- 1华硕主板安装win11 开启TPM_enable firmware tpm

- 2【编译原理文法概述】

- 3怎么给共享电脑设置密码_电脑共享密码怎么设置

- 4uniapp 荣耀手机 没有检测到设备 运行到Android手机 真机运行_uniapp真机运行检测不到设备

- 5要入坑Python,你居然不懂啥是conda,venv, pyenv ,virtualenv???_conda pyenv

- 6macOS:无法打开“xxx”,因为无法确定(验证)开发者身份_mac无法打开软件,因为无法验证开发者

- 7Unity XR Interaction Toolkit(VR、AR交互工具包)记录安装到开发的流程,以及遇到的常见问题(一)!_unity xr interaction toolkit waspressedthisframe

- 8服务器离线安装rabbitmq 以及版本关系 各个依赖下载_rabbltmq3.7.15导入依赖版本应该是多少

- 9makefile中的宏_makefile包含宏

- 10基于Android Studio实现蓝牙组网_androidstudio蓝牙开发

Apache zookeeper kafka 开启SASL安全认证_kafka开启认证_caused by: java.lang.illegalargumentexception: log

赞

踩

};

KafkaClient {

org.apache.kafka.common.security.scram.ScramLoginModule required

username=“admin”

password=“admin123”

user_producer=“producer123”

user_consumer=“consumer123”;

};

Client {

org.apache.kafka.common.security.scram.ScramLoginModule required

username=“kafka”

password=“kafka123”;

};

KafkaServer中usename配置的是kafka服务端使用的账号和密码,后面的user\_xxx事预设的普通帐号认证信息。 中间部分配置的是PLAIN认证方式的账户和密码,其中producer1是账户名,producer123是密码。 Client配置了broker到Zookeeper的连接用户名密码,这里要和前面zookeeper配置中的zk\_jaas.conf.conf 中 user\_kafka 的账号和密码相同。 关于这个文件内容,需要注意以下两点: 1)不要忘记最后一行和倒数第二行结尾处的分号; 2)JAAS 文件中不需要任何空格键。 #### 4. **kafka 配置文件启用SASL认证** Kafka 服务配置文件 server.propertis,配置认证协议及认证实现类 cat server.properties其它内容都注释掉,然后追加如下内容:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

broker.id=0

listeners=SASL_PLAINTEXT://:9092

advertised.listeners=SASL_PLAINTEXT://localhost:9092

sasl.enabled.mechanisms=SCRAM-SHA-256,PLAIN

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256

security.inter.broker.protocol=SASL_PLAINTEXT

allow.everyone.if.no.acl.found=false

authorizer.class.name=kafka.security.auth.SimpleAclAuthorizer

super.users=User:admin

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

log.dirs=/tmp/kafka/logs

num.partitions=3

num.recovery.threads.per.data.dir=1

offsets.topic.replication.factor=2

transaction.state.log.replication.factor=1

transaction.state.log.min.isr=1

log.flush.interval.messages=10000

log.flush.interval.ms=1000

log.retention.hours=168

log.retention.bytes=1073741824

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

delete.topic.enable=true

auto.create.topics.enable=false

zookeeper.connect=localhost:2181

zookeeper.connection.timeout.ms=60000

group.initial.rebalance.delay.ms=0

Host.name=43.138.0.199

#### 5. **kafka 启动脚本添加认证文件路径的环境变量**

Kafka 安全认证可以直接通过环境变量 -Djava.security.auth.login.config 设置,修改 Kafka 启动脚本 kafka-start-server.sh 文件最后一行,增加一个参数指向 jaas 配置文件的绝对路径

vi kafka-server-start.sh

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

exec $base_dir/kafka-run-class.sh E X T R A A R G S − D j a v a . s e c u r i t y . a u t h . l o g i n . c o n f i g = / h o m e / l i g h t h o u s e / k a f k a 2 . 12 − 2.2.1 / c o n f i g / k a f k a s e r v e r j a a s . c o n f k a f k a . K a f k a " EXTRA_ARGS -Djava.security.auth.login.config=/home/lighthouse/kafka_2.12-2.2.1/config/kafka_server_jaas.conf kafka.Kafka " EXTRAARGS−Djava.security.auth.login.config=/home/lighthouse/kafka2.12−2.2.1/config/kafkaserverjaas.confkafka.Kafka"@"

#### 6. **kafka客户端配置**

1) 配置consumer.properties和producer.properties,都要加入以下配置

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

security.protocol=SASL_PLAINTEXT

sasl.mechanism=SCRAM-SHA-512

2) 生产者配置

使用kafka-console-producer.sh脚本测试生产者,由于开启安全认证和授权,此时使用console-producer脚本来尝试发送消息,那么消息会发送失败,原因是没有指定合法的认证用户,因此客户端需要做相应的配置,需要创建一个名为producer.conf的配置文件给producer程序使用。

config目录下创建一个producer.conf的文件,cat producer.conf文件内容如下:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

security.protocol=SASL_PLAINTEXT

sasl.mechanism=SCRAM-SHA-256

sasl.jaas.config=org.apache.kafka.common.security.scram.Scra

mLoginModule required username=“producer” password=“producer123”;

注意:Topic设置写权限

3) 消费者配置

使用kafka-console-consumer.sh脚本测试生产者,由于开启安全认证和授权,因此客户端需要做相应的配置。需要为 consumer 用户创建consumer.conf给消费者程序,同时设置对topic的读权限。

config目录下创建一个consumer.conf的文件,cat consumer.conf文件内容如下:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

security.protocol=SASL_PLAINTEXT

sasl.mechanism=SCRAM-SHA-256

sasl.jaas.config=org.apache.kafka.common.security.scram.Scra

mLoginModule required username=“consumer” password=“consumer123”;

注意:Topic设置读权限。

4) 在生产者和消费者启动脚本中引入JAAS文件

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

vim bin/kafka-console-producer.sh

if [ “x$KAFKA_HEAP_OPTS” = “x” ]; then

export KAFKA_HEAP_OPTS=“-Xmx512M”

fi

添加这行

export KAFKA_OPTS=“-Djava.security.auth.login.config=…/config/kafka_server_jaas.conf”

exec $(dirname 0 ) / k a f k a − r u n − c l a s s . s h k a f k a . t o o l s . C o n s o l e P r o d u c e r " 0)/kafka-run-class.sh kafka.tools.ConsoleProducer " 0)/kafka−run−class.shkafka.tools.ConsoleProducer"@"

vim bin/kafka-console-consumer.sh

if [ “x$KAFKA_HEAP_OPTS” = “x” ]; then

export KAFKA_HEAP_OPTS=“-Xmx512M”

fi

添加这行

export KAFKA_OPTS=“-Djava.security.auth.login.config=…/config/kafka_server_jaas.conf”

exec $(dirname 0 ) / k a f k a − r u n − c l a s s . s h k a f k a . t o o l s . C o n s o l e C o n s u m e r " 0)/kafka-run-class.sh kafka.tools.ConsoleConsumer " 0)/kafka−run−class.shkafka.tools.ConsoleConsumer"@"

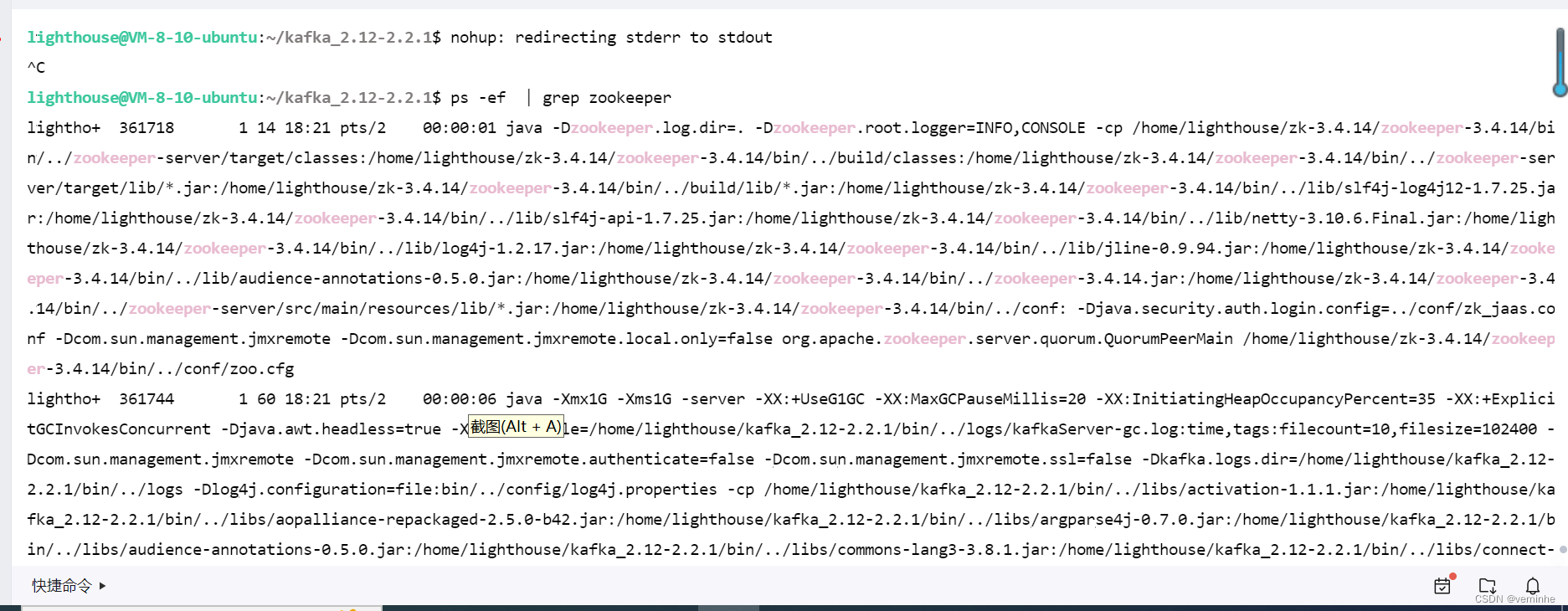

### 启动kafka

- 1

- 2

- 3

- 4

- 5

nohup kafka-server-start.sh /path-to-kafka/config/server.properties &

我自己写了一个脚本,同时启动zookeeper和kafka

文件名称叫startup.sh内容如下:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

cd /home/lighthouse/zk-3.4.14/zookeeper-3.4.14/bin

./zkServer.sh start

cd /home/lighthouse/kafka_2.12-2.2.1/

nohup bin/kafka-server-start.sh config/server.properties > output.txt &

zookeeper没有启动成功,我找下原因。把整个过程重新整理了一遍,发现zookeeper、kafka启动成功了。

### 检查验证

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

./zkCli.sh -server localhost:2181

ls /brokers/ids

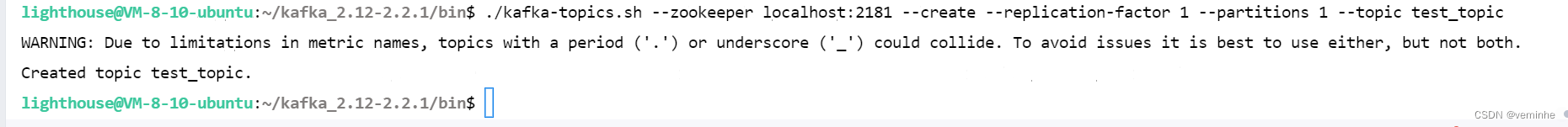

#### 1. 生产者测试

1) 创建一个测试主题test\_topic

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

./kafka-topics.sh --zookeeper localhost:2181 --create --replication-factor 1 --partitions 1 --topic test_topic

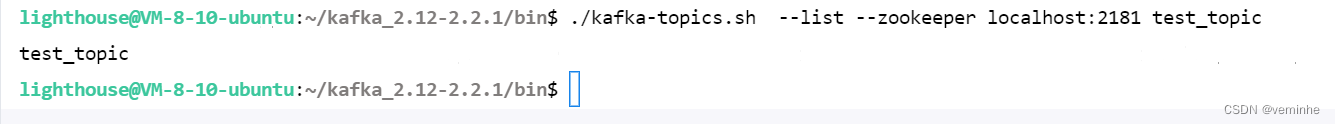

2)查看创建的Topic

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

./kafka-topics.sh --list --zookeeper localhost:2181 test_topic

- 1

- 2

- 3

- 4

- 5

./kafka-topics.sh --describe --zookeeper localhost:2181 --topic test_topic

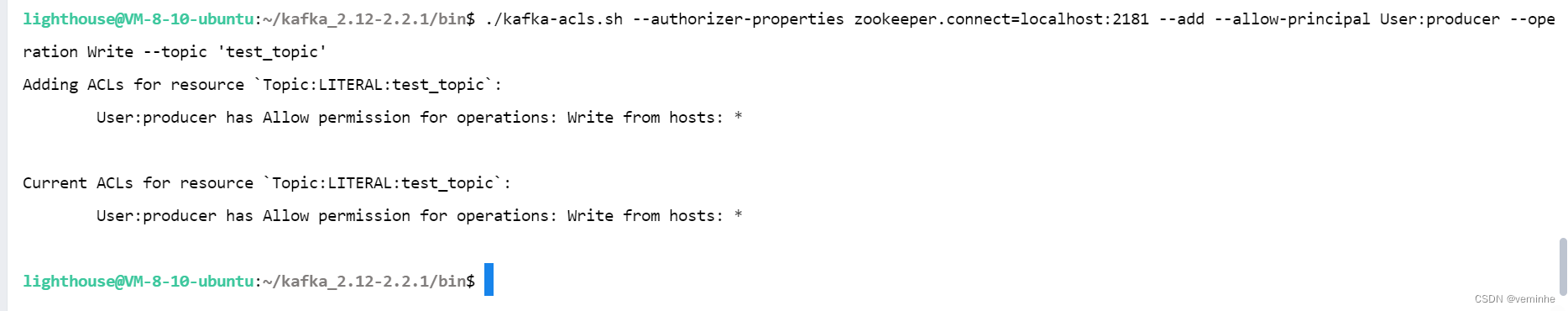

注:kafka开启认证后,当生产者往Topic写数据需要为主题配置权限(write),即对生产者赋予写的权限。

这里使用producer用户认证授权,通过ACL为producer 用户分配操作test\_topic权限:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

./kafka-acls.sh --authorizer-properties zookeeper.connect=localhost:2181 --add --allow-principal User:producer --operation Write --topic ‘test_topic’

注意allow-后面不要换行(会报错),注意整段命令要放在一行上。   * 启动生产者发送消息 特别注意:在生产者生产消息之前如果不设置生产者用户的ACL权限会报错:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

./kafka-console-producer.sh --broker-list localhost:9092 --topic test_topic --producer.config …/config/producer.conf

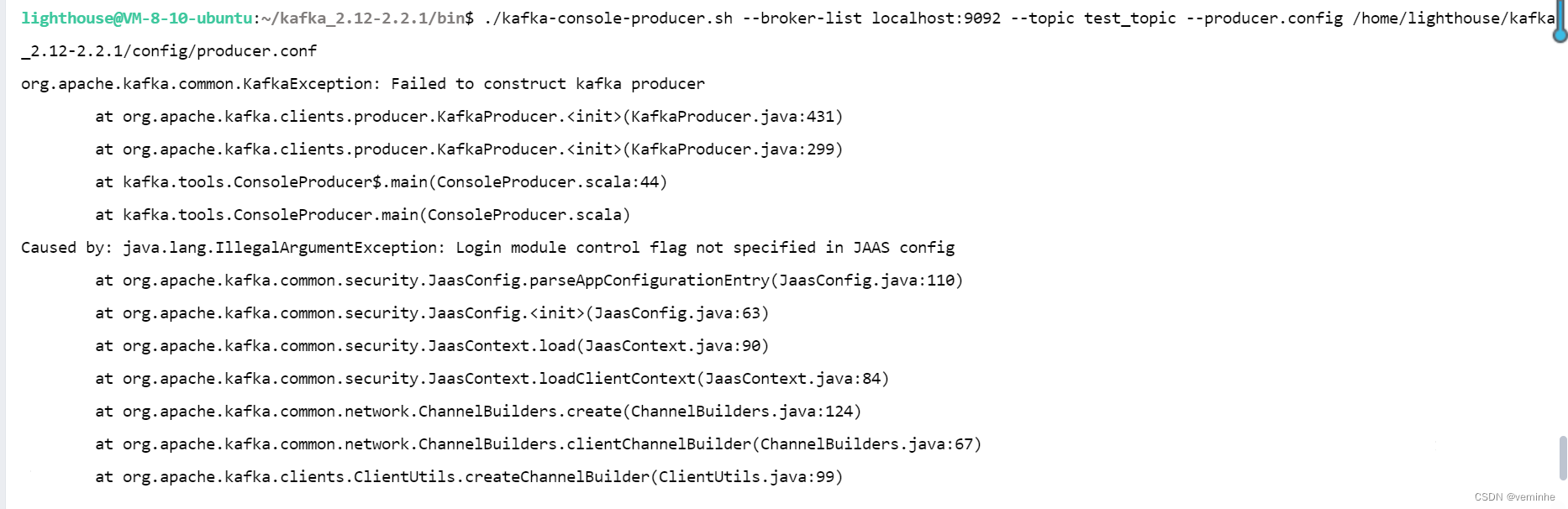

./kafka-console-producer.sh --broker-list localhost:9092 --topic test_topic --producer.config /home/lighthouse/kafka_2.12-2.2.1/config/producer.conf

使用相对路径和绝对路径都报错了,错误相同

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

org.apache.kafka.common.KafkaException: Failed to construct kafka producer

at org.apache.kafka.clients.producer.KafkaProducer.(KafkaProducer.java:431)

at org.apache.kafka.clients.producer.KafkaProducer.(KafkaProducer.java:299)

at kafka.tools.ConsoleProducer$.main(ConsoleProducer.scala:44)

at kafka.tools.ConsoleProducer.main(ConsoleProducer.scala)

Caused by: java.lang.IllegalArgumentException: Login module control flag not specified in JAAS config

at org.apache.kafka.common.security.JaasConfig.parseAppConfigurationEntry(JaasConfig.java:110)

at org.apache.kafka.common.security.JaasConfig.(JaasConfig.java:63)

at org.apache.kafka.common.security.JaasContext.load(JaasContext.java:90)

at org.apache.kafka.common.security.JaasContext.loadClientContext(JaasContext.java:84)

at org.apache.kafka.common.network.ChannelBuilders.create(ChannelBuilders.java:124)

at org.apache.kafka.common.network.ChannelBuilders.clientChannelBuilder(ChannelBuilders.java:67)

at org.apache.kafka.clients.ClientUtils.createChannelBuilder(ClientUtils.java:99)

at org.apache.kafka.clients.producer.KafkaProducer.newSender(KafkaProducer.java:439)

at org.apache.kafka.clients.producer.KafkaProducer.(KafkaProducer.java:420)

… 3 more

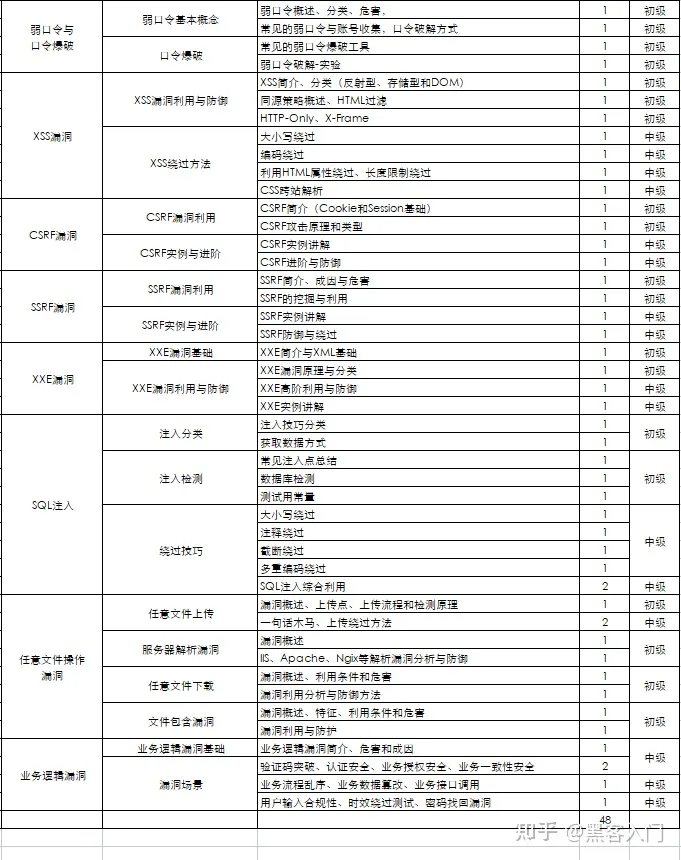

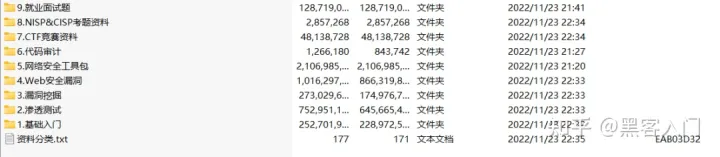

### 如何自学黑客&网络安全 #### 黑客零基础入门学习路线&规划 **初级黑客** **1、网络安全理论知识(2天)** ①了解行业相关背景,前景,确定发展方向。 ②学习网络安全相关法律法规。 ③网络安全运营的概念。 ④等保简介、等保规定、流程和规范。(非常重要) **2、渗透测试基础(一周)** ①渗透测试的流程、分类、标准 ②信息收集技术:主动/被动信息搜集、Nmap工具、Google Hacking ③漏洞扫描、漏洞利用、原理,利用方法、工具(MSF)、绕过IDS和反病毒侦察 ④主机攻防演练:MS17-010、MS08-067、MS10-046、MS12-20等 **3、操作系统基础(一周)** ①Windows系统常见功能和命令 ②Kali Linux系统常见功能和命令 ③操作系统安全(系统入侵排查/系统加固基础) **4、计算机网络基础(一周)** ①计算机网络基础、协议和架构 ②网络通信原理、OSI模型、数据转发流程 ③常见协议解析(HTTP、TCP/IP、ARP等) ④网络攻击技术与网络安全防御技术 ⑤Web漏洞原理与防御:主动/被动攻击、DDOS攻击、CVE漏洞复现 **5、数据库基础操作(2天)** ①数据库基础 ②SQL语言基础 ③数据库安全加固 **6、Web渗透(1周)** ①HTML、CSS和JavaScript简介 ②OWASP Top10 ③Web漏洞扫描工具 ④Web渗透工具:Nmap、BurpSuite、SQLMap、其他(菜刀、漏扫等) 恭喜你,如果学到这里,你基本可以从事一份网络安全相关的工作,比如渗透测试、Web 渗透、安全服务、安全分析等岗位;如果等保模块学的好,还可以从事等保工程师。薪资区间6k-15k 到此为止,大概1个月的时间。你已经成为了一名“脚本小子”。那么你还想往下探索吗? 如果你想要入坑黑客&网络安全,笔者给大家准备了一份:282G全网最全的网络安全资料包评论区留言即可领取! **7、脚本编程(初级/中级/高级)** 在网络安全领域。是否具备编程能力是“脚本小子”和真正黑客的本质区别。在实际的渗透测试过程中,面对复杂多变的网络环境,当常用工具不能满足实际需求的时候,往往需要对现有工具进行扩展,或者编写符合我们要求的工具、自动化脚本,这个时候就需要具备一定的编程能力。在分秒必争的CTF竞赛中,想要高效地使用自制的脚本工具来实现各种目的,更是需要拥有编程能力. 如果你零基础入门,笔者建议选择脚本语言Python/PHP/Go/Java中的一种,对常用库进行编程学习;搭建开发环境和选择IDE,PHP环境推荐Wamp和XAMPP, IDE强烈推荐Sublime;·Python编程学习,学习内容包含:语法、正则、文件、 网络、多线程等常用库,推荐《Python核心编程》,不要看完;·用Python编写漏洞的exp,然后写一个简单的网络爬虫;·PHP基本语法学习并书写一个简单的博客系统;熟悉MVC架构,并试着学习一个PHP框架或者Python框架 (可选);·了解Bootstrap的布局或者CSS。 **8、超级黑客** 这部分内容对零基础的同学来说还比较遥远,就不展开细说了,附上学习路线。  #### 网络安全工程师企业级学习路线  如图片过大被平台压缩导致看不清的话,评论区点赞和评论区留言获取吧。我都会回复的 视频配套资料&国内外网安书籍、文档&工具 当然除了有配套的视频,同时也为大家整理了各种文档和书籍资料&工具,并且已经帮大家分好类了。  一些笔者自己买的、其他平台白嫖不到的视频教程。  **网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。** **[需要这份系统化资料的朋友,可以点击这里获取](https://bbs.csdn.net/topics/618540462)** **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93