热门标签

热门文章

- 1大模型的自我监督

- 2Android 开发必备 - Java知识点总结_学习安卓编程要java的哪些知识点

- 3css div style

- 4关于TestFlight Beta Testing_testflight已准备好测试

- 5qemu虚拟机 安装银河麒麟V10 arm架构系统 桌面版_vmware支持arm吗_qemu装arm麒麟

- 6浅谈大模型 SFT 的实践落地:十问十答_bert和llm的区别

- 7大数据之Spark:Spark面试(初级)

- 8SwiftUI 6.0(iOS 18/macOS 15)关于颜色 Color 的新玩法

- 9【机器学习】GLM-4V:图片识别多模态大模型(MLLs)初探_glm4v部署

- 10安装 Docker Compose_kali安装docker compose

当前位置: article > 正文

离线计算---Hadoop集群搭建_hadoop集群离线搭建

作者:黑客灵魂 | 2024-06-27 13:13:16

赞

踩

hadoop集群离线搭建

1 集群搭建

本案例Hadoop集群,使用6个服务器节点进行搭建,各节点大体部署的服务如图所示:

2 集群介绍

- Hadoop集群,主要包含两个:①HDFS集群;②YARN集群

- HDFS集群,主要角色:①NameNode;②DataNode

- YARN集群,主要角色:①ResourceManager;②NodeManager

各个服务器具体角色分配:

| HostName | 角色 | 角色 | 角色 |

|---|---|---|---|

| ha01 | zookeeper | namenode(actvie) | resourcemanager(active) |

| ha02 | zookeeper | namenode(standby) | - |

| ha03 | zookeeper | - | resourceManager(standby) |

| ha04 | dataNode | nodeManager | JournalNode |

| ha05 | dataNode | nodeManager | JournalNode |

| ha06 | dataNode | nodeManager | JournalNode |

部署图如下:

3 搭建过程

3.1 服务器准备

准备虚拟机:Vmware11.0 , Centos 6.5 64bit

- 1

3.2 网络环境准备

- 采用NAT方式联网

- 网关地址:192.168.254.100

- 服务器节点IP地址:

| 服务器IP地址 |

|---|

| 192.168.254.101 |

| 192.168.254.102 |

| 192.168.254.103 |

| 192.168.254.104 |

| 192.168.254.105 |

| 192.168.254.106 |

- 子网掩码:255.255.255.0

3.3 服务器系统设置

- 永久关闭防火墙:每台服务器均先执行:service iptables stop ,后执行:chkconfig iptables off

- 设置主机名:服务器各自设置主机名:vim /etc/sysconfig/network,

| 服务器IP | 主机名 |

|---|---|

| 192.168.254.101 | HOSTNAME=ha01 |

| 192.168.254.102 | HOSTNAME=ha02 |

| 192.168.254.103 | HOSTNAME=ha03 |

| 192.168.254.104 | HOSTNAME=ha04 |

| 192.168.254.105 | HOSTNAME=ha05 |

| 192.168.254.106 | HOSTNAME=ha06 |

然后各自在服务器上执行命令:hostname 主机名,以便达到不重启服务器主机名生效的目的

- 配置每台服务器hosts文件,执行命令:vim /etc/hosts

| hosts文件 |

|---|

| 127.0.0.1 localhost |

| ::1 localhost |

| 192.168.254.101 ha01 |

| 192.168.254.102 ha02 |

| 192.168.254.103 ha03 |

| 192.168.254.104 ha04 |

| 192.168.254.105 ha05 |

| 192.168.254.106 ha06 |

然后通过远程copy命令将配置好的hosts文件scp到其他5台服务器节点上,命令如下:

scp /etc/hosts root@ha01:/etc

scp /etc/hosts root@ha02:/etc

scp /etc/hosts root@ha03:/etc

scp /etc/hosts root@ha04:/etc

scp /etc/hosts root@ha05:/etc

scp /etc/hosts root@ha06:/etc

- 配置服务器免密登录:在每台服务器中各自执行命令:ssh-keygen,然后执行命令

ssh-copy-id root@ha01

ssh-copy-id root@ha02

ssh-copy-id root@ha03

ssh-copy-id root@ha04

ssh-copy-id root@ha05

ssh-copy-id root@ha06

3.4 JDK安装

- 上传jdk1.8安装包

- 安装目录:/home/appsystem/jdk1.8(这里选择目录/home/appsystem统一存放所有应用程序)

- 解压安装包:tar -zxvf jdk1.8.jar

- 配置环境变量:/etc/profile,配置完成后执行:source /etc/profile使其生效,并通过命令:java -version检查jdk是否安装成功

| profile文件 |

|---|

| export JAVA_HOME = /home/appsystem/jdk1.8 |

| export CLASSPATH = $JAVA_HOME/lib/dt.jar: $JAVA_HOME/lib/tools.jar |

| export PATH = $JAVA_HOME/bin: $PATH |

可通过只安装好一台服务器的JDK后,使用scp 远程复制到各个服务器中,节省时间

3.5 zookeeper集群安装

- 在ha01服务器节点上传zookeeper安装包

- 安装目录:/home/appsystem/zk(这里选择目录/home/appsystem统一存放所有应用程序)

- 解压安装包:tar -zxvf zk.tar.gz

- 进入zk的conf目录:cp zoo_sample.cfg zoo.cfg

- 修改zoo.cfg文件:vim zoo.cfg

| zoo.cfg文件 |

|---|

| dataDir=/home/appsystem/zk/tmp |

| server.1=192.168.254.101:2888:3888 |

| server.2=192.168.254.102:2888:3888 |

| server.3=192.168.254.103:2888:3888 |

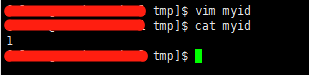

- 创建 mkdir tmp 目录,cd tmp/进入目录中,编辑:vim myid为1

- 把安装好的zk,scp拷贝到ha02和ha03节点与ha01相同目录下,然后分别修改myid文件为2和3,这样zk集群就搭建好了

| 服务器 | myid文件中值 |

|---|---|

| ha01 | 1 |

| ha02 | 2 |

| ha03 | 3 |

3.5 Hadoop集群安装

- 在ha01服务器节点上传Hadoop安装包

- 安装目录:/home/appsystem/hadoop(这里选择目录/home/appsystem统一存放所有应用程序)

- 解压安装包:tar -zxvf hadoop.jar

- 配置环境变量: /etc/profile,配置完成后执行:source /etc/profile使其生效

| profile文件 |

|---|

| export JAVA_HOME = /home/appsystem/jdk1.8 |

| export HADOOP_HOME = /home/appsystem/hadoop |

| export CLASSPATH = $JAVA_HOME/lib/dt.jar: $JAVA_HOME/lib/tools.jar |

| export PATH = $JAVA_HOME/bin: $HADOOP_HOME/bin: $HADOOP_HOME/sbin: $PATH |

| export JAVA_HOME PATH CLASSPATH HADOOP_HOME |

- 编辑hadoop-env.sh配置文件:vim hadoop-env.sh

export JAVA_HOME=/home/appsystem/jdk1.8

export HADOOP_CONF_DIR=/home/appsystem/hadoop/etc/hadoop

- 编辑core-site.xml配置文件:vim core-site.xml

<configuration> <!--指定hdfs的老大,ns为固定属性名,表示两个namenode--> <property> <name>fs.defaultFS</name> <value>hdfs://ns</value> </property> <!--指定hadoop运行时产生文件的存放目录--> <property> <name>hadoop.tmp.dir</name> <value>/home/appsystem/hadoop/tmp</value> </property> <!--zookeeper集群地址--> <property> <name>ha.zookeeper.quorum</name> <value>ha01:2181,ha02:2181,ha03:2181</value> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 编辑hdfs-site.xml配置文件:vim hdfs-site.xml

<configuration> <!--执行hdfs的nameservice为ns,和core-site.xml保持一致--> <property> <name>dfs.nameservices</name> <value>ns</value> </property> <!--ns下有两个namenode,分别是nn1,nn2--> <property> <name>dfs.ha.namenodes.ns</name> <value>nn1,nn2</value> </property> <!--nn1的RPC通信地址--> <property> <name>dfs.namenode.rpc-address.ns.nn1</name> <value>ha01:9000</value> </property> <!--nn1的http通信地址--> <property> <name>dfs.namenode.http-address.ns.nn1</name> <value>ha01:50070</value> </property> <!--nn2的RPC通信地址--> <property> <name>dfs.namenode.rpc-address.ns.nn2</name> <value>ha02:9000</value> </property> <!--nn2的http通信地址--> <property> <name>dfs.namenode.http-address.ns.nn2</name> <value>ha02:50070</value> </property> <!--指定namenode的元数据在JournalNode上的存放位置,这样,namenode2可以从jn集群里获取最新的namenode的信息,达到热备的效果--> <property> <name>dfs.namenode.shared.edits.dir</name> <value>qjournal://ha04:8485;ha05:8485;ha06:8485/ns</value> </property> <!--指定JournalNode存放数据的位置--> <property> <name>dfs.journalnode.edits.dir</name> <value>/home/appsystem/hadoop/journal</value> </property> <!--开启namenode故障时自动切换--> <property> <name>dfs.ha.automatic-failover.enabled</name> <!--配置切换的实现方式--> <property> <name>dfs.client.failover.proxy.provider.ns</name> <value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value> <!--配置隔离机制--> <property> <name>dfs.ha.fencing.methods</name> <value>sshfence</value> </property> <!--配置隔离机制的ssh登录秘钥所在的位置--> <property> <name>dfs.ha.fencing.ssh.private-key-files</name> <value>/root/.ssh/id_rsa</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:///home/appsystem/hadoop/tmp/namenode</value> </property> <!--配置datanode数据存放的位置,可以不配置,如果不配置,默认用的是core-site.xml里配置的hadoop.tmp.dir的路径--> <property> <name>dfs.datanode.data.dir</name> <value>file:///home/appsystem/hadoop/tmp/datanode</value> </property> <!--配置block副本数量为3--> <property> <name>dfs.replication</name> <value>3</value> </property> <!--设置hdfs的操作权限,false表示任何用户都可以在hdfs上操作文件--> <property> <name>dfs.permissions</name> <value>false</value> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 编辑mapred-site.xml配置文件:vim mapred-site.xml

<configuration>

<property>

<!--指定mapreduce运行在yarn上-->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 编辑yarn-site.xml配置文件:vim yarn-site.xml

<configuration> <!-- 开启YARN HA --> <property> <name>yarn.resourcemanager.ha.enabled</name> <value>true</value> </property> <!-- 指定两个resourcemanager的名称 --> <property> <name>yarn.resourcemanager.ha.rm-ids</name> <value>rm1,rm2</value> </property> <!-- 配置rm1,rm2的主机 --> <property> <name>yarn.resourcemanager.hostname.rm1</name> <value>ha01</value> </property> <property> <name>yarn.resourcemanager.hostname.rm2</name> <value>ha03</value> </property> <!--开启yarn恢复机制--> <property> <name>yarn.resourcemanager.recovery.enabled</name> <value>true</value> </property> <!--执行rm恢复机制实现类--> <property> <name>yarn.resourcemanager.store.class</name> <value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value> </property> <!-- 配置zookeeper的地址 --> <property> <name>yarn.resourcemanager.zk-address</name> <value>ha01:2181,ha02:2181,ha03:2181</value> <description>For multiple zk services, separate them with comma</description> </property> <!-- 指定YARN HA的名称 --> <property> <name>yarn.resourcemanager.cluster-id</name> <value>yarn-ha</value> </property> <property> <!--指定yarn的老大 resoucemanager的地址--> <name>yarn.resourcemanager.hostname</name> <value>ha01</value> </property> <property> <!--NodeManager获取数据的方式--> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 编辑salves文件:vi salves

Ha04

Ha05

Ha06

- 1

- 2

- 3

- 创建文件夹

mkdir -p /home/appsystem/hadoop/tmp/namenode /home/appsystem/hadoop/tmp/datanode

mkdir /home/appsystem/hadoop/journal

- 1

- 2

3.6 启动集群

3.6.1 启动zk集群

路径:/home/appsystem/zk/bin

执行:sh zkServer.sh start

在zk集群的leader节点下执行:hdfs zkfc -formatZK生成ha(ns)节点

- 1

- 2

- 3

3.6.2 启动journalnode集群

启动节点:ha04,ha05,ha06其中任意节点

Hadoop/sbin/sh hadoop-daemon.sh start journalnode

- 1

- 2

3.6.3 格式化和启动ha01节点的namenode

格式化节点:ha01

Hadoop/sbin/hadoop namenode -format

Hadoop/sbin/sh hadoop-daemon start namenode

- 1

- 2

- 3

3.6.4 启动ha02节点的namenode,并设置为standby

第一步把ha02节点变成standby namenode

Hadoop/sbin/hdfs namenode -bootstrapStandby

第二步启动ha02节点的namenode

Hadoop/sbin/sh hadoop-daemon.sh start namenod

- 1

- 2

- 3

- 4

3.6.5 启动ha04 ha05 ha06节点的datanode

Hadoop/sbin/sh hadoop-daemon.sh start datanode

- 1

3.6.5 启动ha01 ha02中的zkfc(FailoverController)

Hadoop/sbin/sh hadoop-daemon.sh start zkfc

- 1

3.6.6 启动ha01节点的主resourcemanager

Hadoop/sbin/sh start-yarn.sh

启动成功后ha04 ha05 ha06节点会生成nodemanager进程

- 1

- 2

3.6.7 启动ha03节点的副resourcemanager

Hadoop/sbin/sh yarn-daemon.sh start resourcemanager

- 1

3.7 查询集群是否正常启动

- 输入地址:http://192.168.254.101:50070,查看namenode的信息,是active状态的

- 输入地址:http://192.168.254.102:50070,查看namenode的信息,是standby状态的

- 停掉ha01节点:hadoop-daemon stop namenode,观察ha02是否变成active状态

- 查看yarn的管理地:http://192.168.254.101:8088(节点01的8088端口)

- 停掉ha01节点:yarn-daemon.sh stop resourcemanager,查看http://192.168.254.103:8088(节点01的8088端口)

- 在各个服务器中执行jps -l,查看是否上面介绍的各个服务器具体角色分配一直

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/黑客灵魂/article/detail/762613

推荐阅读

相关标签