- 1神经网络——循环神经网络(RNN)

- 2CVE-2020-25648:RHSA-2021:1384: nss 安全和BUG修复更新

- 3Vue+element-ui上传logo图片到后端生成二维码展示到页面_elementui二维码图标

- 4ROS2知识(1):开始实践机器人_ros机器人开发实践

- 5网络工程管理 第四章 路由器 RIP OSPF 及配置实验_计算机网络 组网基础-静态路由、动态路由协议rip、ospf配置实验

- 6完美解决api-ms-win-crt-runtime-l1-1-0.dll详细步骤_api-ms-win-crt-runtime-l1-1-0.dll win7

- 7前端跨平台框架对比分析,看这篇就够了

- 8如何做好“向上管理”

- 9HTTP网络协议的请求方法,具体详解(2024-04-26)

- 10今天中午看到的几个哲学小故事

liunx安装Hadoop及配置基础环境_hadoop linux 基础环境

赞

踩

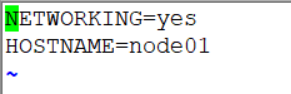

二、修改linux主机名称

-

vim /etc/sysconfig/network

-

三台虚拟机修改后重启

-

centos7修改方法:

[root@centos7 ~]$ hostnamectl set-hostname 要修改的主机名.magedu.com # 使用这个命令会立即生效且重启也生效 [root@centos7 ~]$ hostname # 查看下 centos77.magedu.com [root@centos7 ~]$ vim /etc/hosts # 编辑下hosts文件, 给127.0.0.1添加hostname [root@centos7 ~]$ cat /etc/hosts # 检查 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 centos77.magedu.com ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

三、配置三台主机的映射

-

编辑文件 vim /etc/hosts 末尾添加: 192.168.1.14 gz001 192.168.1.16 gz002 192.168.1.17 gz004

(3台主机的主机名称与IP地址的映射)

四、Windows上配置hosts

-

Windows 客户端 连接 Linux 主机,既可以通过 IP去连接, 也可以通过主机名称去连接,需要修改 Windows 目录下面的配置

-

C:\Windows\System32\Drivers\etc\hosts

五、关闭防火墙

暂时性的关闭:service iptables stop

永久性开启:chkconfig iptables on

永久行关闭:chkconfig iptables off

六、ssh免密登录

-

首先生成服务器密钥

-

ssh-keyge

-

-

拷贝服务器公钥至 主机gouzheng01(注意三台主机俩俩之间互相免密)

-

ssh-copy-id 主机名

-

-

测试是否免密成功

-

ssh 主机名

-

七、上传 JDK 和 hadoop 压缩包

-

tar zxvf hadoop-2.5.1_x64_0.tar.gz tar zxvf jdk1.8.0_144.tar.gz

-

配置jdk 以及 hadoop环境 (vim /etc/profile )

-

jdk环境 export JAVA_HOME=/opt/jdk1.8.0_144 export PATH=$PATH:$JAVA_HOME/bin

-

Hadoop环境(如果要ambari一键部署则不需要配置) export HADOOP_HOME=/opt/hadoop-2.5.1_x64_0 export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin

-

八、配置hadoop (四个配置文件)

-

/opt/hadoop-2.5.1_x64_0/etc/hadoop/hadoop-env.sh 把JAVA_HOME 换成 jdk的路径 (检查jdk路径用 ${JAVA_HOME})

-

opt/hadoop-2.5.1_x64_0/etc/hadoop/core-site.xml <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://gz001:8020</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/hadoop-data</value> </property> </configuration>

-

opt/hadoop-2.5.1_x64_0/etc/hadoop/ yarn-site.xml <configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

-

/opt/hadoop-2.5.1_x64_0/etc/hadoop/slaves 主机列表 Hadoop01 Hadoop02 Hadoop03

-

同步配置另外俩台虚拟机的Hadoop配置文件 { hadoop-env.sh core-site.xml yarn-site.xml slaves }到其他机器的目录下面

-

命令 :scp hadoop-env.sh core-site.xml yarn-site.xml slaves gz001:/opt/hadoop-2.5.1_x64_0/etc/hadoop/

-

九、格式化Hadoop文件系统

-

命令 : /opt/hadoop-2.5.1_x64_0/bin/hdfs namenode -format

-

注意Hdfs只能执行一次

-

如果要进行多次格式化要将 /opt/hadoop-data/dfs删除(前提是dfs中没有重要文件)

十、启动hdfs分布式文件系统

-

/opt/hadoop-2.5.1_x64_0/sbin/start-dfs.sh

访问Hdfs页面 http://gz001:50070 注意 : 关闭防火墙 service iptables stop -

启动yarn资源调度 /opt/hadoop-2.5.1_x64_0/sbin/start-yarn.sh

访问 yarn 页面 http://gz001:8088 注意 : 在哪个主机上面启动的,主机名就写哪个 -

检验Hadoop是否配置成功 运行自带计算圆周率PI的例子 (没有配置Hadoop环境 所以要从bin目录下进入) /opt/hadoop-2.5.1_x64_0/bin/hadoop jar /opt/hadoop-2.5.1_x64_0/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.5.2.jar pi 10 1000

-

运行自带统计单词出现的次数 touch wordcount ( 创建一个wordcount文件)

样例数据 wordcount.txt hadoop hadoop spark hadoop flume hadoop hdfs hadoop hbase hadoop zookeeper 上传 wordcount.txt 到 hadoop 文件系统 /opt/hadoop-2.5.1_x64_0/bin/hdfs dfs -put wordcount /wordcount(hdfs命名文件夹)

执行 wordcount 程序

/opt/hadoop-2.5.1_x64_0/bin/ yarn jar /opt/hadoop-2.5.1_x64_0/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.5.2.jar wordcount /wordcount /output

十一、配置静态IP

1./编辑配置文件

vim /etc/sysconfig/network-scripts/ifcfg-eth33

DEVICE="eth0" BOOTPROTO="dhcp" //static HWADDR="00:0C:29:D3:C4:79" IPV6INIT="yes" // no NM_CONTROLLED="yes" ONBOOT="yes" TYPE="Ethernet" UUID="87e0a990-8d0b-4468-b228-00dfbf9bbcfc" // 删掉

追加:

IPADDR=192.168.253.155 / / 配置的静态 IP地址 NETMASK=255.255.255.0 //子网掩码,划分子网 GATEWAY=192.168.255.2 // 网关,路由器的地址 BROADCAST=192.168.253.255 // 广播地址 DNS1=114.114.114.114 // 域名解析服务 ping www.baidu.com

2.执行命令 : service network restart