- 1逻辑运算详解_逻辑与运算

- 2QT设计常用控件_qt string stra = ui->lineddita->text();

- 3配置MyBatisPlus_mybatisplus配置

- 4毕业设计:2023-2024年计算机专业毕业设计选题汇总(建议收藏)_python购物系统代码

- 5SQL查询优化

- 6初学者试试,HarmonyOS应用开发者基础认证_鸿蒙开发者认证

- 7vue 文本超出,换行展示,添加white-space: pre-wrap无效_使用"white-space:pre"不起作用

- 8nRF52832 DFU升级导致FDS数据丢失的问题_nrf fds烧录被擦除

- 9最全Pycharm教程(34)——Pycharm内置终端以及远程SSH工具的使用_pycharm remote 终端

- 10吃过饭就是如他让他让他额u

常见多核CUP利用率与相应线程数量的估算方式_cpu利用率怎么算

赞

踩

为了提高计算机的执行效率,需要尽量提高CPU的有效执行率。由于主流的应用系统以线程为运算执行基本单位,所以线程数可以等同于运算执行单位数量。由于在用户空间,需要用户自行进行线程的调度,那么如何计算最佳的线程数量呢?

从线程的状态当中,可以知晓一个线程并不是总在执行的,它会因为I/O等原因陷入阻塞状态,这种状态下,CPU会处于空闲状态。为了提高CPU的利用率,这便需要在某一个线程处于阻塞状态的时候,给CPU安排其他线程进行处理,通过cpu调度算法,让用户看上去同时执行,增加系统整体的处理效率。

CPU的利用率

确定需求所期望CPU的利用率(0-100%),以及成本可以负担的CPU的核心数量:

Ncpu = CPU 核心数

Ucpu = CPU 利用率,0-100%

线程总体运行时间和CPU运算时间比率= ((等待时间+CPU运行时间)/CPU运行时间)=(1 + W/C)

W/C = 等待时间与CPU运算时间的比率 (等待时间/CPU运算时间的比率)

多核CPU的的线程数量计算公式一:

线程数 = Ncpu x Ucpu x (1 + W/C)

假设一个任务运算占总时间的50%,当我们希望CPU利用率为100% ,

线程数 = Ncpu x 1 x (1 + W/C) =Ncpu x (1 + W/C),

那么对于单核CPU来说想保持100%的CPU效率需要的这样的任务数量为

线程数 = 1 x 1 x (1 + W/C) =1 x (1 + W/C) ,

也就是线程数 =1 + (0.5/0.5)=2 这个单核CPU可以并发的运行2个这样的任务。

若使用Java语言实现这个任务,为了简化问题假设不考虑GC对于CPU损耗,由于Java语言是一对一的线程映射模型,所以内核线程数等于用户线程数。我们假设CPU具有4个内核,所以使用Java实现多个任务运算占总时间的50%的时候,可以运行的线程就是4 x 1 x (1 + 0.5/0.5) =4 x 2 =8个线程。

同时,也可以从线程阻塞(等待)情况来进行线程计算,将等待时间等同于阻塞时间,线程阻塞(等待)和总体运行时间和比率定义为Blocking Coefficient(阻塞系数)

阻塞系数= 阻塞时间/(阻塞时间+CPU运行时间)

假设一个任务阻塞率是50%,也就是说这个任务有50%的时间会被阻塞(例如读取文件,访问数据库网络i/o等),那么对于单核CPU来说想保持100%的CPU效率需要的这样的任务数量为任务数量= 1/(1 - 0.5)=2,也就是说可以这个单核CPU可以并发的运行2个这样的任务。

假设使用Java语言实现这个任务,为了简化问题假设这里不考虑GC对于CPU损耗,由于Java语言是一对一的线程映射模型,所以内核线程数等于用户线程数,由此Java的线程数量在单核CPU上的计算公式为:

单核CPU任务数量= 1/(1 - 阻塞系数))

多核CPU的的线程数量计算公式二

对于多核CPU来说,当每个线程之间没有依赖关系每个内核之间同时运行属于并行运算场景,由此可以得到对应多核CPU的的线程数量计算公式二:

线程数= Ncpu * 单核CPU任务数量=Ncpu *(1/(1 - 阻塞系数))), N为CPU内核数量。

我们假设CPU具有4个内核,所以使用java实现多个任务阻塞率是50%时候,可以运行的线程数=4 *(1/(1 - 0.5))=8 个线程。

从上面的例子可以看到当 Ucpu 为100%时,公式一等同于公式二这两个公式是同一个问题的从两个角度进行的同等阐释。

Amdahl 定律

多线程并不是银弹它也有其极限,对于整个系统的效率提升可以参考计算机科学家 Gene Amdahl 1967 年在 AFIPS 春季联合计算机会议上提出了Amdahl 定律。这个定律给出了固定工作负载下执行任务延迟,通过改善系统资源得到加速理论。

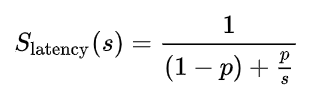

Slatency 是整个任务执行的理论加速;

s 是系统执行改善的加速倍数;

p 为被改进执行部分所占比例。

对于并行开发来说加速倍数可以等于CPU数量,所以s=Ncpu

单个多核服务器计算密集型场景

假设需要在一个8核CPU服务器上设计一个web系统,需要承受的QPS为1000。平均单个query处理时间为500ms,假设这些Query没有CPU阻塞,所以 1秒单个线程最多处理2个Query。同时,没有CPU阻塞也就意味着 线程数= Ncpu *( 1/(1 - 0))=Ncpu (是不是需要额外的一个线程防止线程意外停止即线程数= Ncpu+1 看线程切换的代价)。 8核CPU意味着 Ncpu = 8 也就是8个线程。8个线程每秒可以处理的Query数量为8*2=16个。

这里可以看到1000 Qps指标与单台服务器16个Query线程之间的差距,那就意味着 如果要达到为1000 的QPS的指标需要1000/16= 62.5 台服务器才能达成。

单个多核服务器I/O密集型场景

若其中的network I/O阻塞占整个Query执行时间的90%,其他条件不变,则所需线程数= Ncpu *( 1/(1 - 0.9))=8*( 1/(1 - 0.9))= 80个线程,80个线程每秒可以处理的Query数量为80*2=160个Query。要达到为1000 的QPS的指标则需要1000/160= 6.25 台服务器。缩需的服务器数量与没有线程被阻塞(即query处理时间500ms都在进行CPU密集运行)的场景相比大大减少。

并发、并行操作步骤占整体系统运行操作的比例

假设,并发Query操作步骤占整体系统运行流程的比例为50%,在保证QPS为1000的情况下

Slatency(S)= 1/((1-0.5)+0.5/1000 )= 1/( 0.5+0.0005)=1.9998

以上结果说明即使保证了1000的QPS,保证了相应的服务器数量,整体提升比例仍不超过2倍。

假设,并发Query操作步骤占整体系统运行流程的比例为95%,在保证QPS为1000的情况下

Slatency(S)= 1/((1-0.95)+0.95/1000 )= 1(0.05+0.00095)=19.62

以上结果说明即使保证了1000的QPS,保证了相应的服务器数量,整体提升比例可以达到近20倍。

结论

从以上的例子可见能够并发、并行操作步骤占整体系统运行操作的比例越高,则系统可优化的比例越大,但不能超过一个由串并操作比例决定的极限值。操作中I/O密集型占比越高则单个多核服务器可支持并发的任务数就越大,需要的服务器数量就越少。互联网web服务器属于I/O密集型服务,当进行相应的配置选择时,需要将I/O密集型服务作为重要设计依据之一进行相应的架构设计。

参考《Java Concurrency in Practice》-8.2章节,

依据《Programming Concurrency on the JVM Mastering》

https://en.wikipedia.org/wiki/Amdahl%27s_law