- 1打印容器_3D打印:增材点阵结构在压力容器优化设计中的应用

- 2zabbix技术遇到的问题3--ZBX_NOTSUPPORTED: Unsupported item key._zbxd)zbx_notsupportedinvalid item key format.

- 3k8s使用volume将ConfigMap作为文件或目录直接挂载_从零开始入门 K8s | Kubernetes 存储架构及插件使用...

- 4vsCode离线安装remote-ssh插件搭建远程开发环境_remote-ssh 离线下载

- 5Python2.7 CentOS7 处理报错 ImportError: No module named psycopg2

- 6What is Ark? (Ark是什么?)_it 中ark是什么

- 7查看删除短信_+cmti

- 8pycharm+mobaxterm通过跳板机连接实验室服务器_mobaxterm设置跳板机

- 9docker 运行 java jar_docker 容器运行 jar,读取jar 外配置文件

- 10后端接收前端url请求传的一个数组ids_url传来的数组怎么接收

python中shape用法_python shape

赞

踩

一维矩阵

二维矩阵

更详细讲解:Python里对于shape()的理解

Python里对于shape()的理解

(1)shape()含义

在笔者debug深度学习相关代码的时候,很容易出现shape()这样形式的东西,用来告知输出数据的形式,由于shape()里出现的数字数量不同,还经常有shape(?,64,512)这样的数据存在,因此上网查了一些信息,作出比较通俗易懂的解释:

import numpy as np

a = np.array([[[1,2,3],[4,5,6]]])

print(a.shape)

(1, 2, 3)

- 1

- 2

- 3

- 4

表示该数组有1个,是2行3列的数组。每一个shape里的数字对应数组中的一对中括号,第一个数字1表示最外层的中括号。以此类推,数字2表示第二层中括号,数字3表示最里层的中括号。如果定义array时去掉了最外层的括号那么输出的shape为(2, 3)。

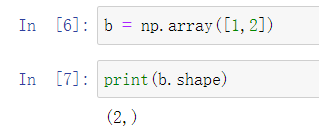

(2)区分一维数组和二维数组

有几个中括号就为几维数组,即shape后的结果中就有几个数。

因此在上文中,有三对中括号,是3维数组,shape()中有3个数。

a = np.array([1,2]) #a.shape值(2,),意思是一维数组,数组中有2个元素。

b = np.array([[1],[2]]) #b.shape值是(2,1),意思是一个二维数组,每行有1个元素。

c = np.array([[1,2]]) #c.shape值是(1,2),意思是一个二维数组,每行有2个元素。

- 1

- 2

- 3

(3)shape()中“?”的含义

而在debug相关程序时,可能会出现shape(?,2,3)这便代表数组每一个都是2行3列的,前面这个“?”便代表批处理个数,若为1则有1个,为2则有两个,但是在debug的时候不知道有几个,所以以“?”的形式显示。

(4)shape()中有四个数,第一个数表示时间序列(批处理数)

from keras.models import Input,Model

from keras.layers import Dense,Conv2D,TimeDistributed

input_ = Input(shape=(12,32,32,3))

out = TimeDistributed(Conv2D(filters=32,kernel_size=(3,3),padding='same'))(input_)

model = Model(inputs=input_,outputs=out)

model.summary()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

而这里,shape()中有四个数。第一个12代表就是时间序列,32,32,3指的是高,宽,通道数。卷积操作使用TimeDistributed就相当与这12个时间序列共享一个卷积层参数信息,无论时间序列值为多少,参数总量还是一定的。此处一共有896个参数,卷积核weights有3×3×3×32=864个,卷积核bias有32个。

附TimeDistributed解释

关于TimeDistributed有一个比较通俗的示例解释:

考虑一批32个样本,其中每个样本是一个由16个维度组成的10个向量的序列。该层的批输入形状然后(32, 10, 16)。

可以这么理解,输入数据是一个特征方程,X1+X2+…+X10=Y,从矩阵的角度看,拿出未知数,就是10个向量,每个向量有16个维度,这16个维度是评价Y的16个特征方向。

TimeDistributed层的作用就是把Dense层应用到这10个具体的向量上,对每一个向量进行了一个Dense操作,假设是下面这段代码:

model = Sequential()model.add(TimeDistributed(Dense(8), input_shape=(10, 16)))

- 1

输出还是10个向量,但是输出的维度由16变成了8,也就是(32,10,8)。

TimeDistributed层给予了模型一种一对多,多对多的能力,增加了模型的维度。