- 1android 自定义radiobutton 样式,RadioButton自定义点击时的背景颜色

- 2kafka命令行操作_kafka命令行发送消息

- 3使用 Java api在MongoDB中获取最后插入的文档ID_java mongo插入对象,返回主键到对象的属性中

- 4小梅哥Xilinx FPGA学习笔记15——基于SPI接口的ADC芯片驱动_adc128s102

- 5mysql索引—B+树 查找_b数索引查找过程

- 6SELINUX=enforcing时无法启动httpd服务的解决方案(semanage命令以及setroubleshoot-server插件的妙用)

- 7git教程(基于vscoede)_vscode git版本回退

- 8一个驱动商业创新的业务中台长啥样?让它来告诉你!_社会化商业架构最直接的体现是什么

- 9java微服务应用层join_《中台架构与实现 DDD和微服务》核心思想

- 10深度学习_PyCharm入门_pycharm深度学习

16、Kafka ------ SpringBoot 整合 Kafka (配置 Kafka 属性 及对应的 属性处理类 解析)_springboot 连接 kafka

赞

踩

配置 Kafka 及对应的 属性处理类

配置Kafka

spring.kafka.* 开头的配置属性,这些属性将由 KafkaProperties类(属性处理类)负责处理。

属性处理类: KafkaProperties

以 spring.kafka.* 开头的属性,是对 生产者、消费者、管理API、流API 都有效的 通用配置 。

以 spring.kafka.producer.* 开头的属性,说明这些配置属性仅对 消息生产者 有效;

以 spring.kafka.consumer.* 开头的属性,说明这些配置属性仅对 消息消费者 有效;

以 spring.kafka.admin.* 开头的属性,说明这些配置属性仅对 管理者API 有效;

以 spring.kafka.streams.* 开头的属性,说明这些配置属性仅对 流API 有效;

以 spring.kafka.listener.* 开头的属性,说明这些配置属性仅对 Kafka的监听器的容器工厂 有效;

以 spring.kafka.template.* 开头的属性,说明这些配置属性仅对 KafkaTemplate 有效;

…

其他以此类推

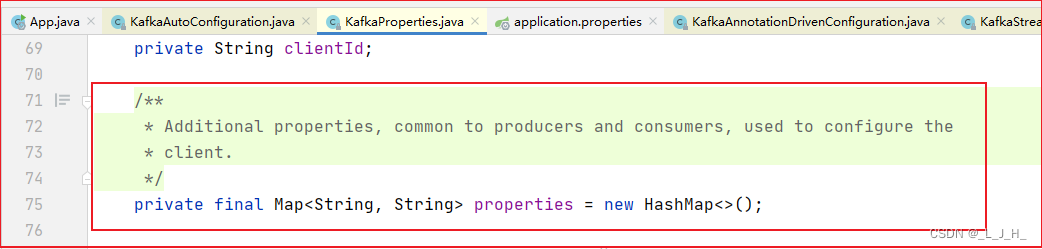

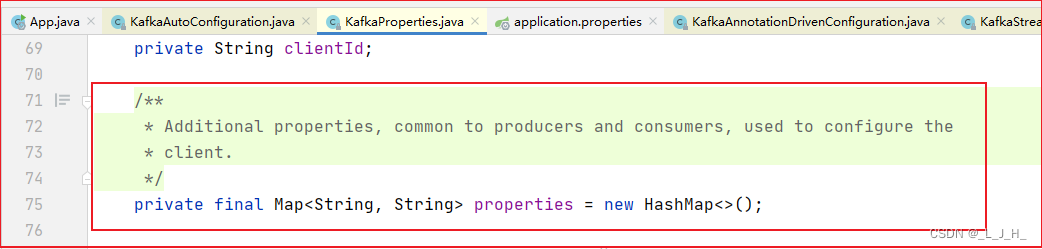

不管是KafkaProperties类,还是Producer、Consumer、Admin、Streams等内部类,它们都定义了一个Map<String, String>类型的properties属性,这个属性用于配置通用属性。

比如可以定义如下配置:

spring.kafka.properties[prop.one]=first

- 1

Kafka配置属性的约定

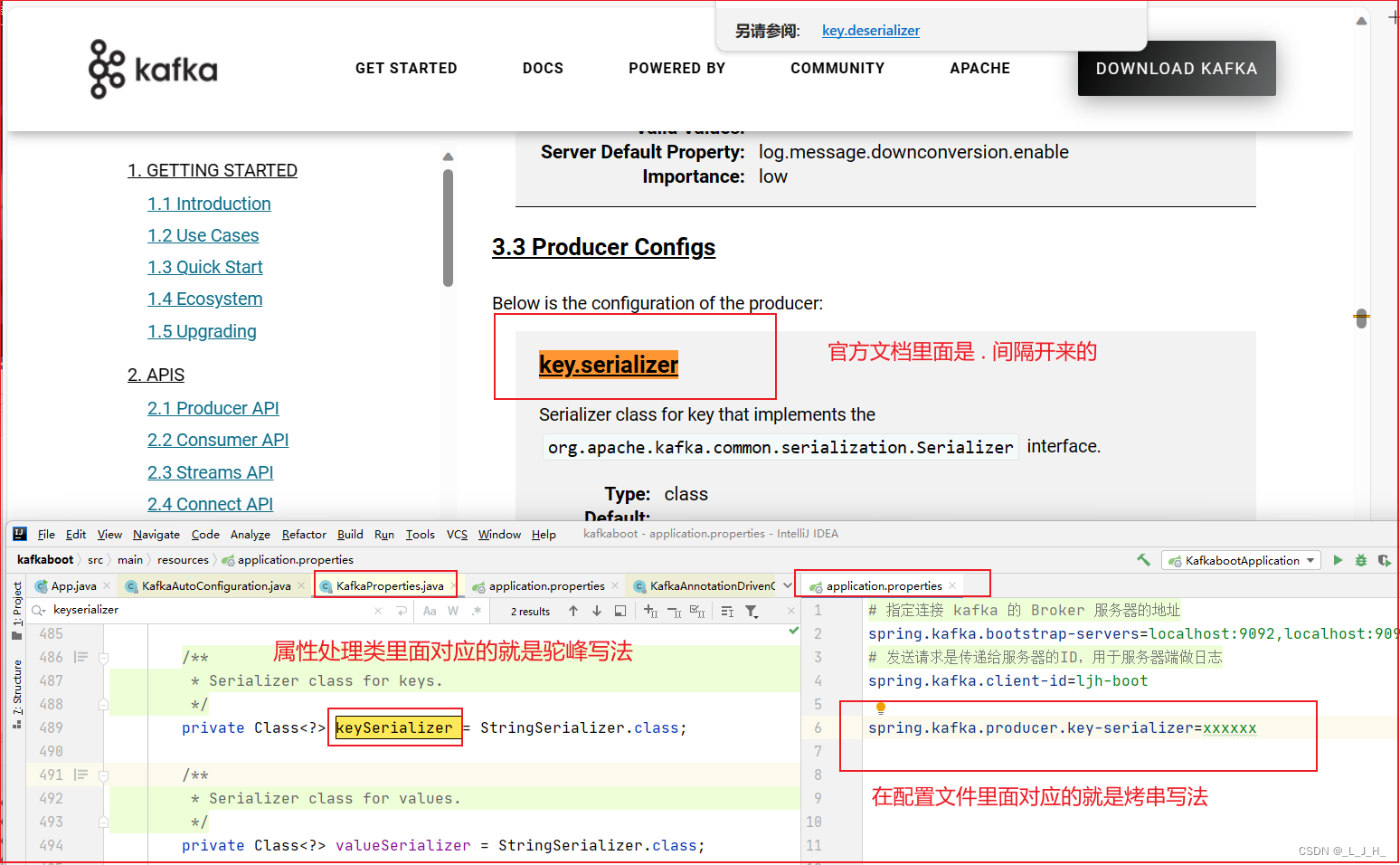

Spring Boot为Kafka的常用配置属性都提供了对应字段,

比如 Kafka 的生产者配置支持 key.serializer 属性,Spring Boot 就在 Producer 内部类中定义了一个 keySerializer 字段来与之对应,

这样就允许 在application.properties 配置文件中定义如下配置:

spring.kafka.producer.key-serializer=...

- 1

上面这行配置其实就对应于为 Kafka 生产者配置中的 key.serializer 属性,

只不过是将 Kafka 配置中点号(.)分隔的属性,变成了中划线分隔。

如图:

问题在于 Kafka 支持的配置属性实在太多,而且随着版本的升级,Kafka 完全可能会加入更多的配置属性。为了能支持 Kafka 所有可能的属性,Spring Boot也支持如下配置:

spring.kafka.properties[prop.one]=first —— 此处 properties 中属性名、属性值都需要自行控制(参考Kafka文档)

- 1

此处的 properties 是一个Map类型,因此它可以接受无数的 key-value对,

其中 key 将作为 Kafka 的配置属性名,value 将作为 Kafka 的配置属性值。

Spring Boot会忠实地将“prop.one”附加属性及对应的值传给Kafka,至于该属性是否起作用则取决于Kafka本身

kafka 提供了一致的模型,无论后面版本是新增额外的配置属性或删减,都可以通过这个 properties 传进来这个KafkaProperties属性处理类。

【备注】:

当你要为消息生产者、消费者、管理API、流API等配置属性时,常用属性可通过 Producer内部类、Consumer内部类、Admin内部类、Streams内部类 的对应属性来进行配置。

还有一些额外的配置属性,都应该通过 .properties 来配置。

代码演示

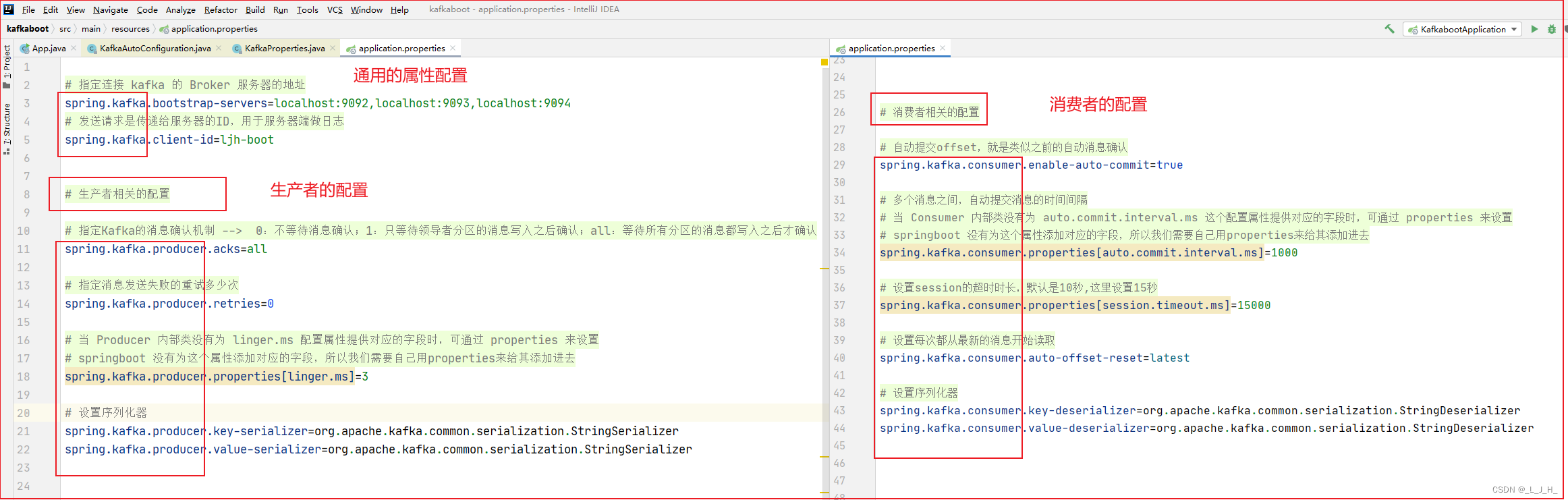

以 spring.kafka.* 开头的属性,是对 生产者、消费者、管理API、流API 都有效的 通用配置

生产者相关的配置

如图,我们在配置文件中配置的生产者需要的一些属性,跟我们自己写一个生产者时添加的配置是一样的,只是写法不一样,一个是写在配置文件里面,一个是简单的写在类里面。

配置文件中的属性,如果 springboot 有为它提供对应的字段,那么点击该属性,是可以跳转到对应的字段里面去的。

能点进去,说明这个配置属性是有效的。

消费者相关的配置

可以看出和之前写的消费者的对应属性

代码(配置文件)

application.properties

# 指定连接 kafka 的 Broker 服务器的地址

spring.kafka.bootstrap-servers=localhost:9092,localhost:9093,localhost:9094

# 发送请求是传递给服务器的ID,用于服务器端做日志

spring.kafka.client-id=ljh-boot

# 生产者相关的配置

spring.kafka.producer.acks=all

spring.kafka.producer.retries=0

# 当 Producer 内部类没有为 linger.ms 配置属性提供对应的字段时,可通过 properties 来设置

# springboot 没有为这个属性添加对应的字段,所以我们需要自己用properties来给其添加进去

spring.kafka.producer.properties[linger.ms]=3

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

# 消费者相关的配置

# 自动提交offset,就是类似之前的自动消息确认

spring.kafka.consumer.enable-auto-commit=true

# 多个消息之间,自动提交消息的时间间隔

# 当 Consumer 内部类没有为 auto.commit.interval.ms 这个配置属性提供对应的字段时,可通过 properties 来设置

# springboot 没有为这个属性添加对应的字段,所以我们需要自己用properties来给其添加进去

spring.kafka.consumer.properties[auto.commit.interval.ms]=1000

# 设置session的超时时长,默认是10秒,这里设置15秒

spring.kafka.consumer.properties[session.timeout.ms]=15000

# 设置每次都从最新的消息开始读取

spring.kafka.consumer.auto-offset-reset=latest

# 设置序列化器

spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.StringDeserializer

spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializer

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37