- 1MessageBox shellcode_mengssagebox shellcode

- 2kafka java详解_Kafka 全解析

- 3es _update_by_query 查询_192.168.20.20:3007

- 4Docker网络

- 5【Gitee】如何在gitee上使用Git+一个仓库管理多个项目代码,个人探索经验,内含git管理、上传代码文件_能否使用一个代码仓管理多套代码

- 6python 使用 mechanize 模拟浏览器访问网页_python中mechanize登录网页

- 7jdk1.8中,java 抽象类和接口的区别_jdk1.8之前抽象类和接口的区别

- 82020首届数字四川创新大赛_诈骗电话识别数据统计分析(一)_2020年数字四川创新大赛

- 9解决IDEA:Failed to locate the winutils binary in the hadoop binary path

- 10element-ui使用心得之三:怎么看element官方文档_autocomplete events

AI 绘画简史_绘画程序aaron

赞

踩

从机械臂到梦境创造者,艺术与科技的交响曲。

艺术,这个人类的独有领域,在历经数千年的发展后,如今与科技强强联合,掀起了新一轮的变革。今天,我们将回溯 AI 绘画的发展历程,见证一个由机械臂变为梦境创造者的传奇。握紧这把时光的钥匙,让我们解锁 AI 绘画简史的每一个精彩瞬间。

1970s:机械臂的浪漫 — AARON 项目

在 70 年代,一位艺术家,哈罗德:科恩 Harold Cohen(画家,加利福尼亚大学圣地亚哥分校的教授)就开始打造电脑程序”AARON"进行绘画创作.只是和当下Al 绘画输出数字作品有所不同,AARON 是真的去控制一个机械臂来作画的。Harold 对 AARON 的改进一直持续了几十年,直到他离世。在 80 年代的时候,ARRON ”掌握”了三维物体的绘制;90 年代时,AARON 能够使用多种颜色进行绘画,据称直到今天,ARRON 仍然在创作。

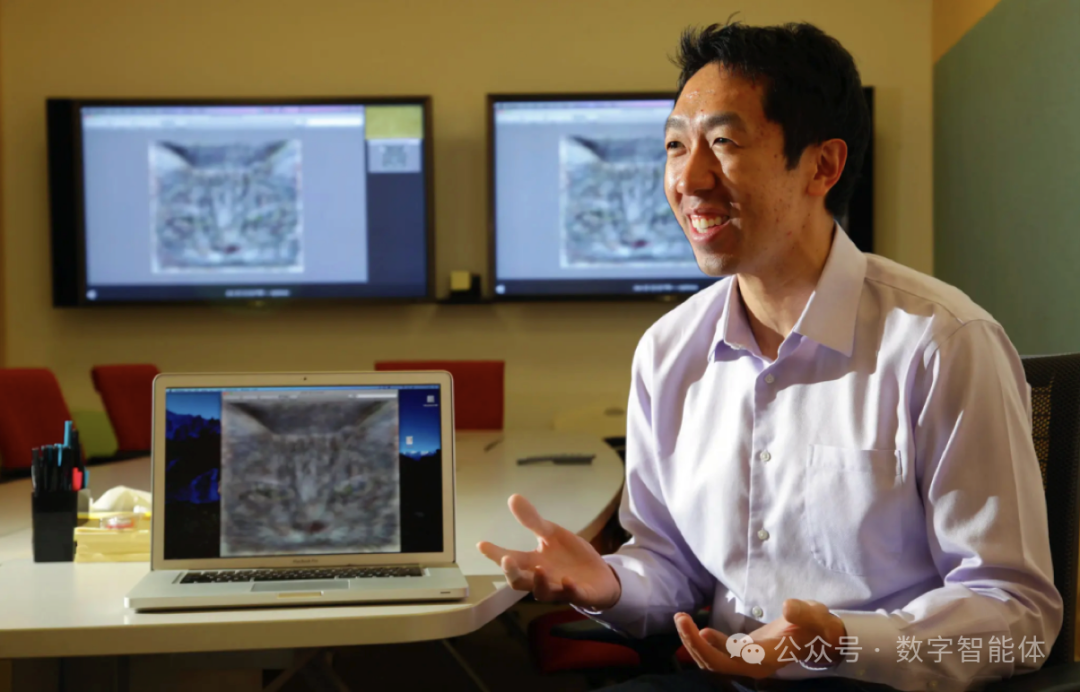

2012 年:首次揭幕 — Google 的 “猫脸革命”

在 2012 年 Google 两位大名鼎鼎的 Al 大神,吴恩达和 Jeff Dean 进行了一场空前的试验,联手使用 1.6 万个 CPU 训练了一个当时世界上最大的深度学习网络,用来指导计算机画出猫脸图片。当时他们使用了来自 youtube 的 1000 万个猫脸图片,1.6 万个 CPU 整整训练了 3 天,最终得到的模型,令人振奋地可以生成一个非常模糊的猫脸。

2014 年:对抗与生成 — GAN 网络的冒险

在 2014 年,Al 学术界提出了一个非常重要的深度学习模型,这就是大名鼎鼎的对抗生成网络 GAN(Generative Adversarial Network, GAN)正如同其名字”对抗生成”这个深度学习模型的核心理念是让两个内部程序"生成器(generator)”和"判别器(discriminator)”互相 PK 平衡之后得到结果。

论文地址:https://arxiv.org/abs/1406.2661

2015 年:梦境开端 — Deep Dream 的异想世界

2015 年 11 月,《Deep Unsupervised Learning using Nonequilibrium Thermodynamics》论文发表,是扩散模型的开山之作,奠定了扩散模型的理论基础和基本框架。

论文地址:https://arxiv.org/abs/1503.03585

同一年,Google 发布了一个图像工具深梦(DeepDream)。Google 通过 DeepDream,将代码编织成梦。它提供了一窥 AI 的“梦境”的难得机会,而这些“梦境”画作,实现了与人类观众的首次对话。

深梦发布了一系列画作,一时吸引了很多眼球。谷歌甚至为这个深梦的作品策划了一场画展。

画展地址:https://deepdreamgenerator.com/

2017 年:初识简约 — Google 的 “sketch-rnn”

艺术的极简,有时比复杂更难。Google 的 sketch-rnn,以最简的笔触,演绎了日常物体背后的深刻哲思。

在 David Ha 与 Douglas Eck 合作的论文《A Neural Representation of Sketch Drawings》中,研究者设计了一个名为「sketch-rnn」 的生成式 RNN,它能够用简单的笔触描绘出日常物体,系统旨在训练机器如何像人类一样提炼事物的抽象概念。

研究者在一个手绘 sketches 数据集中进行训练,控制提笔落笔的时间及方向,进而创造一个具有可观前景的应用:不仅术家迸发艺术灵感,还能教授学生绘画的基本技巧。

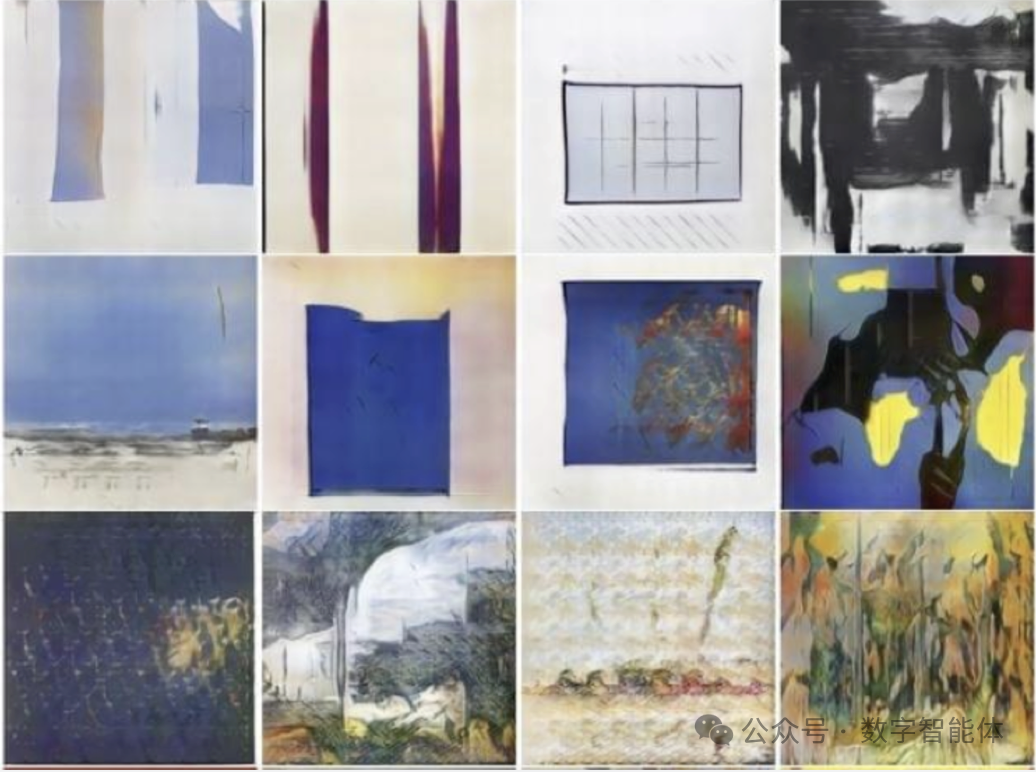

2017 年:创新风潮 — Facebook 的 CAN 网络

这一年,Facebook 在艺术与技术间架起了一座桥梁。CAN 网络首次不再模仿,而是创造,引领着 AI 向着艺术家的身份更进一步。

2017 年 7 月,Facebook 联合罗格斯大学和查尔斯顿学院艺术史系三方合作得到的新模型,号称创造性对抗网络(CAN, Creative Adversarial Networks)。

从作品集可以看出,这个创造性对抗网络 CAN 在尝试输出一些像是艺术家作品的图画,它们是独一无二的,而不是现存艺术作品的仿品。

2019 年 & 2020 年:扩散模型之光

基于梯度估计的生成模型和 DDPM 的诞生,标志着 AI 绘画技术的一个突破。这种新的画布,让 AI 的创作变得更加精细而充满无限可能。

2019 年 7 月:《Generative Modeling by Estimating Gradients of the Data Distribution》论文发表。这是 Nips 2019 的 Oral 论文,一作是清华、斯坦福毕业的宋飏博士。这篇工作提出了基于“score”的生成式模型,和扩散模型有着千丝万缕的联系。

论文地址:https://arxiv.org/abs/1907.05600v3

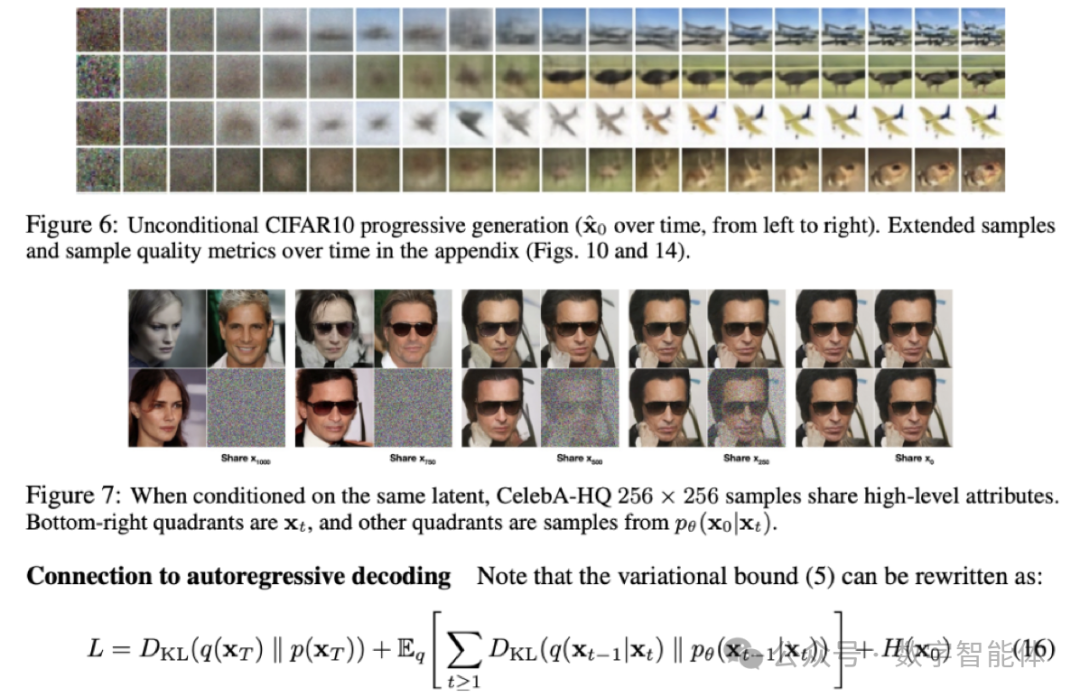

2020 年 6 月:加州伯克利大学提出了 DDPM 模型。如今生成扩散模型的大火,则是始于 2020 年所提出的 DDPM(Denoising Diffusion Probabilistic Model),虽然也用了“扩散模型”这个名字,但事实上除了采样过程的形式有一定的相似之外,DDPM 与传统基于朗之万方程采样的扩散模型可以说完全不一样,这完全是一个新的起点、新的篇章。

论文地址:https://arxiv.org/abs/2006.11239

2020 年 11 月:(Score-Based Generative Modeling through Stochastic Differential Equations》论文发表。该论文构建了一个相当一般化的生成扩散模型理论框架,将 DDPM、SDE、 ODE 等诸多结果联系了起来,也是扩散模型的奠基论文之一,第一作者为宋飏博士。

论文提出了一个随机微分方程(SDE),通过缓慢注入噪声,将复杂的数据分布平滑地转换为已知的先验分布,以及一个相应的反向时间 SDE,通过缓慢去除噪声将先验分布转换回数据分布。

论文地址:https://arxiv.org/abs/2011.13456v2

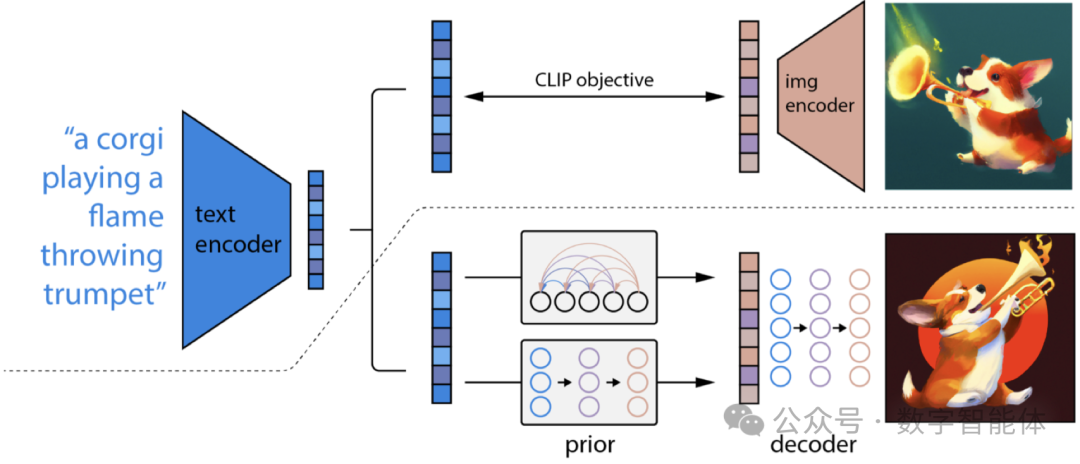

2021 年:触摸现实 — OpenAI 的 CLIP 与微软的 LoRA

CLIP 的到来使 AI 的图像与文字理解迈上了新台阶,而 LoRA 的出现,则让这场盛宴的参与者们变得更加庞大。

OpenAI 团队,在 2021 年 1 月开源了新的深度学习模型 CLIP(Contrastive Language-lmage Pre-Training)。一个当今最先进的图像分类人工智能。

CLIP 训练 AI 同时做了两个事情,一个是自然语言理解,一个是计算机视觉分析。它被设计成一个有特定用途的能力强大的工具,那就是做通用的图像分类,CLIP 可以决定图像和文字提示的对应程度,比如把猫的图像和”猫”这个词完全匹配起来。

论文地址:https://openai.com/research/clip

2021 年 6 月:微软发布 LoRA 论文。LORA,英文全称 Low-Rank Adaptation of Large Language Models, 直译为大语言模型的低阶适应,这是微软的研究人员为了解决大语言模型微调而开发的一项技术。

比如,GPT-3 有 1750 亿参数,为了让它能干特定领域的活儿,需要做微调,但是如果直接对 GPT-3 做微调,成本太高太麻烦了。

LoRA 的做法是,冻结预训练好的模型权重参数,然后在每个 Transformer(Transforme 就是 GPT 的那个 T)块里注入可训练的层,由于不需要对模型的权重参数重新计算梯度,所以,大大减少了需要训练的计算量。

论文地址:https://arxiv.org/abs/2106.09685

2022 年:光影交响 — Disco Diffusion 与 MidJourney 的诗意空间

Disco Diffusion 让抽象图形变得触手可及,而 MidJourney 的诗意探险,则彻底打开了 AI 在艺术上的想象之门。

2022 年 3 月:Disco Diffusion 发布,正是第一个基于 CLIP + Diffusion 模型的实用化 Al 绘画产品,擅长于大场景的抽象图形。

2022 年 7 月:MidJourney V3 上线。Midjourney 自发布以来迭代速度非常快。2022 年 3 月 V1 发布时仍参考了很多的开源模型;4 月、7 月和 11 月分别发布了 V2、 V3 和 V4,迭代出了自己的模型优势。V4 补充了生物、地点等信息;增强了对细节的识别能力及多物体/多人物的场景塑造能力。总之,每次迭代都是产品功能的飞跃。

图为《太空歌剧院》。2022 年 8 月,美国科罗拉多州举办艺术博览会,《太空歌剧院》获得数字艺术类别冠军,此作品是游戏设计师 Jason Allen 使用 Midjourney 生成。

2022 年 8 月:Stable Diffusion 上线,并开源。Stable Diffusion 于 2022 年 8 月推出,以开源底层代码的形式在 HuggingFace/Github 公开发布。“将 AIGC交到数十亿人手中,实现技术民主化”,用户可以在其代码的基础上运行或修改,制作自己的应用程序,向终端用户提供服务。作为稀缺的开源模型,同时有着良好的性能,公测后就受到了广泛的关注和好评,积累了大量用户。截止 2022 年 10 月,Stable Diffusion 已经有超过 20 万开发者下载和获得授权,各渠道累计日活用户超过 1000 万。团队开发的付费在线平台DreamStudio 目前获得了超过 150 万用户,生成超过 1.7 亿图片。

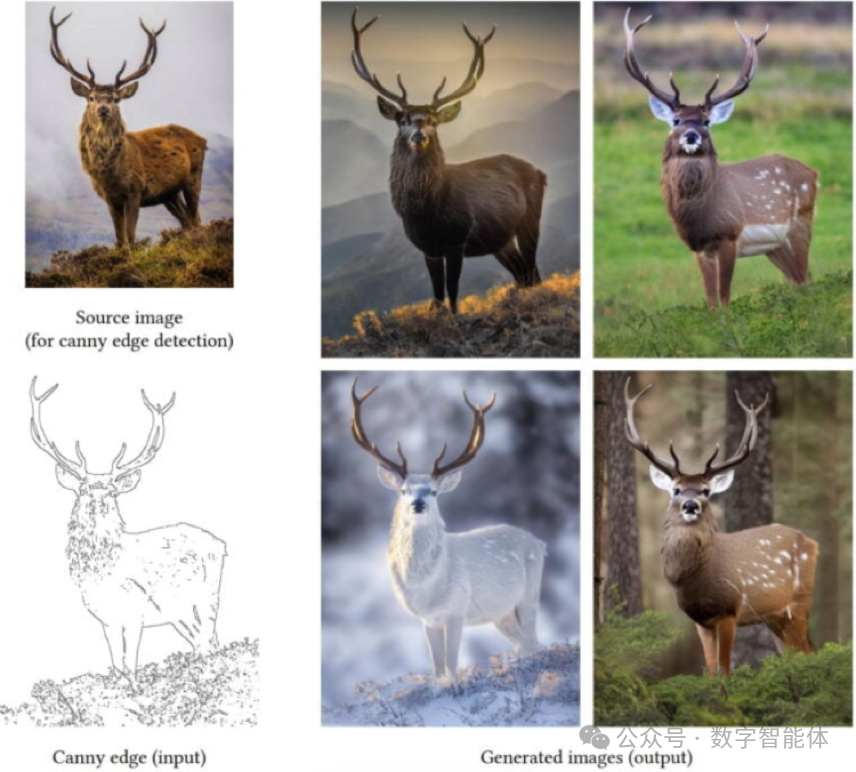

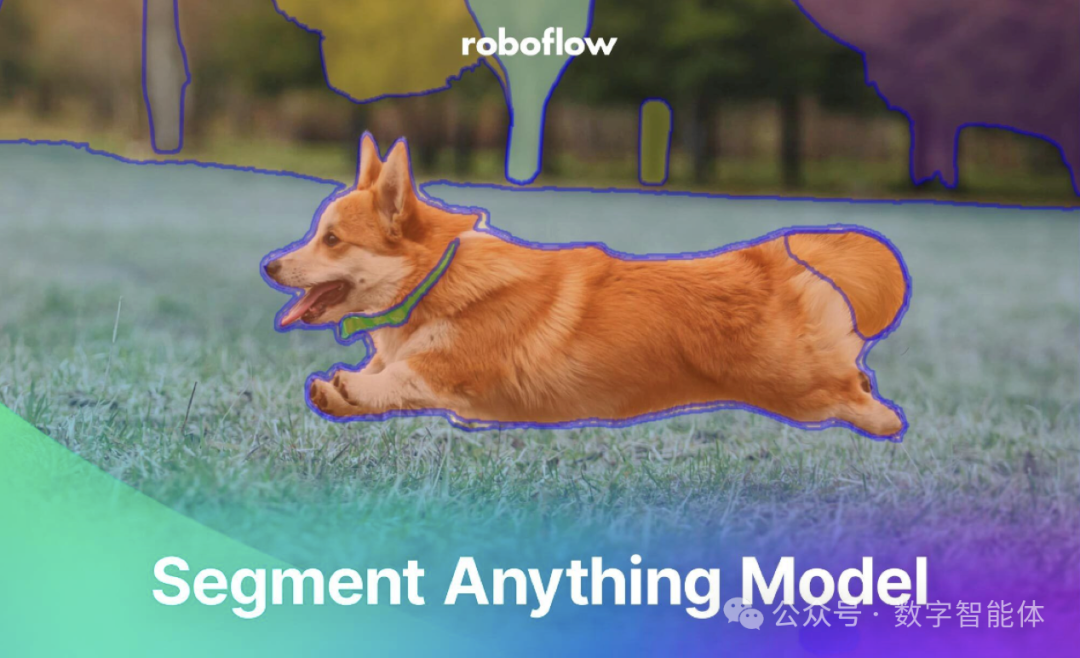

2023 年:掌控画笔 — ControlNet 与 SAM 的卓越视域

ControlNet 与 Segment Anything (SAM) 的登场,不仅增强了 AI 创作的精确性、可控性,还拉近了 AI 与艺术的距离。

2023 年 2 月:发布 ControiNet(斯坦福张吕敏)。可控生成模式的出现,意味着 AIGC 走入了直立行走的时代。对于生成式模型,可控性一直是被人最为诟病的大问题之一。历史的方案更多是使用大力出奇迹的方式,不断地尝试 prompt 的线性组合 + 大批生产图片,给足了使用者空间的同时,也带来了大量的不足之处。但是 ControlNet 的出现意味着 AI 创作进入了直立行走的时代。

2023 年 4 月:Meta 发布图像分割 Segment Anything。正如名字“Segment Anything”一样,该模型可以用于分割图像中的一切对象,包括训练数据中没有的内容。交互方面,SAM 可使用点击、框选、文字等各种输入提示(prompt),指定要在图像中分割的内容,这也意味着,用于自然语言处理的 Prompt 模式也开始被应用在计算机视觉领域。对于视频中物体,SAM 也能准确识别并快速标记物品的种类、名字、大小,并自动用 ID 为这些物品进行记录和分类。

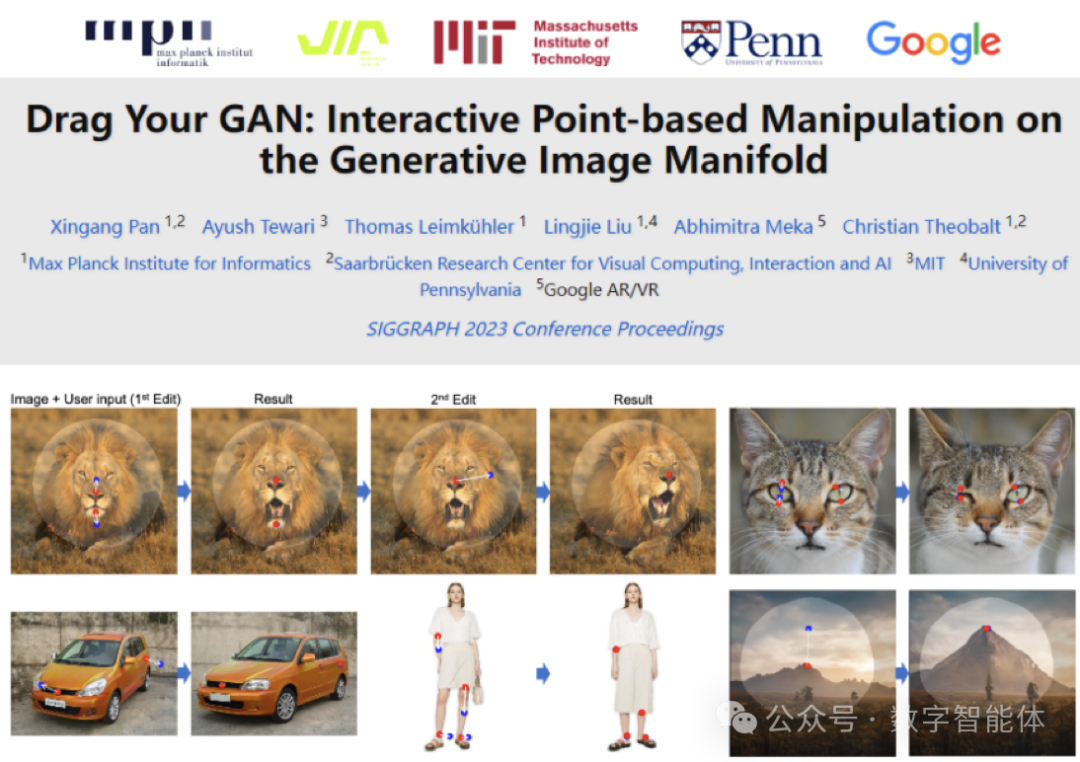

2023 年 6 月:DragGAN 开源。DragGAN 是一款基于生成对抗网络(GANs)技术的图片编辑项目。追根潮源,其实还是 NVIDIA 的 StyleGAN 的衍生项目。

DragGAN 由两个主要部分组成:第一部分是基于特征的运动监督,通过控制起始点向目标点运动,实现图像的变形;

第二部分是新的点跟踪方法,即最近邻检索,通过在相同的特征空间上进行点跟踪,提高了效率,并避免了累计误差损失。

简单来说,它能够让你轻松掌控图片中的人物和动物,通过拖拽控制点和目标点来调整他们的位置、形状、姿势等等。

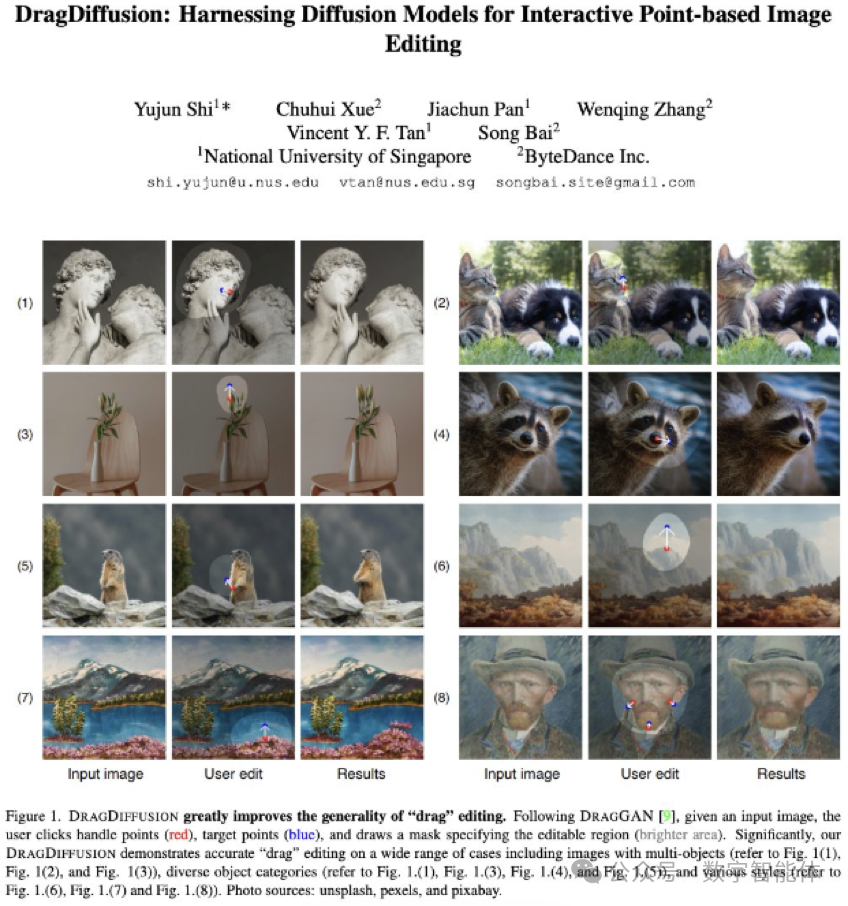

2023 年 6 月:DragDiffusion 论文发布。精确和可控的图像编辑是一项具有挑战性的任务,已经引起了极大的关注。最近,DragGAN 实现了一个基于点的交互式图像编辑框架,并以像素级的精度实现了令人印象深刻的编辑结果。然而,由于该方法是基于生成对抗网络 (GAN),其通用性受到预先训练好的 GAN 模型能力的上限限制。在这项工作中,我们将这样一个编辑框架扩展到扩散模型,并提出 DragDiffusion。通过利用大规模预训练的扩散模型,我们大大改善了基于点的交互式编辑在现实世界场景中的适用性。虽然大多数现有的基于扩散的图像编辑方法是在文本嵌入的基础上工作的,但 DragDiffusion 优化了扩散潜势,以实现精确的空间控制。虽然扩散模型以迭代的方式生成图像,但我们的经验表明,在一个单一步骤中优化扩散潜势就足以产生连贯的结果,使 DragDiffusion 能够有效地完成高质量的编辑。在各种具有挑战性的情况下(如多物体、不同的物体类别、各种风格等)进行的广泛实验证明了 DragDiffusion 的多功能性和通用性。

2023 年 9 月:DALL • E 3 发布。DALL • E3 是 OpenAl 在 2023 年 9 月份发布的一个文生图模型。与上一代模型 DALL • E 2 最大的区别在于,它可以利用 ChatGPT 生成提示 (prompt),然后让模型根据该提示生成图像。对于不擅长编写提示的普通人来说,这一改进大大提高了 DALL • E 3 的使用效率。

此外,与 DALL • E2 相比,DALL • E3 生成的图质量也更高。

诞生,成长,现在的 AI,逐渐从技术的边缘走到了艺术的中心。它所绘的每一幅画面,都是人类文明交织精神与物质的记录。今天的我们,已站在一个新的艺术世界的门槛上。

我们有多少故事,AI 就能绘就多少画卷。从 AARON 的机械臂,到 DALL•E 3 的精神火花,AI 正成为我们共同创造未来的伙伴。在这千变万化的世界中,唯一不变的,是那份探求艺术与科技结合的激情和毅力。

一个崭新的艺术纪元正在召唤。那么问题来了,你准备好与 AI 一同探索艺术的新领域了吗?可以给我们发私信聊聊你的畅想,告诉我们你对 AI 艺术的期待!

——“如果你要向星空探索,把握好画笔,因为树木的根在于风中,梦在 AI 的羽翼之下。”

写在最后

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除