- 1【阿里云】如何开放80端口_云开80

- 2Hibernate 一级缓存(session级别)、二级缓存(sessionFactory级别)以及查询缓存,当然还要讨论下我们的N+1的问题

- 3Vue前端框架_前端 vue 架构模板

- 4CentOS7 开放端口操作_centos7开放22端口指令

- 5关于spring boot加载自定义配置文件失败的原因_springboot配置文件加载环境变量失败

- 6systemctl重新加载_如何配置systemd在重新加载时杀死并重启守护进程?

- 7云计算新宠:探索Apache Doris的云原生策略

- 8Windbg调试命令详解_windbg .open -a 7ff8cd5fa84c

- 9TCP过程中,网络断开问题解决办法_tcp异常断开处理

- 10WDS服务搭建和部署Win10_wds安装win10

深入理解LLaMA, Alpaca, ColossalChat 系列模型

赞

踩

知乎:紫气东来

https://zhuanlan.zhihu.com/p/618695885

一、从 LLaMA 到 Alpaca:大模型的小训练

1.1 LLaMA 概要与实践

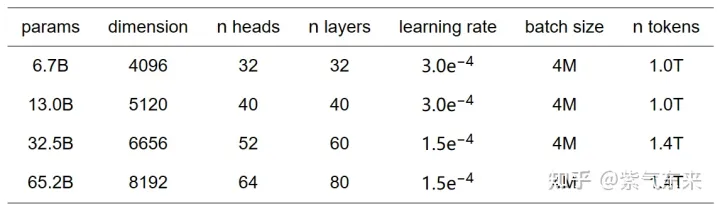

LLaMA(Large Language Model Meta AI) 是由 Meta AI 发布了一款全新的大型语言模型,共有7B、13B、33B、65B 四种版本,其模型参数如下表所示:

与原始的 transformer Decoder 相比,LLaMA主要有以下改进:

预归一化(Pre-normalization)[GPT3]

为了提高训练的稳定性,LLaMA对每个transformer子层的输入进行归一化,而不是对输出进行归一化。同时使用RMSNorm归一化函数。SwiGLU激活函数[PaLM]

LLaMA用SwiGLU激活函数取代ReLU非线性,以提高性能。SwiGLU激活函数的实现如下:

其中 ,,具体实现参考这里[1]。

旋转嵌入(Rotary pos)[GPTNeo]

LLaMA删除了绝对位置嵌入,取而代之的是在网络的每一层添加旋转位置嵌入(RoPE),RoPE的实现参见这里[2]。当前 HuggingFace 已经实现了 LLaMA 模型 代码,可通过以下方式直接调用:

- from transformers import LlamaForCausalLM

- USE_8BIT = True # use 8-bit quantization; otherwise, use fp16

- model = LlamaForCausalLM.from_pretrained(

- "pretrained/path",

- load_in_8bit=USE_8BIT,

- torch_dtype=torch.float16,

- device_map="auto",

- )

- if not USE_8BIT:

- model.half() # use fp16

- model.eval()

1.2 Alpaca 如何使用小成本训练大模型

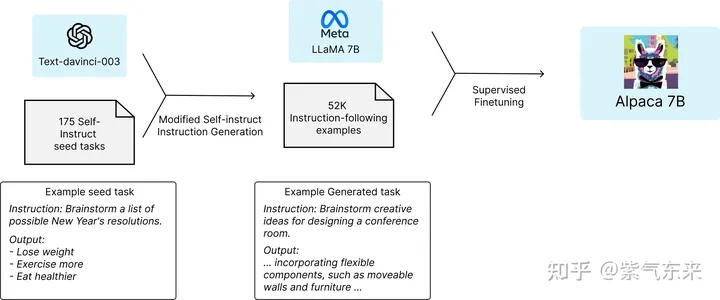

如下图所示,Stanford的研究者使用 52K 个 intruction-following examples 来微调 LLaMA 7B 模型,从而生成了 Alpaca[3] 7B。

Alpaca 团队使用 self-instruct[4] 提供的 175 个 prompts,调用 OpenAI 的text-davinci-003模型,利用 OpenAI 的模型来产生有价值的 instructions 。

将 OpenAI 性能完备的模型作为 Teacher,来指导参数更少的 Alpaca 模型进行训练,大幅降低了训练成本 。其中调用 OpenAI API 的成本不到 500 美元,另外微调 7B 参数的 LLaMA 模型,使用云服务商提供的 8 块 80GB A100 显卡,训练 3 小时,消费不到 100 美元,因此整体成本是小于 600 美元。

二、Alpaca 的优化、训练及应用

2.1 alpaca-lora 的优化

alpace-lora[5] 是在alpaca的基础上把训练方式改成用lora训练,仅需要在消费级的GPU上经过数小时的训练,就可以达到和alpaca差不多的效果。

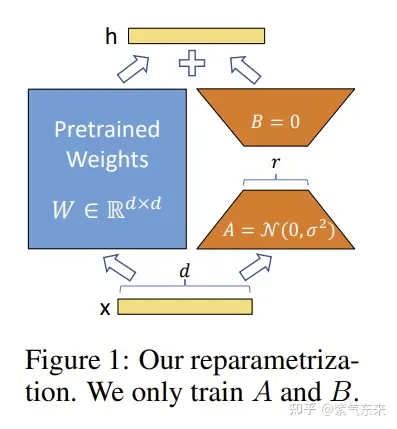

LoRA(Low-Rank Adaptation) 技术

LoRA 的思想很简单,即在原始 Pretrained Weights 旁边增加一个旁路,做一个降维再升维的操作,来模拟所谓的 intrinsic rank 。训练的时候固定 Pretrained Weights 的参数,只训练降维矩阵 与升维矩阵 。而模型的输入输出维度不变,输出时将 与 Pretrained Weights 的参数叠加。用随机高斯分布初始化 ,用0矩阵初始化 ,保证训练的开始此旁路矩阵依然是 0 矩阵。

具体来看,假设预训练的矩阵为,它的更新可表示为:

其中秩。

LoRA与Transformer的结合也很简单,仅在QKV attention的计算中增加一个旁路,而不动MLP模块。基于大模型的内在低秩特性,增加旁路矩阵来模拟全模型参数微调,LoRA通过简单有效的方案来达成轻量微调的目的,可以将现在的各种大模型通过轻量微调变成各个不同领域的专业模型。

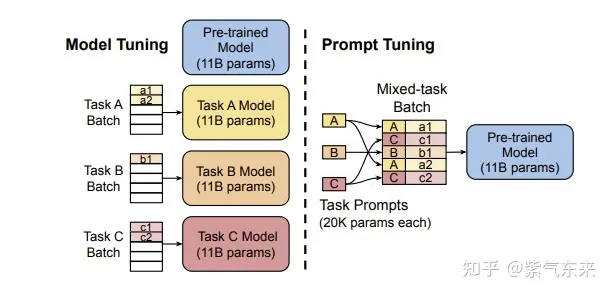

2.2 PEFT(Parameter-Efficient Fine-Tuning) 方法

随着模型变得越来越大,在消费级硬件上对模型进行全部参数的微调变得不可行。此外,为每个下游任务独立存储和部署微调模型变得非常昂贵,因为微调模型与原始预训练模型的大小相同。PEFT 方法旨在解决这两个问题,PEFT 方法仅微调少量 (额外) 模型参数,同时冻结预训练 LLM 的大部分参数,从而大大降低了计算和存储成本。

HuggingFace 开源的一个高效微调大模型的 PEFT 库,目前包含LoRA,Prefix Tuning,Prompt Tuning,P-Tuning 四种算法,下面简要介绍后三种:

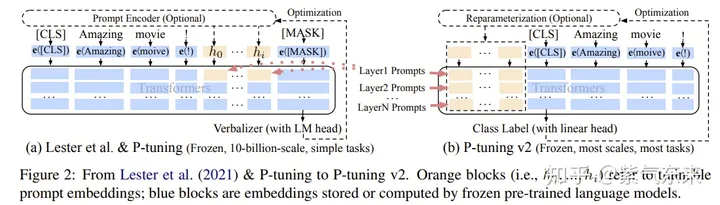

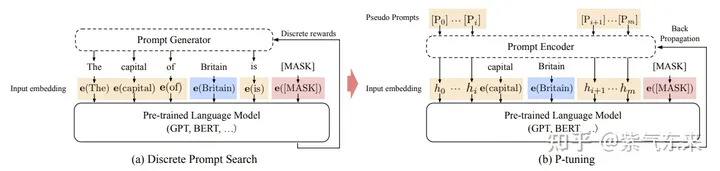

Prefix Tuning

Prefix Tuning 算法是根据 下游任务 "前缀指令文本" 的所有层的embeding表示,学习到的前缀指令文本向量可以挖掘大模型的潜力去引导模型完成特定任务。

P-Tuning

P-Tuning 算法和 Prefix Tuning 的想法很相似,想通过微调"指令文本",让指令文本去挖掘大模型的潜力去完成特定的任务。但是 P-Tuning 只学习 "指令文本" 输入层embeding的的表示。为了增强 "指令文本"的连续性,采用了一个 MLP(LSTM) 的结果去encoding "指令文本"。从微调参数量来看只有 0.65% 比 Prefix Tuning 和 LoRA 这些在所有层都增加参数的方法要少。

Prompt Tuning

Prompt Tuning 算法和 P-Tuning 很像,且更简单,就是是根据 下游任务 "指令文本" 输入层embeding的的表示。Prompt Tuning 没有增加任何的层,直接使用微调指令文本(prompt) 的embeding向量。

2.3 使用 PEFT 训练 alpaca-lora

以下仅说明过程,完整代码见这里[6]。

step 1. 模块的加载及初始化

- import torch

- import transformers

- from datasets import load_dataset

- from peft import LoraConfig, get_peft_model, get_peft_model_state_dict, prepare_model_for_int8_training, set_peft_model_state_dict,

- from transformers import LlamaForCausalLM, LlamaTokenizer

-

- model = LlamaForCausalLM.from_pretrained(base_model, load_in_8bit=True, torch_dtype=torch.float16, device_map=device_map,)

- tokenizer = LlamaTokenizer.from_pretrained(base_model)

- model = prepare_model_for_int8_training(model)

-

- config = LoraConfig(

- r=lora_r,

- lora_alpha=lora_alpha,

- target_modules=lora_target_modules,

- lora_dropout=lora_dropout,

- bias="none",

- task_type="CAUSAL_LM",

- )

- model = get_peft_model(model, config)

step 2. 准备data 和 trainer 并进行训练

- data = load_dataset(data_path)

- trainer = transformers.Trainer(

- model=model,

- train_dataset=train_data,

- eval_dataset=val_data,

- args=transformers.TrainingArguments(

- per_device_train_batch_size=micro_batch_size,

- gradient_accumulation_steps=gradient_accumulation_steps,

- warmup_steps=100,

- num_train_epochs=num_epochs,

- learning_rate=learning_rate,

- fp16=True,

- logging_steps=10,

- optim="adamw_torch",

- evaluation_strategy="steps" if val_set_size > 0 else "no",

- save_strategy="steps",

- eval_steps=200 if val_set_size > 0 else None,

- save_steps=200,

- output_dir=output_dir,

- save_total_limit=3,

- load_best_model_at_end=True if val_set_size > 0 else False,

- ddp_find_unused_parameters=False if ddp else None,

- group_by_length=group_by_length,

- report_to="wandb" if use_wandb else None,

- run_name=wandb_run_name if use_wandb else None,

- ),

- data_collator=transformers.DataCollatorForSeq2Seq(

- tokenizer, pad_to_multiple_of=8, return_tensors="pt", padding=True

- ),

- )

-

- trainer.train(resume_from_checkpoint=resume_from_checkpoint)

2.4 更多类似模型

Baize (白泽)

论文:https://arxiv.org/pdf/2304.01196.pdf

demo: Baize Lora 7B - a Hugging Face Space by project-baize

repo: https://github.com/project-baize/baize

Luotuo (骆驼,Chinese)

repo: https://github.com/LC1332/Luotuo-Chinese-LLM

Koala (考拉)

blog: Koala: A Dialogue Model for Academic Research

demo: FastChat

repo: https://github.com/young-geng/EasyLM

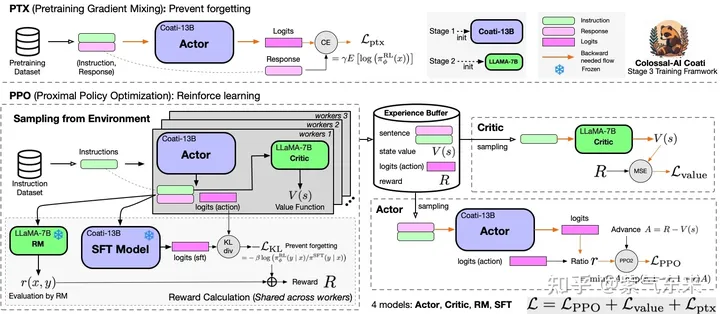

三、ColossalChat:深入体验 RLHF 在大模型中的功能

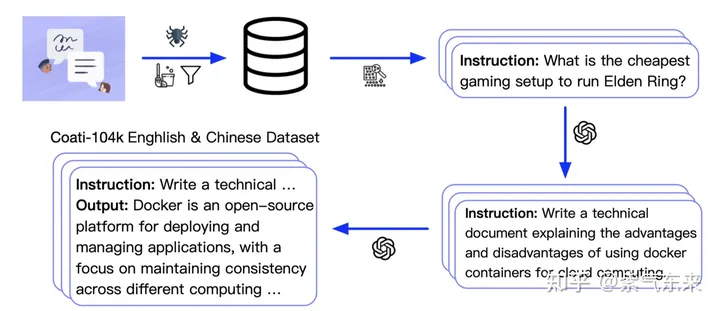

ColossalChat[7] 是第一个基于LLaMA预训练模型开源完整RLHF pipline实现,包括有监督数据收集、有监督微调、奖励模型训练和强化学习微调。只需要不到100亿个参数,就可以在大型语言模型的基础上通过RLHF微调达到中英文双语水平,达到与ChatGPT和GPT-3.5相当的效果,并可以进行Demo测试。关于RLHF的原理,可参考

https://zhuanlan.zhihu.com/p/613315873

ColossalChat使用InstructionWild[8]双语数据集,包含约52K的英语和52K的汉语问答,数据集通过OpenAI API接口获得。该数据集适用于微调和RLHF训练。通过提供高质量的数据,ColossalChat可以实现更好的对话互动,也可以支持中文。

3.1 监督指令微调

使用前面提到的数据集执行有监督指令微调,以微调模型。运行examples/train_sft.sh来启动有监督的指令微调。

- torchrun --standalone --nproc_per_node=4 train_sft.py \

- --pretrain "/path/to/LLaMa-7B/" \

- --model 'llama' \

- --strategy colossalai_zero2 \

- --log_interval 10 \

- --save_path /path/to/Coati-7B \

- --dataset /path/to/data.json \

- --batch_size 4 \

- --accimulation_steps 8 \

- --lr 2e-5 \

- --max_datasets_size 512 \

- --max_epochs 1 \

3.2 训练奖励模型

训练奖励模型,通过手动对同一提示的不同输出进行排序来分配相应的分数,然后有监督奖励模型的训练。

运行examples/train_rm.sh开始奖励模型训练。

- torchrun --standalone --nproc_per_node=4 train_reward_model.py

- --pretrain "/path/to/LLaMa-7B/" \

- --model 'llama' \

- --strategy colossalai_zero2 \

- --loss_fn 'log_exp'\

- --save_path 'rmstatic.pt' \

3.3 人类反馈强化学习

在第一阶段的监督微调模型和第二阶段的奖励模型的基础上,使用强化学习算法进一步训练大型语言模型。该阶段是RLHF训练的核心部分,在强化学习中使用近端策略优化(PPO)算法来引入奖励信号,并生成更符合人类偏好的内容。

运行examples/train_prompts.sh,开始使用人类反馈训练PPO。

- torchrun --standalone --nproc_per_node=4 train_prompts.py \

- --pretrain "/path/to/LLaMa-7B/" \

- --model 'llama' \

- --strategy colossalai_zero2 \

- --prompt_path /path/to/your/prompt_dataset \

- --pretrain_dataset /path/to/your/pretrain_dataset \

- --rm_pretrain /your/pretrain/rm/defination \

- --rm_path /your/rm/model/path

进NLP群—>加入NLP交流群(备注nips/emnlp/nlpcc进入对应投稿群)

持续发布自然语言处理NLP每日优质论文解读、相关一手资料、AI算法岗位等最新信息。

加入星球,你将获得:

1. 每日更新3-5篇最新最优质的的论文速读

2. 最新入门和进阶学习资料

4. 每日1-3个NLP、搜广推、CV等AI岗位招聘信息

参考资料

[1]

SiLUActivation: "https://github.com/huggingface/transformers/blob/main/src/transformers/activations.py#L140"

[2]RoPE: "https://nn.labml.ai/transformers/rope/index.html"

[3]Alpaca: "https://github.com/tatsu-lab/stanford_alpaca"

[4]self-instruct: "https://github.com/yizhongw/self-instruct"

[5]alpace-lora: "https://github.com/tloen/alpaca-lora"

[6]alpaca-lora: "https://github.com/tloen/alpaca-lora/blob/main/finetune.py"

[7]ColossalChat: "https://github.com/hpcaitech/ColossalAI/tree/main/applications/Chat"

[8]InstructionWild: "https://github.com/XueFuzhao/InstructionWild/tree/main/data"