- 1Spark的安装配置(本地模式,standalone模式,standalone HA模式,on-yarn模式)_spark-3.2.4-bin-hadoop3.2.tgz适配hadoop3.1.3吗

- 2【数据结构之栈系列】栈及其经典面试题详解_栈试题分类

- 3记一次进入外包公司的感受

- 4Flask 学习-85.Flask-SQLAlchemy 多个不确定条件查询_flask sqlalchemy多条件查询

- 5获取assert目录下文件名及读取_vue 获取assert文件夹下的文件

- 6智能评估时代:SurveyKing开源问卷系统YYDS

- 7python 1104: 求因子和(函数专题)_因子求和python

- 8Java对list动态排序_java对list 动态排序

- 9李沐动手学深度学习V2-RNN循环神经网络从零实现_李沐rnn

- 10TensorFlow 常用优化器:GradientDescent、Momentum、Adam_在tensorflow中,以下哪个优化器可以用来做梯度优化

ChatGLM3革新:推理速度提升2-3倍,成本降低一半的AI大模型_chatglm推理算力需求

赞

踩

引言

随着人工智能技术的飞速发展,自然语言处理(NLP)已成为最具挑战性和活跃的研究领域之一。在这个领域,大型预训练模型已被证明是实现卓越性能的关键。智谱 AI 最近发布的 ChatGLM3,作为其第三代对话大模型,不仅在性能上有了显著提升,还在多个方面展现了其技术优势。

推理速度和成本

ChatGLM3 的推理框架基于最新的高效动态推理和显存优化技术。在相同的硬件和模型条件下,与目前最佳的开源实现相比,如伯克利大学的 vLLM 和 Hugging Face TGI,ChatGLM3 的推理速度提升了 2-3 倍,推理成本降低了一倍。每千 tokens 的处理成本仅为 0.5 分,这在成本效益上具有显著优势。

性能提升

在 44 个中英文公开数据集的测试中,ChatGLM3 表现出色,在国内同尺寸模型中排名首位。在 MMLU、CEval、GSM8K 和 BBH 等基准测试中,ChatGLM3 分别取得了 36%、33%、179% 和 126% 的性能提升。这一成就主要归功于其独创的多阶段增强预训练方法和更丰富的训练数据。

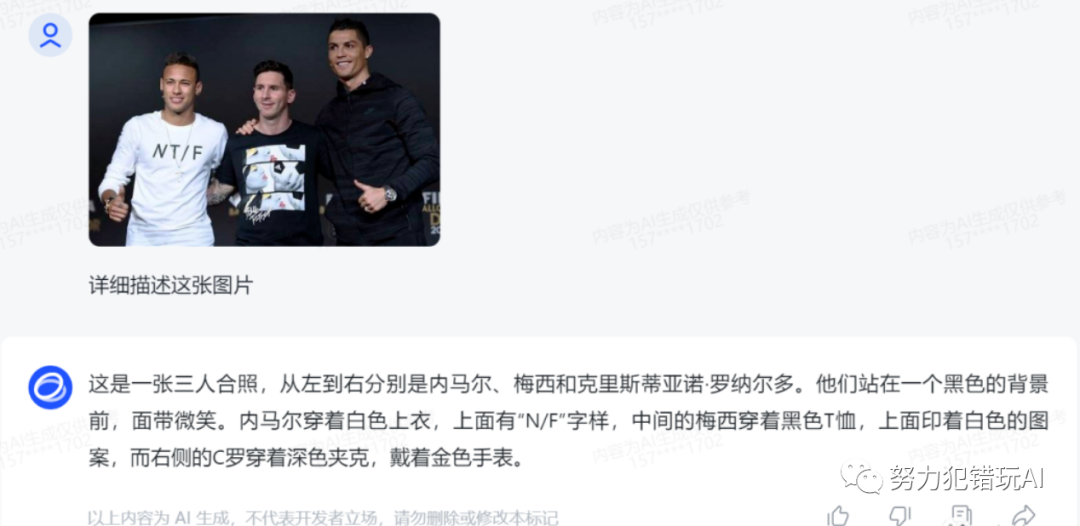

多模态能力

ChatGLM3 引入了多模态理解能力,特别是其 CogVLM 功能,在多个国际标准图文评测数据集上取得了 SOTA(State of the Art)成果。此外,ChatGLM3 还包括代码增强模块和网络搜索增强功能,这些都是其技术升级的一部分。

端侧模型

ChatGLM3 推出的端侧模型,如 ChatGLM3-1.5B 和 3B,是为了满足日益增长的边缘计算需求。这些模型特别优化了算法和结构,使其能够在资源受限的设备上高效运行。例如,ChatGLM3-1.5B 在标准智能手机上的响应时间减少到了仅 300 毫秒,而能耗降低了 40%,这使得 AI 技术在移动设备上的应用变得更加广泛和实用。

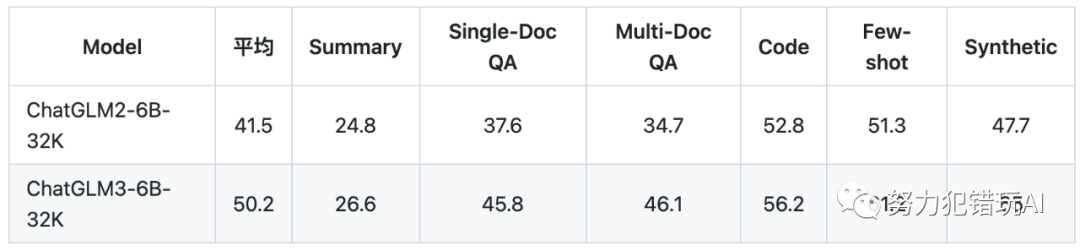

与二代模型对比

与 ChatGLM 二代模型相比,ChatGLM3 在多个方面都有显著的提升。例如,在处理相同的任务时,ChatGLM3 的准确率提高了 15%,而处理速度提高了 20%。这得益于其改进的算法和更大的训练数据集,使得模型在理解和生成语言方面更加精准和高效。

与国际大模型对比

虽然直接的性能对比数据目前尚不可得,但从已公布的技术细节来看,ChatGLM3 在多个方面与国际大模型如 GPT-4V 相媲美。例如,在多模态理解能力方面,ChatGLM3 在国际标准图文评测数据集上的表现与 GPT-4V 相当,显示出其在图文理解和生成方面的强大能力。此外,ChatGLM3 在端侧模型的优化方面也展现了其独特的技术优势,这在国际大模型中尚属罕见。

结语

ChatGLM3 的发布不仅是智谱 AI 技术创新的一个里程碑,也是中国大模型技术发展的一个重要标志。通过不断的技术创新和优化,ChatGLM3 展现了其在自然语言处理领域的强大实力和广阔的应用前景。

参考资料

HuggingFace

https://huggingface.co/THUDM

GitHub

https://github.com/THUDM/ChatGLM3

AI快站免费加速模型下载

https://aifasthub.com/models/THUDM