热门标签

热门文章

- 1黑猴子的家:Redis 持久化 之 RDB_dump.rdb.bak

- 2重要一个设置 adb connect 由于目标计算机积极拒绝,无法连接。 (10061)_雷电模拟器 adb 连接 由于目标计算机积极拒绝,无法连接。 (10061)

- 3【ICML 2020】REALM: Retrieval-Augmented Language Model PreTraining

- 4「最新版」SpringBoot3.2.0官方教程实践01-构建一个RESTful Web服务_spring boot 3.2.0

- 5区块链和人工智能的关系以及经典案例_区块链和ai的关系

- 6通信算法之四十六:OFDM系统波形设计_shi算法 ofdm

- 7最新最详细的Python开发环境搭建以及PyCharm的安装配置教程【图+文】_pycharm最后的rebootnow

- 8Leetcode- 使字符串平衡的最小交换次数

- 9Vivado 3-8译码器 4-16译码器_4输入十六进制显示译码器vivado

- 10爬虫练习:Selenium使用案例

当前位置: article > 正文

十.SparkSQL之外部数据源操作mysql表数据_sparksql using org.apache.spark.sql.jdbc

作者:Cpp五条 | 2024-05-19 14:37:39

赞

踩

sparksql using org.apache.spark.sql.jdbc

引言:

Spark SQL还包括一个可以使用JDBC从其他数据库读取数据的数据源。与使用JdbcRDD相比,此功能应该更受欢迎。这是因为结果作为DataFrame返回,它们可以在Spark SQL中轻松处理或与其他数据源连接。JDBC数据源也更易于使用Java或Python,因为它不需要用户提供ClassTag。(请注意,这与Spark SQL JDBC服务器不同,后者允许其他应用程序使用Spark SQL运行查询)。

操作Mysql表数据

首先启动spark-shell,命令如下:

./spark-shell --master local[2] --jars ~/software/mysql-connector-java-5.1.38.jar

- 1

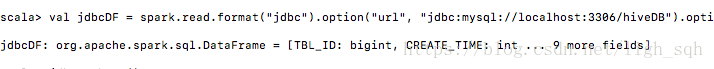

读操作方式一:

spark.read.format("jdbc").option("url", "jdbc:mysql://localhost:3306/hiveDB").option("dbtable", "hiveDB.TBLS").option("user", "root").option("password", "123456").load()

- 1

运行之后会产生下面这种错误:

java.sql.SQLException: No suitable driver

- 1

原因就是没有加载mysql的驱动Driver类,解决方法就是加上,新的命令如下:

spark.read.format("jdbc").option("url", "jdbc:mysql://localhost:3306/hiveDB").option("dbtable", "hiveDB.TBLS").option("user", "root").option("password", "123456").option("driver","com.mysql.jdbc.Driver").load()

- 1

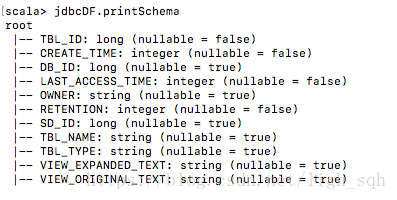

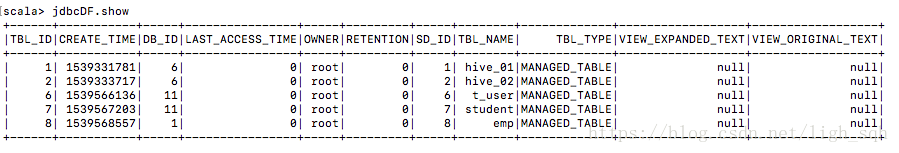

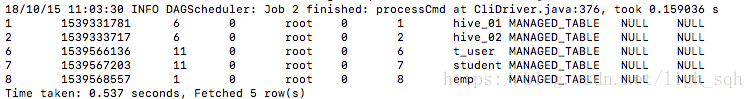

结果显示:

由于直接返回DataFrame类型的数据,可以通过printSchema和show方法进行查看操作,结果如下:

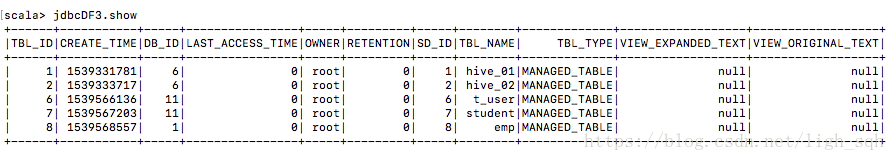

读操作方式二:

通过java中的Properties配置文件的形式进行读取:

import java.util.Properties

val connectionProperties = new Properties()

connectionProperties.put("user", "root")

connectionProperties.put("password", "123456")

connectionProperties.put("driver", "com.mysql.jdbc.Driver")

val jdbcDF3 = spark.read.jdbc("jdbc:mysql://localhost:3306", "hiveDB.TBLS", connectionProperties)

- 1

- 2

- 3

- 4

- 5

- 6

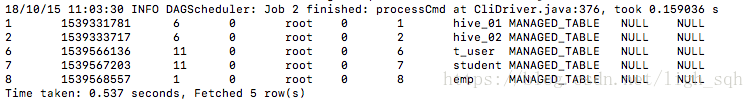

结果显示:

写操作方式一(通过spark-shell命令行):

// Saving data to a JDBC source

jdbcDF.write

.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306")

.option("dbtable", "schema.tablename") //创建新的表

.option("user", "username")

.option("password", "password")

.save()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

结果显示:

写操作方式二(通过spark-sql命令行):

启动spark-sql:

./spark-sql --master local[2] --jars ~/software/mysql-connector-java-5.1.38.jar

- 1

操作:

CREATE TEMPORARY VIEW jdbcTable

USING org.apache.spark.sql.jdbc

OPTIONS (

url 'jdbc:mysql://localhost:3306',

dbtable "hiveDB.TBLS",

user 'root',

password '123456',

driver 'com.mysql.jdbc.Driver' //一定要加驱动

);

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

结果显示:

至此就完成了SparkSQL的外部数据源对mysql数据表的操作.

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Cpp五条/article/detail/593334

推荐阅读

相关标签