- 1jenkins 自动化部署的实现(10)_remotedirectorysdf 什么意思

- 2sqlmap——json注入_sqlmap json注入

- 3Android—Jetpack教程(一)_android jetpack

- 4Fiddler抓不到包该怎么解决_fiddler抓不了包怎么办

- 5【LabVIEW FPGA入门】FPGA中的数据流

- 6Vue系列之—Vuex详解

- 7Linux “wget”命令详解_linux wget

- 8Java线上问题排查系列--系统问题排查的方法/步骤_java线上问题排查–系统问题排查的方法/步骤

- 9快应用开发商城app的实践分享 - 调试

- 10机器学习是如何利用线性代数来解决数据问题的_线性代数在机器人中的应用

OmniSLAM:多鱼眼相机的SLAM系统

赞

踩

作者 | dianyunPCL 编辑 | 点云PCL

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【SLAM】技术交流群

后台回复【SLAM综述】获取视觉SLAM、激光SLAM、RGBD-SLAM等多篇综述!

●论文摘要

本文提出了多鱼眼相机的定位和稠密SLAM系统,该系统使用超大视角(FOV)鱼眼相机,可以360°覆盖环境的立体环境。为了更实用、更精确的重建,首先引入改进的、轻量的深度神经网络来进行全方位深度估计,它比现有的网络更快、更精确。其次,将鱼眼相机深度估计整合到视觉里程表(VO)中,并添加一个循环闭合模块以实现地图全局一致性。利用估计的深度图,我们将关键点重新投影到另一个视图上,从而得到一个更好、更有效的特征匹配过程。最后,我们将鱼眼相机深度图和估计的姿态融合到TSDF中,得到三维地图。评估了方法在具有真值和数据集上的性能,大量的实验表明,该系统在合成和真实环境中都能产生良好的重建效果。

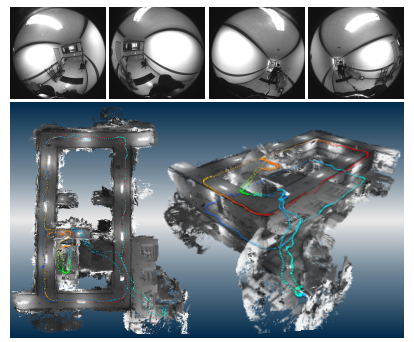

上图:输入具有挑战性的室内环境的示例图像。下图:一栋复式建筑的稠密重建图,带有估计的轨迹。轨迹的颜色代表高度值。

● 相关工作与介绍

主要贡献总结如下:

(i) 提出了一种轻量化和改进的网络鱼眼相机的深度估计。网络的精度、参数个数、运行时间等都比以前的版本有了很大的提高,使本系统更加实用。

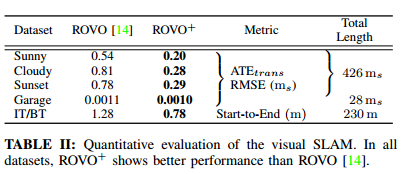

(ii)通过将深度图集成到ROVO(鲁棒的视觉里程计)中,并增加回环闭合模块,构建了一个鲁棒的全向视觉SLAM系统。在具有挑战性的室内和大型室外环境中,估算的轨迹精度比以前的版本有所提高。

(iii)提出了一个完整的全方位定位和稠密地图系统,并在合成环境和真实的室内外环境中进行了大量的实验,结果表明我们的系统能够为各种场景生成重建良好的三维稠密地图

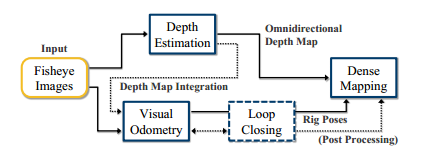

系统的流程图。首先使用给定的鱼眼图像估计深度图和位姿。如果可用,深度图将集成到视觉里程计中。将输出深度图和位姿融合到TSDF中,以构建3D地图。在后处理过程中,利用回环模块修正后的姿态建立全局一致的地图。

● 内容精华

A、 全深度估计

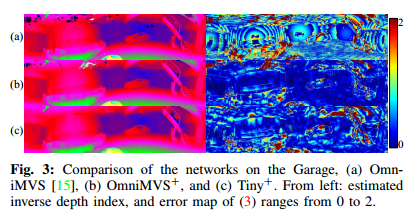

采用端到端网络OmniMVS,并在此基础上提出了Light-weighted OmniMVS。

B、视觉SLAM

定位也是三维稠密SLAM的重要组成部分,根据提出的ROVO[14]对全向立体鱼眼相机系统的姿态进行了稳健估计。在文章中,ROVO有四个步骤:鱼眼相机的投影、跟踪和匹配、姿态估计和联合优化。首先,将输入的鱼眼图像进行视觉矫正,在投影图像中检测到球的特征。其次,利用KLT对检测到的球体特征进行光流跟踪,并在相邻摄像机之间进行特征匹配。然后,跟踪上的特征被三角化到每个对应的3D点。第三,利用2D-3D特征对应关系,利用多视点P3P-RANSAC初始化姿态,并通过pose only bundle平差(BA)进行优化。最后,利用局部光束平差(LBA)同时对估计的姿态和观测到的三维点进行优化。

C. 基于TSDF稠密地图

为了获得全局的3D地图,将估计的全深度图和姿态融合到TSDF中。

● 实验

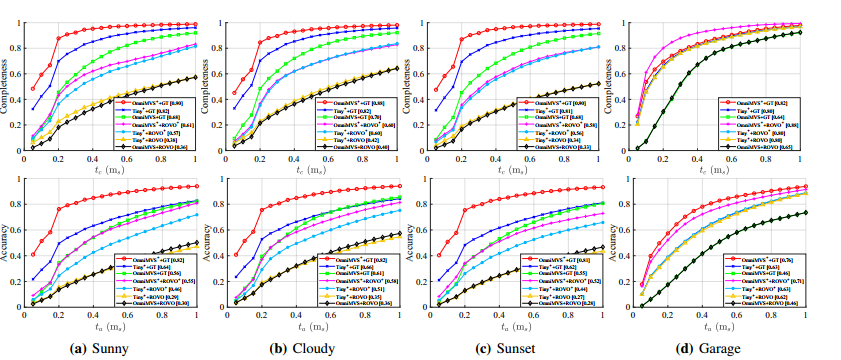

稠密地图结果的评估。顶部:完整性,底部:准确性。图例中显示了每种方法的平均比率。我们使用OmniMVS[15]、OmniMVS+和Tiny+作为深度;GT轨迹、ROVO[14]和ROVO+用于姿势。

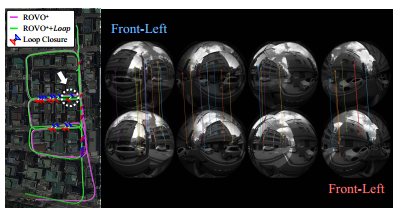

我们对Wangsimni数据集是否有闭环检测的影响对比。与检测到的回路闭合的轨迹比较结果。

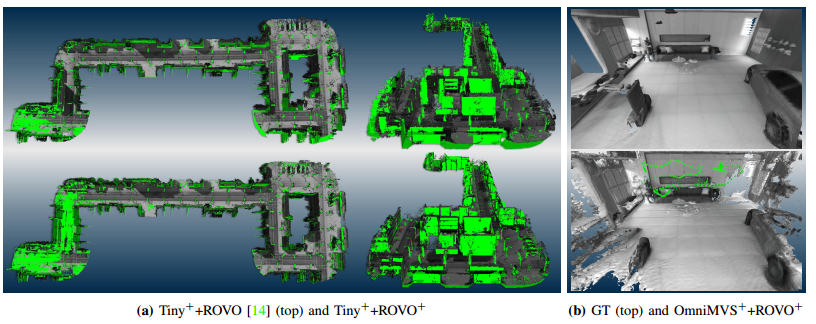

数据集的稠密SLAM结果。

(a)光照强烈的环境下。绿色代表GT地图。我们的ROVO+减少了估计姿态的漂移误差。

(b) 车库环境下。绿色表示前摄像头的估计轨迹

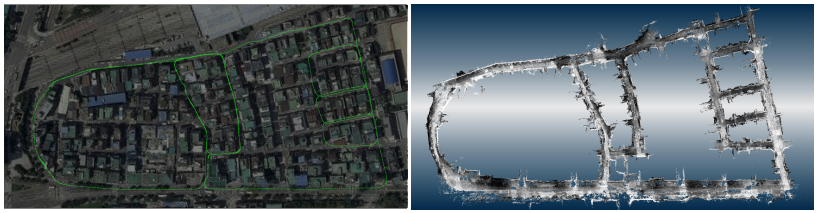

Wangsimni数据集的定性结果。左图:在卫星图像上垂直投影的估计轨迹。右:对应的稠密映射结果。我们将直方图均衡化应用于顶点颜色的可视化。

●总结

本文提出了一种适用于多鱼眼相机的定位与稠密地图的SLAM系统。该方法在参数较少的情况下,快速、准确地估计出全方位深度图。然后将输出深度图集成到视觉里程计中,提出的视觉SLAM模块实现了较好的姿态估计性能。实验表明,该系统能够生成良好的合成环境和真实环境三维地图。

往期回顾

盘一盘!实时自动驾驶车辆定位技术都有哪些?(视觉/Lidar/多传感器数据融合)

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、规划控制、模型部署落地、自动驾驶仿真测试、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称

自动驾驶之心【知识星球】

想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球(三天内无条件退款),日常分享论文+代码,这里汇聚行业和学术界大佬,前沿技术方向尽在掌握中,期待交流!