热门标签

热门文章

- 1MYSQL事务与MVCC_mysql中的事务和mvcc

- 2【自然语言处理(NLP)】基于PaddleNLP的短文本相似度计算_paddle短文本相似度计算

- 3python-django 招聘数据可视化系统_django招聘网站数据可视化

- 4【Python实战】随机图像数据集自动生成(原创)_python randimage

- 5Sora技术分解(dw00)

- 6二手车价格预测 | 构建AI模型并部署Web应用 ⛵_scikitlearn二手车价格预测模型

- 7改进YOLOv7 | 在 ELAN 模块中添加【Triplet】【SpatialGroupEnhance】【NAM】【S2】注意力机制 | 附详细结构图_triplet改进yolo

- 8年度书单盘点 | 史上最卷考研潮过后,这十本书让你不再迷茫

- 9【情商智慧:630】你混得好不好,这些能力很重要_高情商:630年 dddd

- 10美团NLP以及知识图谱文章提炼_iterative strategy for named entity recognition wi

当前位置: article > 正文

恒源云(GPUSHARE)_替代MLM的预训练任务,真的超简单吗?_预训练任务太简单

作者:Gausst松鼠会 | 2024-04-04 17:20:30

赞

踩

预训练任务太简单

文章来源 | 恒源云社区

原文地址 | 简单到令人沮丧的替代MLM的预训练任务?

原文作者 | Mathor

看了这么多篇社区大佬Mathor的文章,就在刚刚,我居然发现大佬居然、大概、可能、也许在diss某个训练说法!

哇哦,amazing!这么神奇的吗?

我这小八卦之心,熊熊燃起了啊!这到底是个啥子神奇的模型训练方法?

大伙也别急惹,让我完整的copy大佬的文章,然后一起一睹究竟!

正文开始

EMNLP2021有一篇论文标题名为Frustratingly Simple Pretraining Alternatives to Masked Language Modeling,翻译过来就是「简单到令人沮丧的替代MLM的预训练任务」。但我给它加了个问号,因为我觉得首先作者提出的这些方法,对于模型来说太难了,即便是让我去做他所提出的这些预训练任务,我都不一定做得出来。其次是从结果来看效果似乎一般般

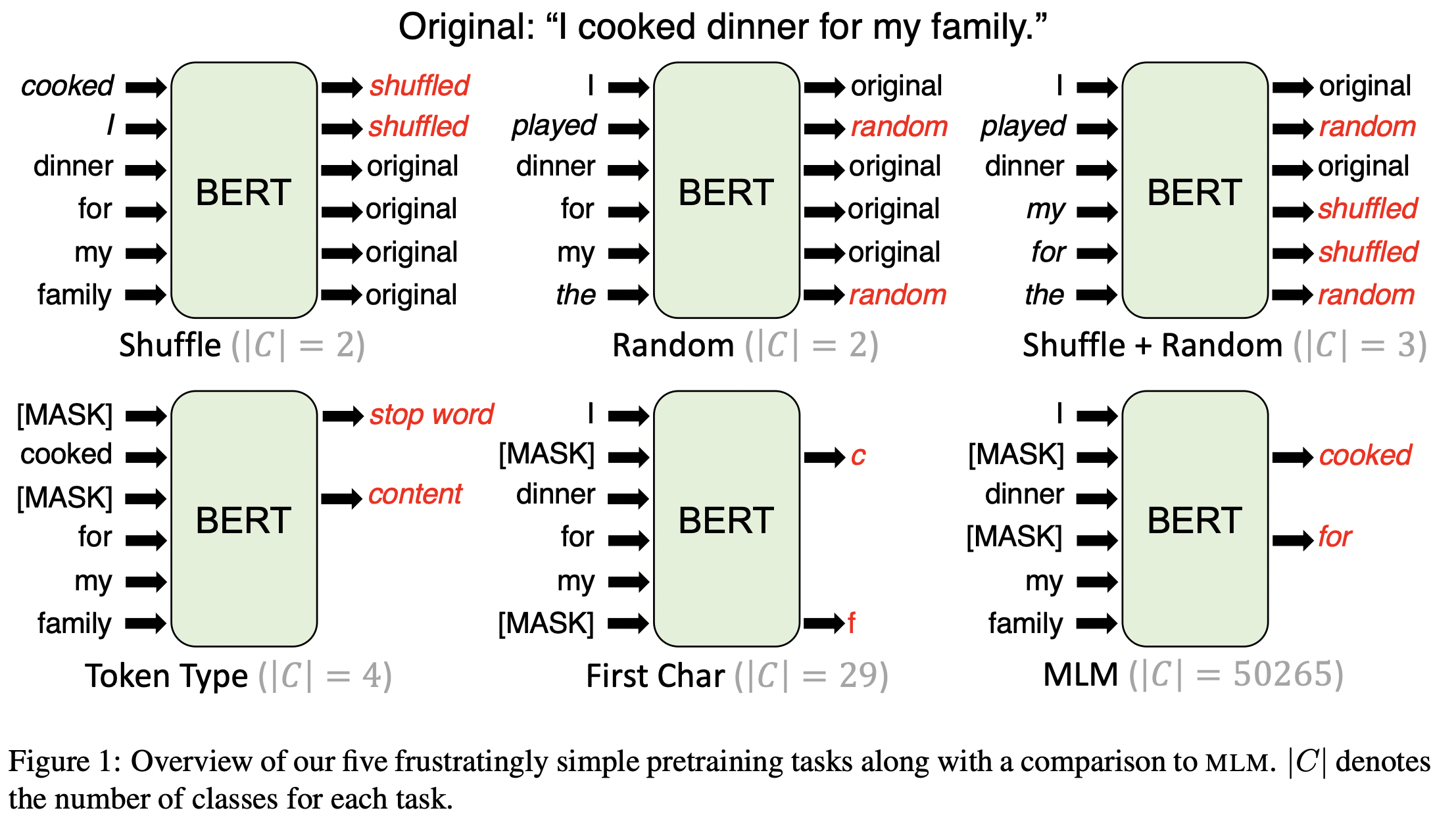

如下图所示,具体来说作者提出了4中用于替代MLM的预训练任务,分别是Shuffle、Random、Shuffle+Random、Token Type、First Char

PRETRAINING TASKS

Shuffle

作者提到这个方法的灵感来源于ELECTRA。具体来说,一个句子中有15%的token将会被随机调换顺序,然后模型需要做一个token级别的2分类问题,对于每一个位置预测该token是否被调换了位置。这个预训练任务的好处是,模型可以通过学习区分上下文中是否有token被打乱,从而获得句法和语义知识

对于Shuffle任务来说,其损失函数为简单的Cross-Entropy Loss:

其中 N N N表示一个样本的token数量, y i y_i yi和 p (

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/360102

推荐阅读

相关标签