热门标签

热门文章

- 1Python遍历特定文件夹下的所有文件名_python遍历目录文件名输出到特定文件

- 2vue开发鸿蒙,vue全套教程(实操)-1

- 3昆仑万维半年营收近18亿 旗下移动游戏平台启用独立品牌

- 4[报错]TypeError [ERR_INVALID_CALLBACK]: Callback must be a function

- 5JAVA二维数组的概述、定义格式、遍历、求和、杨辉三角、参数传递、数组加密_二维数组的定义java11

- 6springboot 修改启动时默认加载application.properties文件以及加载指定配置文件

- 7pycharm中terminal默认为Ps而不是命令行窗口_pycharm的工作台ps

- 8Mistral 7B 大型语言模型 — 小而强大(比 LLAMA2 13B 更好!) 探索 Mistral 7B LLM 独特的架构以及 GGLU(CPU) 和 GPU 版本无与伦比的性能_mistral大模型

- 9canvas基础

- 10Android英文名词解释大全(持续更新中......)_安卓加固 英文

当前位置: article > 正文

Gemma模型论文详解(附源码)_gemma的最大长度序列是多少

作者:Gausst松鼠会 | 2024-04-04 22:03:18

赞

踩

gemma的最大长度序列是多少

原文链接:Gemma模型论文详解(附源码)

1. 背景介绍

Gemma模型是在2023.2.21号Google新发布的大语言模型, Gemma复用了Gemini相同的技术(Gemini也是Google发布的多模态模型),Gemma这次发布了了2B和7B两个版本的参数,不仅提供了预训练的checkpoints,还提供了用于对话、指令跟随等fine-tune的checkpoints。在QA问答、常识。在11

2. 模型介绍

2.1 模型结构

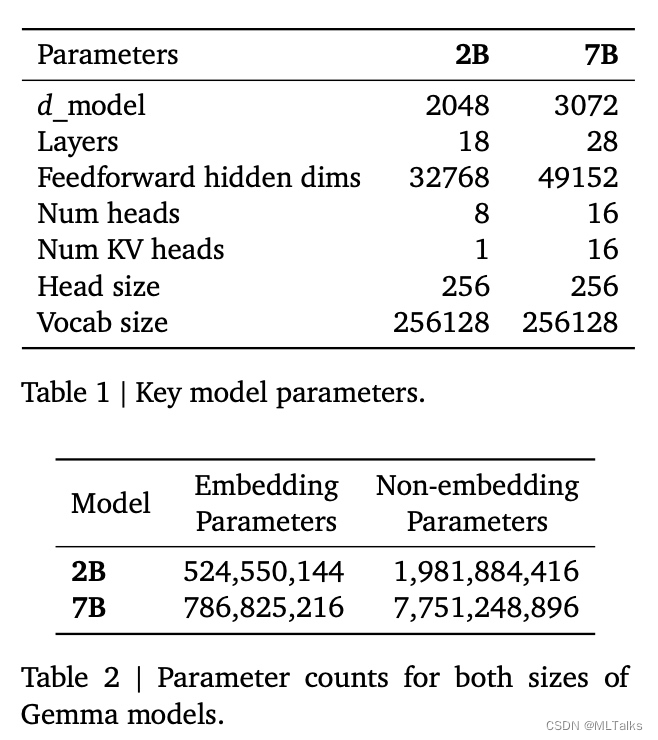

Gemma模型使用了transformer decoder结构进行训练,训练的上下文大小为8192个token,模型参数如下:

相比原始transformer结构的区别:

-

Multi-Query Attention:7B模型使用了

multi-head attention,2B模型使用了multi-query attention (with声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/361421

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。