- 1玩过Tauri和Electron,最终我选择Flutter进行跨平台应用开发_flutter electron对比

- 2RK3568-RK628D调试之HDMI-IN

- 3linux设置定时任务

- 4html网页制作之简单登入界面_html表格登录界面

- 5360浏览器安装JSON-Handle插件实现页面JSON数据格式化的操作方法_浏览器json格式化插件

- 6火狐浏览器安装插件步骤

- 7Unity 协程底层 简单解释_unity协程

- 82023最新AI创作系统ChatGPT网站源码+Midjourney绘画+支持GPT-4-Turbo模型+即将支持TSS语音对话功能模块_ai创作系统源码

- 95个免费练习黑客技术的网站!_ctf刷题网站

- 10python如何解决动态的定义变量名,并给其赋值(大数据处理)_pqfactor y定义状态机变量事件名字怎么弄

老男孩上海校区Python面试题_return dict1 [s]*math. log (a/b)

赞

踩

python面试题

第一章:python基础

数据类型:

1 字典:

1.1 现有字典 dict={‘a’:24,‘g’:52,‘i’:12,‘k’:33}请按字典中的 value 值进行排序?

1. sorted(dict.items(),key = lambda x:x[1])

- 1

1.2 说一下字典和json的区别?

1. 字典是一种数据结构,json是一种数据的表现形式,字典的key值只要是能hash的就行,json的必须是字符串

- 1

1.3 什么是可变、不可变类型?

1. 可变不可变指的是内存中的值是否可以被改变,不可变类型指的是对象所在内存块里面的值不可以改变,有数值、字符串、元组;可变类型则是可以改变,主要有列表、字典。

- 1

1.4 存入字典里的数据有没有先后排序?

1. 存入的数据不会自动排序,可以使用sort函数对字典进行排序。

- 1

1.5 字典推导式?

1. dict = {key: value for (key, value) in iterable}

- 1

1.6 现有字典 d={‘a’:24,’g’:52,’l’:12,’k’:33}请按字 典中的 value 值进行排序?

1. sorted(d.items(),key = lambda x:x[1])

- 1

2 字符串:

2.1 请反转字符串“aStr”?

1. . print(‘aStr’[::-1])

- 1

2.2 将字符串"k:1|k1:2|k2:3|k3:4",处理成Python字典:{k:1, k1:2, … } # 字 典里的K作为字符串处理

1. str1 = "k:1|k1:2|k2:3|k3:4"

2. def str2dict(str1):

3. dict1 = {}

4. for iterms in str1.split('|'):

5. key,value = iterms.split(':')

6. dict1[key] = value

7. return dict1

- 1

- 2

- 3

- 4

- 5

- 6

- 7

2.3 请按alist中元素的age由大到小排序

alist [{‘name’:‘a’,‘age’:20},{‘name’:‘b’,‘age’:30},{‘name’:‘c’,‘age’:25}]

1.def sort_by_age(list1):

2. return sorted(alist,key=lambda x:x['age'],reverse=True)

- 1

- 2

3 列表

3.1 下面代码的输出结果将是什么?

list = [‘a’, ‘b’, ‘c’, ‘d’, ‘e’]

print(list[10:])

1. 下面的代码将输出[],不会产生IndexError错误。就像所期望的那样,尝试用超出成员的个数的index

2. 来获取某个列表的成员。

3. 例如,尝试获取list[10]和之后的成员,会导致IndexError。

- 1

- 2

- 3

3.2 写一个列表生成式,产生一个公差为11的等差数列

1. 1print([x*11 for x in range(10)])

3``2`456.

- 1

- 2

3.3 给定两个列表,怎么找出他们相同的元素和不同的元素?

1. list1 = [1,2,3]

2. list2 = [3,4,5]

3. set1 = set(list1)

4. set2 = set(list2)

5. print(set1&set2)

6. print(set1^set2)

- 1

- 2

- 3

- 4

- 5

- 6

3.4 请写出一段Python代码实现删除一个list里面的重复元素?

比较容易记忆的是用内置的set:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = list(set(l1))

3. print(l2)

- 1

- 2

- 3

如果想要保持他们原来的排序:

用list类的sort方法:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = list(set(l1))

3. l2.sort(key=l1.index)

4. print(l2)

- 1

- 2

- 3

- 4

也可以这样写:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = sorted(set(l1),key=l1.index)

3. print(l2)

- 1

- 2

- 3

也可以用遍历:

1. l1 = ['b', 'c', 'd', 'b', 'c', 'a', 'a']

2. l2 = []

3. for i in l1:

4. if not i in l2:

5. l2.append(i)

6. print(l2)

- 1

- 2

- 3

- 4

- 5

- 6

3.5 给定两个list A ,B,请用找出 A ,B中相同的元素,A ,B中不同的元素

1. A、B 中相同元素:print(set(A)&set(B))

2. A、B 中不同元素:print(set(A)^set(B))

- 1

- 2

3.6 有如下数组list = range(10)我想取以下几个数组,应该如何切片?

1. [1,2,3,4,5,6,7,8,9]

2. [1,2,3,4,5,6]

3. [3,4,5,6]

4. [9]

5. [1,3,5,7,9]

6. 答: 1. [1:] 2. [1:7] 3. [3:7] 4. [-1] 5. [1::2]

- 1

- 2

- 3

- 4

- 5

- 6

3.7 下面这段代码的输出结果是什么?请解释?

1. def extendlist(val, list=[]):

2. list.append(val)

3. return list

4. list1 = extendlist(10)

5. list2 = extendlist(123, []

6. list3 = extendlist('a')

7. print("list1 = %s" %list1)

8. print("list2 = %s" %list2)

9. print("list3 = %s" %list3)

10. 输出结果:

11. list1 = [10, 'a']

12. list2 = [123]

13. list3 = [10, 'a']

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

新的默认列表只在函数被定义的那一刻创建一次。当extendList被没有指定特定参数list调用时,这组list的值

随后将被使用。这是因为带有默认参数的表达式在函数被定义的时候被计算,不是在调用的时候被计算。

3.8 将以下3 个函数按照执行效率高低排序

1. def f1(lIn):

2. l1 = sorted(lIn)

3. l2 = [i for i in l1 if i<0.5]

4. return [i*i for i in l2]

5. def f2(lIn):

6. l1 = [i for i in l1 if i<0.5]

7. l2 = sorted(l1)

8. return [i*i for i in l2]

9. def f3(lIn):

10. l1 = [i*i for i in lIn]

11. l2 = sorted(l1)

12. return [i for i in l1 if i<(0.5*0.5)]

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

按执行效率从高到低排列:f2、f1和f3。

要证明这个答案是正确的,你应该知道如何分析自己代码的性能。

Python中有一个很好的程序分析包,可以满足这个需求。

1. import random

2. import cProfile

3. lIn = [random.random() for i in range(100000)]

4. cProfile.run('f1(lIn)')

5. cProfile.run('f2(lIn)')

6. cProfile.run('f3(lIn)')

- 1

- 2

- 3

- 4

- 5

- 6

3.9 获取1~100被7整除的偶数?

1. def A():

2. alist = []

3. for i in range(1,100):

4. if i % 7 == 0:

5. alist.append(i)

6. last_num = alist[-3:]

7. print(last_num)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

4. 元组

1. tuple:元组,元组将多样的对象集合到一起,不能修改,通过索引进行查找,使用括号”()”;

2. 应用场景:把一些数据当做一个整体去使用,不能修改;

- 1

- 2

5. 集合

1. set:set集合,在Python中的书写方式为{},集合与之前列表、元组类似,可以存储多个数据,但

2. 是这些数据是不重复的。集合对象还支持union(联合), intersection(交), difference(差)和

3. sysmmetric_difference(对称差集)等数学运算.

- 1

- 2

- 3

快速去除列表中的重复元素

1. In [4]: a = [11,22,33,33,44,22,55]

2. In [5]: set(a)

3. Out[5]: {11, 22, 33, 44, 55}

- 1

- 2

- 3

交集:共有的部分

1. In [7]: a = {71,72,73,74,75}

2. In [8]: b = {72,74,75,76,77}

3. In [9]: a&b

4. Out[9]: {72, 74, 75}

- 1

- 2

- 3

- 4

并集:总共的部分

1. In [11]: a = {21,22,23,24,25}

2. In [12]: b = {22,24,25,26,27}

3. In [13]: a | b

4. Out[13]: {21, 22, 23, 24, 25, 26, 27}

- 1

- 2

- 3

- 4

差集:另一个集合中没有的部分

1. In [15]: a = {51,52,53,54,55}

2. In [16]: b = {52,54,55,56,57}

3. In [17]: b - a

4. Out[17]: {66, 77}

- 1

- 2

- 3

- 4

对称差集(在a或b中,但不会同时出现在二者中)

1. In [19]: a = {91,92,93,94,95}

2. In [20]: b = {92,94,95,96,97}

3. In [21]: a ^ b

4. Out[21]: {11, 33, 66, 77}

- 1

- 2

- 3

- 4

6.综合

1.通过代码实现如下转换

二进制转换成十进制:v = “0b1111011”

十进制转换成二进制:v = 18

八进制转换成十进制:v = “011”

十进制转换成八进制:v = 30

十六进制转换成十进制:v = “0x12”

十进制转换成十六进制:v = 87

print(int(v1,2))

print(int(v2,16))

print(int(v3,8))

print(bin(a1))

print(oct(a2))

print(hex(a3))

- 1

- 2

- 3

- 4

- 5

- 6

2. 求结果:

v1 = 1 or 3

v2 = 1 and 3

v3 = 0 and 2 and 1

v4 = 0 and 2 or 1

v5 = 0 and 2 or 1 or 4

v6 = 0 or Flase and 1

v1 = 1 or 3

v2 = 1 and 3

v3 = 0 and 2 and 1

v4 = 0 and 2 or 1

v5 = 0 and 2 or 1 or 4

v6 = 0 or False and 1

>>>1 3 0 1 1 False

- 1

- 2

- 3

- 4

- 5

- 6

- 7

3. python2与python3的区别

# py2 >>> print("hello", "world") ('hello', 'world') # py3 >>> print("hello", "world") hello world py2:input_raw() py3:input() 1/2的结果 py2:返回0 py3:返回0.5 py2:默认编码ascii py3:默认编码utf-8 字符串 py2:unicode类型表示字符串序列,str类型表示字节序列 py3::str类型表示字符串序列,byte类型表示字节序列

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

4. 用一行代码实现数值交换

a = 1

b = 2

a,b=(2,1)

- 1

5. xrange和range的区别?

xrange 用法与 range 完全相同,所不同的是生成的不是一个list对象,而是一个生成器。

注意:现在的python3中将以前的range取消了,而将xrange重新命名成了range!所以我们现在看到的range其实本质还是xrange~。

- 1

- 2

6. lambda表达式格式以及应用场景?

匿名就是没有名字

def func(x,y,z=1):

return x+y+z

匿名

lambda x,y,z=1:x+y+z #与函数有相同的作用域,但是匿名意味着引用计数为0,使用一次就释放,除非让其有名字

func=lambda x,y,z=1:x+y+z

func(1,2,3)

#让其有名字就没有意义

与内置函数配合一起使用

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

8. *arg和**kwarg作用

*args用来接收溢出的位置参数,将接收的参数组织成元祖

**kwargs用来接收溢出的关键字参数,将接受的参数组织成字典

- 1

- 2

9. 求结果

v = dict.fromkeys([‘k1’,‘k2’],[])

v[‘k1’].append(666)

print(v)

v[‘k1’] = 777

print(v)

v = dict.fromkeys(['k1','k2'],[])

v['k1'].append(666)

print(v) #{'k1': [666], 'k2': [666]}

v['k1'] = 777

print(v)#{'k1': 777, 'k2': [666]}

#第一次字典的两个k指向的是同一块内存地址,所以k1的内存地址追加666,

k2的值也同样会是666,

而当给k1赋值时,改变了k1指向的内存地址,所以这个时候,k2不会随之发生变化

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

10. 一行代码实现9*9乘法表

print("\n".join("\t".join(["%s*%s=%s" %(x,y,x*y) for y in range(1, x+1)])

- 1

11. 比较 a = [1,2,3] 和 b = [(1),(2),(3) ] 以及 b = [(1,),(2,),(3,) ] 的区别?

a与b两者值相等,而c中列表的每个元素是一个个的元祖形式

a,b元素均为数字,b中括号内没加逗号,所以仍然是数字

- 1

- 2

Python高级

一.元类

1.Python中类方法、类实例方法、静态方法有何区别?

类方法:是类对象的方法,在定义时需要在上方使用“@classmethod”进行装饰,形参为 cls,

表示类对象,类对象和实例对象都可调用;

类实例方法:是类实例化对象的方法,只有实例对象可以调用,形参为self,指代对象本身;

静态方法:是一个任意函数,在其上方使用“@staticmethod”进行装饰,可以用对象直接调用,

静态方法实际上跟该类没有太大关系。

- 1

- 2

- 3

- 4

- 5

2.Python中如何动态获取和设置对象的属性?

1. if hasattr(Parent,'x'):

2. print(getattr(Parent,'x'))

3. setattr(Parent,'x',29)

4. print(getattr(Parent,'x'))

- 1

- 2

- 3

- 4

二.内存管理与垃圾回收机制

1 . Python的内存管理机制及调优手段?

1. 内存管理机制:引用计数、垃圾回收、内存池。

- 1

引用计数:

1. 引用计数是一种非常高效的内存管理手段, 当一个 Python 对象被引用时其引用计数增加

2. 1, 当其不再被一个变量引用时则计数减 1. 当引用计数等于0时对象被删除。.

- 1

- 2

垃圾回收 :

- 引用计数

1. 引用计数也是一种垃圾收集机制,而且也是一种最直观,最简单的垃圾收集技术。当 Python 的某

2. 个对象的引用计数降为 0 时,说明没有任何引用指向该对象,该对象就成为要被回收的垃圾了。比如

3. 某个新建对象,它被分配给某个引用,对象的引用计数变为 1。如果引用被删除,对象的引用计数为 0,

4. 那么该对象就可以被垃圾回收。不过如果出现循环引用的话,引用计数机制就不再起有效的作用了

- 1

- 2

- 3

- 4

- 标记清除

如果两个对象的引用计数都为 1,但是仅仅存在他们之间的循环引用,那么这两个对象都是需要被

回收的,也就是说,它们的引用计数虽然表现为非 0,但实际上有效的引用计数为 0。所以先将循环引

用摘掉,就会得出这两个对象的有效计数。

- 1

- 2

- 3

- 分代回收

1. 从前面“标记-清除”这样的垃圾收集机制来看,这种垃圾收集机制所带来的额外操作实际上与系统

2. 中总的内存块的数量是相关的,当需要回收的内存块越多时,垃圾检测带来的额外操作就越多,而垃圾

3. 回收带来的额外操作就越少;反之,当需回收的内存块越少时,垃圾检测就将比垃圾回收带来更少的额

4. 外操作。

- 1

- 2

- 3

- 4

举个例子:

当某些内存块 M 经过了 3 次垃圾收集的清洗之后还存活时,我们就将内存块 M 划到一个集合

A 中去,而新分配的内存都划分到集合 B 中去。当垃圾收集开始工作时,大多数情况都只对集合 B 进

行垃圾回收,而对集合 A 进行垃圾回收要隔相当长一段时间后才进行,这就使得垃圾收集机制需要处

理的内存少了,效率自然就提高了。在这个过程中,集合 B 中的某些内存块由于存活时间长而会被转

移到集合 A 中,当然,集合 A 中实际上也存在一些垃圾,这些垃圾的回收会因为这种分代的机制而被延迟。

- 1

- 2

- 3

- 4

- 5

内存池:

1. Python 的内存机制呈现金字塔形状,-1,-2 层主要有操作系统进行操作;

2. 第 0 层是 C 中的 malloc,free 等内存分配和释放函数进行操作;

3. 第1 层和第 2 层是内存池,有 Python 的接口函数 PyMem_Malloc 函数实现,当对象小于256K 时有该层直接分配内存;

4. 第3层是最上层,也就是我们对 Python 对象的直接操作;

- 1

- 2

- 3

- 4

Python 在运行期间会大量地执行 malloc 和 free 的操作,频繁地在用户态和核心态之间进行切

换,这将严重影响 Python 的执行效率。为了加速Python 的执行效率,Python 引入了一个内存池

机制,用于管理对小块内存的申请和释放。

Python 内部默认的小块内存与大块内存的分界点定在 256 个字节,当申请的内存小于 256 字节

时,PyObject_Malloc会在内存池中申请内存;当申请的内存大于 256 字节时,PyObject_Malloc 的

行为将蜕化为 malloc 的行为。当然,通过修改 Python 源代码,我们可以改变这个默认值,从而改

变 Python 的默认内存管理行为。

调优手段(了解)

1.手动垃圾回收

2.调高垃圾回收阈值

3.避免循环引用(手动解循环引用和使用弱引用)

2.内存泄露是什么?如何避免?

指由于疏忽或错误造成程序未能释放已经不再使用的内存的情况。内存泄漏并非指内存在物理上的

消失,而是应用程序分配某段内存后,由于设计错误,失去了对该段内存的控制,因而造成了内存的浪

费。导致程序运行速度减慢甚至系统崩溃等严重后果。

有 __del__() 函数的对象间的循环引用是导致内存泄漏的主凶。

不使用一个对象时使用:del object 来删除一个对象的引用计数就可以有效防止内存泄漏问题。

通过Python 扩展模块 gc 来查看不能回收的对象的详细信息。

可以通过 sys.getrefcount(obj) 来获取对象的引用计数,并根据返回值是否为 0 来判断是否内存

泄漏。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

三.函数

1.0 谈谈你对闭包的理解?

闭包(closure)是函数式编程的重要的语法结构。闭包也是一种组织代码的结构,它同样提高了代码的可重复使用性。

当一个内嵌函数引用其外部作作用域的变量,我们就会得到一个闭包. 总结一下,创建一个闭包必须满足以下几点:

必须有一个内嵌函数

内嵌函数必须引用外部函数中的变量

外部函数的返回值必须是内嵌函数

感觉闭包还是有难度的,几句话是说不明白的,还是查查相关资料.

重点是函数运行后并不会被撤销,就像16题的instance字典一样,当函数运行完后,instance并不被销毁,而是继续留在内存空间里.这个功能类似类里的类变量,只不过迁移到了函数上.

闭包就像个空心球一样,你知道外面和里面,但你不知道中间是什么样.

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

1.1 Python函数调用的时候参数的传递方式是值传递还是引用传递?

Python的参数传递有:位置参数、默认参数、可变参数、关键字参数。

函数的传值到底是值传递还是引用传递,要分情况:

- 1

- 2

不可变参数用值传递:

像整数和字符串这样的不可变对象,是通过拷贝进行传递的,因为你无论如何都不可能在原处改变

- 1

不可变对象

可变参数是引用传递的:

比如像列表,字典这样的对象是通过引用传递、和C语言里面的用指针传递数组很相似,可变对象

能在函数内部改变。

- 1

- 2

- 3

1.2对缺省参数的理解 ?

缺省参数指在调用函数的时候没有传入参数的情况下,调用默认的参数,在调用函数的同时赋值时,

所传入的参数会替代默认参数。

*args 是不定长参数,他可以表示输入参数是不确定的,可以是任意多个。

**kwargs 是关键字参数,赋值的时候是以键 = 值的方式,参数是可以任意多对在定义函数的时候

不确定会有多少参数会传入时,就可以使用两个参数。

- 1

- 2

- 3

- 4

- 5

1.3为什么函数名字可以当做参数用?

Python中一切皆对象,函数名是函数在内存中的空间,也是一个对象。

- 1

1.4 Python中pass语句的作用是什么?

在编写代码时只写框架思路,具体实现还未编写就可以用 pass 进行占位,使程序不报错,不会进

行任何操作。

- 1

- 2

1.5有这样一段代码,print c会输出什么,为什么?

a = 10

b = 20

c = [a]

a = 15

答:10对于字符串、数字,传递是相应的值。

- 1

- 2

- 3

- 4

- 5

2. 内置函数

2.1 map函数和reduce函数?

①从参数方面来讲:

map()包含两个参数,第一个参数是一个函数,第二个是序列(列表 或元组)。其中,函数(即 map

的第一个参数位置的函数)可以接收一个或多个参数。

reduce()第一个参数是函数,第二个是序列(列表或元组)。但是,其函数必须接收两个参数。

②从对传进去的数值作用来讲:

map()是将传入的函数依次作用到序列的每个元素,每个元素都是独自被函数“作用”一次 。

reduce()是将传人的函数作用在序列的第一个元素得到结果后,把这个结果继续与下一个元素作用

(累积计算)。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

2.2递归函数停止的条件?

递归的终止条件一般定义在递归函数内部,在递归调用前要做一个条件判断,根据判断的结果选择

是继续调用自身,还是 return;返回终止递归。

终止的条件:

1.判断递归的次数是否达到某一限定值

2.判断运算的结果是否达到某个范围等,根据设计的目的来选择

- 1

- 2

- 3

- 4

- 5

2.3 回调函数,如何通信的?

回调函数是把函数的地址作为参数传递给另一个函数,将整个函数当作一个对象,赋值给调用的函

数。

- 1

- 2

2.4 Python主要的内置数据类型都有哪些? print dir( ‘a ’) 的输出?

内建类型:布尔类型、数字、字符串、列表、元组、字典、集合;

输出字符串‘a’的内建方法;

- 1

- 2

2.5 print(list(map(lambda x: x * x, [y for y in range(3)])))的输出?

1. [0, 1, 4]

- 1

2.6 hasattr() getattr() setattr() 函数使用详解?

hasattr(object, name)函数:

判断一个对象里面是否有name属性或者name方法,返回bool值,有name属性(方法)返回True,

否则返回False。

注意:name要使用引号括起来。

1. class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5. functiondemo = function_demo()

6. res = hasattr(functiondemo, 'name') #判断对象是否有name 属性,True

7. res = hasattr(functiondemo, "run") #判断对象是否有run方法,True

8. res = hasattr(functiondemo, "age") #判断对象是否有age属性,Falsw

9. print(res)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

getattr(object, name[,default]) 函数:

获取对象object的属性或者方法,如果存在则打印出来,如果不存在,打印默认值,默认值可选。

注意:如果返回的是对象的方法,则打印结果是:方法的内存地址,如果需要运行这个方法,可以在后

面添加括号()。

1. functiondemo = function_demo()

2. getattr(functiondemo, 'name') #获取name属性,存在就打印出来--- demo

3. getattr(functiondemo, "run") #获取run方法,存在打印出 方法的内存地址---<bound method function_demo.run of <__main__.function_demo object at 0x10244f320>>

4. getattr(functiondemo, "age") #获取不存在的属性,报错如下:

5. Traceback (most recent call last):

6. File "/Users/liuhuiling/Desktop/MT_code/OpAPIDemo/conf/OPCommUtil.py", line 39, in <module>

7. res = getattr(functiondemo, "age")

8. AttributeError: 'function_demo' object has no attribute 'age'

9. getattr(functiondemo, "age", 18) #获取不存在的属性,返回一个默认值

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

setattr(object,name,values)函数:

给对象的属性赋值,若属性不存在,先创建再赋值

1.class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5.functiondemo = function_demo()

6.res = hasattr(functiondemo, 'age') # 判断age属性是否存在,False

7.print(res)

8.setattr(functiondemo, 'age', 18 ) #对age属性进行赋值,无返回值

9.res1 = hasattr(functiondemo, 'age') #再次判断属性是否存在,True

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

综合使用:

1.class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5.functiondemo = function_demo()

6.res = hasattr(functiondemo, 'addr') # 先判断是否存在if res:

7. addr = getattr(functiondemo, 'addr')

8. print(addr)else:

9. addr = getattr(functiondemo, 'addr', setattr(functiondemo, 'addr', '北京首都'))

10. #addr = getattr(functiondemo, 'addr', '美国纽约')

11. print(addr)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

reduce(lambda x,y: x*y, range(1,n+1)) 注意:Python3中取消了该函数。

Lambda

3.1什么是lambda函数? 有什么好处?

lambda 函数是一个可以接收任意多个参数(包括可选参数)并且返回单个表达式值的函数

1、lambda 函数比较轻便,即用即仍,很适合需要完成一项功能,但是此功能只在此一处使用,

连名字都很随意的情况下;

2、匿名函数,一般用来给 filter, map 这样的函数式编程服务;

3、作为回调函数,传递给某些应用,比如消息处理

- 1

- 2

- 3

- 4

- 5

3.2下面这段代码的输出结果将是什么?请解释。

def multipliers():

return [lambda x : i * x for i in range(4)]

print [m(2) for m in multipliers()]

- 1

- 2

- 3

上面代码输出的结果是[6, 6, 6, 6] (不是我们想的[0, 2, 4, 6])。

上述问题产生的原因是Python闭包的延迟绑定。这意味着内部函数被调用时,参数的值在闭包内

进行查找。因此,当任何由multipliers()返回的函数被调用时, i的值将在附近的范围进行查找。那时,

不管返回的函数是否被调用,for循环已经完成,i被赋予了最终的值3。

因此,每次返回的函数乘以传递过来的值3,因为上段代码传过来的值是2,它们最终返回的都是6。下面是解决这一问题的一些方法。

一种解决方法就是用Python生成器。

def multipliers():

for i in range(4): yield lambda x :

i * x

- 1

- 2

- 3

另外一个解决方案就是创造一个闭包,利用默认函数立即绑定。

def multipliers():

return [lambda x, i=i : i * x for i in range(4)]

- 1

- 2

3.3什么是lambda函数?它有什么好处?写一个匿名函数求两个数的和?

lambda 函数是匿名函数;使用 lambda 函数能创建小型匿名函数。这种函数得名于省略了用 def

声明函数的标准步骤;

f = lambda x,y:x+y

print(f(2017,2018))

- 1

- 2

- 3

- 4

四.设计模式

1. 单例

1.1请手写一个单例

class A(object):

__instance = None

def __new__(cls, *args, **kwargs):

if cls.__instance is None:

cls.__instance = object.__new__(cls)

return cls.__instance

else:

return cls.__instance

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

1.2单例模式的应用场景有哪些?

单例模式应用的场景一般发现在以下条件下:

(1)资源共享的情况下,避免由于资源操作时导致的性能或损耗等。如日志文件,应用配置。

(2)控制资源的情况下,方便资源之间的互相通信。如线程池等。 1.网站的计数器 2.应用配置 3.多线程池 4.

数据库配置,数据库连接池 5.应用程序的日志应用....

- 1

- 2

- 3

2. 工厂

3. 装饰器

3.1对装饰器的理解 ,并写出一个计时器记录方法执行性能的装饰器?

装饰器本质上是一个 Python 函数,它可以让其他函数在不需要做任何代码变动的前提下增加额外

功能,装饰器的返回值也是一个函数对象。

import time

def timeit(func):

def wrapper():

start = time.clock()

func() end =time.clock()

print 'used:', end - start

return wrapper

@timeit

def foo():

print 'in foo()'foo()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

3.2解释一下什么是闭包?

在函数内部再定义一个函数,并且这个函数用到了外边函数的变量,那么将这个函数以及用到的一些变量称之为

闭包。

- 1

- 2

3.3函数装饰器有什么作用?

装饰器本质上是一个Python函数,它可以在让其他函数在不需要做任何代码的变动的前提下增加额外的功能。 装

饰器的返回值也是一个函数的对象,它经常用于有切面需求的场景。 比如:插入日志、性能测试、事务处理、缓存、

权限的校验等场景 有了装饰器就可以抽离出大量的与函数功能本身无关的雷同代码并发并继续使用。

- 1

- 2

- 3

4. 生成器

4.1生成器、迭代器的区别?

迭代器是一个更抽象的概念,任何对象,如果它的类有next方法和iter方法返回自己本身,对于string、list、

dict、tuple等这类容器对象,使用for循环遍历是很方便的。在后台for语句对容器对象调用iter()函数,iter()

是python的内置函数。iter()会返回一个定义了next()方法的迭代器对象,它在容器中逐个访问容器内元素,next()

也是python的内置函数。在没有后续元素时,next()会抛出一个StopIteration异常。

生成器(Generator)是创建迭代器的简单而强大的工具。它们写起来就像是正规的函数,只是在需要返回数

据的时候使用 yield 语句。每次 next()被调用时,生成器会返回它脱离的位置(它记忆语句最后一次执行的位置

和所有的数据值)

区别:生成器能做到迭代器能做的所有事,而且因为自动创建了iter()和 next()方法,生成器显得特别简洁,而且

生成器也是高效的,使用生成器表达式取代列表解析可以同时节省内存。除了创建和保存程序状态的自动方法,当

发生器终结时,还会自动抛出 StopIteration 异常。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

4.2 X是什么类型?

X = (for i in ramg(10))

答:X是generator 类型。

- 1

- 2

4.3请尝试用“一行代码”实现将1-N 的整数列表以 3为单位分组,比如 1-100 分组后为?

print([[x for x in range(1,100)][i:i+3] for i in range(0,len(list_a),3)])

- 1

4.4Python中yield的用法?

yield 就是保存当前程序执行状态。你用 for 循环的时候,每次取一个元素的时候就会计算一次。用 yield 的函数

叫generator,和 iterator一样,它的好处是不用一次计算所有元素,而是用一次算一次,可以节省很多空间。generator

每次计算需要上一次计算结果,所以用yield,否则一return,上次计算结果就没了。

def createGenerator():

mylist = range(3)

for i in mylist:

yield i*i

mygenerator = createGenerator() # create a generator

print(mygenerator) # mygenerator is an object!

<generator object createGenerator at 0xb7555c34>

for i in mygenerator:

print(i)

# 输出结果: 0 1 4

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

5.试题

1 一行代码实现1–100之和

sum(range(0, 101))

- 1

2 如何在一个函数内部修改全局变量

利用global 修改全局变量

a = 20

def foo():

global a

a = 47

foo()

print(a) # 4

- 1

- 2

- 3

- 4

- 5

- 6

3 列出5个python标准库

os:提供了不少与操作系统相关联的函数

sys: 通常用于命令行参数

re: 正则匹配

math: 数学运算

datetime:处理日期时间

4 字典如何删除键和合并两个字典

del和update方法

dic = {'name': 'kermit', 'age': 18}

del dic['name'] # 删除键

print(dic) # {'age': 18}

dic2 = {'name': 'jack'}

dic.update(dic2)

print(dic) # {'age': 18, 'name': 'jack'}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

5、谈下python的GIL

GIL 是python的全局解释器锁,同一进程中假如有多个线程运行,一个线程在运行python程序的时候会霸占python解释器(加了一把锁即GIL),

使该进程内的其他线程无法运行,等该线程运行完后其他线程才能运行。如果线程运行过程中遇到耗时操作,则解释器锁解开,使其他线程运行。

所以在多线程中,线程的运行仍是有先后顺序的,并不是同时进行。

多进程中因为每个进程都能被系统分配资源,相当于每个进程有了一个python解释器,所以多进程可以实现多个进程的同时运行,缺点是进程系统

资源开销大

- 1

- 2

- 3

- 4

- 5

五.面向对象

1. 类

2. 对象

2.1 Python中的可变对象和不可变对象?

不可变对象,该对象所指向的内存中的值不能被改变。当改变某个变量时候,由于其所指的值不能被改变,相当

于把原来的值复制一份后再改变,这会开辟一个新的地址,变量再指向这个新的地址。

可变对象,该对象所指向的内存中的值可以被改变。变量(准确的说是引用)改变后,实际上是其所指的值直接

发生改变,并没有发生复制行为,也没有开辟新的出地址,通俗点说就是原地改变。

Python中,数值类型(int和float)、字符串str、元组tuple都是不可变类型。而列表list、字典dict、集合

set是可变类型。

- 1

- 2

- 3

- 4

- 5

- 6

2.2 Python中is和==的区别?

is判断的是a对象是否就是b对象,是通过id来判断的。

==判断的是a对象的值是否和b对象的值相等,是通过value来判断的。

- 1

- 2

- 3

2.3 Python的魔法方法

魔法方法就是可以给你的类增加魔力的特殊方法,如果你的对象实现 (重载)了这些方法中的某一个,那么这个

方法就会在特殊的情况下被 Python 所调用,你可以定义自己想要的行为,而这一切都是自动发生的。 它们经常是

两个下划线包围来命名的(比如 init,lt),Python 的魔法方法是非常强大的,所以了解其使用方法也变得

尤为重要!

__init__ 构造器,当一个实例被创建的时候初始化的方法。但是它并 不是实例化调用的第一个方法。

__new__才是实例化对象调用的第一个方法,它只取下 cls 参数,并把 其他参数传给 __init__。 __new__很少使

用,但是也有它适合的场景,尤其 是当类继承自一个像元组或者字符串这样不经常改变的类型的时候。

__call__ 允许一个类的实例像函数一样被调用 。

__getitem__ 定义获取容器中指定元素的行为,相当于 self[key] 。

__getattr__ 定义当用户试图访问一个不存在属性的时候的行为 。

__setattr__ 定义当一个属性被设置的时候的行为 。

__getattribute__ 定义当一个属性被访问的时候的行为 。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

2.4面向对象中怎么实现只读属性?

将对象私有化,通过共有方法提供一个读取数据的接口。

class person:

def __init__(self,x):

self.__age = 10;

def age(self):

return self.__age;

t = person(22)

# t.__age = 100

print(t.age())

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

最好的方法

class MyCls(object): __weight = 50 @property #以访问属性的方式来访问weight方法 def weight(self): return self.__weight if __name__ == '__main__': obj = MyCls() print(obj.weight) obj.weight = 12 # 报错信息 Traceback (most recent call last): 50 File "C:/PythonTest/test.py", line 11, in <module> obj.weight = 12 AttributeError: can't set attribute

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

2.5谈谈你对面向对象的理解?

面向对象是相对于面向过程而言的。面向过程语言是一种基于功能分析的、以算法为中心的程序设计方法;而面

向对象是一种基于结构分析的、以数据为中心的程序设计思想。在面向对象语言中有一个有很重要东西,叫做类。

面向对象有三大特性:封装、继承、多态。

- 1

- 2

- 3

六.正则表达式

1. Python里match与search的区别?

match()函数只检测RE是不是在string的开始位置匹配,

search()会扫描整个string查找匹配;

也就是说match()只有在0位置匹配成功的话才有返回,

如果不是开始位置匹配成功的话,match()就返回none。

- 1

- 2

- 3

- 4

2. Python字符串查找和替换?

re.findall(r’目的字符串’,’原有字符串’) #查询

re.findall(r'cast','itcast.cn')[0]

re.sub(r‘要替换原字符’,’要替换新字符’,’原始字符串’)

re.sub(r'cast','heima','itcast.cn')

- 1

- 2

- 3

- 4

3.用Python匹配HTML tag的时候,<.> 和 <.?> 有什么区别?

<.*>是贪婪匹配,会从第一个“<”开始匹配,直到最后一个“>”中间所有的字符都会匹配到,中间可能会包含

“<>”。

<.*?>是非贪婪匹配,从第一个“<”开始往后,遇到第一个“>”结束匹配,这中间的字符串都会匹配到,但是

不会有“<>”。

- 1

- 2

- 3

- 4

七.系统编程

进程总结

进程:程序运行在操作系统上的一个实例,就称之为进程。进程需要相应的系统资源:内存、时间

片、pid。

创建进程:

1.首先要导入multiprocessing中的Process;

2.创建一个Process对象;

3.创建Process对象时,可以传递参数;

1.p = Process(target=XXX, args=(元组,) , kwargs={key:value}) 2.target = XXX 指定的任务函数,不用加() 3.args=(元组,) , kwargs={key:value} 给任务函数传递的参数 4.使用start()启动进程;

5.结束进程。

- 1

- 2

- 3

- 4

- 5

Process语法结构:

Process([group [, target [, name [, args [, kwargs]]]]])

target:如果传递了函数的引用,可以让这个子进程就执行函数中的代码

args:给target指定的函数传递的参数,以元组的形式进行传递

kwargs:给target指定的函数传递参数,以字典的形式进行传递

name:给进程设定一个名字,可以省略

group:指定进程组,大多数情况下用不到

Process创建的实例对象的常用方法有:

start():启动子进程实例(创建子进程)

is_alive():判断进程子进程是否还在活着

join(timeout):是否等待子进程执行结束,或者等待多少秒

terminate():不管任务是否完成,立即终止子进程

Process创建的实例对象的常用属性:

name:当前进程的别名,默认为Process-N,N为从1开始递增的整数

pid:当前进程的pid(进程号)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

给子进程指定函数传递参数Demo:

import osfrom multiprocessing import Process import time def pro_func(name, age, **kwargs): for i in range(5): print("子进程正在运行中,name=%s, age=%d, pid=%d" %(name, age, os.getpid())) print(kwargs) time.sleep(0.2) if __name__ == '__main__': # 创建Process对象 p = Process(target=pro_func, args=('小明',18), kwargs={'m': 20}) # 启动进程 p.start() time.sleep(1) # 1秒钟之后,立刻结束子进程 17. p.terminate() p.join() 注意:进程间不共享全局变量。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

进程之间的通信-Queue

在初始化Queue()对象时,(例如q=Queue(),若在括号中没有指定最大可接受的消息数量,或数

量为负值时,那么就代表可接受的消息数量没有上限-直到内存的尽头)

Queue.qsize():返回当前队列包含的消息数量。

Queue.empty():如果队列为空,返回True,反之False。

Queue.full():如果队列满了,返回True,反之False。

Queue.get([block[,timeout]]):获取队列中的一条消息,然后将其从队列中移除,block默认值为True。

如果block使用默认值,且没有设置timeout(单位秒),消息列队如果为空,此时程序将被阻塞

(停在读取状态),直到从消息列队读到消息为止,如果设置了timeout,则会等待timeout秒,若还没读取到任何消息,则抛出"Queue.Empty"异常;

如果block值为False,消息列队如果为空,则会立刻抛出"Queue.Empty"异常;

Queue.get_nowait():相当Queue.get(False);

Queue.put(item,[block[, timeout]]):将item消息写入队列,block默认值为True;

如果block使用默认值,且没有设置timeout(单位秒),消息列队如果已经没有空间可写入,此时程序将被阻塞(停在写入状态),直到从消息列队腾出空间为止,如果设置了timeout,则会等待

timeout秒,若还没空间,则抛出"Queue.Full"异常;

如果block值为False,消息列队如果没有空间可写入,则会立刻抛出"Queue.Full"异常; Queue.put_nowait(item):相当Queue.put(item, False);

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

进程间通信Demo:

from multiprocessing import Process, Queueimport os, time, random # 写数据进程执行的代码:def write(q):

for value in ['A', 'B', 'C']:

print('Put %s to queue...' % value)

q.put(value)

time.sleep(random.random())

- 1

- 2

- 3

- 4

- 5

读数据进程执行的代码:def read(q):

while True: if not q.empty(): value = q.get(True) print('Get %s from queue.' % value) time.sleep(random.random()) else: break if __name__=='__main__': # 父进程创建Queue,并传给各个子进程: q = Queue() pw = Process(target=write, args=(q,)) pr = Process(target=read, args=(q,)) # 启动子进程pw,写入: pw.start() # 等待pw结束: pw.join() # 启动子进程pr,读取: pr.start() pr.join() # pr进程里是死循环,无法等待其结束,只能强行终止: print('') print('所有数据都写入并且读完') 进程池Pool

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

from multiprocessing import Poolimport os, time, random

def worker(msg):

t_start = time.time()

print("%s开始执行,进程号为%d" % (msg,os.getpid()))

# random.random()随机生成0~1之间的浮点数 7. time.sleep(random.random()*2)

t_stop = time.time()

print(msg,"执行完毕,耗时%0.2f" % (t_stop-t_start))

po = Pool(3) # 定义一个进程池,最大进程数3

for i in range(0,10): 13. # Pool().apply_async(要调用的目标,(传递给目标的参数元祖,))

# 每次循环将会用空闲出来的子进程去调用目标 po.apply_async(worker,(i,))

print("----start----")

po.close() # 关闭进程池,关闭后po不再接收新的请求 po.join() # 等待po中所有子进程执行完成,必须放在close 语句之后 print("-----end-----")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

multiprocessing.Pool 常用函数解析:

apply_async(func[, args[, kwds]]):使用非阻塞方式调用func(并行执行,堵塞方式必须等待上一个进程退出才能执行下一个进程),args为传递给func的参数列表,kwds为传递给func的关键字参数列表;

close():关闭Pool,使其不再接受新的任务;

terminate():不管任务是否完成,立即终止;

join():主进程阻塞,等待子进程的退出, 必须在close或terminate之后使用;

进程池中使用Queue

如果要使用Pool创建进程,就需要使用multiprocessing.Manager()中的 Queue(),而不是

multiprocessing.Queue(),否则会得到一条如下的错误信息:

RuntimeError: Queue objects should only be shared between processes through inheritance. from multiprocessing import Manager,Poolimport os,time,random def reader(q): print("reader启动(%s),父进程为(%s)" % (os.getpid(), os.getppid())) for i in range(q.qsize()): print("reader从Queue获取到消息:%s" % q.get(True)) def writer(q): print("writer启动(%s),父进程为(%s)" % (os.getpid(), os.getppid())) for i in "itcast": q.put(i) if __name__=="__main__": print("(%s) start" % os.getpid()) q = Manager().Queue() # 使用Manager中的Queue po = Pool() po.apply_async(writer, (q,)) time.sleep(1) # 先让上面的任务向Queue存入数据,然后再让下面的任务开始从中取数据 po.apply_async(reader, (q,)) po.close() po.join() print("(%s) End" % os.getpid())

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

谈谈你对多进程,多线程,以及协程的理解,项目是否用?

这个问题被问的概率相当之大,其实多线程,多进程,在实际开发中用到的很少,除非是那些对项目性能要求特别高的,有的开发工作几年了,也确实没用过,你可以这么回答,给他扯扯什么是进程,线程(cpython中是伪多线程)的概念就行,实在不行你就说你之前写过下载文件时,用过多线程技术,或者业余时间用过多线程写爬虫,提升效率。

进程:一个运行的程序(代码)就是一个进程,没有运行的代码叫程序,进程是系统资源分配的最

小单位,进程拥有自己独立的内存空间,所以进程间数据不共享,开销大。

线程: 调度执行的最小单位,也叫执行路径,不能独立存在,依赖进程存在一个进程至少有一个线程,叫主线程,而多个线程共享内存(数据共享,共享全局变量),从而极大地提高了程序的运行效率。

协程:是一种用户态的轻量级线程,协程的调度完全由用户控制。协程拥有自己的寄存器上下文和栈。

协程调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存

器上下文和栈,直接操作栈则基本没有内核切换的开销,可以不加锁的访问全局变量,所以上下文的切

换非常快。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

什么是多线程竞争?

线程是非独立的,同一个进程里线程是数据共享的,当各个线程访问数据资源时会出现竞争状态即:

数据几乎同步会被多个线程占用,造成数据混乱 ,即所谓的线程不安全

那么怎么解决多线程竞争问题?-- 锁。

锁的好处:

确保了某段关键代码(共享数据资源)只能由一个线程从头到尾完整地执行能解决多线程资源竞争下

的原子操作问题。

锁的坏处:

阻止了多线程并发执行,包含锁的某段代码实际上只能以单线程模式执行,效率就大大地下降了

锁的致命问题:死锁。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

解释一下什么是锁,有哪几种锁?

锁(Lock)是 Python 提供的对线程控制的对象。有互斥锁、可重入锁。

- 1

什么是死锁呢?

若干子线程在系统资源竞争时,都在等待对方对某部分资源解除占用状态,结果是谁也不愿先解锁,互相干等着,程序无法执行下去,这就是死锁。

GIL锁(有时候,面试官不问,你自己要主动说,增加b格,尽量别一问一答的尬聊,不然最后等到的一句话就是:你还有什么想问的么?)

GIL锁 全局解释器锁(只在cpython里才有)

作用:限制多线程同时执行,保证同一时间只有一个线程执行,所以cpython里的多线程其实是伪多线程!

所以Python里常常使用协程技术来代替多线程,协程是一种更轻量级的线程,

进程和线程的切换时由系统决定,而协程由我们程序员自己决定,而模块gevent下切换是遇到了耗时操作才会切换。

三者的关系:进程里有线程,线程里有协程。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

什么是线程安全,什么是互斥锁?

每个对象都对应于一个可称为" 互斥锁"的标记,这个标记用来保证在任一时刻,只能有一个线程访问该对象。

同一个进程中的多线程之间是共享系统资源的,多个线程同时对一个对象进行操作,一个线程操作尚未结束,

另一个线程已经对其进行操作,导致最终结果出现错误,此时需要对被操作对象添加互斥锁,保证每个线程对该对象的操作都得到正确的结果。

- 1

- 2

- 3

说说下面几个概念:同步,异步,阻塞,非阻塞?

同步:多个任务之间有先后顺序执行,一个执行完下个才能执行。

异步:多个任务之间没有先后顺序,可以同时执行有时候一个任务可能要在必要的时候获取另一个同时执行的任务的结果,这个就叫回调!

阻塞:如果卡住了调用者,调用者不能继续往下执行,就是说调用者阻塞了。

非阻塞:如果不会卡住,可以继续执行,就是说非阻塞的。

同步异步相对于多任务而言,阻塞非阻塞相对于代码执行而言。

- 1

- 2

- 3

- 4

- 5

什么是僵尸进程和孤儿进程?怎么避免僵尸进程?

孤儿进程:父进程退出,子进程还在运行的这些子进程都是孤儿进程,孤儿进程将被 init 进程(进程号为 1)所收养,并由init进程对它们完成状态收集工作。

僵尸进程:进程使用fork创建子进程,如果子进程退出,而父进程并没有调用 wait或waitpid获取子进程的状态信息,那么子进程的进程描述符仍然保存在系统中的这些进程是僵尸进程。

避免僵尸进程的方法:

-fork两次用孙子进程去完成子进程的任务;

-用wait()函数使父进程阻塞;

-使用信号量,在 signal handler 中调用waitpid,这样父进程不用阻塞。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

Python中的进程与线程的使用场景?

多进程适合在 CPU 密集型操作(cpu 操作指令比较多,如位数多的浮点运算)。

多线程适合在 IO 密集型操作(读写数据操作较多的,比如爬虫)。

- 1

- 2

线程是并发还是并行,进程是并发还是并行?

线程是并发,进程是并行;

进程之间相互独立,是系统分配资源的最小单位,同一个线程中的所有线程共享资源。

- 1

- 2

并行(parallel)和并发(concurrency)?

并行:同一时刻多个任务同时在运行。

并发:在同一时间间隔内多个任务都在运行,但是并不会在同一时刻同时运行,存在交替执行的情况。

实现并行的库有:multiprocessing

实现并发的库有:threading

程序需要执行较多的读写、请求和回复任务的需要大量的 IO 操作,IO密集型操作使用并发更好。

CPU运算量大的程序程序,使用并行会更好。

IO密集型和CPU密集型区别?

IO密集型:系统运作,大部分的状况是CPU在等 I/O (硬盘/内存)的读/写。

CPU密集型:大部份时间用来做计算、逻辑判断等 CPU动作的程序称之CPU密集型。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

八.网络编程

1.UDP总结

使用udp发送/接收数据步骤:

1.创建客户端套接字

2.发送/接收数据

3.关闭套接字

import socket def main(): # 1、创建udp套接字 # socket.AF_INET 表示IPv4协议 AF_INET6 表示IPv6协议 # socket.SOCK_DGRAM 数据报套接字,只要用于udp协议 udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM) # 2、准备接收方的地址 # 元组类型 ip是字符串类型 端口号是整型 dest_addr = ('192.168.113.111', 8888) # 要发送的数据 send_data = "我是要发送的数据" # 3、发送数据 udp_socket.sendto(send_data.encode("utf-8"), dest_addr) # 4、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据 # 接收到的数据是一个元组 (接收到的数据, 发送方的ip和端口) # 1024 表示本次接收的最大字节数 recv_data, addr = udp_socket.recvfrom(1024) # 5、关闭套接字 udp_socket.close() if __name__ == '__main__': 22. main() 编码的转换 str -->bytes: encode编码 bytes--> str: decode()解码

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

UDP绑定端口号:

1.创建socket套接字

2.绑定端口号

3.接收/发送数据

4.关闭套接字

import socket def main(): # 1、创建udp套接字 # socket.AF_INET 表示IPv4协议 AF_INET6 表示IPv6协议 # socket.SOCK_DGRAM 数据报套接字,只要用于udp协议 udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM) # 2、绑定端口 # 元组类型 ip一般不写 表示本机的任何的一个ip local_addr = ('', 7777) udp_socket.bind(local_addr) # 3、准备接收方的地址 # 元组类型 ip是字符串类型 端口号是整型 dest_addr = ('192.168.113.111', 8888) # 要发送的数据 send_data = "我是要发送的数据" # 4、发送数据 udp_socket.sendto(send_data.encode("utf-8"), dest_addr) # 5、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据 # 接收到的数据是一个元组 (接收到的数据, 发送方的ip和端口) # 1024 表示本次接收的最大字节数 recv_data, addr = udp_socket.recvfrom(1024) # 6、关闭套接字 udp_socket.close() if __name__ == '__main__': main() 注意点:绑定端口要在发送数据之前进行绑定。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

2. TCP总结

TCP客户端的创建流程:

1.创建TCP的socket套接字

2.连接服务器

3.发送数据给服务器端

4.接收服务器端发送来的消息

5.关闭套接字

import socket def main(): # 1、创建客户端的socket # socket.AF_INET 表示IPv4协议 AF_INET6 表示IPv6协议 # socket.SOCK_STREAM 流式套接字,只要用于TCP 协议 client_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM) # 2、构建目标地址 server_ip = input("请输入服务器端的IP地址:") server_port = int(input("请输入服务器端的端口号:")) # 3、连接服务器 # 参数:元组类型 ip 是字符串类型 端口号是整型 client_socket.connect((server_ip, server_port)) # 要发送给服务器端的数据 send_data = "我是要发送给服务器端的数据" # 4、发送数据 client_socket.send(send_data.encode("gbk")) # 5、接收服务器端恢复的消息, 没有消息会阻塞 # 1024表示接收的最大字节数 recv_date= client_socket.recv(1024) print("接收到的数据是:", recv_date.decode('gbk')) # 6、关闭套接字 client_socket.close() if __name__ == '__main__': main()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

TCP服务器端的创建流程

1.创建TCP服务端的socket

2.bing绑定ip地址和端口号

3.listen使套接字变为被动套接字

4.accept取出一个客户端连接,用于服务

5.recv/send接收和发送消息

6.关闭套接字

import socket def main(): # 1、创建tcp服务端的socket server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM) # 2、绑定 server_socket.bind(('', 8888)) # 3、listen使套接字变为被动套接字 server_socket.listen(128) # 4、如果有新的客户端来链接服务器,那么就产生一个新的套接字专门为这个客户端服务 # client_socket用来为这个客户端服务 # tcp_server_socket就可以省下来专门等待其他新客户端的链接 client_socket, client_addr = server_socket.accept() # 5、接收客户端发来的消息 recv_data = client_socket.recv(1024) print("接收到客户端%s的数据:%s" % (str(client_addr), recv_data.decode('gbk'))) # 6、回复数据给客户端 client_socket.send("收到消息".encode('gbk')) # 7、关闭套接字 client_socket.close() server_socket.close() if __name__ == '__main__': main()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

4. TCP是面向连接的通讯协议,通过三次握手建立连接,通讯完成时四次挥手

优点:TCP在数据传递时,有确认、窗口、重传、阻塞等控制机制,能保证数据正确性,较为可靠。

缺点:TCP相对于UDP速度慢一点,要求系统资源较多。

- 1

- 2

5. 简述浏览器通过WSGI请求动态资源的过程?

1.发送http请求动态资源给web服务器

2.web服务器收到请求后通过WSGI调用一个属性给应用程序框架

3.应用程序框架通过引用WSGI调用web服务器的方法,设置返回的状态和头信息。

4.调用后返回,此时web服务器保存了刚刚设置的信息

5.应用程序框架查询数据库,生成动态页面的body的信息

6.把生成的body信息返回给web服务器

7.web服务器吧数据返回给浏览器

- 1

- 2

- 3

- 4

- 5

- 6

- 7

6. 描述用浏览器访问www.baidu.com的过程

先要解析出baidu.com对应的ip地址

- 要先使用arp获取默认网关的mac地址

- 组织数据发送给默认网关(ip还是dns服务器的ip,但是mac地址是默认网关的mac地址)

- 默认网关拥有转发数据的能力,把数据转发给路由器

- 路由器根据自己的路由协议,来选择一个合适的较快的路径转发数据给目的网关

- 目的网关(dns服务器所在的网关),把数据转发给dns服务器

- dns服务器查询解析出baidu.com对应的ip地址,并原路返回请求这个域名的client

得到了baidu.com对应的ip地址之后,会发送tcp的3次握手,进行连接

使用http协议发送请求数据给web服务器

- web服务器收到数据请求之后,通过查询自己的服务器得到相应的结果,原路返回给浏览器。

- 浏览器接收到数据之后通过浏览器自己的渲染功能来显示这个网页。

- 浏览器关闭tcp连接,即4次挥手结束,完成整个访问过程

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

7. Post和Get请求的区别?

GET请求:

请求的数据会附加在URL之后,以?分割URL和传输数据,多个参数用&连接。URL的

编码格式采用的是ASCII编码,而不是uniclde,即是说所有的非ASCII字符都要编码之后再传输。

- 1

- 2

POST请求:

POST请求会把请求的数据放置在HTTP请求包的包体中。上面的item=bandsaw就

是实际的传输数据。

因此,GET请求的数据会暴露在地址栏中,而POST请求则不会。

传输数据的大小:

- 在HTTP规范中,没有对URL的长度和传输的数据大小进行限制。但是在实际开发过程中,对

于GET,特定的浏览器和服务器对URL的长度有限制。因此,在使用GET请求时,传输数据会

受到URL长度的限制。

- 对于POST,由于不是URL传值,理论上是不会受限制的,但是实际上各个服务器会规定对POST

提交数据大小进行限制,Apache、IIS都有各自的配置。

安全性:

- POST的安全性比GET的高。这里的安全是指真正的安全,而不同于上面GET提到的安全方法

中的安全,上面提到的安全仅仅是不修改服务器的数据。比如,在进行登录操作,通过GET请求,

用户名和密码都会暴露再URL上,因为登录页面有可能被浏览器缓存以及其他人查看浏览器的

历史记录的原因,此时的用户名和密码就很容易被他人拿到了。除此之外,GET请求提交的数据

还可能会造成Cross-site request frogery攻击。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

效率:GET比POST效率高。

POST请求的过程:

1.浏览器请求tcp连接(第一次握手)

2.服务器答应进行tcp连接(第二次握手)

3.浏览器确认,并发送post请求头(第三次握手,这个报文比较小,所以http会在此时进行

第一次数据发送)

4.服务器返回100 continue响应

5.浏览器开始发送数据

6.服务器返回200 ok响应

GET请求的过程:

1.浏览器请求tcp连接(第一次握手)

2.服务器答应进行tcp连接(第二次握手)

3.浏览器确认,并发送get请求头和数据(第三次握手,这个报文比较小,所以http会在此时

进行第一次数据发送)

4.服务器返回200 OK响应

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

8. cookie 和session 的区别?

1、cookie数据存放在客户的浏览器上,session数据放在服务器上。

2、cookie不是很安全,别人可以分析存放在本地的cookie并进行cookie欺骗考虑到安全应当使

用session。

3、session会在一定时间内保存在服务器上。当访问增多,会比较占用服务器的性能考虑到减轻服

务器性能方面,应当使用cookie。

4、单个cookie保存的数据不能超过4K,很多浏览器都限制一个站点最多保存20个cookie。

5、建议: 将登陆信息等重要信息存放为SESSION 其他信息如果需要保留,可以放在cookie中

- 1

- 2

- 3

- 4

- 5

- 6

- 7

9. HTTP协议状态码有什么用,列出你知道的 HTTP 协议的状态码,然后讲出他们都 表示什么意思?

通过状态码告诉客户端服务器的执行状态,以判断下一步该执行什么操作。

常见的状态机器码有:

100-199:表示服务器成功接收部分请求,要求客户端继续提交其余请求才能完成整个处理过程。

200-299:表示服务器成功接收请求并已完成处理过程,常用200(OK请求成功)。

300-399:为完成请求,客户需要进一步细化请求。302(所有请求页面已经临时转移到新的url)。

304、307(使用缓存资源)。

400-499:客户端请求有错误,常用404(服务器无法找到被请求页面),403(服务器拒绝访问,

权限不够)。

500-599:服务器端出现错误,常用500(请求未完成,服务器遇到不可预知的情况)。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

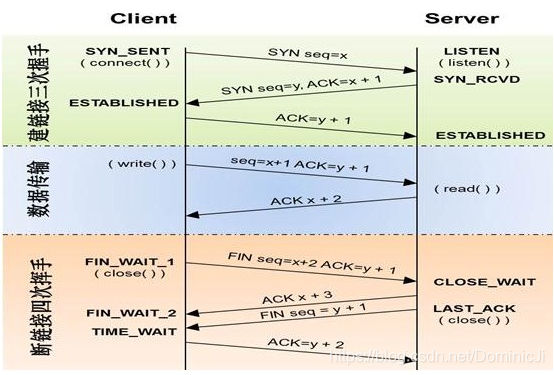

10. 请简单说一下三次握手和四次挥手?

三次握手过程:

1首先客户端向服务端发送一个带有SYN 标志,以及随机生成的序号100(0字节)的报文

2服务端收到报文后返回一个报文(SYN200(0字节),ACk1001(字节+1))给客户端

3客户端再次发送带有ACk标志201(字节+)序号的报文给服务端

至此三次握手过程结束,客户端开始向服务端发送数据。

1客户端向服务端发起请求:我想给你通信,你准备好了么?

2服务端收到请求后回应客户端:I'ok,你准备好了么

3客户端礼貌的再次回一下客户端:准备就绪,咱们开始通信吧!

整个过程跟打电话的过程一模一样:1喂,你在吗2在,我说的你听得到不3恩,听得到(接下来请

开始你的表演)

补充:SYN:请求询问,ACk:回复,回应。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

四次挥手过程:

由于TCP连接是可以双向通信的(全双工),因此每个方向都必须单独进行关闭(这句话才是

精辟,后面四个挥手过程都是其具体实现的语言描述)

四次挥手过程,客户端和服务端都可以先开始断开连接

1客户端发送带有fin标识的报文给服务端,请求通信关闭

2服务端收到信息后,回复ACK答应关闭客户端通信(连接)请求

3服务端发送带有fin标识的报文给客户端,也请求关闭通信

4客户端回应ack给服务端,答应关闭服务端的通信(连接)请求

- 1

- 2

- 3

- 4

- 5

- 6

- 7

11. 说一下什么是tcp的2MSL?

主动发送fin关闭的一方,在4次挥手最后一次要等待一段时间我们称这段时间为2MSL

TIME_WAIT状态的存在有两个理由:

1.让4次挥手关闭流程更加可靠

2.防止丢包后对后续新建的正常连接的传输造成破坏o

- 1

- 2

- 3

- 4

12. 为什么客户端在TIME-WAIT状态必须等待2MSL的时间?

1、为了保证客户端发送的最后一个ACK报文段能够达到服务器。 这个ACK报文段可能丢失,

因而使处在LAST-ACK状态的服务器收不到确认。服务器会超时重传FIN+ACK报文段,客户端就

能在2MSL时间内收到这个重传的FIN+ACK报文段,接着客户端重传一次确认,重启计时器。最

好,客户端和服务器都正常进入到CLOSED状态。如果客户端在TIME-WAIT状态不等待一段时间,

而是再发送完ACK报文后立即释放连接,那么就无法收到服务器重传的FIN+ACK报文段,因而也

不会再发送一次确认报文。这样,服务器就无法按照正常步骤进入CLOSED状态。

2、防止已失效的连接请求报文段出现在本连接中。客户端在发送完最后一个ACK确认报文段

后,再经过时间2MSL,就可以使本连接持续的时间内所产生的所有报文段都从网络中消失。这样

就可以使下一个新的连接中不会出现这种旧的连接请求报文段。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

13. 说说HTTP和HTTPS区别?

HTTP协议传输的数据都是未加密的,也就是明文的,因此使用HTTP协议传输隐私信息非常不安

全,为了保证这些隐私数据能加密传输,于是网景公司设计了SSL(Secure Sockets Layer)协议用于

对HTTP协议传输的数据进行加密,从而就诞生了HTTPS。简单来说,HTTPS协议是由SSL+HTTP协

议构建的可进行加密传输、身份认证的网络协议,要比http协议安全。

HTTPS和HTTP的区别主要如下:

1、https协议需要到ca申请证书,一般免费证书较少,因而需要一定费用。

2、http是超文本传输协议,信息是明文传输,https则是具有安全性的ssl加密传输协议。

3、http和https使用的是完全不同的连接方式,用的端口也不一样,前者是80,后者是443。

4、http的连接很简单,是无状态的;HTTPS协议是由SSL+HTTP协议构建的可进行加密传输、

身份认证的网络协议,比http协议安全。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

14. 谈一下HTTP协议以及协议头部中表示数据类型的字段?

HTTP 协议是 Hyper Text Transfer Protocol(超文本传输协议)的缩写,是用于从万维网

(WWW:World Wide Web)服务器传输超文本到本地浏览器的传送协议。

HTTP 是一个基于 TCP/IP 通信协议来传递数据(HTML 文件, 图片文件, 查询结果等)。

HTTP 是一个属于应用层的面向对象的协议,由于其简捷、快速的方式,适用于分布式超媒体

信息系统。它于 1990 年提出,经过几年的使用与发展,得到不断地完善和扩展。目前在 WWW 中

使用的是 HTTP/1.0 的第六版,HTTP/1.1 的规范化工作正在进行之中,而且 HTTP-NG(Next

Generation of HTTP)的建议已经提出。

HTTP 协议工作于客户端-服务端架构为上。浏览器作为 HTTP 客户端通过URL 向 HTTP 服

务端即 WEB 服务器发送所有请求。Web 服务器根据接收到的请求后,向客户端发送响应信息。

表示数据类型字段: Content-Type

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

15. HTTP请求方法都有什么?

根据HTTP标准,HTTP请求可以使用多种请求方法。

HTTP1.0定义了三种请求方法: GET, POST 和 HEAD方法。

HTTP1.1新增了五种请求方法:OPTIONS, PUT, DELETE, TRACE 和 CONNECT 方法。

1、 GET 请求指定的页面信息,并返回实体主体。

2、HEAD 类似于get请求,只不过返回的响应中没有具体的内容,用于获取报头

3、POST 向指定资源提交数据进行处理请求(例如提交表单或者上传文件)。数据被包含在

请求体中。POST请求可能会导致新的资源的建立和/或已有资源的修改。

4、PUT 从客户端向服务器传送的数据取代指定的文档的内容。

5、DELETE 请求服务器删除指定的页面。

6、CONNECT HTTP/1.1协议中预留给能够将连接改为管道方式的代理服务器。

7、OPTIONS 允许客户端查看服务器的性能。

8、TRACE 回显服务器收到的请求,主要用于测试或诊断。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

16. 使用Socket套接字需要传入哪些参数 ?

Address Family 和 Type,分别表示套接字应用场景和类型。

family的值可以是AF_UNIX(Unix域,用于同一台机器上的进程间通讯),也可以是AF_INET

(对于IPV4协议的TCP和 UDP),至于type参数,SOCK_STREAM(流套接字)或者

SOCK_DGRAM(数据报文套接字),SOCK_RAW(raw套接字)。

- 1

- 2

- 3

- 4

17. HTTP常见请求头?

1. Host (主机和端口号)

2. Connection (链接类型)

3. Upgrade-Insecure-Requests (升级为 HTTPS 请求)

4. User-Agent (浏览器名称)

5. Accept (传输文件类型)

6. Referer (页面跳转处)

7. Accept-Encoding(文件编解码格式)

8. Cookie (Cookie)

9. x-requested-with :XMLHttpRequest (是 Ajax 异步请求)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

18. 七层模型? IP ,TCP/UDP ,HTTP ,RTSP ,FTP 分别在哪层?

IP: 网络层 TCP/UDP: 传输层 HTTP、RTSP、FTP: 应用层协议

- 1

19. url的形式?

形式: scheme://host[:port#]/path/…/[?query-string][#anchor]

scheme:协议(例如:http, https, ftp)

host:服务器的IP地址或者域名

port:服务器的端口(如果是走协议默认端口,80 or 443)

path:访问资源的路径

query-string:参数,发送给http服务器的数据

anchor:锚(跳转到网页的指定锚点位置)

http://localhost:8000/file/part01/1.2.html

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

20. 幂等 Idempotence

HTTP方法的幂等性是指一次和多次请求某一个资源应该具有同样的副作用。(注意是副作用)

GET http://www.bank.com/account/123456,不会改变资源的状态,不论调用一次还是N次都没有副作用。请注意,这里强调的是一次和N次具有相同的副作用,而不是每次GET的结果相同。GET http://www.news.com/latest-news这个HTTP请求可能会每次得到不同的结果,但它本身并没有产生任何副作用,因而是满足幂等性的。

DELETE方法用于删除资源,有副作用,但它应该满足幂等性。比如:DELETE http://www.forum.com/article/4231,调用一次和N次对系统产生的副作用是相同的,即删掉id为4231的帖子;因此,调用者可以多次调用或刷新页面而不必担心引起错误。

POST所对应的URI并非创建的资源本身,而是资源的接收者。比如:POST http://www.forum.com/articles的语义是在http://www.forum.com/articles下创建一篇帖子,HTTP响应中应包含帖子的创建状态以及帖子的URI。两次相同的POST请求会在服务器端创建两份资源,它们具有不同的URI;所以,POST方法不具备幂等性。

PUT所对应的URI是要创建或更新的资源本身。比如:PUT http://www.forum/articles/4231的语义是创建或更新ID为4231的帖子。对同一URI进行多次PUT的副作用和一次PUT是相同的;因此,PUT方法具有幂等性。

- 1

- 2

- 3

- 4

- 5

21. SOAP

SOAP(原为Simple Object Access Protocol的首字母缩写,即简单对象访问协议)是交换数据的一种协议规范,使用在计算机网络Web服务(web service)中,交换带结构信息。SOAP为了简化网页服务器(Web Server)从XML数据库中提取数据时,节省去格式化页面时间,以及不同应用程序之间按照HTTP通信协议,遵从XML格式执行资料互换,使其抽象于语言实现、平台和硬件。

- 1

22. RPC

RPC(Remote Procedure Call Protocol)——远程过程调用协议,它是一种通过网络从远程计算机程序上请求服务,而不需要了解底层网络技术的协议。RPC协议假定某些传输协议的存在,如TCP或UDP,为通信程序之间携带信息数据。在OSI网络通信模型中,RPC跨越了传输层和应用层。RPC使得开发包括网络分布式多程序在内的应用程序更加容易。

总结:服务提供的两大流派.传统意义以方法调用为导向通称RPC。为了企业SOA,若干厂商联合推出webservice,制定了wsdl接口定义,传输soap.当互联网时代,臃肿SOA被简化为http+xml/json.但是简化出现各种混乱。以资源为导向,任何操作无非是对资源的增删改查,于是统一的REST出现了.

进化的顺序: RPC -> SOAP -> RESTful

- 1

- 2

- 3

第四章 前端

一.Html

head内常用标签:

https://www.cnblogs.com/Dominic-Ji/p/9085037.html

body内常用标签:

https://www.cnblogs.com/Dominic-Ji/p/9085099.html

二.Css

CSS选择器:

https://www.cnblogs.com/Dominic-Ji/p/9091130.html

属性相关:

https://www.cnblogs.com/Dominic-Ji/p/9100443.html

1. 什么是CSS初始化?有什么好处?

CSS初始化是指重设浏览器的样式。不同的浏览器默认的样式可能不尽相同,如果没对CSS初始化

往往会出现浏览器之间的页面差异。

好处:能够统一标签在各大主流浏览器中的默认样式,使得我们开发网页内容时更加方便简洁,同

时减少CSS代码量,节约网页下载时间。

- 1

- 2

- 3

- 4

2. 简述浮动的特征和清除浮动的方法?

浮动的特征:

浮动元素有左浮动(float:left)和右浮动(float:right)两种。

浮动的元素会向左或向右浮动,碰到父元素边界、其他元素才停下来。

相邻浮动的块元素可以并在一行,超出父级宽度就换行。

浮动让行内元素或块元素转化为有浮动特性的行内块元素(此时不会有行内块元素间隙问题)。

父元素如果没有设置尺寸(一般是高度不设置),父元素内整体浮动的子元素无法撑开父元素,父元

素需要清除浮动。

清除浮动的方法:

父级上增加属性overflow:hidden。

在最后一个子元素的后面加一个空的div,给它样式属性 clear:both。

使用成熟的清浮动样式类,clearfix。

1. .clearfix:after,.clearfix:before{ content: "";display: table;} 2. .clearfix:after{ clear:both;} 3. .clearfix{zoom:1;}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

三.JavaScript

参考博客:

https://www.cnblogs.com/Dominic-Ji/p/9111021.html

1. AJAX试什么?如何使用AJAX?

ajax(异步的javascript 和xml) 能够刷新局部网页数据而不是重新加载整个网页。

第一步,创建xmlhttprequest对象,var xmlhttp =new XMLHttpRequest();XMLHttpRequest

对象用来和服务器交换数据。

第二步,使用xmlhttprequest对象的open()和send()方法发送资源请求给服务器。

第三步,使用xmlhttprequest对象的responseText或responseXML属性获得服务器的响应。

第四步,onreadystatechange函数,当发送请求到服务器,我们想要服务器响应执行一些功能就

需要使用onreadystatechange函数,每次xmlhttprequest对象的readyState发生改变都会触发

onreadystatechange函数。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

第五章 Web

一.Flask

**参考博客(写的很好,很全,很牛逼的~)?*https://www.cnblogs.com/Dominic-Ji/p/9505608.html

1. Flask 中正则 URL 的实现?

app.route(’’)中 URL 显式支持 string、int、float、path uuid any 6种类型,隐式支持正则。

**第一步:**写正则类,继承 BaseConverter,将匹配到的值设置为 regex 的值。

1. class RegexUrl(BaseConverter):

2. def __init__(self, url_map, *args):

3. super(RegexUrl, self).__init__(url_map)

4. self.regex = args[0]

- 1

- 2

- 3

- 4

**第二步:**把正则类赋值给我们定义的正则规则。

5. app.url_map.converters['re'] = RegexUrl

- 1

**第三步:**在 URL 中使用正则。

6. @app.route('/regex/<re("[a-z]{3}"):id>')

7. def regex111(id):

8. return 'id:%s'%id

- 1

- 2

- 3

2. Flask 中请求上下文和应用上下文的区别和作用?

current_app、g 是应用上下文。

request、session 是请求上下文。

手动创建上下文的两种方法:

1. with app.app_context()

2. app = current_app._get_current_object()

- 1

- 2

两者区别:

请求上下文:保存了客户端和服务器交互的数据。

应用上下文:flask 应用程序运行过程中,保存的一些配置信息,比如程序名、数据库连接、应用信息等。

两者作用:

请求上下文(request context):

Flask从客户端收到请求时,要让视图函数能访问一些对象,这样才能处理请求。请求对象是一个很好的例子,它封装了客户端发送的HTTP请求。

要想让视图函数能够访问请求对象,一个显而易见的方式是将其作为参数传入视图函数,不过这会导致程序中的每个视图函数都增加一个参数,除了访问请求对象,如果视图函数在处理请求时还要访问其他对象,情况会变得更糟。为了避免大量可有可无的参数把视图函数弄得一团糟,

Flask使用上下文临时把某些对象变为全局可访问。

应用上下文(application context):

它的字面意思是 应用上下文,但它不是一直存在的,它只是request context 中的一个对 app 的代理(人),所谓local proxy。它的作用主要是帮助 request 获取当前的应用,它是伴 request 而生,随 request 而灭的。

3. Flask中数据库设置?

1. app.config['SQLALCHEMY_DATABASE_URI'] = 'mysql://root:mysql@127.0.0.1:3306/test'

- 1

动态追踪修改设置,如未设置只会提示警告

1. app.config['SQLALCHEMY_TRACK_MODIFICATIONS'] = True

- 1

查询时会显示原始SQL语句

1. app.config['SQLALCHEMY_ECHO'] = True

- 1

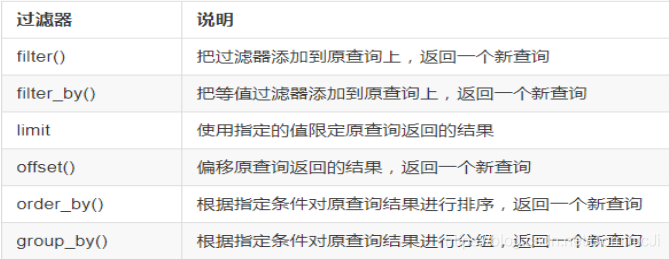

4. 常用的SQLAlchemy查询过滤器?

5. 对Flask蓝图(Blueprint)的理解?

1) 蓝图的定义

蓝图 /Blueprint 是Flask应用程序组件化的方法,可以在一个应用内或跨越多个项目共用蓝图。

使用蓝图可以极大地简化大型应用的开发难度,也为 Flask扩展 提供了一种在应用中注册服务的集中式机制。

2) 蓝图的应用场景

1. 把一个应用分解为一个蓝图的集合。这对大型应用是理想的。一个项目可以实例化一个应用对象,初始化几个扩展,并注册一集合的蓝图。

2. 以 URL 前缀和/或子域名,在应用上注册一个蓝图。 URL 前缀/子域名中的参数即成为这个蓝图下的所有视图函数的共同的视图参数(默认情况下)。

3. 在一个应用中用不同的 URL 规则多次注册一个蓝图。

4. 通过蓝图提供模板过滤器、静态文件、模板和其它功能。一个蓝图不一定要实现应用或者视图函数。

5. 初始化一个 Flask 扩展时,在这些情况中注册一个蓝图。

3) 蓝图的缺点

不能在应用创建后撤销注册一个蓝图而不销毁整个应用对象。

4) 使用蓝图的三个步骤

1.创建 一个蓝图对象

2. blue = Blueprint("blue",__name__)

- 1

2.在这个蓝图对象上进行操作 ,例如注册路由、指定静态文件夹、注册模板过滤器

1. @blue.route('/')

2. def blue_index():

3. return 'Welcome to my blueprint'

- 1

- 2

- 3

3.在应用对象上注册这个蓝图对象

1. app.register_blueprint(blue,url_prefix='/blue')

- 1

字段对象 说明

FieldList 一组指定类型的字段

WTForms常用验证函数

InputRequired 确保字段中有数据

DataRequired 确保字段中有数据并且数据为真

EqualTo 比较两个字段的值,常用于比较两次密码输入

Length 验证输入的字符串长度

NumberRange 验证输入的值在数字范围内

URL 验证URL

AnyOf 验证输入值在可选列表中

NoneOf 验证输入值不在可选列表中

使用Flask-WTF需要配置参数SECRET_KEY。

CSRF_ENABLED是为了CSRF(跨站请求伪造)保护。 SECRET_KEY用来生成加密令牌,当CSRF激活的时候,该设置会根据设置的密匙生成加密令牌。

6. Flask项目中如何实现 session 信息的写入?

Flask中有三个 session:

第一个:数据库中的 session,例如:db.session.add()

第二个:在 flask_session 扩展中的 session,使用:from flask_session importSession,使用第三方扩展的 session 可以把信息存储在服务器中,客户端浏览器中只存储 sessionid。

第三个:flask 自带的 session,是一个请求上下文, 使用:from flask import session。自带的session 把信息加密后都存储在客户端的浏览器 cookie 中。

7. 项目接口实现后路由访问不到怎么办?

1.可以通过 postman 测试工具测试,或者看 log 日志信息找到错误信息的大概位置。

2.断点调试

8. Flask中url_for函数?

**1.URL反转:**根据视图函数名称得到当前所指向的url。

2.url_for() 函数最简单的用法是以视图函数名作为参数,返回对应的url,还可以用作加载静态文件。

1. <link rel="stylesheet" href="{{url_for('static',filename='css/index.css')}}">

- 1

该条语句就是在模版中加载css静态文件。

3.url_for 和 redirect 区别

url_for是用来拼接 URL 的,可以使用程序 URL 映射中保存的信息生成 URL。url_for() 函数最简单的用法是以视图函数名作为参数, 返回对应的 URL。例如,在示例程序中 hello.py 中调用

url_for(‘index’) 得到的结果是 /。

redirect 是重定向函数,输入一个URL后,自动跳转到另一个URL所在的地址,例如,你在函数

中写 return redirect(‘https://www.baidu.com’) 页面就会跳转向百度页面。

1. from flask import Flask,redirect,url_for 2. app = Flask(__name__) 3. @app.route('/') 4. def index(): 5. login_url = url_for('login') 6. return redirect(login_url) 7. return u'这是首页' 8. 9. @app.route('/login/') 10. def login(): 11. return u'这是登陆页面' 12. 13. @app.route('/question/<is_login>/') 14. def question(is_login): 15. if is_login == '1': 16. return u'这是发布问答的页面' 17. else: 18. return redirect(url_for('login')) 19. 20. if __name__ == '__main__': 21. app.run(debug=True)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

9. Flask中请求钩子的理解和应用?

请求钩子是通过装饰器的形式实现的,支持以下四种:

1,before_first_request 在处理第一个请求前运行

2,before_request:在每次请求前运行

3,after_request:如果没有未处理的异常抛出,在每次请求后运行

4,teardown_request:即使有未处理的异常抛出,在每次请求后运行

应用:

请求钩子

1. @api.after_request

2. def after_request(response):

3. """设置默认的响应报文格式为 application/json"""

4. # 如果响应报文 response 的 Content-Type 是以 text 开头,则将其改为

5. # 默认的 json 类型

6. if response.headers.get("Content-Type").startswith("text"):

7. response.headers["Content-Type"] = "application/json"

8. return respon

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

10. 一个变量后写多个过滤器是如何执行的?

{{ expression | filter1 | filter2 | … }} 即表达式(expression)使用filter1 过滤后再将filter1的结果去使用 filter2 过滤。

11. 如何把整个数据库导出来,再导入指定数据库中?

导出:

mysqldump [-h 主机] -u 用户名 -p 数据库名 > 导出的数据库名.sql

导入指定的数据库中:

第一种方法:

mysqldump [-h 主机] -u 用户名 -p 数据库名 < 导出的数据库名.sql

第二种方法:

先创建好数据库,因为导出的文件里没有创建数据库的语句,如果数据库已经建好,则不用再创建。

create database example charset=utf8;(数据库名可以不一样)

切换数据库:

use example;

导入指定 sql 文件:

mysql>source /path/example.sql;

12. Flask和Django路由映射的区别?

在django中,路由是浏览器访问服务器时,先访问的项目中的url,再由项目中的url找到应用中url,这些url是放在一个列表里,遵从从前往后匹配的规则。在flask中,路由是通过装饰器给每个视图函数提供的,而且根据请求方式的不同可以一个url用于不同的作用。

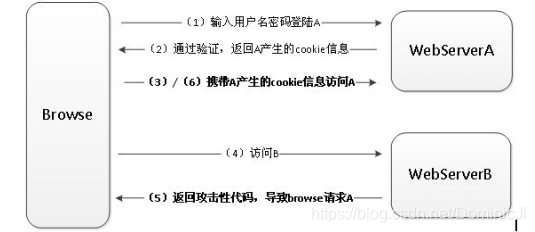

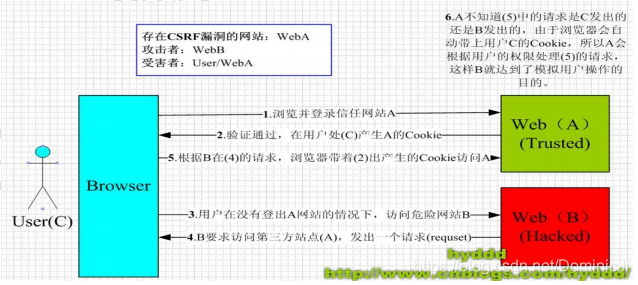

13. 跨站请求伪造和跨站请求保护的实现?

图中Browse是浏览器,WebServerA是受信任网站/被攻击网站A,WebServerB是恶意网站/点

击网站B。

(1)一开始用户打开浏览器,访问受信任网站A,输入用户名和密码登陆请求登陆网站A。

(2)网站A验证用户信息,用户信息通过验证后,网站A产生Cookie信息并返回给浏览器。

(3)用户登陆网站A成功后,可以正常请求网站A。

(4)用户未退出网站A之前,在同一浏览器中,打开一个TAB访问网站B。

(5)网站B看到有人方式后,他会返回一些攻击性代码。

(6)浏览器在接受到这些攻击性代码后,促使用户不知情的情况下浏览器携带Cookie(包括sessionId)信息,请求网站A。这种请求有可能更新密码,添加用户什么的操作。 从上面CSRF攻击原理可以看出,要完成一次CSRF攻击,需要被攻击者完成两个步骤:

1.登陆受信任网站A,并在本地生成COOKIE。

2.在不登出A的情况下,访问危险网站B。

如果不满足以上两个条件中的一个,就不会受到CSRF的攻击,以下情况可能会导致CSRF:

1.登录了一个网站后,打开一个tab页面并访问另外的网站。

2.关闭浏览器了后,本地的Cookie尚未过期,你上次的会话还没有已经结束。(事实上,关闭浏览器不能结束一个会话,但大多数人都会错误的认为关闭浏览器就等于退出登录/结束会话了……)

解决办法:就是在表单中添加from.csrf_token。

14. Flask(_name_)中的__name__可以传入哪些值?

可以传入的参数:

1,字符串:‘hello’,

但是‘abc’,不行,因为abc是python内置的模块

2,_name_,约定俗成

不可以插入的参数

1,python内置的模块,re,urllib,abc等

2,数字

###二.Django

1. Django ORM查询中select_related和prefetch_related的区别??

**参考博客:**https://www.cnblogs.com/Dominic-Ji/p/9213887.html

2. Django ORM详解?

**参考博客:**https://www.cnblogs.com/Dominic-Ji/p/9209341.html

3. Django创建项目的命令?

django-admin startproject 项目名称

python manage.py startapp 应用 app 名

4. Django 创建项目后,项目文件夹下的组成部分(对mvt 的理解)?

项目文件夹下的组成部分:

manage.py 是项目运行的入口,指定配置文件路径。

与项目同名的目录,包含项目的配置文件。

_init.py 是一个空文件,作用是这个目录可以被当作包使用,也可以做一些初始化操作。

settings.py 是项目的整体配置文件。

urls.py 是项目的 URL 配置文件。

wsgi.py 是项目与 WSGI 兼容的 Web 服务器。

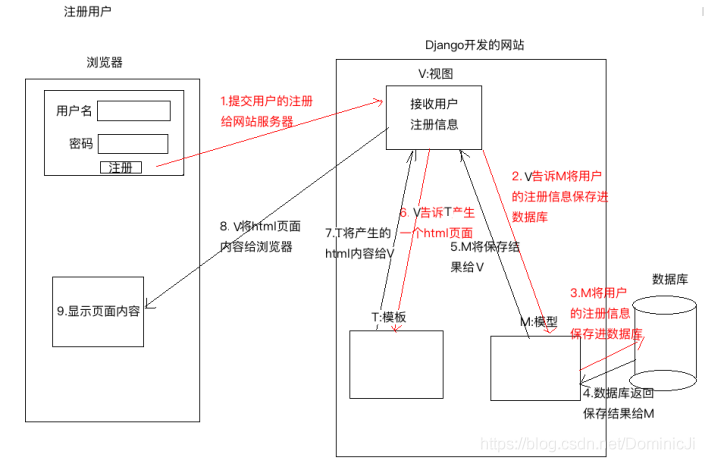

5. 对 MVC,MVT解读的理解?

M:Model,模型,和数据库进行交互

V:View,视图,负责产生Html页面

C:Controller,控制器,接收请求,进行处理,与M和V进行交互,返回应答。

1、 用户点击注按钮,将要注册的信息发送给网站服务器。

2、 Controller控制器接收到用户的注册信息,Controller会告诉Model层将用户的注册信息保存到数据库

3、 Model层将用户的注册信息保存到数据库

4、 数据保存之后将保存的结果返回给Model模型,

5、 Model层将保存的结果返回给Controller控制器。

6、 Controller控制器收到保存的结果之后,或告诉View视图,view视图产生一个html页面。

7、 View将产生的Html页面的内容给了Controller控制器。

8、 Controller将Html页面的内容返回给浏览器。

9、 浏览器接受到服务器Controller返回的Html页面进行解析展示。

M:Model,模型,和MVC中的M功能相同,和数据库进行交互。

V:view,视图,和MVC中的C功能相同,接收请求,进行处理,与M和T进行交互,返回应答。

T:Template,模板,和MVC中的V功能相同,产生Html页面

1、 用户点击注册按钮,将要注册的内容发送给网站的服务器。

2、 View视图,接收到用户发来的注册数据,View告诉Model将用户的注册信息保存进数据库。

3、 Model层将用户的注册信息保存到数据库中。

4、 数据库将保存的结果返回给Model

5、 Model将保存的结果给View视图。

6、 View视图告诉Template模板去产生一个Html页面。

7、 Template生成html内容返回给View视图。

8、 View将html页面内容返回给浏览器。

9、 浏览器拿到view返回的html页面内容进行解析,展示。

6. Django中models利用ORM对Mysql进行查表的语句(多个语句)?

字段查询

all():返回模型类对应表格中的所有数据。

get():返回表格中满足条件的一条数据,如果查到多条数据,则抛异常:MultipleObjectsReturned,

查询不到数据,则抛异常:DoesNotExist。

filter():参数写查询条件,返回满足条件 QuerySet 集合数据。

条件格式:

模型类属性名__条件名=值

注意:此处是模型类属性名,不是表中的字段名

关于 filter 具体案例如下:

判等 exact。

1. BookInfo.object.filter(id=1)

2. BookInfo.object.filter(id__exact=1)此处的__exact 可以省略

- 1

- 2

模糊查询 like

例:查询书名包含’传’的图书。contains

1. contains BookInfo.objects.filter(btitle__contains=’传’)

- 1

空查询 where 字段名 isnull

1. BookInfo.objects.filter(btitle__isnull=False)

- 1

范围查询 where id in (1,3,5)

1. BookInfo.objects.filter(id__in=[1,3,5])

- 1

比较查询 gt lt(less than) gte(equal) lte

1. BookInfo.objects.filter(id__gte=3)

- 1

日期查询

1. BookInfo.objects.filter(bpub_date__year = 1980)

2. BookInfo.objects.filter(bpub_date__gt = date(1980,1,1))

- 1

- 2

exclude:返回不满足条件的数据。

3. BookInfo.objects.exclude(id=3)

- 1

F 对象

作用:用于类属性之间的比较条件。

1. from django.db.models import F

2. 例:where bread > bcomment BookInfo.objects.filter(bread__gt =F(‘bcomment’))

3. 例:BookInfo.objects.filter(bread__gt=F(‘bcomment’)*2)

- 1

- 2

- 3

Q 对象

作用:用于查询时的逻辑条件。可以对 Q 对象进行&|~操作。

1. from django.db.models import Q

2. BookInfo.objects.filter(id__gt=3, bread__gt=30)

3. BooInfo.objects.filter(Q(id__gt=3) & Q(bread__gt=3))

4. 例:BookInfo.objects.filter(Q(id__gt=3) | Q(bread__gt=30))

5. 例:BookInfo.objects.filter(~Q(id=3))

- 1

- 2

- 3

- 4

- 5

order_by 返回 QuerySet

作用:对查询结果进行排序。

1. 例: BookInfo.objects.all().order_by('id')

2. 例: BookInfo.objects.all().order_by('-id')

3. 例:BookInfo.objects.filter(id__gt=3).order_by('-bread')

- 1

- 2

- 3

聚合函数

作用:对查询结果进行聚合操作。

1. sum count max min avg

- 1

aggregate:调用这个函数来使用聚合。

1. from django.db.models import Sum,Count,Max,Min,Avg

2. 例:BookInfo.objects.aggregate(Count('id'))

- 1

- 2

{‘id__count’: 5} 注意返回值类型及键名

1. 例:BookInfo.objects.aggregate(Sum(‘bread’))

- 1

{‘bread__sum’:120} 注意返回值类型及键名

count 函数

作用:统计满足条件数据的数目。

例:统计所有图书的数目。

1. BookInfo.objects.all().count()

- 1

例:统计 id 大于 3 的所有图书的数目。

1. BookInfo.objects.filter(id__gt = 3).count()

- 1

模型类关系

一对多关系

例:图书类-英雄类

models.ForeignKey() 定义在多的类中。

2)多对多关系

例:新闻类-新闻类型类

models.ManyToManyField() 定义在哪个类中都可以。

3)一对一关系

例:员工基本信息类-员工详细信息类

models.OneToOneField() 定义在哪个类中都可以。

7. django中间件的使用?

面试官问你Django中间件的时候,我们不应该只是局限于面试官的问题,而应做到举一反三。

面试之前准备一些白纸,在问到一些问题的时候应该用画图的形式展示出来

比如这里问到Django的中间件,我们应该给面试官画出Django的生命周期整体流程图,把中间件作为一部分的回答内容,

这样的好处在于,即展示了你对Django从前到后的流程都很熟悉又回答了面试官的问题,还顺带秀了一把其他技能,一举两得。

中间件介绍:作为Django的门户,一切请求都会先经过中间件才会到达Django后端,所以中间件可以用来做全局方面的一些功能

详细:给我们定义了五个方法

1.def process_request(request):

pass

2.def process_view(request):

pass

3.def process_template_response(request):

pass

4.def process_exception(request):

pass

5.def process_response(request):

pass

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

这些内容应该做到快速回答,不要"慢条斯理"的,搞IT的都很忙好吧,知识点一定要掌握牢固,脱口而出

一定要记住你是需要在有限的时间内将自己的看家本领不遗余力的倾囊而出

8. 谈一下你对uWSGI和 nginx的理解?

1.uWSGI是一个Web服务器,它实现了WSGI协议、uwsgi、http等协议。Nginx中HttpUwsgiModule的作用是与uWSGI服务器进行交换。WSGI是一种Web服务器网关接口。它是一个Web服务器(如nginx,uWSGI等服务器)与web应用(如用Flask框架写的程序)通信的一种规范。

要注意 WSGI / uwsgi / uWSGI 这三个概念的区分。

WSGI是一种通信协议。

uwsgi是一种线路协议而不是通信协议,在此常用于在uWSGI服务器与其他网络服务器的数据通信。

uWSGI是实现了uwsgi和WSGI两种协议的Web服务器。

2. nginx是一个开源的高性能的HTTP服务器和反向代理:

1.作为web服务器,它处理静态文件和索引文件效果非常高;

2.它的设计非常注重效率,最大支持5万个并发连接,但只占用很少的内存空间;

3.稳定性高,配置简洁;

4.强大的反向代理和负载均衡功能,平衡集群中各个服务器的负载压力应用。

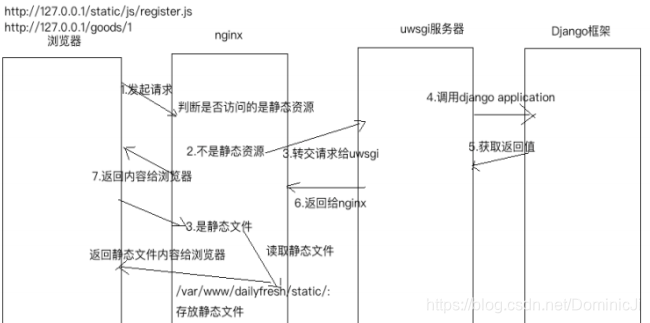

9. 说说nginx和uWISG 服务器之间如何配合工作的?

首先浏览器发起http请求到nginx服务器,Nginx根据接收到请求包,进行url分析,判断访问的资源类型,如果是静态资源,直接读取静态资源返回给浏览器,如果请求的是动态资源就转交给uwsgi服务器,uwsgi服务器根据自身的uwsgi和WSGI协议,找到对应的Django框架,Django框架下的应用进行逻辑处理后,将返回值发送到uwsgi服务器,然后uwsgi服务器再返回给nginx,最后nginx将返回值返回给浏览器进行渲染显示给用户。 如果可以,画图讲解效果更佳,可以 将下面的图画给面试官。

10. django开发中数据库做过什么优化?

1.设计表时,尽量少使用外键,因为外键约束会影响插入和删除性能;

2.使用缓存,减少对数据库的访问;

3.在orm框架下设置表时,能用varchar确定字段长度时,就别用text;

4.可以给搜索频率高的字段属性,在定义时创建索引;

5.Django orm框架下的Querysets 本来就有缓存的;

6.如果一个页面需要多次连接数据库,最好一次性取出所有需要的数据,减少对数据库的查询次数;

7.若页面只需要数据库里某一个两个字段时,可以用QuerySet.values();

8.在模板标签里使用with标签可以缓存Qset的查询结果。

11. 验证码过期时间怎么设置?

将验证码保存到数据库或session,设置过期时间为1分钟,然后页面设置一个倒计时(一般是前端js实现 这个计时)的展示,一分钟过后再次点击获取新的信息。

12. Python中三大框架各自的应用场景?

django:主要是用来搞快速开发的,他的亮点就是快速开发,节约成本,正常的并发量不过10000,如果要实现高并发的话,就要对django进行二次开发,比如把整个笨重的框架给拆掉,自己写socket实现http的通信,底层用纯c,c++写提升效率,ORM框架给干掉,自己编写封装与数据库交互的框

架,因为啥呢,ORM虽然面向对象来操作数据库,但是它的效率很低,使用外键来联系表与表之间的查询;

flask:轻量级,主要是用来写接口的一个框架,实现前后端分离,提升开发效率,Flask本身相当于一个内核,其他几乎所有的功能都要用到扩展(邮件扩展Flask-Mail,用户认证Flask-Login),都需要用第三方的扩展来实现。比如可以用Flask-extension加入ORM、窗体验证工具,文件上传、身份验

证等。Flask没有默认使用的数据库,你可以选择MySQL,也可以NoSQL。

其 WSGI 工具箱采用 Werkzeug(路由模块),模板引擎则使用 Jinja2。这两个也是Flask框架的核心。Python最出名的框架要数Django,此外还有Flask、Tornado等框架。虽然Flask不是最出名的框架,但是Flask应该算是最灵活的框架之一,这也是Flask受到广大开发者喜爱的原因。

Tornado: Tornado是一种 Web 服务器软件的开源版本。Tornado 和现在的主流 Web 服务器框架(包括大多数 Python 的框架)有着明显的区别:它是非阻塞式服务器,而且速度相当快。 得利于其非阻塞的方式和对epoll的运用,Tornado 每秒可以处理数以千计的连接,因此 Tornado 是实时 Web 服务的一个 理想框架。

13. django如何提升性能(高并发)?

对一个后端开发程序员来说,提升性能指标主要有两个一个是并发数,另一个是响应时间网站性能的优化一般包括web前端性能优化,应用服务器性能优化,存储服务器优化。

对前端的优化主要有:

1.减少http请求,减少数据库的访问量,比如使用雪碧图。

2.使用浏览器缓存,将一些常用的css,js,logo图标,这些静态资源缓存到本地浏览器,通过设置http头中的cache-control和expires的属性,可设定浏览器缓存,缓存时间可以自定义。

3.对html,css,javascript文件进行压缩,减少网络的通信量。

对我个人而言,我做的优化主要是以下三个方面:

1.合理的使用缓存技术,对一些常用到的动态数据,比如首页做一个缓存,或者某些常用的数据做

个缓存,设置一定得过期时间,这样减少了对数据库的压力,提升网站性能。

2.使用celery消息队列,将耗时的操作扔到队列里,让worker去监听队列里的任务,实现异步操

作,比如发邮件,发短信。

3.就是代码上的一些优化,补充:nginx部署项目也是项目优化,可以配置合适的配置参数,提升效率,增加并发量。

4.如果太多考虑安全因素,服务器磁盘用固态硬盘读写,远远大于机械硬盘,这个技术现在没有普及,主要是固态硬盘技术上还不是完全成熟, 相信以后会大量普及。

5.另外还可以搭建服务器集群,将并发访问请求,分散到多台服务器上处理。

6.最后就是运维工作人员的一些性能优化技术了。

14. 什么是restful api,谈谈你的理解?

上来先给面试官扔出一手Django的restgramework源码(这一块知识课下一定要自己看着源码走三遍做到烂熟于心,看着面试官的眼睛快速自信的说出。这一手源码扔出来之后,面试已经成功一半)

REST:Representational State Transfer的缩写,翻译:“具象状态传输”。一般解释为“表现层状态转换”。

REST是设计风格而不是标准。是指客户端和服务器的交互形式。我们需要关注的重点是如何设计REST风格的网络接口。

REST的特点:

1.具象的。一般指表现层,要表现的对象就是资源。比如,客户端访问服务器,获取的数据就是资源。比如文字、图片、音视频等。

2.表现:资源的表现形式。txt格式、html格式、json格式、jpg格式等。浏览器通过URL确定资源的位置,但是需要在HTTP请求头中,用AcceptContent-Type字段指定,这两个字段是对资源表现的描述。

3.状态转换:客户端和服务器交互的过程。在这个过程中,一定会有数据和状态的转化,这种转化叫做状态转换。其中,GET表示获取资源,POST表示新建资源,PUT表示更新资源,DELETE表示删除资源。HTTP协议中最常用的就是这四种操作方式。

RESTful架构:

1.每个URL代表一种资源;

2.客户端和服务器之间,传递这种资源的某种表现层;

3.客户端通过四个http动词,对服务器资源进行操作,实现表现层状态转换。

14.1 如何设计符合 RESTful 风格的 API

一、域名:

将api部署在专用域名下:

http://api.example.com

或者将api放在主域名下:

http://www.example.com/api/

二、版本:

将API的版本号放在url中。

http://www.example.com/app/1.0/info

http://www.example.com/app/1.2/info

三、路径:

路径表示API的具体网址。每个网址代表一种资源。 资源作为网址,网址中不能有动词只能有名词,一般名词要与数据库的表名对应。而且名词要使用复数。

错误示例:

http://www.example.com/getGoods

http://www.example.com/listOrders

正确示例:

获取单个商品

http://www.example.com/app/goods/1

获取所有商品

http://www.example.com/app/goods

四、使用标准的HTTP方法:

对于资源的具体操作类型,由HTTP动词表示。 常用的HTTP动词有四个。

GET SELECT :从服务器获取资源。

POST CREATE :在服务器新建资源。

PUT UPDATE :在服务器更新资源。

DELETE DELETE :从服务器删除资源。

示例:

获取指定商品的信息

GET http://www.example.com/goods/ID

新建商品的信息

POST http://www.example.com/goods

更新指定商品的信息

PUT http://www.example.com/goods/ID

删除指定商品的信息

DELETE http://www.example.com/goods/ID

五、过滤信息:

如果资源数据较多,服务器不能将所有数据一次全部返回给客户端。API应该提供参数,过滤返回结果。 实例:

指定返回数据的数量

http://www.example.com/goods?limit=10

指定返回数据的开始位置

http://www.example.com/goods?offset=10

指定第几页,以及每页数据的数量

http://www.example.com/goods?page=2&per_page=20

六、状态码:

服务器向用户返回的状态码和提示信息,常用的有:

200 OK :服务器成功返回用户请求的数据

201 CREATED :用户新建或修改数据成功。

202 Accepted:表示请求已进入后台排队。

400 INVALID REQUEST :用户发出的请求有错误。

401 Unauthorized :用户没有权限。

403 Forbidden :访问被禁止。

404 NOT FOUND :请求针对的是不存在的记录。

406 Not Acceptable :用户请求的的格式不正确。

500 INTERNAL SERVER ERROR :服务器发生错误。

七、错误信息:

一般来说,服务器返回的错误信息,以键值对的形式返回。

{

error: ‘Invalid API KEY’

}

八、响应结果:

针对不同结果,服务器向客户端返回的结果应符合以下规范。

返回商品列表

GET http://www.example.com/goods

返回单个商品

GET http://www.example.com/goods/cup

返回新生成的商品

POST http://www.example.com/goods

返回一个空文档

DELETE http://www.example.com/goods

九、使用链接关联相关的资源:

在返回响应结果时提供链接其他API的方法,使客户端很方便的获取相关联的信息。

十、其他:

服务器返回的数据格式,应该尽量使用JSON,避免使用XML。

13. 什么csrf攻击原理?如何解决?

简单来说就是: 你访问了信任网站A,然后A会用保存你的个人信息并返回给你的浏览器一个cookie,然后呢,在cookie的过期时间之内,你去访问了恶意网站B,它给你返回一些恶意请求代码,要求你去访问网站A,而你的浏览器在收到这个恶意请求之后,在你不知情的情况下,会带上保存在本地浏览器的cookie信息去访问网站A,然后网站A误以为是用户本身的操作,导致来自恶意网站C的攻击代码会被执:发邮件,发消息,修改你的密码,购物,转账,偷窥你的个人信息,导致私人信息泄漏和账户财产安全收到威胁

14. 启动Django服务的方法?

runserver 方法是调试 Django 时经常用到的运行方式,它使用 Django 自带的WSGI Server 运行,主要在测试和开发中使用,并且 runserver 开启的方式也是单进程 。

15. 怎样测试django框架中的代码?

在单元测试方面,Django继承 python 的 unittest.TestCase 实现了自己的

django.test.TestCase,编写测试用例通常从这里开始。测试代码通常位于app 的 tests.py 文件中(也可以在 models.py 中编写,一般不建议)。在Django 生成的 depotapp 中,已经包含了这个文件,并且其中包含了一个测试 用例的样例:

1. python manage.py test:执行所有的测试用例

2. python manage.py test app_name, 执行该 app 的所有测试用例

3. python manage.py test app_name.case_name: 执行指定的测试用例

- 1

- 2

- 3

一些测试工具:unittest 或者 pytest

16. 有过部署经验?用的什么技术?可以满足多少压力?

1.有部署经验,在阿里云服务器上部署的

2.技术有:nginx + uwsgi 的方式来部署 Django 项目

3.无标准答案(例:压力测试一两千)

17. Django中哪里用到了线程?哪里用到了协程?哪里用到了进程?

1.Django 中耗时的任务用一个进程或者线程来执行,比如发邮件,使用celery。

2.部署 django项目的时候,配置文件中设置了进程和协程的相关配置。

18. django关闭浏览器,怎样清除 cookies 和 session?

设置Cookie

1. def cookie_set(request):

2. response = HttpResponse("<h1>设置Cookie,请查看响应报文头</h1>")

3. response.set_cookie('h1', 'hello django')

4. return response

- 1

- 2

- 3

- 4

读取Cookie

1. def cookie_get(request):

2. response = HttpResponse("读取Cookie,数据如下:<br>")

3. if request.COOKIES.has_key('h1'):

4. response.write('<h1>' + request.COOKIES['h1'] + '</h1>')

5. return response

- 1

- 2

- 3

- 4

- 5

以键值对的格式写会话。

1. request.session['键']=值

- 1

根据键读取值。

1. request.session.get('键',默认值)

- 1

清除所有会话,在存储中删除值部分。

1. request.session.clear()

- 1

清除会话数据,在存储中删除会话的整条数据。

1. request.session.flush()

- 1

删除会话中的指定键及值,在存储中只删除某个键及对应的值。

1. del request.session['键']

- 1

设置会话的超时时间,如果没有指定过期时间则两个星期后过期。

如果value是一个整数,会话将在value秒没有活动后过期。

如果value为0,那么用户会话的Cookie将在用户的浏览器关闭时过期。

如果value为None,那么会话在两周后过期。

1. request.session.set_expiry(value)

- 1

Session 依赖于 Cookie,如果浏览器不能保存 cookie 那么 session 就失效了。因为它需要浏览器的 cookie 值去 session 里做对比。session就是用来在服务器端保存用户的会话状态。

cookie 可以有过期时间,这样浏览器就知道什么时候可以删除 cookie了。 如果 cookie 没有设置过期时间,当用户关闭浏览器的时候,cookie 就自动过期了。你可以改变 SESSION_EXPIRE_AT_BROWSER_CLOSE 的设置来控制session 框架的这一行为。缺省情况下, SESSION_EXPIRE_AT_BROWSER_CLOSE设置为 False ,这样,会话 cookie 可以在用户浏览器中保持有效达SESSION_COOKIE_AGE 秒(缺省设置是两周,即 1,209,600 秒)如果你不想用户每次打开浏览器都必须重新登陆的话,用这个参数来帮你。如果SESSION_EXPIRE_AT_BROWSER_CLOSE

设置为 True,当浏览器关闭时,Django 会使 cookie 失效。

SESSION_COOKIE_AGE:设置 cookie 在浏览器中存活的时间。

19. 有用过Django REST framework 吗?

面试就喜欢面试官问这种问题,前面就已经说过了,这种问题一提出来,我们内心是高兴的一笔的,正好将我们学的Django restframework源码带面试官走一波,之后可以再补充一点Django的其他源码,比如ORM源码,settings源码,

admin源码…最后一定要记住,你要展示出你不仅阅读过源码还基于源码在自己的实际项目中参考借鉴过。如果把面试比作考试题满分100的话,这一题就是送分的30分大题!!!

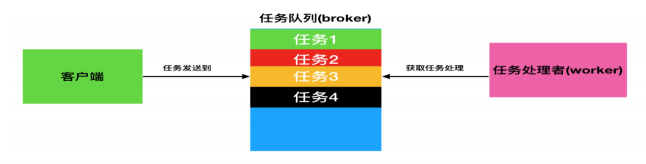

20. Celery分布式任务队列?

情景:用户发起request,并等待response返回。在本些views中,可能需要执行一段耗时的程序,那么用户就会等待很长时间,造成不好的用户体验,比如发送邮件、手机验证码等。 使用celery后,情况就不一样了。解决:将耗时的程序放到celery中执行。将多个耗时的任务添加到队列queue中,也就是用redis实现broker中间人,然后用多个worker去监听队列 里的任务去执行。

- 任务task:就是一个Python函数。

- 队列queue:将需要执行的任务加入到队列中。

- 工人worker:在一个新进程中,负责执行队列中的任务。

- 代理人broker:负责调度,在布置环境中使用redis。

正向代理:请求经过代理服务器从局域网发出,然后到达互联网上的服务器。

特点:服务端并不知道真正的客户端是谁。

反向代理:请求从互联网发出,先进入代理服务器,再转发给局域网内的服务器。

特点:客户端并不知道真正的服务端是谁。

区别:正向代理的对象是客户端。反向代理的对象是服务端。

21. 简述Django下的(内建的)缓存机制?

Django提供6种缓存方式:

开发调试

内存

文件

数据库

Memcache缓存(python-memcached模块)

Memcache缓存(pylibmc模块)

除此之外还可使用redis缓存

由于Django是动态网站,所有每次请求均会去数据进行相应的操作,当程序访问量大时,耗时必然会更加明显,

最简单解决方式是使用:缓存,缓存将一个某个views的返回值保存至内存或者memcache中,5分钟内(默认配置)再有人来访问时,

则不再去执行view中的操作,而是直接从内存或者Redis中之前缓存的内容拿到,并返回。

这里可以向面试官介绍一下前面提到的Django中间件配合缓存协同工作的机制

22. 对cookie与session的了解?他们能单独用吗?

首先需要搞清楚的是session是存储在服务器上的,cookie是存储在客户端浏览器上的两者是相辅相成的用户首次访问服务器,服务器会为每个用户单独创建一个session对象(HttpSession),

并为每个session分配唯一一个id(sessionId),sessionId通过cookie保存到用户端,当用户再次访问服务器时,需将对应的sessionId携带给服务器,服务器通过这个唯一sessionId就可以找到用户对应的session对象,从而达到管理用户状态

23. Django里QuerySet的get和filter方法的区别?

1) 输入参数

get 的参数只能是model中定义的那些字段,只支持严格匹配。

filter的参数可以是字段,也可以是扩展的 where查询关键字,如 in,like 等。

2) 返回值

get返回值是一个定义的 model 对象。

filter返回值是一个新的 QuerySet 对象,然后可以对 QuerySet 在进行查询返回新的 QuerySet 对象,支持链式操作,QuerySet 一个集合对象,可使用迭代或者遍历,切片等,但是不等于 list 类型(使用一定要注意)。

3) 异常

get只有一条记录返回的时候才正常,也就说明 get 的查询字段必须是主键或者唯一约束的字段。当返回多条记录或者是没有找到记录的时候都会抛出异常。 filter 有没有匹配的记录都可以

24. django 中当一个用户登录 A 应用服务器(进入登录状态),然后下次请求被 nginx 代理到 B 应用服务器会出现什么影响?

如果用户在A应用服务器登陆的session数据没有共享到B应用服务器,那么之前的登录状态就没有了。

1.安装django-cors-headers,之后在settings.py中配置

pip install django-cors-headers

- 1

INSTALLED_APPS = [ ... 'corsheaders', ... ] MIDDLEWARE_CLASSES = ( ... 'corsheaders.middleware.CorsMiddleware', 'django.middleware.common.CommonMiddleware', # 注意顺序 ... ) #跨域增加忽略 CORS_ALLOW_CREDENTIALS = True CORS_ORIGIN_ALLOW_ALL = True CORS_ORIGIN_WHITELIST = ( '*' ) CORS_ALLOW_METHODS = ( 'DELETE', 'GET', 'OPTIONS', 'PATCH', 'POST', 'PUT', 'VIEW', ) CORS_ALLOW_HEADERS = ( 'XMLHttpRequest', 'X_FILENAME', 'accept-encoding', 'authorization', 'content-type', 'dnt', 'origin', 'user-agent', 'x-csrftoken', 'x-requested-with', 'Pragma', )

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

2.使用JSONP

使用Ajax获取json数据时,存在跨域的限制。不过,在Web页面上调用js的script脚本文件时却不受跨域的影响,JSONP就是利用这个来实现跨域的传输。因此,我们需要将Ajax调用中的dataType从JSON改为JSONP(相应的API也需要支持JSONP)格式。

JSONP只能用于GET请求。

3.直接修改Django中的views.py文件

修改views.py中对应API的实现函数,允许其他域通过Ajax请求数据:

def myview(_request):

response = HttpResponse(json.dumps({“key”: “value”, “key2”: “value”}))

response[“Access-Control-Allow-Origin”] = “*”

response[“Access-Control-Allow-Methods”] = “POST, GET, OPTIONS”

response[“Access-Control-Max-Age”] = “1000”

response[“Access-Control-Allow-Headers”] = “*”

return response

- 1

- 2

- 3

- 4

- 5

- 6

- 7

26. Django对数据查询结果排序怎么做,降序怎么做,查询大于某个字段怎么做?

- 排序使用order_by()

- 降序需要在排序字段名前加-

- 查询字段大于某个值:使用filter(字段名_gt=值)

更多骚操作:https://www.cnblogs.com/Dominic-Ji/p/9209341.html

27. 生成迁移文件和执行迁移文件的命令是什么?(2018-4-16-lxy)

python manage.py makemigrations

python manage.py migrate

- 1

- 2

28.uWSGI与uwsgi区别

uWSGI是一个 Web 服务器,它实现了WSGI 协议、uwsgi、http 等协议。注意 uwsgi 是一种通信协议,而 uWSGI 是实现 uwsgi 协议和 WSGI 协议的Web 服务器。uWSGI 具有超快的性能、低内存占用和多app 管理等优点,并且搭配着 Nginx就是一个生产环境了,能够将用户访问请求与应用 app 隔离开,实现真正的部署。相比来讲,支持的并发量更高,方便管理多进程,发挥多核的优势,提升性能。

29. apache和nginx的区别?(2018-4-16-lxy)

Nginx相对Apache的优点:

轻量级,同样起web 服务,比apache 占用更少的内存及资源;

抗并发,nginx 处理请求是异步非阻塞的,支持更多的并发连接,而apache 则是阻塞型的,在高并发下nginx 能保持低资源低消耗高性能; 配置简洁; 高度模块化的设计,编写模块相对简单;

社区活跃。

Apache相对Nginx的优点:

rewrite ,比nginx 的rewrite 强大;

模块超多,基本想到的都可以找到;

少bug ,nginx 的bug 相对较多; 超稳定。

30. git 常用命令? (2018-4-23-lxy)

- git clone 克隆指定仓库

- git status 查看当前仓库状态

- git diff 比较版本的区别

- git log 查看 git 操作日志

- git reset 回溯历史版本

- git add 将文件添加到暂存区

- git commit 将文件提交到服务器

- git checkout 切换到指定分支

- git rm 删除指定文件

(命令好记,实际操作就相对较难,平时应有意识地去锻炼使用git管理我们的代码仓库)

31. 什么是gitlab,github和gitlab的区别?

**参考博客:**https://blog.csdn.net/zhang_oracle/article/details/77317717

32. git中 .gitignore文件的作用?

**参考博客:**https://www.cnblogs.com/kevingrace/p/5690241.html

33. HttpRequest和HttpResponse是什么?干嘛用的?

HttpRequest是django接受用户发送多来的请求报文后,将报文封装到HttpRequest对象中去。

HttpResponse 返回的是一个应答的数据报文。render内部已经封装好了HttpResponse类。

视图的第一个参数必须是HttpRequest对象,两点原因:表面上说,他是处理web请求的,所以必须是请求对象,根本上说,他是基于请求的一种web框架,所以,必须是请求对象。 因为view处理的是一个request对象,请求的所有属性我们都可以根据对象属性的查看方法来获取具体的信息:格式:request.属性

request.path 请求页面的路径,不包含域名

request.get_full_path 获取带参数的路径

request.method 页面的请求方式

request.GET GET 请求方式的数据

request.POST POST请求方式的数据

request.COOKIES 获取cookie

request.session 获取session

request.FILES 上传图片(请求页面有enctype="multipart/form-data"属性时FILES才有数据)

34. 什么是反向解析

使用场景:模板中的超链接,视图中的重定向

使用:在定义url时为include定义namespace属性,为url定义name属性

在模板中使用url标签:{% url ‘namespace_value:name_value’%}

在视图中使用reverse函数:redirect(reverse('namespce_value:name_value’))

根据正则表达式动态生成地址,减轻后期维护成本。

注意反向解析传参数,主要是在我们的反向解析的规则后面天界了两个参数,两个参数之间使用空格隔开:<a href="{% url ‘booktest:fan2’ 2 3 %}">位置参数</a>

###三.Tornado

1. Tornado的核是什么?

Tornado 的核心是 ioloop 和 iostream 这两个模块,前者提供了一个高效的 I/O 事件循环,后者则封装了 一个无阻塞的socket 。通过向 ioloop 中添加网络 I/O 事件,利用无阻塞的 socket ,再搭配相应的回调函数,便可达到梦寐以求的高效异步执行。

第六章 爬虫

一.常用库与模块

1. 试列出至少三种目前流行的大型数据库的名称:_、_、_, 其中您最熟悉的是_,从__年开始使用

(考察对数据可的熟悉程度,同时考察你的工作年限注意和自己简历一致)。Oracle,Mysql,SQLServer、MongoDB根据自己情况(推荐Mysql 、MongoDB)。

2. 列举您使用过的Python网络爬虫所用到的网络数据包?

requests、urllib、urllib2、httplib2。

3. 列举您使用过的Python网络爬虫所用到的解析数据包

Re、json、jsonpath、BeautifulSoup、pyquery、lxml。

4. 爬取数据后使用哪个数据库存储数据的,为什么?

MongoDB是使用比较多的数据库,这里以MongoDB为例,大家需要结合自己真实开发环境回答。

原因:

1)与关系型数据库相比,MongoDB的优点如下。

①弱一致性(最终一致),更能保证用户的访问速度

举例来说,在传统的关系型数据库中,一个COUNT类型的操作会锁定数据集,这样可以保证得到“当前”情况下的较精确值。这在某些情况下,例 如通过ATM 查看账户信息的时候很重要,但对于Wordnik来说,数据是不断更新和增长的,这种“较精确”的保证几乎没有任何意义,反而会产生很大的延 迟。他们需要的是一个“大约”的数字以及更快的处理速度。 但某些情况下MongoDB会锁住数据库。如果此时正有数百个请求,则它们会堆积起来,造成许多问题。我们使用了下面的优化方式来避免锁定。 每次更新前,我们会先查询记录。查询操作会将对象放入内存,于是更新则会尽可能的迅速。在主从部署方案中,从节点可以使用“-pretouch”参数运行,这也可以得到相同的效果。

使用多个mongod进程。我们根据访问模式将数据库拆分成多个进程。

②文档结构的存储方式,能够更便捷的获取数据。

对于一个层级式的数据结构来说,如果要将这样的数据使用扁平式的,表状的结构来保存数据,这无论是在查询还是获取数据时都十分困难。

③内置GridFS,支持大容量的存储。

GridFS是一个出色的分布式文件系统,可以支持海量的数据存储。内置了GridFS了MongoDB,能够满足对大数据集的快速范围查询。

④内置Sharding。