- 1怎么在navicat导入excel文件、csv文件、DBase文件...........?_navicat导入csv文件

- 2高可用的分布式Hadoop大数据平台搭建,超详细,附代码。_四、启动hadoop分布式环境. 写清楚步骤及截图。

- 3【华为OD机试真题 JS语言】432、 密码解密 | 机试真题+思路参考+代码解析(最新C卷抽中)(双代码)_华为c卷密码解密

- 4Linux权限管理_$uid -gt 199

- 5一款挺好看的南瓜影视APP下载页面_dl.keke1.app

- 6Elasticsearch 嵌套类型的深度剖析与实例_elastic search嵌套文档查询

- 7MySQL的触发器、索引和存储引擎

- 8【算法】【二叉树,DFS,哈希集合,分类讨论】力扣1110. 删点成林

- 9python PyQt5窗口运行vue项目记录_pyqt vue

- 10Qt实现简单的显示网页(QtWebkit、QtWebEngine、QAxWidget)_qt 显示网页

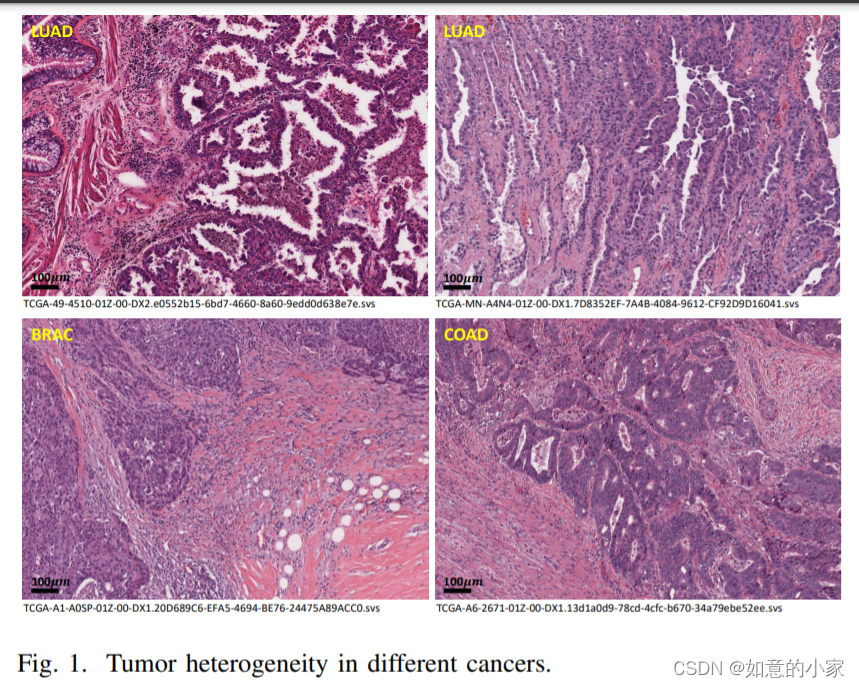

病理切片的相关文章总结_mulgt: multi-task graph-transformer with task-awar

赞

踩

1.数字病理学中的人工智能 — 用于诊断和精确肿瘤学的新工具

2.小样本学习研究综述(中科院计算所)

3.基于无监督组织分类的结直肠癌生存预测研究

4.常规组织病理学弱监督无标注癌检测与基因型预

5.肿瘤拓扑图+无监督深度学习

6.一种基于原型学习的多示例卷积神经网络

7Qualitative Histopathological Classification of Primary Bone Tumors Using Deep Learning: A Pilot Study

8.Vision transformer-based weakly supervised histopathological image analysis of primary brain tumors

9.MulGT: Multi-Task Graph-Transformer with Task-Aware Knowledge Injection and Domain Knowledge-Driven Pooling for Whole Slide Image Analysis

10.Weakly supervised tumor detection in whole slide image analysis

注意:弱监督学习在大数据集上的泛化性能要好于全监督学习在小数据集上的泛化性能

11.openslide与DeepZoomGenerator的使用方法介绍视频

12.Weakly-supervised, large-scale computational pathology for diagnosis & prognosis | Max Lu

13.Supervision and Source Domain Impact on Representation Learning:A Histopathology Case Study

14.few-shot learning(还挺不错,很好理解)

15.CAD: Co-Adapting Discriminative Features for Improved Few-Shot Classification【代码】

18.Multiple Instance Learning with Center Embeddings for Histopathology Classification【代码】

19.基于元学习框架的医学图像分类算法研究

20.数字病理学中的人工智能 — 用于诊断和精确肿瘤学的新工具

Artificial intelligence in digital pathology-new tools for diagnosis and precision oncology.

21.Pathologist-level Interpretable Whole-slide Cancer Diagnosis with Deep Learning【数据链接】

22.scaling vision transformers to gigapixel images via hierarchical self-supervised training

23.Gene Expression Profiling for Differential Diagnosis of Liver Metastases: A Multicenter, Retrospective Cohort Study

【注】(基因表达谱的关联关系?)研究人员发现肿瘤在转移过程中,其转移灶的基因表达谱与其原发部位组织的基因表达谱更为相似,而与其转移部位组织的基因表达谱存在较大差异。

病理图片数据扩增的相关方法

1.augmentations for computational pathology

2.WSSS4LUAD: Grand Challenge on Weakly-supervised Tissue Semantic Segmentation for Lung Adenocarcinoma

博士论文

1.基于自监督深度学习的肿瘤全数字切片多分类算法设计

零样本学习

1.零样本学习(Zero-Shot Learning)简介与分类

Vision Language Pre-training

1.VLP (Vision Language Pre-training) 梳理

小样本学习

1.小样本学习概述

注:如果把小样本学习比作一个黑盒子,给这个黑盒子喂少量的数据,凭什么能让它表现得好呢?显然我们需要外力来帮助,这个外力就是“先验知识”。如果可以像人类一样使用先验知识,则可以在非常少的样本下获得很好的效果。

2.A survey on Few-shot Learning (小样本学习)

典型的应用场景:(1).像人类一样一样去学习。(2).处理稀少的样例。(3).减少数据的收集工作量和计算成本。

prompt funing

1.Prompt-Tuning——深度解读一种新的微调范式

在大多数的下游任务微调时,下游任务的目标与预训练的目标差距过大导致提升效果不明显,微调过程中依赖大量的监督语料等。至此,以GPT-3、PET为首提出一种基于预训练语言模型的新的微调范式——Prompt-Tuning,其旨在通过添加模板的方法来避免引入额外的参数,从而让语言模型可以在小样本(Few-shot)或零样本(Zero-shot)场景下达到理想的效果。Prompt-Tuning又可以称为Prompt、Prompting、Prompt-based Fine-tuning等。

MSI预测

1.A deep learning model to predict RNA-Seq expression of tumours from whole slide images

CAMELYON16

处理流程

小样本数据集合

Omniglot:由来自50种不同语言的1,623个手写字符构成的,每个字符都有20个不同的笔迹,这就构成了一个样本类别极多(1623种),但每种类别的样本数量极少(20个)的小样本手写字符数据集。使用中通常选择1200种字符作为训练集,剩余的423种字符作为验证集,并通过旋转90°,180°和270°进行数据集扩张,每张图片通过裁剪将尺寸统一为28*28。

少样本+弱监督+病理分类问题

1.Few_shot_weakly_supervised_detection_and_retrieval_in_histopathology_whole_slide_images

【会议口头报告】