- 1pycorrector训练自己的模型,pycharm如何训练模型

- 2华为ensp中ospf多区域管理 原理及配置命令(详解)

- 3(java毕业设计源码)基于java(springboot)图书馆管理系统

- 4大语言模型(LLM)及使用方法_llm模型

- 5【调剂】燕山大学电气工程学院杜义浩接收调剂研究生

- 6字节跳动 2024 校招研发提前批启动!免笔试!免笔试!!!_字节跳动校招官网2024

- 7新闻速递 I MobTech首席数据官杨冠军受CSDN之邀,探索企业数字化转型最佳路径

- 8Linux版本选择建议

- 9Cannot allocate memory 的分析及解决方法

- 10多输入多输出(MIMO)毫米波雷达FMCW的MATLAB实现_相参mimo雷达信号模型matlab实现

对线性回归的学习与总结_线性回归算法 收获体会

赞

踩

回归分析是指一种预测性的建模技术,主要是研究自变量和因变量的关系。通常使用线/曲线来拟合数据点,然后研究如何使曲线到数据点的距离差异最小。

线性回归:

- 假设目标值(因变量)与特征值(自变量)之间线性相关。

- 然后构建损失函数。

- 最后通过令损失函数最小来确定参数。(最关键的一步)

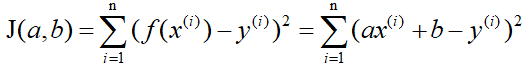

在回归问题中,均方误差是回归任务中最常用的性能度量。记J(a,b)为f(x)和y之间的差异,即

这里称J(a,b)为损失函数,明显可以看出它是个二次函数,即凸函数(这里的凸函数对应中文教材的凹函数),所以有最小值。当J(a,b)取最小值的时候,f(x)和y的差异最小,然后我们可以通过J(a,b)取最小值来确定a和b的值。

确定a和b的值的三种方法:

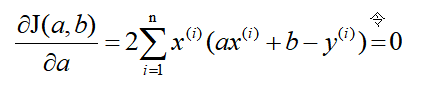

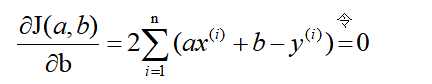

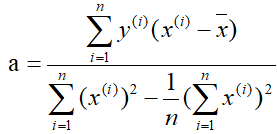

1.最小二乘法:

- 既然损失函数J(a,b)是凸函数,那么分别关于a和b对J(a,b)求偏导,并令其为零解出a和b。这里直接给出结果:

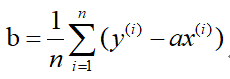

解得:

2.梯度下降法:

梯度的本意是一个向量(矢量),表示某一函数(该函数一般是二元及以上的)在该点处的方向导数沿着该方向取得最大值,即函数在该点处沿着该方向(此梯度的方向)变化最快,变化率最大(为该梯度的模)。

当函数是一元函数时,梯度就是导数。

在梯度下降法中,需要我们先给参数a赋一个预设值,然后再一点一点的修改a,直到J(a)取最小值时,确定a的值。下面直接给出梯度下降法的公式(其中α为正数):

总结下,不同的步长η ,随着迭代次数的增加,会导致被优化函数f(x) 的值有不同的变化:

f(x) 往上走(红线),自然是η 过大,需要调低。

f(x)一开始下降的特别急,然后就几乎没有变化(棕线),可能η 较大,需要调低。

f(x)几乎线性变化(蓝线),可能是η 较小,需要调大。

3.正规方程:

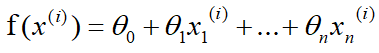

同样,假设有n组数据,其中目标值(因变量)与特征值(自变量)之间的关系为:

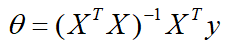

正规方程的公式:

总结:

1.梯度下降法是通用的,包括更为复杂的逻辑回归算法中也可以使用,但是对于较小的数据量来说它的速度并没有优势。

2.正规方程的速度往往更快,但是当数量级达到一定的时候,还是梯度下降法更快,因为正规方程中需要对矩阵求逆,而求逆的时间复杂的是n的3次方。

3.最小二乘法一般比较少用,虽然它的思想比较简单,在计算过程中需要对损失函数求导并令其为0,从而解出系数θ。但是对于计算机来说很难实现,所以一般不使用最小二乘法。