热门标签

热门文章

- 1【python深度学习】——torch.einsum|torch.bmm

- 2OSPF/IS-IS RFC历史版本集合_rfc 5340

- 3VMware17 虚拟机下载以及配置 一条龙全教程_vm17

- 4opencv——实战(一)_opencv测试用图片

- 5python的常见矩阵除法_Python矩阵除法

- 6使用uniapp内置组件checkbox-group所遇到的问题_uniapp 中checkbox发生改变事件?

- 7工作流程引擎之flowable(集成springboot)_flowable流程引擎

- 8人工智能_大模型032_LangChain002_从文件加载prompt_输出封装OutputParser_加载PDF等文档_向量数据库与向量检索---人工智能工作笔记0167

- 9安卓开发学习15-3:消息、通知和广播:AlarmManager闹钟设置_android闹钟是广播还是通知

- 10python拟合函数_python拟合函数

当前位置: article > 正文

Ollama配置webui连接大预言模型_ollama ui

作者:IT小白 | 2024-06-09 06:30:34

赞

踩

ollama ui

Ollama配置Web UI连接大预言模型

默认ollama安装后,chat对话只有命令行界面,交互体验较差。借助open-webui可以通过web界面连接ollama,从而实现类似chatgpt式的web交互体验。

使用家用PC实践记录如下:

1. 环境配置

本次使用的操作系统及硬件信息如下:

- 操作系统:windows11 23H2

- CPU: intel i7-12700

- MEM: 16GB

- GPU: NVIDIA GeForce GTX 1650

- Disk: 512GB SSD

- Docker:25.0.3

2. 安装Ollama

-

macOS: Download

-

Windows: Download

-

Linux

一键命令安装:

curl -fsSL https://ollama.com/install.sh | sh -

Docker: Ollama Docker image

3. 安装 Ollama WebUI

运行以下 docker 命令以在本地计算机上部署 llama-webui docker 容器:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

24224b4e9772 ghcr.io/open-webui/open-webui:main "bash start.sh" 15 seconds ago Up 10 seconds 0.0.0.0:3000->8080/tcp open-webui

- 1

- 2

- 3

- 4

- 5

要连接到另外一台机器上的 Ollama,请将 OLLAMA_BASE_URL 更改为对应的URL:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 1

注意:

使用 Docker 安装 Open WebUI 时,请确保在 Docker 命令中包含 -v open-webui:/app/backend/data,用于保存数据。

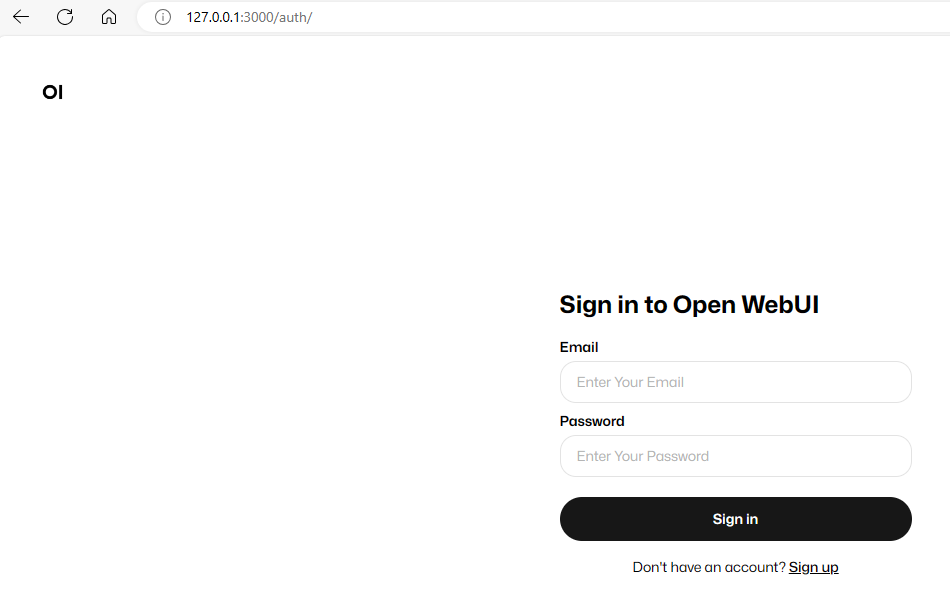

4. 登录打开WebUI

安装完成后,您可以通过http://localhost:3000 访问OpenWebUI。首次登录需要进行注册:

5. 从 ollama library下载模型

-

使用使用命令行下载模型,例如下载llama3:

ollama pull llama3 -

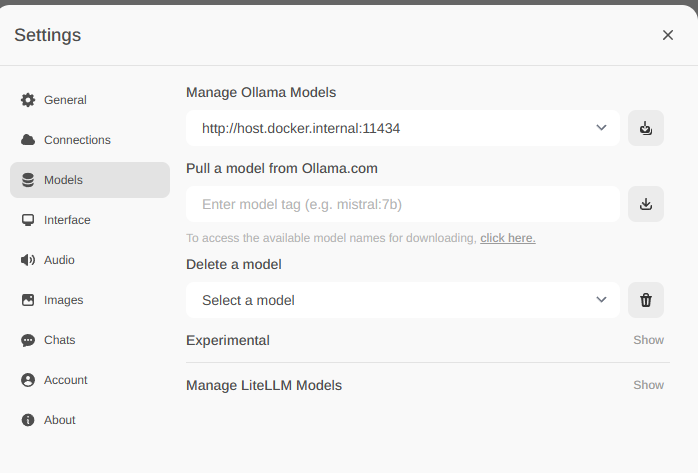

通过openwebUI下载

点击右上角设置图标,打开设置窗口,如下图,输入型号标签(如llama2:7b, gemma:2b),点击右侧下载按钮,等待型号待下载。

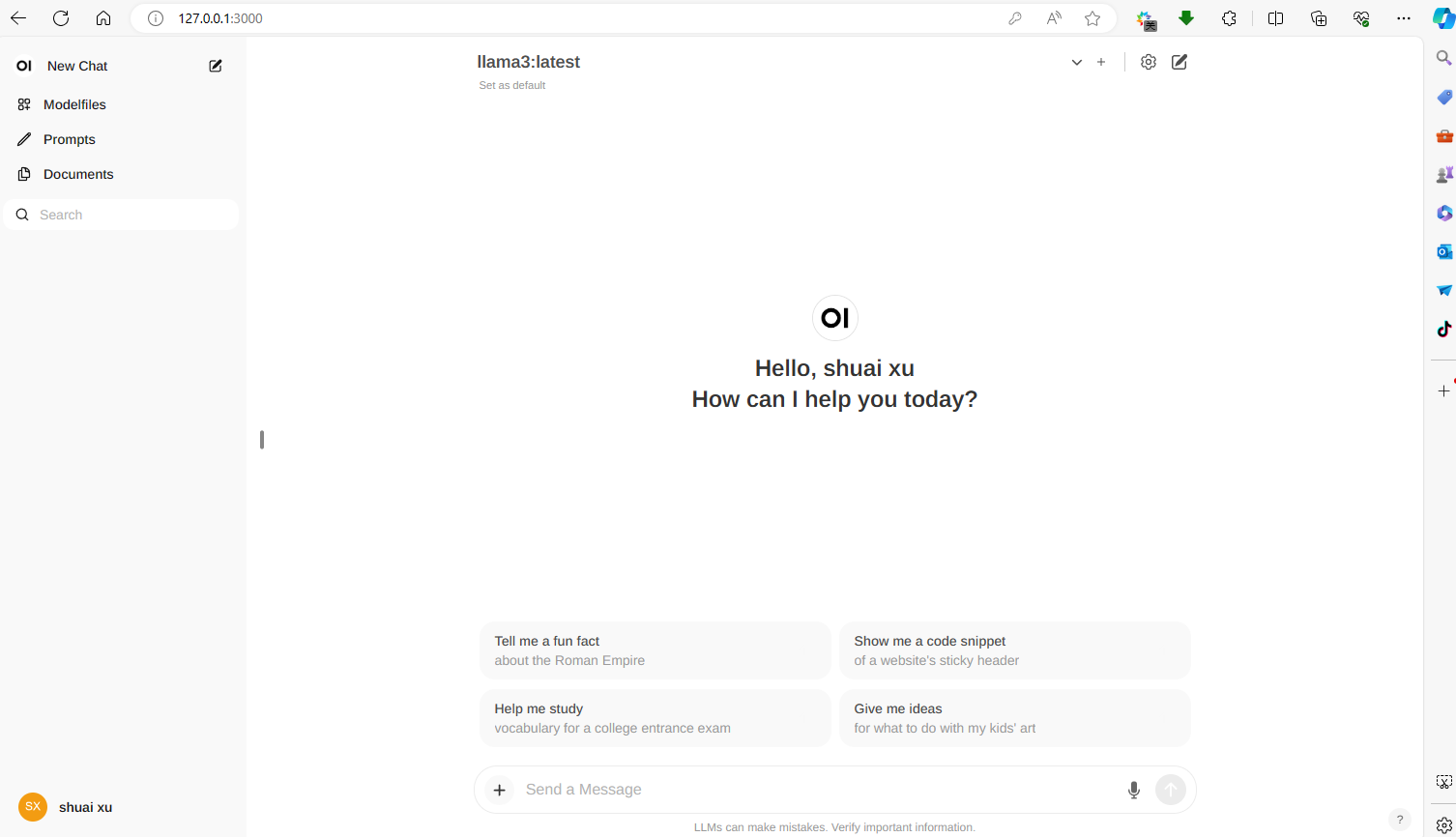

6. 选择模型进行chat

选择model即可进行chat对话。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/692974?site

推荐阅读

相关标签