热门标签

热门文章

- 1zookeeper总有节点启动失败_xshell开启zookeeper其余结点打不开

- 2使用objdump objcopy查看与修改符号表_objdump 可执行文件 符号

- 3Spring Boot Jpa 的使用(转载)_springboot jpa使用getconnection

- 4华为薪资等级结构表_2020年华为工资等级对照表

- 5利用java filter 实现业务异常拦截 跳转到错误信息提示页面_拦截器过滤error页面

- 6初步探索GraalVM--云原生时代JVM黑科技_graalvm 动态生成字节码

- 7算法5分钟|如何实现整数的数字反转【首尾交换法】_数字翻转算法

- 8openGauss学习笔记-133 openGauss 数据库运维-例行维护-日维护检查项_opengauss数据库怎么查看锁

- 9阿里云服务器镜像怎么选?操作系统版本选择说明_服务器操作系统选什么知乎

- 10深入浅出 Java 虚拟机 · 通往高级 Java 开发的必经之路_java虚拟机定义

当前位置: article > 正文

Relu简介

作者:IT小白 | 2024-02-10 19:02:07

赞

踩

relu

Relu

Relu(Linear rectification function)是深度学习中的一种激活函数

其函数表达式为:

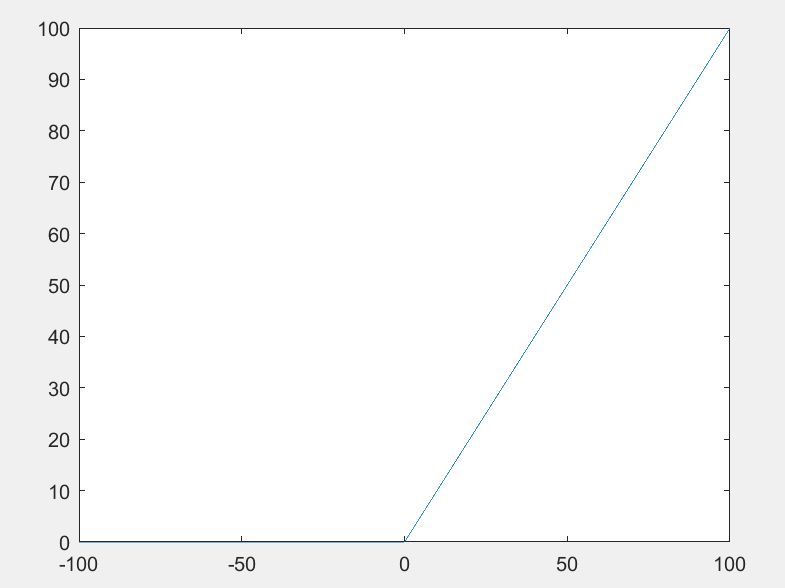

其函数图像为:

该函数主要用于cnn卷积神经网络的卷积(Convolution)和池化(MaxPooling)中,因为经过卷积运算和池化运算后的图像矩阵的值有正有负,这难免造成了数据规模变得很大,那么经过Relu函数之后的图像矩阵中的值只留下正数的值。

优点:

1.极大地减少了数据量

2.在一定程度上减少了运算量

3.避免层数增加。

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】

推荐阅读

相关标签