热门标签

热门文章

- 1Python第8章作业_python中把一个目录下所有的文件删除,在所有的目录下新建一个a.txt的文件,并在文

- 2python3 实现读写文件(xlsx文件/ini文件/json文件/yaml文件),代码已封装更新_python pandas 读取ini

- 3Github 错误合集:Failed connect to github.com:8080 || Failed connect to github.com:443; No error

- 4VS2010 切换到设计界面无响应的解决

- 5【机器学习】对抗生成网络

- 6库卡机器人Officelite运行EthernetKRL进行通讯

- 7spark总结

- 8TortoiseGit/TortoiseSVN差异查看器切换单/双区块模式,或使用外部对比工具_tortoisegit 双击文件,用beyond compare打开

- 9stm32 串口多字节接收

- 10mysql乘法函数_数据库入门(MySQL):mySQL运算符与mySQL常用函数

当前位置: article > 正文

第一篇博客,使用python爬虫爬取当当网数据存入数据库中_python爬虫数据库分类

作者:Li_阴宅 | 2024-07-14 14:20:44

赞

踩

python爬虫数据库分类

爬取当当网的图书信息

了解思路

话不多说首先咱先看看网站就就是这个样子

网站链接:http://search.dangdang.com/?key=python&act=input&page_index=1

第一步:首先获取到整个网页的源码。

第二步:使用lxml模块获取到需要爬取的信息。

第三步:导入数据库模块pymysql(因为我用的是python3版本的所以是这个,如果你是python2就导入mysqldb模块,之后写入数据库中。

第一步

先把网页代码拿下来,如果被识别就往header里面添加cookie等,因为我观察网站key的值就是查找的图书,所以定义了一个变量a,方便输入要查询的书籍,page_index网站默认是1就是第一页,可以使用range方法输出9页,可以先获取一页的信息看看是否成功,别忘了导入request。

a = input('请输入你想要查找的书籍:')

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:69.0) Gecko/20100101 Firefox/69.0'}

for i in range(1, 10):

url = 'http://search.dangdang.com/?key='+str(a)+'&act=input&page_index=' + str(i)

response = requests.get(url, headers=headers)

text = response.text

html = etree.HTML(text)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

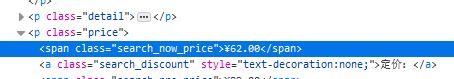

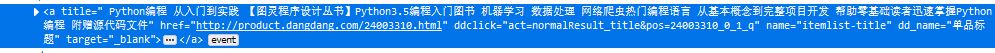

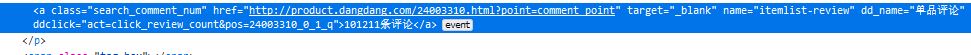

第二步:

查看自己所需要爬取的数据

html = etree.HTML(text)

quan = html.xpath('//ul[@class="bigimg"]/li')

for x in quan:

name = x.xpath('.//p[@name="title"]/a/@title')

href = x.xpath('.//p[@name="title"]/a/@href')

money = x.xpath('.//span[@class="search_now_price"]/text()')

comment = x.xpath('.//a[@name="itemlist-review"]/text()')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

这样就都可以获取了,注意别忘了导入lxml模块

第三步:

先导入数据库模块pymysql,之后链接数据库,使用insert into 表名字(列名…)values(name…),具体的数据库命令参照:MySQL操作命令

conn = pymysql.connect('127.0.0.1','root','123456','dd',charset='utf8')

cur = conn.cursor()

for a in range(len(name)):

print(name[a])

sql = 'insert into dd(title,link,money,comment) VALUES("%s","%s","%s","%s")'

cur.execute(sql % (name[a],href[a],money[a],comment[a]))

cur.close()

conn.commit()

conn.close()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

最后执行一下,别忘了,数据库要新建数据库名为dd,表名为dd,里面列名都设置charvar,不然就会报错。这样看好像金额跟评论有点不好看,可以使用正则表达式的re.sub替换就好了。

总结:第一次写博客,可能排版不太好看,请多指教。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Li_阴宅/article/detail/825051

推荐阅读

相关标签