- 1软件测试最全面试题及答案整理(2023最新版)_软件测试面试题目100及最佳答案

- 2使用Python selenium爬虫领英数据,并进行AI岗位数据挖掘_requests领英爬虫

- 3python贝塞尔插值公式_斐波那契查找原理——附python和C++实现

- 4【pytorch】thread: [16,0,0] Assertion `t >= 0 && t < n_classes` failed

- 5基于Verilog 语言开发的FPGA密码锁工程。通过矩阵键盘输入按键值_verilog设计可视密码锁

- 6unraid下使用iyuu辅种_unraid iyuu

- 7Java项目:学生宿舍管理系统(java+SpringBoot+Mybaits+Vue+elementui+mysql)_java宿舍管理系统

- 8React基础学习-Day01

- 9价值 999!Apache CoC 大会门票免费送;ToT 大模型时间推理基准数据集上新

- 10cookie简介(前端)_前端cookie

CVPR上新 | 从新视角合成、视频编解码器、人体姿态估计,到文本布局分析,微软亚洲研究院精选论文

赞

踩

编者按:欢迎阅读“科研上新”栏目!“科研上新”汇聚了微软亚洲研究院最新的创新成果与科研动态。在这里,你可以快速浏览研究院的亮点资讯,保持对前沿领域的敏锐嗅觉,同时也能找到先进实用的开源工具。

本周,人工智能领域最具学术影响力的顶级会议之一,CVPR 大会在美国西雅图举办。因此,这期的“科研上新”为大家带来了四篇微软亚洲研究院入选 CVPR 2024 的精选论文解读,涉及领域涵盖新视角图像合成、3D 人体姿态估计、视频编解码器、文本布局分析等多个相关主题。

本期内容速览

01. CVPR 2024 Highlight论文CoPoNeRF:统一对应点估计、相机姿态估计和神经辐射场重建,实现端到端双视图新视角合成

02. DCVC-FM:基于特征调制的视频编解码器

03. MVGFormer:用于3D人体姿态估计的多视角几何Transformers

04. 文本分组适配器:将文本布局分析能力装配在任意文本检测器上

CoPoNeRF:统一对应点估计、相机姿态估计和神经辐射场重建,实现端到端双视图新视角合成 (CVPR 2024 Highlight论文)

论文链接:https://arxiv.org/abs/2312.07246

在使用相机拍摄的多张二维图像进行三维神经辐射场(NeRF)建模和新视角渲染的过程中,传统的处理流程往往将其细分为三个子任务:图像特征点匹配、相机姿态估计与神经辐射场建模,并为每个子任务设计不同的算法模块以实现该子任务的目标。然而,由于每个算法模块都是独立设计的,每个子任务可能会引入不同的偏差,这就导致整个流程存在潜在的不一致风险。尤其在拍摄图片数量有限、相机姿态变化较大的情况下,该流程往往会使得最终新视角渲染效果欠佳。

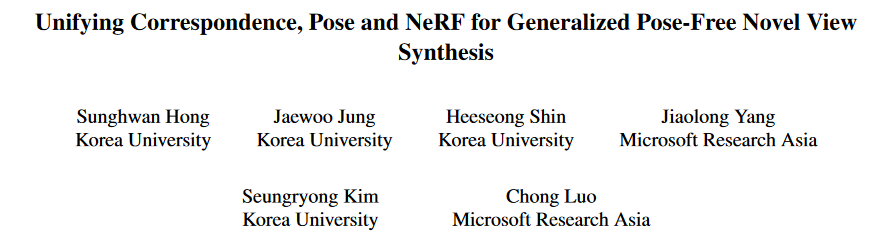

针对这一问题,微软亚洲研究院的研究员们认识到,三个子任务之间共同追求的核心目标是从二维图像数据中精确解释并重建三维几何,因此,它们间的统一性和协同性亟待加强。在仅有两幅图像作为输入的情况下,研究员们提出了一个名为 CoPoNeRF 的创新框架。该框架无缝整合了二维图像对应点匹配、相机相对姿态估计与神经辐射场渲染,并利用这个具有统一性的框架,增强了各子任务间的协同性。CoPoNeRF 框架的设计强调的是三个任务共享一个统一的表征,且整个框架采用端到端的方式进行训练,旨在提升子任务间的协同性和整体模型的精度。

研究员们在真实世界的两个多样化室内和室外场景数据集上,对 CoPoNeRF 框架进行了广泛的评估。实验结果表明,该方法相较于先前的方法取得了明显改进,特别是在两幅图像视点变化较大、相机姿态难以精确获得的情况下新视角渲染效果获得极大提高。

图1:给定两幅可能存在极端视点变化的图像,CoPoNeRF 框架可以端到端地协同执行三个任务(2D 对应点估计、相机姿态估计和神经辐射场渲染),从而实现高质量的新视角图像合成。

DCVC-FM:基于特征调制的视频编解码器

论文链接:https://arxiv.org/abs/2402.17414

项目链接:https://github.com/microsoft/DCVC

相较于常用的基于残差编码的视频编解码器,基于条件编码的模型展现出了巨大的潜力,并在这几年取得了显著的发展。但在其向实用化迈进的过程中,仍存在两个亟待解决的关键问题:1. 考虑到不同带宽和存储的需求,如何设计一个能够支持可变码率的单一模型,且该码率范围需要足够大;2. 视频编解码器通过挖掘时域相关性以减小视频冗余,但这往往容易导致时域上的误差传播。因此,如何避免该误差传播造成的重建质量衰减。针对这两个问题,研究员们通过设计特征调制技术,提出了相应的解决方案。

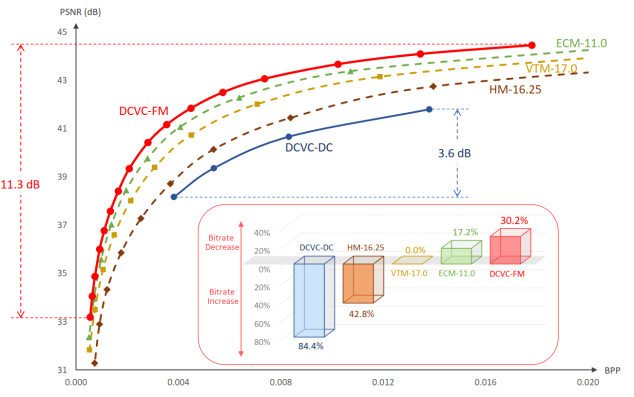

为了实现大范围的可变码率,研究员们提出使用可学习的量化缩放器来调整每帧的隐特征(如图2右图所示)。在训练的过程中,研究员们设计了一种均匀的量化参数采样机制,以使得编解码器应对不一样的率失真权衡。

图2:DCVC-FM 的主框架图(左)和帧编码框架图(右)

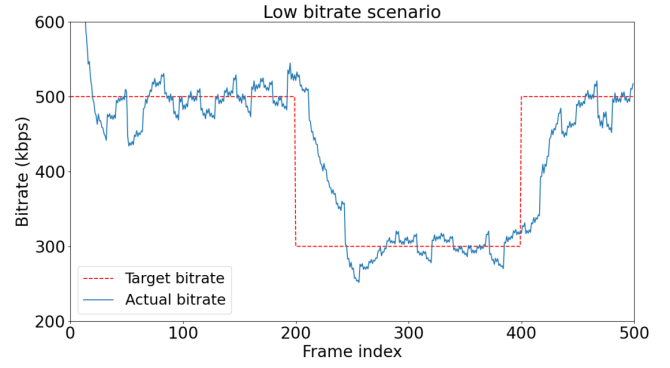

该训练机制可以帮助学习细粒度,并优化可调节的量化缩放器,从而能在一个很大的码率范围内,根据用户需求调节视频编码质量——可调的视频质量范围将从之前的3.8 dB增长到11.4 dB。另外,DCVC-FM 能够动态调节视频中的每帧质量,该功能也使得模型可以应对复杂易变的网络带宽环境,图3便展示了 DCVC-FM 在应对变化带宽方面的能力。

图3:码率控制示意

针对时域误差传播问题,已有的模型普遍采用频繁插入高质量帧内编码帧的方法来切断误差传播。尽管该方法可以有效遏制误差的扩散,但由于帧内编码的效率极低,整体的视频编码效率将显著降低。为此,研究员们设计了一种特征更新机制——当相邻帧的特征在时域传播时,研究员们将周期性地使用辅助性的特征提取器去调整并更新被传播的特征。这一机制使得 DCVC-FMDCVC-FM 在处理非常长的视频时仍能保持极高的压缩效率。如图4所示,DCVC-FM 在压缩性能方面已经超过了正在研发的下一代传统视频编码器标准的原型 ECM。

图4:压缩性能对比

MVGFormer:用于3D人体姿态估计的多视角几何Transformers

论文链接:https://arxiv.org/abs/2311.10983

项目链接:https://github.com/XunshanMan/MVGFormer

在计算机视觉和机器学习领域,3D 人体姿态估计是一项具有挑战性的任务,因为它要求算法能够从图像或视频中准确地预测出人体关节的 3D 空间位置。这项技术对于深入理解人类行为、增强现实、虚拟现实、游戏动画以及人机交互等领域具有重要的应用潜力。然而,现有的基于深度学习的方法在处理多视角数据时,常常面临遮挡问题和视角变化所带来的挑战,特别是在准确解析几何信息方面仍显不足。

尽管目前的研究已经通过使用神经网络,在 3D 人体姿态估计上取得了进步,但这些方法在多视角设置中,尤其是在训练阶段未遇到的新视角和环境条件下,其性能表现往往不尽如人意。此外,现有的基于 Transformers 的端到端学习方法虽然能够处理遮挡问题,但在新场景下的泛化性能往往较差。因此,如何在保持端到端学习优势的基础上,提升模型对于新视角和遮挡情况的泛化能力,是当前研究面临的关键课题。

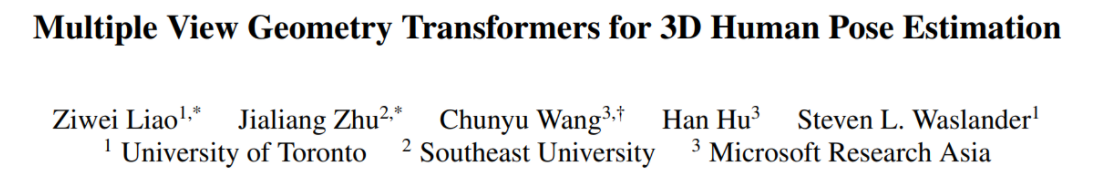

为了解决这个问题,研究员们提出了一种新的方法,其主要思想可以概括为以下三个部分:

1)混合模型设计:研究员们提出了一种新颖的混合模型 MVGFormer,该模型结合了几何模块和外观模块。几何模块负责处理所有与视角相关的 3D 任务,而外观模块则专注于从图像信号中估计 2D 姿态。

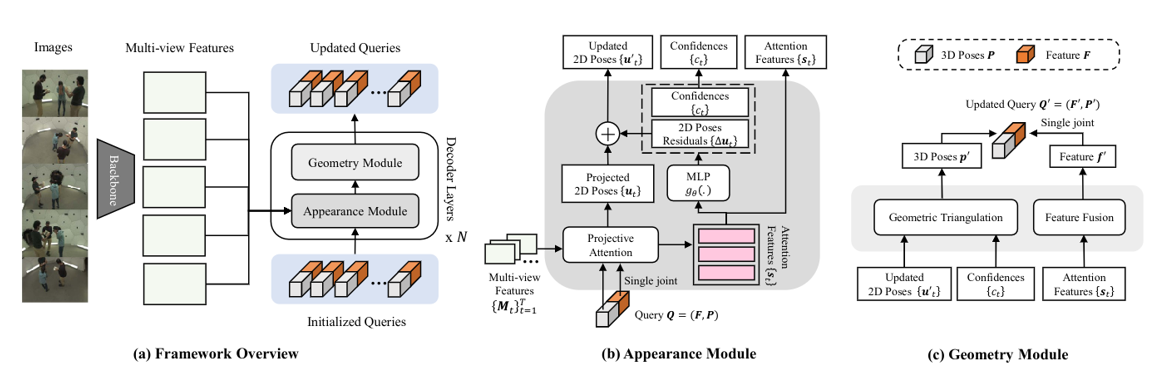

2)迭代细化过程:MVGFormer 通过迭代的方式,交替使用外观模块和几何模块来细化 2D 和 3D 姿态。外观模块基于图像特征预测2D姿态,几何模块利用三角测量法从 2D 姿态中恢复 3D 姿态。

3)端到端训练与评估:MVGFormer 支持端到端的训练,因此研究员们能通过一系列训练目标和损失函数来优化模型。在训练过程中,模型将学习如何准确地从一组初始化查询中重建 3D 人体姿态。

图5:MVGFormer 模型结构

实验结果表明,相较于目前领域内的前沿方法,MVGFormer 在多种测试条件下均展现出了卓越的性能,特别是在那些训练阶段未曾遇到的新视角下,其表现尤为突出。这一成就主要得益于 MVGFormer 强大的泛化能力,即便在全新的视角条件下,它仍能保持对 3D 人体姿态的高精度估计,对于需要在多种视角下理解和预测人体动作的应用场景具有重要意义。

图6:MVGFormer 将初始化查询恢复出 3D 人体姿态的过程

此外,MVGFormer 的框架还具有通用性,可以应用于其他关键点估计任务,如形状、手部和面部估计。未来,研究员们也可能会探索将该架构扩展到基于视频的系统中,以利用时间信息实现更稳健的追踪。

文本分组适配器:将文本布局分析能力装配在任意文本检测器上

论文链接:https://arxiv.org/abs/2405.07481

随着深度学习技术的发展,场景文本检测和识别领域已取得了重大进步。然而,如何将检测到的众多文本区域进行符合语义的分组并构建段落结构——场景文本布局分析问题,仍面临着诸多挑战。这些问题包括但不限于标注数据集缺乏、较难利用已有的文本检测器、缺少端到端模型等。

研究员们发现,场景文本布局分析的结果极大地依赖于文本检测的准确性,但现有的文本布局分析方法要求从头开始联合文本布局分析,与文本检测器进行联合训练,这种方法往往导致文本检测器训练不充分。

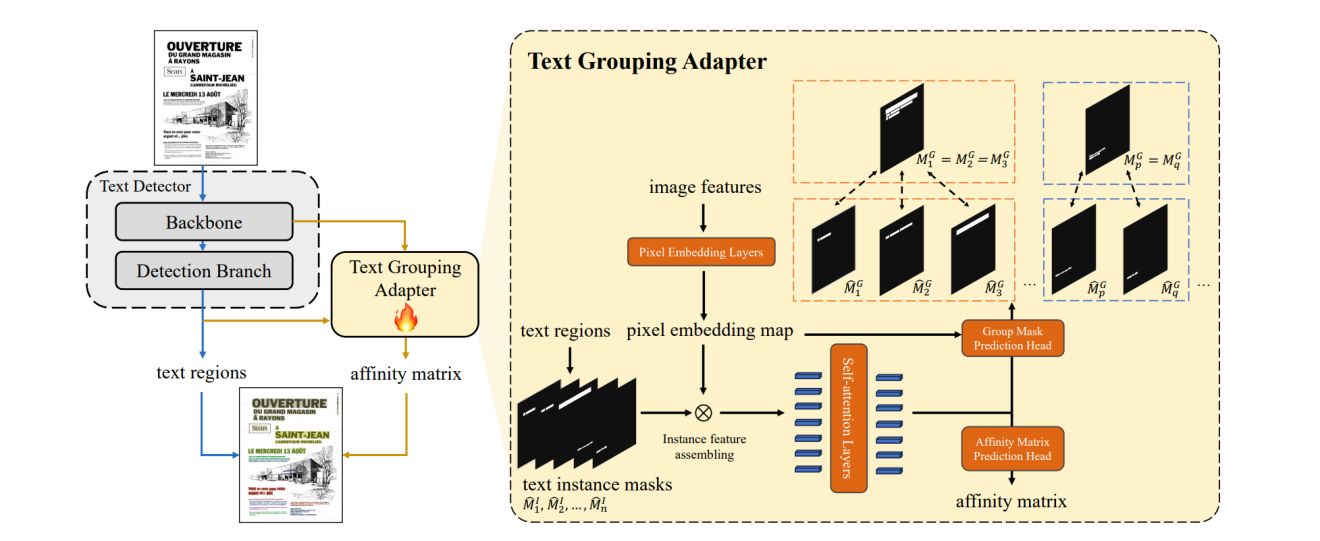

基于这一发现,研究员们利用在大量文本检测数据集上训练得到的预训练文本检测器,成功解决了因网络结构差异和输出格式不同所带来的挑战,并且让模型在冻结所有原有权重的情况下能够正常进行文本布局分析。最终,研究员们提出了通用的文本分组适配器(Text Grouping Adapter,TGA),显著提升了文本布局分析性能,并大幅加速了训练流程。

图7左图展示了装配了 TGA 的模型整体框架,其中原文本检测器模块可选择在训练过程中冻结所有权重。右图则展示了 TGA 的内部结构:首先,文本区域将被转化成实例掩码,从而得到文本实例特征;接着,预测文本组合掩码,确保属于同一组的文本实例具有相似的特征;最终,输出文本实例的关系矩阵,以此形成文本组合。

图7:装配有 TGA 的模型整体框架(左)和 TGA 内部结构(右)

具体而言,TGA 包括两个重要模块:文本区域特征组装模块(Text Instance Feature Assembling)和文本组合掩码预测模块(Group Mask Prediction)。文本区域特征组装模块主要把不同文本检测器的输出统一成为文本区域掩码的形式,并且通过掩码和图片像素嵌入来组装成文本区域特征,这些特征随后会被送入文本组合掩码预测模块以及最终的文本关系预测模块。而文本组合掩码预测模块则通过预测文本组合的共同掩码,确保属于同一文本组合的文本区域具有相似的特征,从而在文本实例的关系矩阵中预测出正确的关系。

实验结果表明,TGA 能与多种不同网络结构与输出格式的文本检测器兼容。此外,TGA 还能够与端到端文本识别模型(Text Spotting Model)结合使用,实现文本检测、文本识别以及文本布局分析结果的同步输出。通过冻结文本检测器,模型能在仅有之前工作13%的可训练参数的情况下,仍能够得到领先的文本检测和文本布局分析结果。研究员们针对 TGA 损失函数的一系列消融实验进一步表明,TGA 有效解决了正负样本不平衡的问题。

文本布局分析背后的核心问题在于,视觉模型如何准确判断视觉对象间的关系以及它们在场景中的拓扑结构。未来,研究员们将持续关注这一问题,并在 Windows UI 场景和自然图像分析方面进行更加深入的探索。