- 1基于Springboot+Vue实现的宿舍管理系统

- 2kettle实现拉链表_kettle 拉链表

- 3asp.net excel文件导出的七种方法(简述)_asp.net excel文件流导出

- 4管道符的工作原理_linux管道符原理

- 5HarmonyOS学习第二章:初识ArkTs/ArkUI,常用组件

- 6OpenStack部署(1)_控制节点和计算节点配置需要一样么

- 7Android项目混淆配置_# uncomment this to preserve the line number infor

- 8基于 Spring Boot 的小区物业综合服务系统的设计与实现_基于springboot的小区服务平台

- 9HBuilder h5+app 项目 安卓本地打包,集成个推推送_h5打包app 推送消息

- 10uniapp兼容问题一些经常出现的问题_低版本安卓系统与uni-app的兼容性

3d场景重建&图像渲染 | 神经辐射场NeRF(Neural Radiance Fields)_辐射场渲染

赞

踩

神经辐射场NeRF(Neural Radiance Fields)

概念

NeRF(Neural Radiance Fields,神经辐射场)是一种用于3D场景重建和图像渲染的深度学习方法。它由Ben Mildenhall等人在2020年的论文《NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis》中首次提出。NeRF通过学习场景的连续体积密度和颜色分布,能够从任意视角准确地渲染出高质量的3D场景图像。

工作原理(两部分)

1. 3D场景重建:NeRF通过分析一组从不同视角拍摄的2D图片,学习场景的连续体积密度和颜色分布。这一步骤不是生成一个传统意义上的3D模型文件,而是训练一个深度学习模型,这个模型能够根据输入的3D位置(x, y, z)和观察方向(θ, φ)来预测该位置的颜色(RGB值)和体积密度(σ)。这样,NeRF模型实际上学习到了整个场景的3D表示。

2. 图像渲染(特定视角):一旦3D场景被重建,就可以通过设置特定的摄像机参数(如位置、朝向和视角等)来从任意视角渲染2D图像。渲染过程模拟了光线从摄像机通过场景到达观察者眼睛的路径,通过计算沿这些路径的多个点的颜色和密度,然后综合这些信息来生成最终的像素颜色,从而形成完整的2D图像。

总结:NeRF模型通过深度神经网络学习场景的连续体积表示,并使用体积渲染技术从任意视角生成高质量的2D图像。

训练过程

NeRF的训练过程需要一组从不同视角拍摄的场景图片(多视角2d)图片作为输入。通过优化网络以最小化渲染图像和实际图像之间的差异,NeRF模型学习到的是整个场景的3D表示。这个过程需要大量的计算资源,因为它涉及到对每个训练图像的大量光线进行采样和渲染。

优点

这种方法的一个显著优点是能够从已有的2D图片中重建出高度逼真的3D场景,并且能够从场景中任意视角生成高质量的2D图像,这对于计算机视觉、增强现实(AR)、虚拟现实(VR)以及电影和游戏制作等领域具有重要的应用价值。

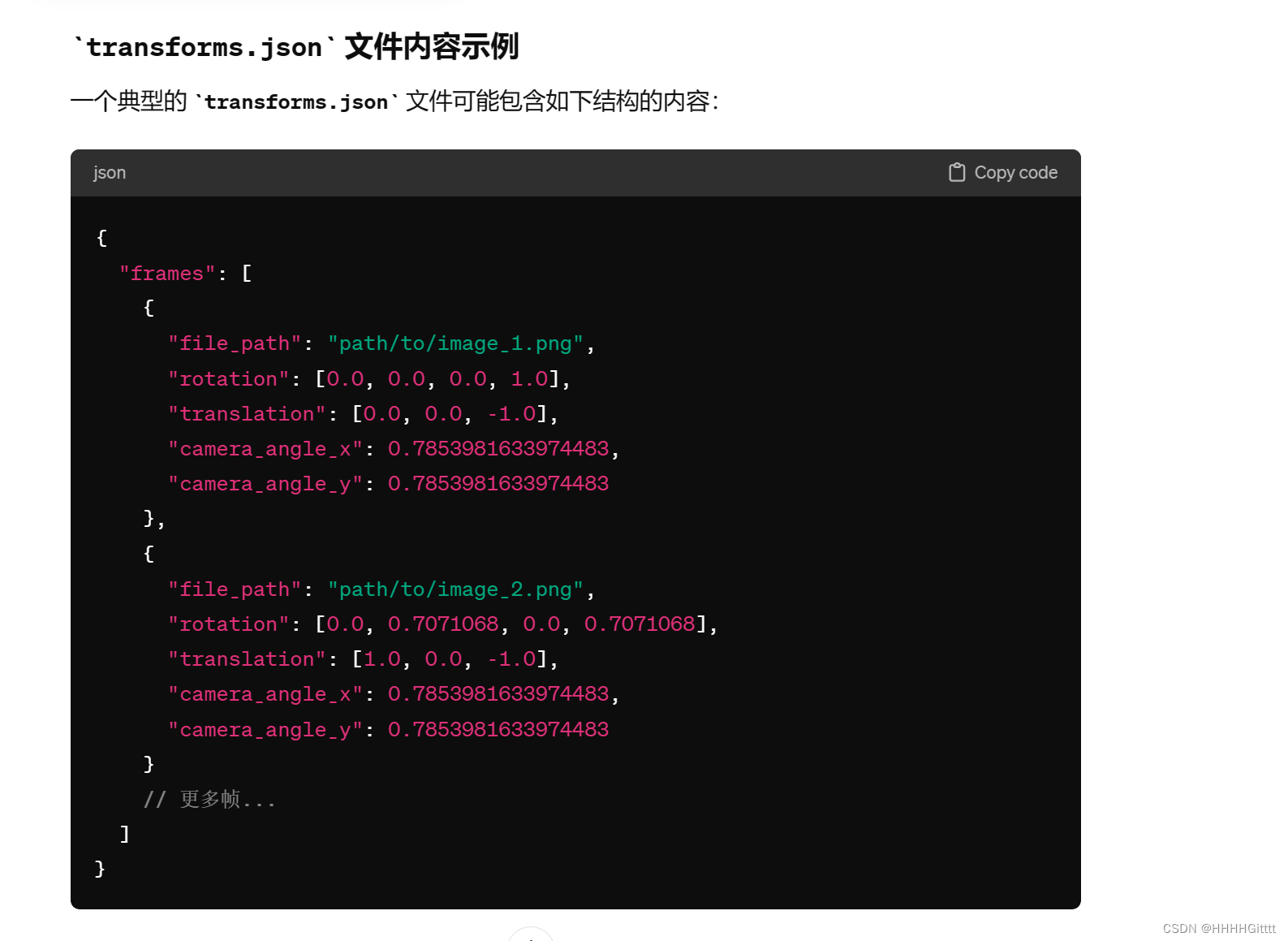

训练特定视角设置:`transforms.json`

`transforms.json` 文件在训练 NeRF(Neural Radiance Fields)模型时很重要。这个文件包含了用于训练的每个图像的摄像机参数,包括摄像机的位置、朝向(通常以四元数或旋转矩阵表示)、以及其他可能的元数据(如焦距、图像尺寸等)。这些信息对于NeRF模型来说至关重要,因为它们使得模型能够理解每个训练图像是从场景中的哪个视角拍摄的,从而学习场景的3D结构和外观。

在这个示例中,每个“frame”条目包含了一个图像的路径(`file_path`)、摄像机的旋转(`rotation`,这里使用四元数表示)、摄像机的平移(`translation`)、以及摄像机的视角(`camera_angle_x` 和 `camera_angle_y`)。这些参数共同定义了摄像机在3D空间中的位置和朝向,对于NeRF模型来说,这些信息是必需的,以便正确地从多个视角重建场景。

通过调整 `transforms.json` 改变输出图像

理论上,通过调整 `transforms.json` 文件中的内容,特别是摄像机的位置(`translation`)和朝向(`rotation`),你可以改变NeRF模型渲染输出图像的视角。这意味着,如果你想要从一个新的视角渲染场景,你可以手动修改或添加一个帧的信息,设置为你想要的摄像机位置和朝向,然后使用NeRF模型进行渲染。

然而,需要注意的是,`transforms.json` 文件主要用于训练过程中定义训练图像的摄像机参数。在训练完成后,如果要渲染新视角的图像,通常是通过在渲染过程中指定新的摄像机参数来实现,而不是直接修改 `transforms.json` 文件。修改 `transforms.json` 并重新训练模型更多地用于调整训练数据集,而不是用于控制渲染输出的视角。

NeRF模型

instant-ngp

Instant Neural Graphics Primitive,这是一个由NVIDIA研究团队开发的框架,旨在大幅提高神经辐射场(NeRF)的训练和渲染速度。Instant-ngp通过使用一种高效的数据结构(如哈希表)来存储和检索神经网络的参数,实现了对NeRF的快速训练和高效渲染。

Instant-ngp的关键特点包括:

-

快速训练和渲染:通过优化的数据结构和算法,instant-ngp能够在几分钟内训练NeRF模型,并实现实时渲染,这是传统NeRF方法无法比拟的。

-

高质量的视觉效果:尽管训练速度大大加快,instant-ngp仍能生成高质量的3D场景和对象渲染,保持了NeRF的视觉效果。

-

易于使用:NVIDIA提供了instant-ngp的开源实现,使研究人员和开发者能够轻松地在自己的项目中使用和扩展这一技术。

Instant-ngp对于3D视觉、虚拟现实、增强现实和游戏开发等领域具有重要的意义,它不仅提高了NeRF技术的可用性,也为未来的图形渲染和3D建模开辟了新的可能性。