热门标签

热门文章

- 1ViLBERT:视觉语言多模态预训练模型_视觉-语言多模态训练模型

- 2深度之眼Paper带读笔记NLP.11:FASTTEXT.Baseline.06_in this work, we explore ways to scale thesebaseli

- 3matlab accumarray_32个实用matlab编程技巧

- 4【科研新手指南2】「NLP+网安」相关顶级会议&期刊 投稿注意事项+会议等级+DDL+提交格式_ccs投稿须知文件

- 5spring-boog-测试打桩-Mockito_org.mockito.exceptions.base.mockitoexception: chec

- 6Git将当前分支暂存切换到其他分支_如何暂存修改切换分支git

- 7solidity实现智能合约教程(3)-空投合约

- 8上位机图像处理和嵌入式模块部署(qmacvisual寻找圆和寻找直线)

- 930天拿下Rust之错误处理

- 10基于springboot的在线招聘平台设计与实现 毕业设计开题报告_招聘app的设计与实现的选题背景怎么写

当前位置: article > 正文

梯度爆炸解决方案——梯度截断(gradient clip norm)_clip gradient norm

作者:Monodyee | 2024-03-25 17:45:05

赞

踩

clip gradient norm

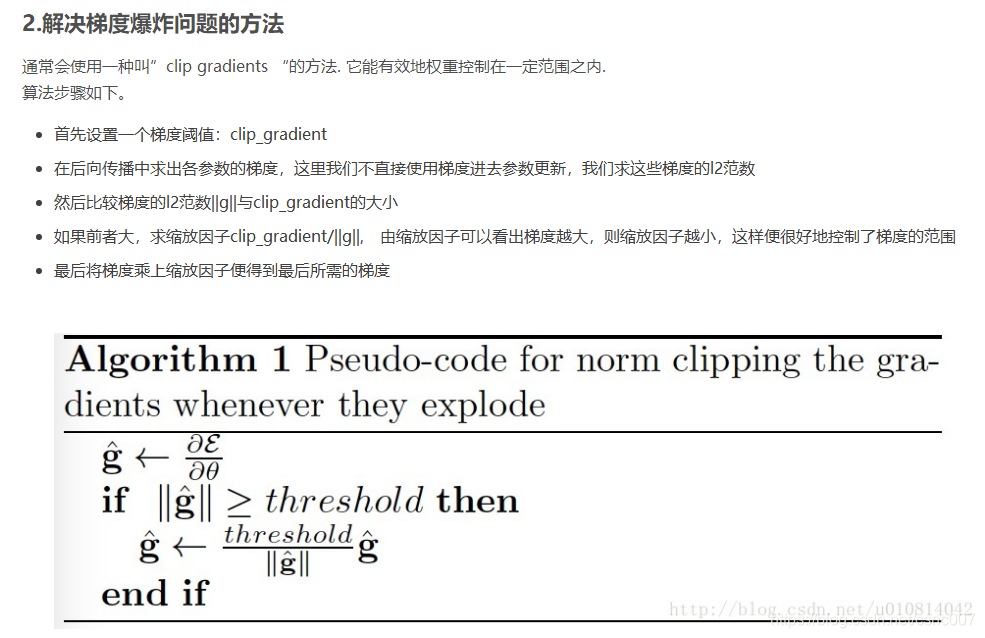

如果梯度超过阈值,那么就截断,将梯度变为阈值

from torch.nn.utils import clip_grad_norm

pytorch源码

默认为l2(norm type)范数,对网络所有参数求l2范数,和最大梯度阈值相比,如果clip_coef<1,范数大于阈值,则所有梯度值乘以系数。

使用:

- optimizer.zero_grad()

- loss, hidden = model(data, hidden, targets)

- loss.backward()

-

- torch.nn.utils.clip_grad_norm_(model.parameters(), args.clip)

- optimizer.step()

python - How to properly do gradient clipping in pytorch? - Stack Overflow https://stackoverflow.com/questions/54716377/how-to-properly-do-gradient-clipping-in-pytorch

但是,clip_grad_norm还不够狠,有时候失效,这个时候更狠的就出来了:

torch.nn.utils.clip_grad_value_(model.parameters(), number)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/311533

推荐阅读

相关标签