热门标签

热门文章

- 1AI助手,让创作更简单_汇语ai助手 csdn

- 2移动云助力智慧交通数智化升级_移动云在公交安全、出行、物流配送、停车监管等场景提供大链接算力支撑的应用案例

- 3深度学习与大语言模型的关系_增量学习和自适应学习与大语言模型有什么关系

- 4Java代码简洁-validation参数校验_java validation

- 5使用 LCM LoRA 4 步完成 SDXL 推理_lcm-lora画面质量偏暗

- 6天啦撸,联合开发网竟然倒闭了!!!(分享一个非常牛的人工智能教程!!!)_天撸啦

- 7字符串串动变化 (10 分)下列程序中,函数fun的功能是:在字符串str中找出ASCII码值最大的字符,将该字符前的所有字符向后顺序移动一个位置,然后将该字符放到第一个位置上。_如何在字符串中删去ascll码值最大的字符c语言

- 8安装 pytorch-geometric_install pytorch geometric dependencies:

- 9Opencv官方文档和学习资料

- 10Android 系统属性SystemProperty分析

当前位置: article > 正文

使用Keras进行深度学习:(七)GRU讲解及实践_keras gru

作者:Monodyee | 2024-04-01 07:10:58

赞

踩

keras gru

Ray

介绍GRU(Gated Recurrent Unit) 是由 Cho, et al. (2014) 提出,是LSTM的一种变体。GRU的结构与LSTM很相似,LSTM有三个门,而GRU只有两个门且没有细胞状态,简化了LSTM的结构。而且在许多情况下,GRU与LSTM有同样出色的结果。GRU有更少的参数,因此相对容易训练且过拟合问题要轻一点。

目录

- GRU****原理讲解

- Keras****实现GRU

一、GRU原理讲解

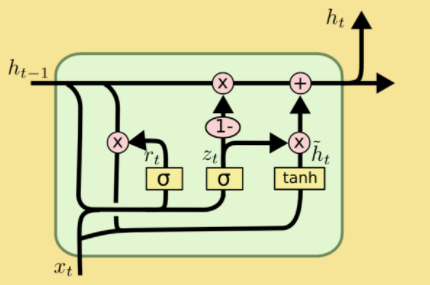

下图展示了GRU的网络结构,GRU的网络结构和LSTM的网络结构很相似,LSTM中含有三个门结构和细胞状态,而GRU只有两个门结构:更新门和重置门,分别为图中的z_t和r_t,结构上比LSTM简单。  将GRU网络结构具体运算操作用下图进行表示。接下来将会针对该图每一部分进行详细的讲解。

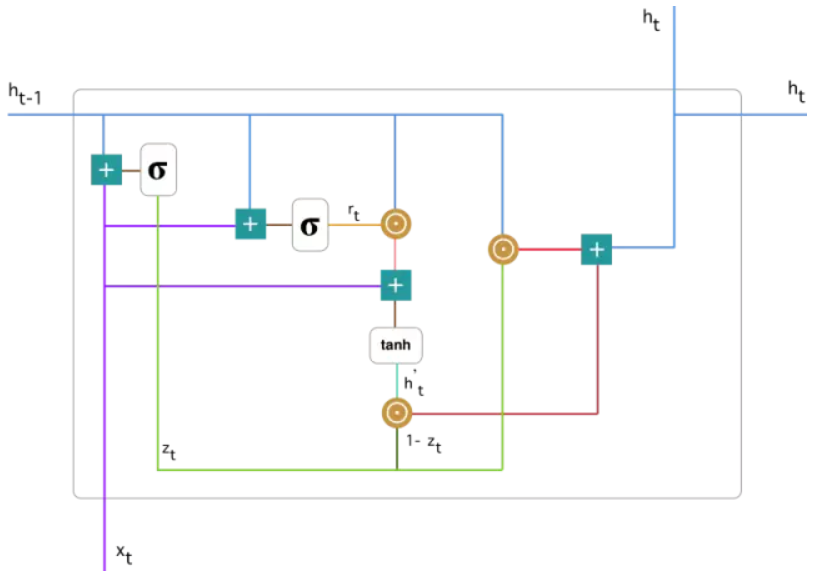

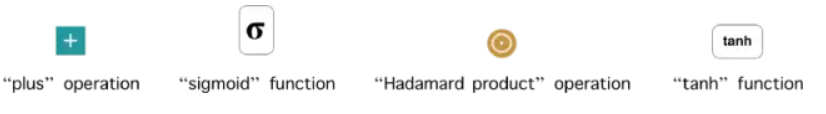

将GRU网络结构具体运算操作用下图进行表示。接下来将会针对该图每一部分进行详细的讲解。  首先说明图中每个符号的意义:

首先说明图中每个符号的意义:

1. 更新门(update gate):

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/347766

推荐阅读

相关标签