- 1如何自己的医疗图像分割数据集 使用NNunet进行训练_nnunet处理nii图像

- 2llama.cpp部署通义千问Qwen-14B_llama.cpp qwen

- 3轻松实现微信、QQ防撤回、多开工具_微信防撤回github

- 4napi系列学习基础篇——NAPI数据类型转换与同步调用

- 5用五一最简单的板做一个智能循迹小车_制作一个智能小车,前期有哪些检查工作

- 6干货:用好VSCode这13款插件,工作效率提升10倍_vscode design

- 7Sentence-Transformer的使用及fine-tune教程_distiluse-base-multilingual-cased

- 8一招解决从GItHub下载文件过慢问题_python下载github慢

- 9宇信科技:强势行业加速融入AIGC,同时做深做细

- 10用云手机运营TikTok有什么好处?

ELK 企业级日志分析系统

赞

踩

ELK 企业级日志分析系统

ELK 企业级日志分析系统是一个开源的日志管理解决方案,由三个核心组件组成:Elasticsearch、Logstash 和 Kibana。这三个组件共同工作,帮助用户收集、存储、搜索、分析和可视化日志数据。

- Elasticsearch:一个高度可扩展的开源全文搜索和分析引擎,用于存储和检索数据。Elasticsearch 基于 Lucene 构建,提供了一个分布式、支持多租户的全文搜索引擎,具有 HTTP Web 接口和无模式 JSON 文档。

- Logstash:一个服务器端数据处理管道,可以同时从多个来源采集数据,转换数据,然后将数据发送到诸如 Elasticsearch 等“存储”中。Logstash 具有丰富的插件生态,可以解析各种格式和类型的数据。

- Kibana:一个开源的数据可视化和分析工具,通常与 Elasticsearch 协同工作。Kibana 提供了可视化的界面,允许用户轻松地创建图表、表格和地图,以便更好地理解日志数据。

ELK 系统广泛应用于日志分析、实时监控和系统性能监控等领域。通过这三个组件的组合,ELK 系统提供了一个强大的平台,适用于处理大规模日志数据。

ELK 的部署

Node节点 (至少需要2核CPU4G内存)

192.168.20.10

192.168.20.20

Apache节点

192.168.20.30

Kiabana

192.168.20.40

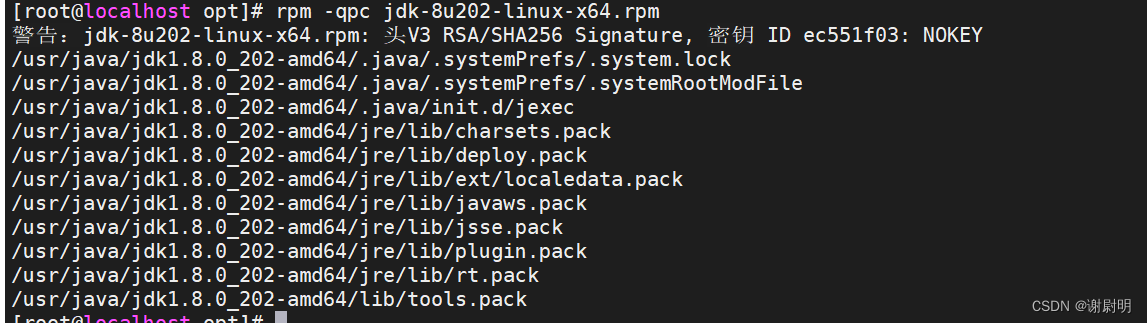

1安装jdk环境

下载 jdk环境rpm包 可以通过我的网盘分享下载jdk8的rpm安装包

下载完成后使用 rpm命令安装这个JDK环境,

rpm -i jdk-8u202-linux-x64.rpm

- 1

再使用rpm查看Java路径

rpm -qpc jdk-8u202-linux-x64.rpm

- 1

记住Java路径

这里是/usr/java/jdk1.8.0_202-amd64

新建一个环境变量子文件增加或修改环境变量

vim /etc/profile.d/java.sh

- 1

export JAVA_HOME=/usr/java/jdk1.8.0_202-amd64

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

- 1

- 2

- 3

- 4

source /etc/profile.d/java.sh

- 1

版本更新成功

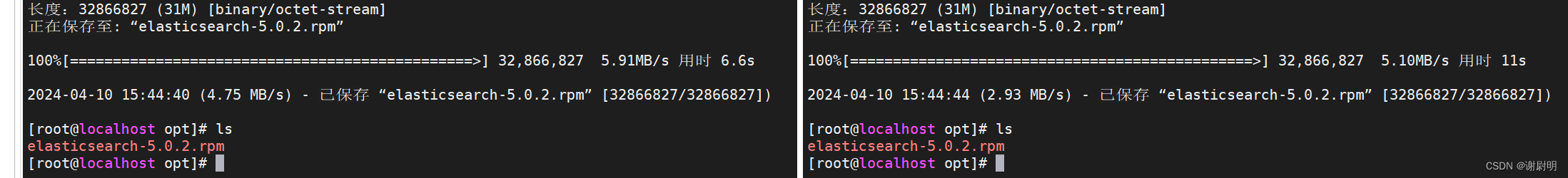

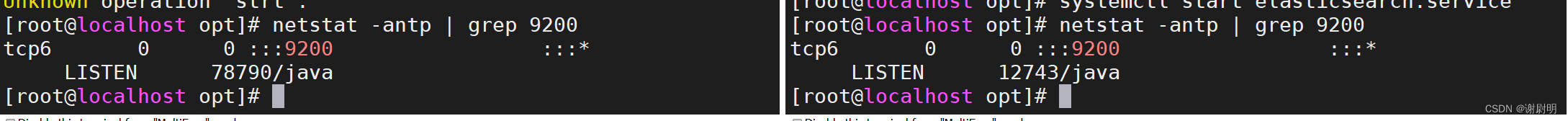

2部署Elasticsearch软件

下载并且安装Elasticsearch RPM 软件包

cd /opt

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.0.2.rpm

- 1

- 2

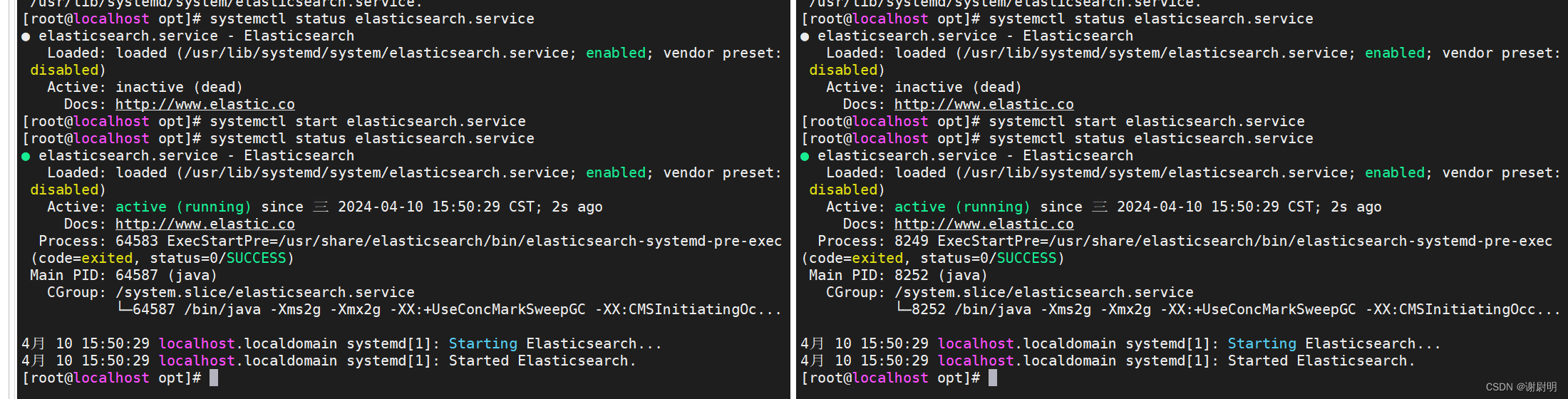

rpm -i elasticsearch-5.0.2.rpm

systemctl daemon-reload

systemctl enable elasticsearch.service

systemctl restart elasticsearch.service

- 1

- 2

- 3

- 4

刷新配置文件并且启动服务

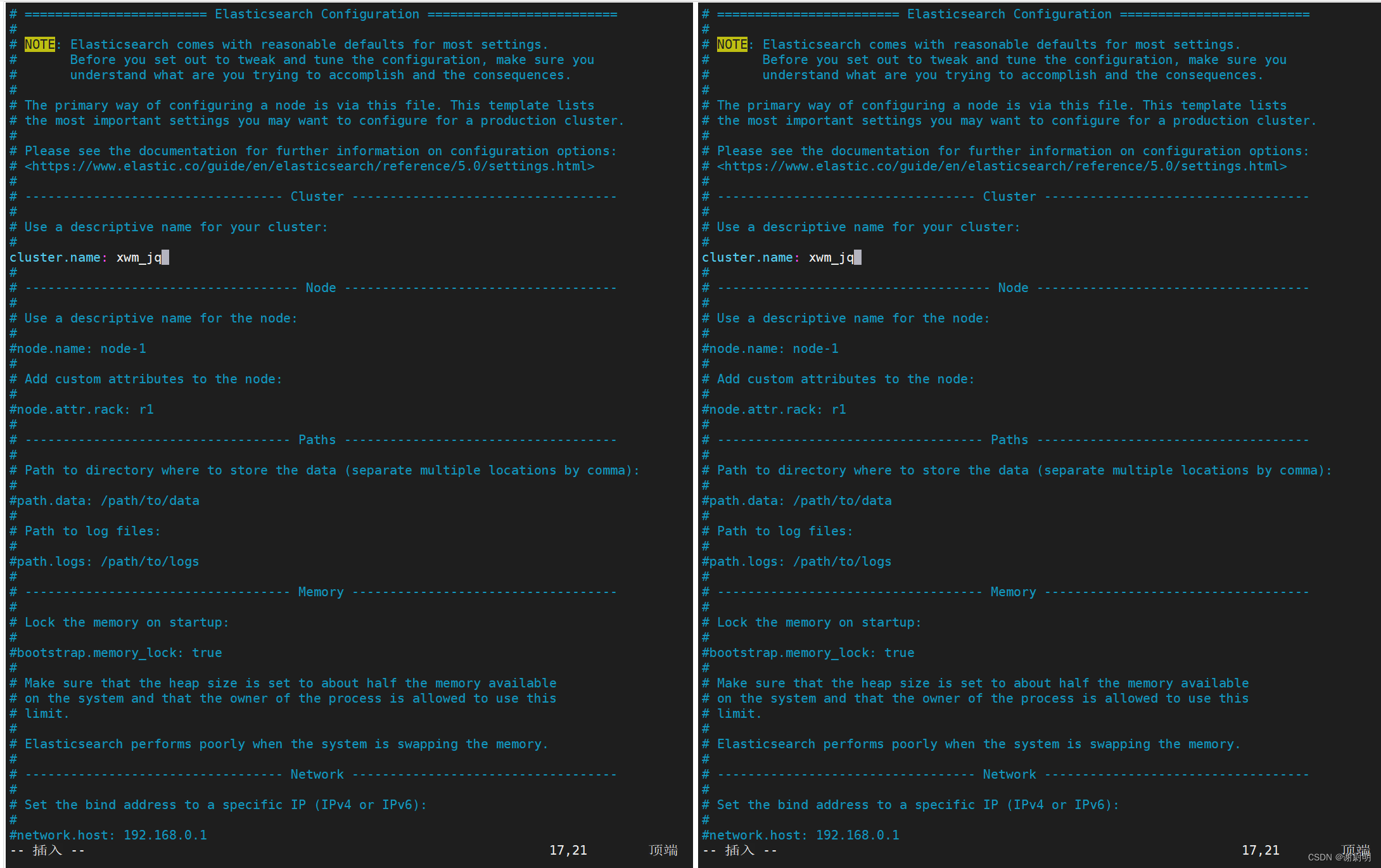

备份并且修改elasticsearch主配置文件

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

vim /etc/elasticsearch/elasticsearch.yml

- 1

- 2

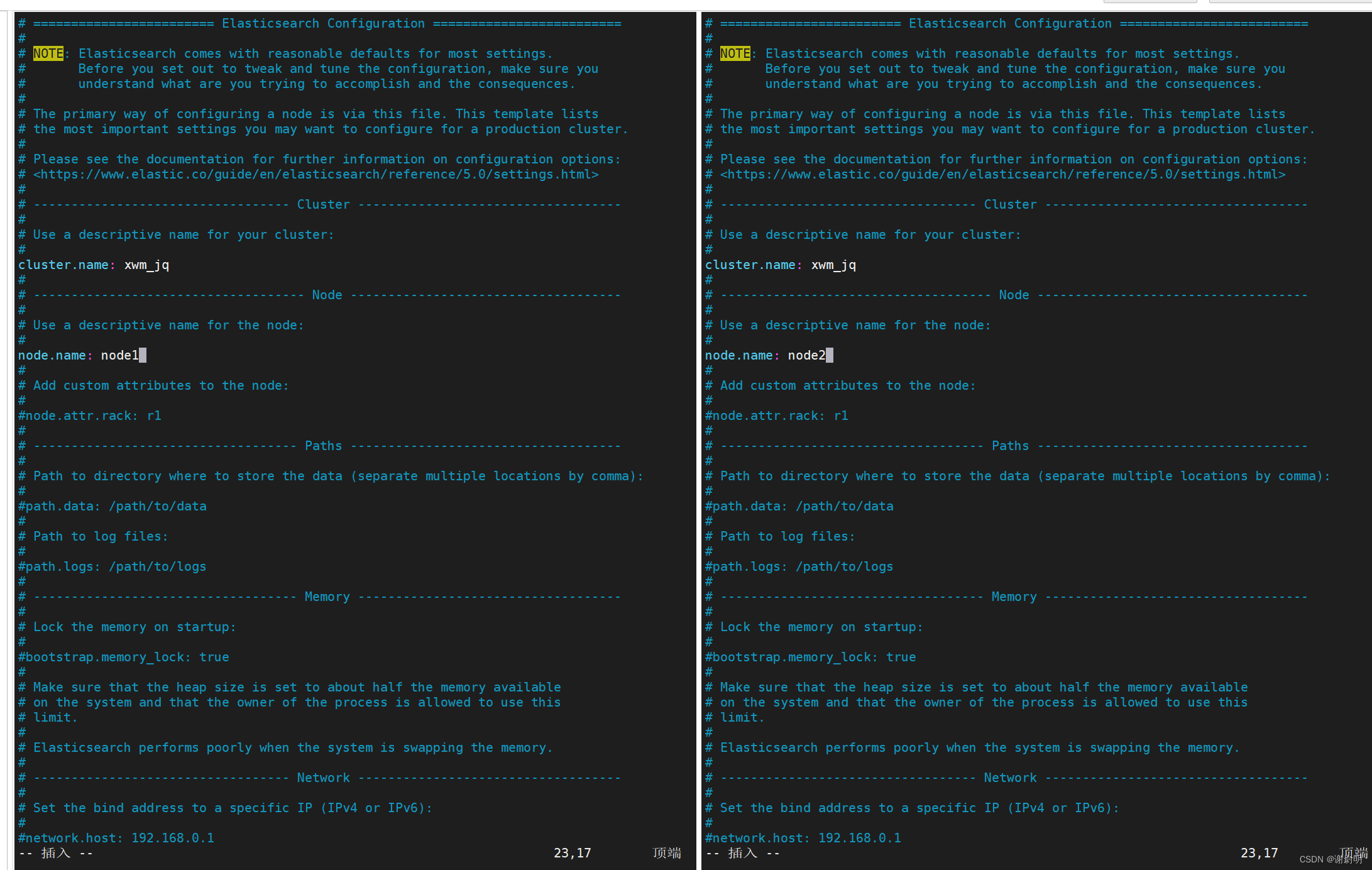

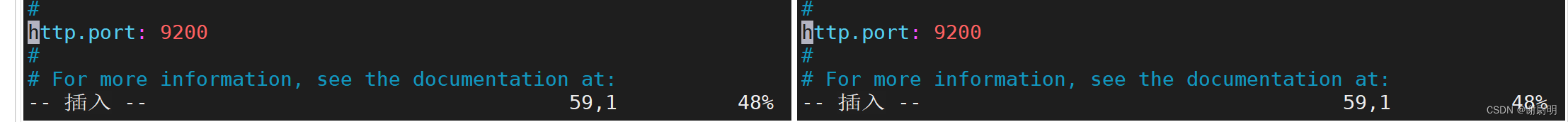

第十七行取消注释,cluster.name: 你想要的名字

第23行取消注释,修改你节点的名字IP

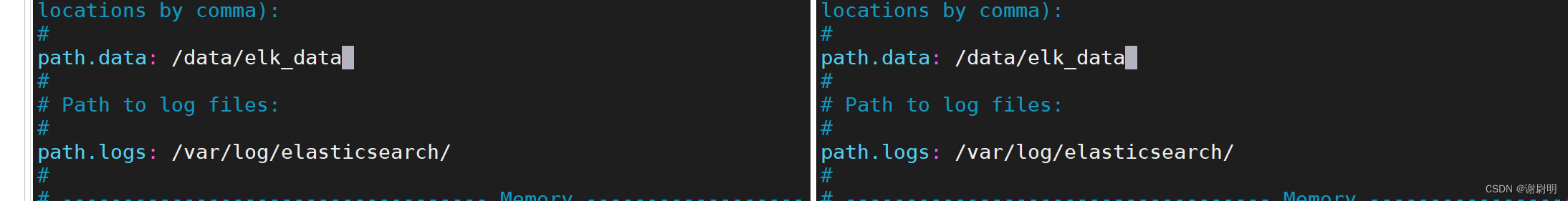

33行取消注释,指定数据存放路径path.data: /data/elk_data

37取消注释,指定日志存放路径path.logs: /var/log/elasticsearch/

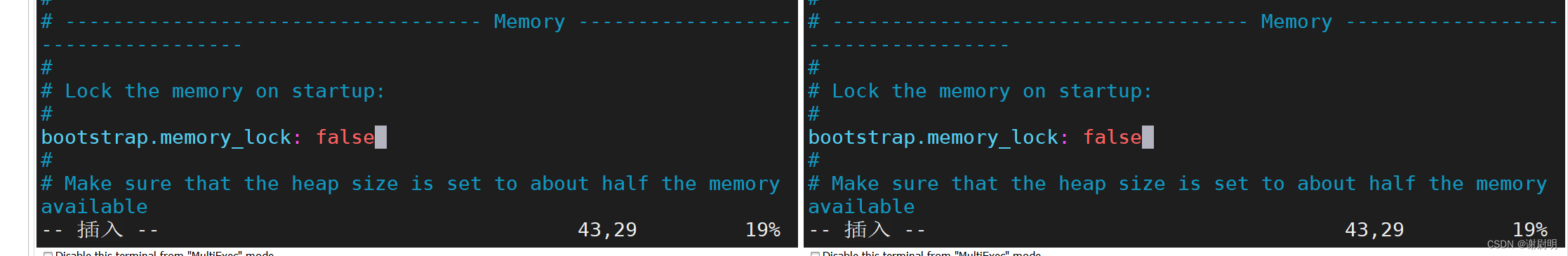

43行取消注释关闭内存锁

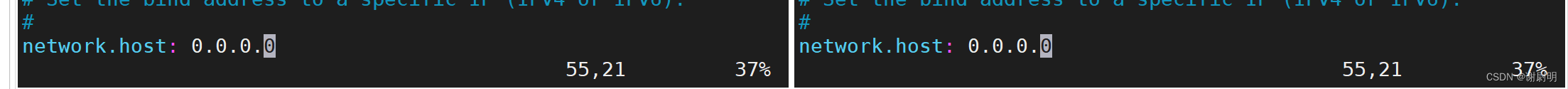

55行取消注释将监听地址改为0.0.0.0监听所有地址

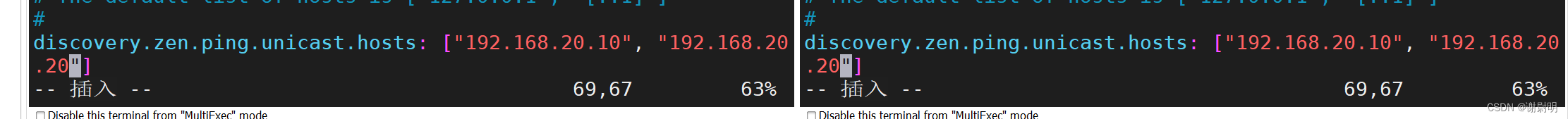

59行取消注释监听9200端口

68行取消注释设置集群发现通过单播实现,指定要发现的节点 可以是主机名也可以是IP,主机名需要在host文件中设置

cluster.name: xwm_jq

node.name: node1

path.data: /data/elk_data

path.logs: /var/log/elasticsearch/

bootstrap.memory_lock: false

network.host: 0.0.0.0

http.port: 9200

discovery.zen.ping.unicast.hosts: ["192.168.20.10", "192.168.20.20"]

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

创建/data/elk_data文件夹并且设置属组与属主,若是没有此文件夹就会报错导致elasticsearch无法启动

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

- 1

- 2

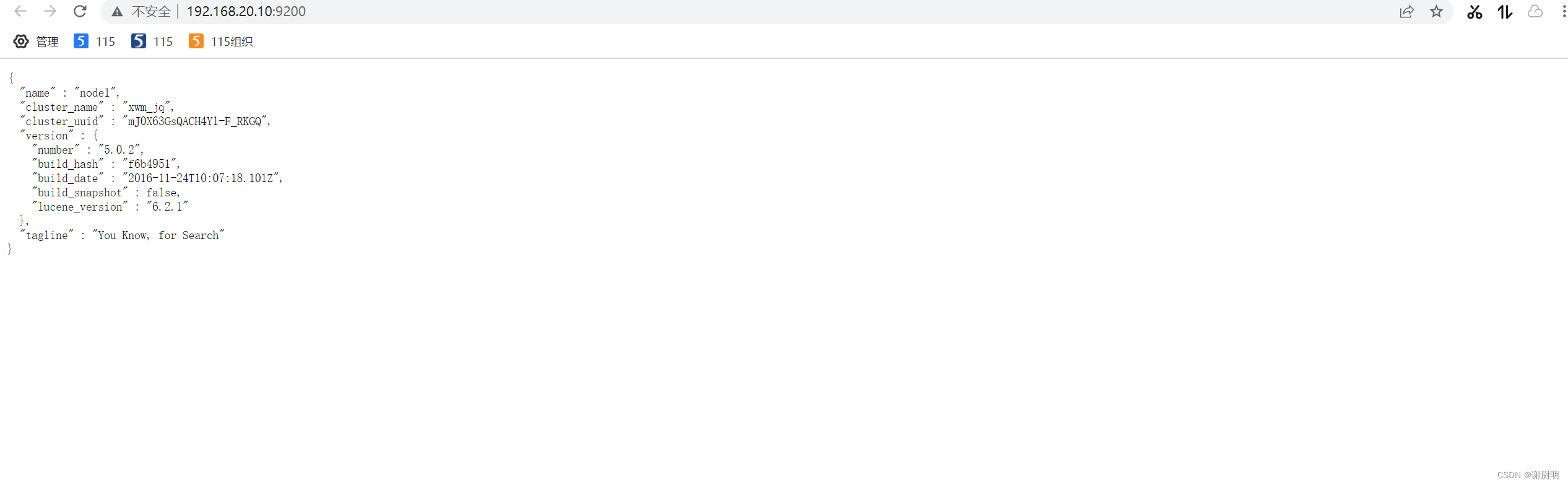

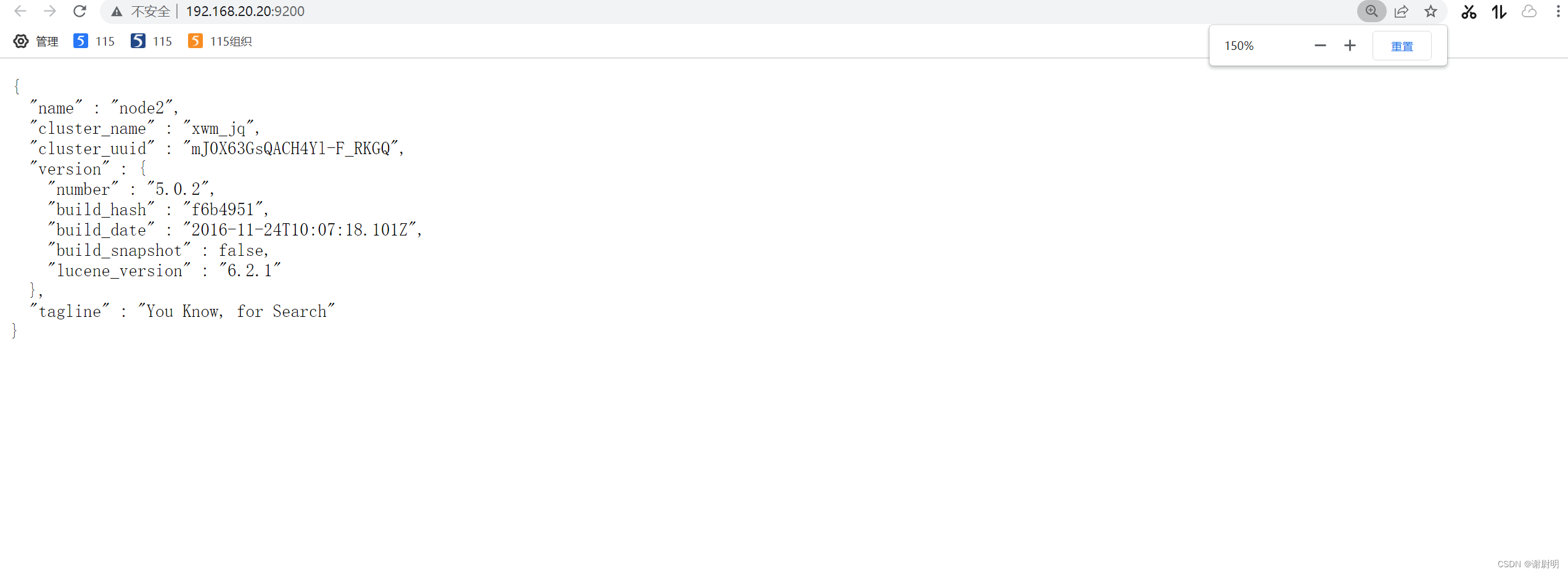

查看节点信息

浏览器访问 http://192.168.20.10:9200 、 http://192.168.20.20:9200 查看节点 Node1、Node2 的信息。

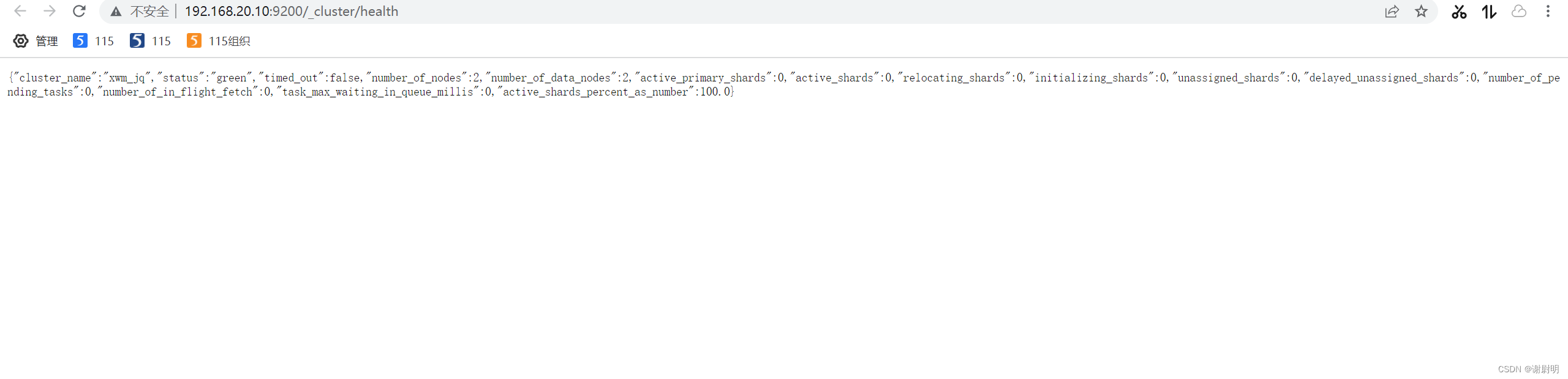

查看节点状态

green(绿色), 表示节点健康运行。

绿色: 健康 数据和副本 全都没有问题

红色: 数据都不完整

黄色: 数据完整,但副本有问题发

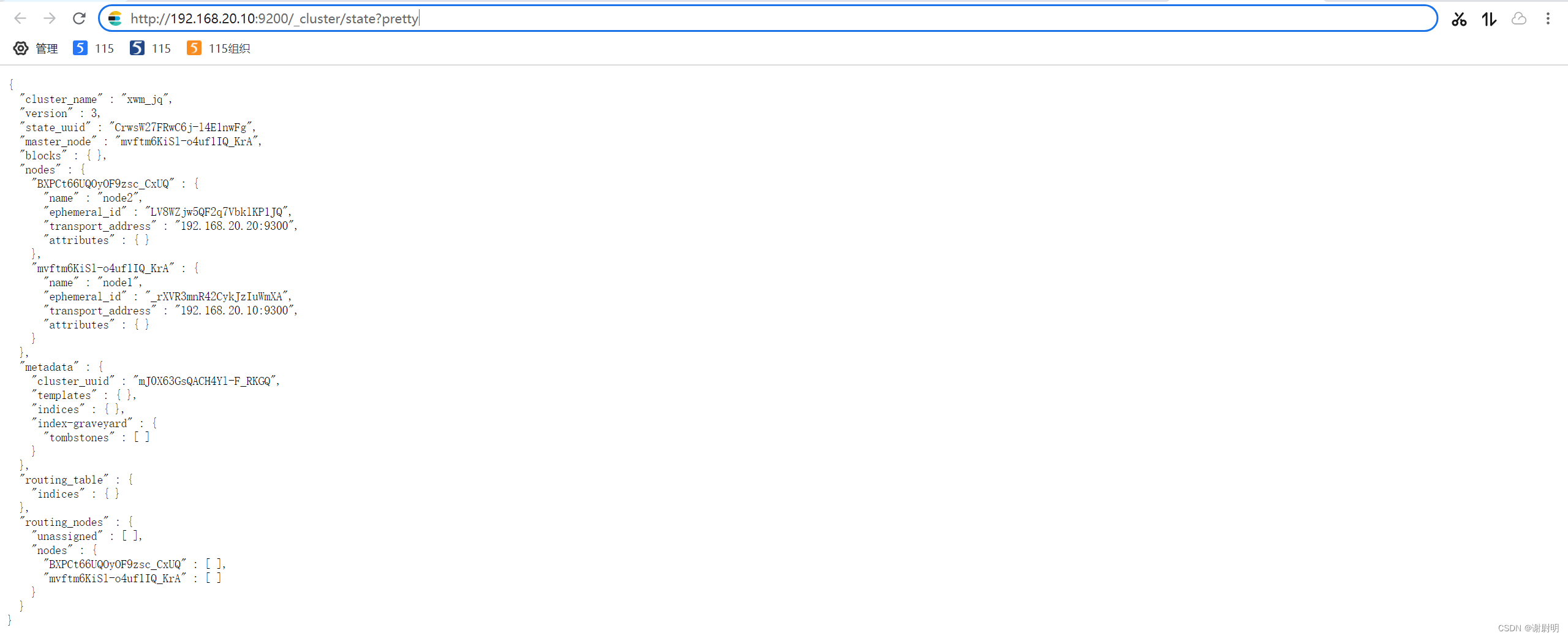

查看集群状态

http://192.168.20.10:9200/_cluster/state?pretty

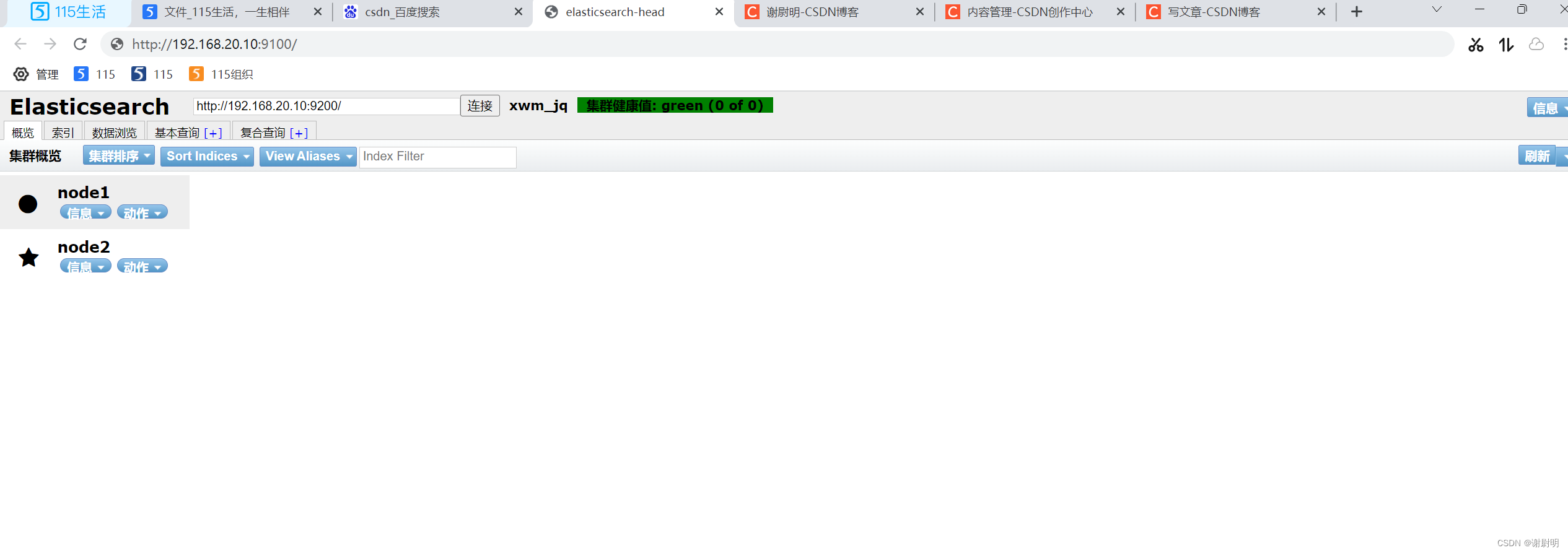

使用这种方式查看集群状态和服务器状态不够直观,可以使用Elasticsearch-head

安装Elasticsearch-head 插件

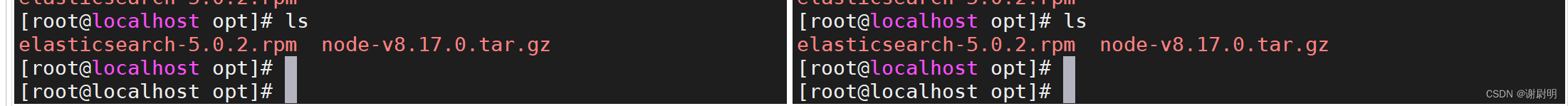

编译安装 node

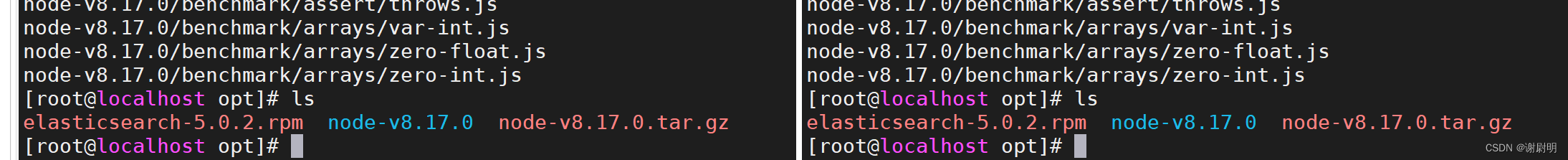

解压缩node-v8.17.0.tar.gz 源码包

tar xfv node-v8.17.0.tar.gz

- 1

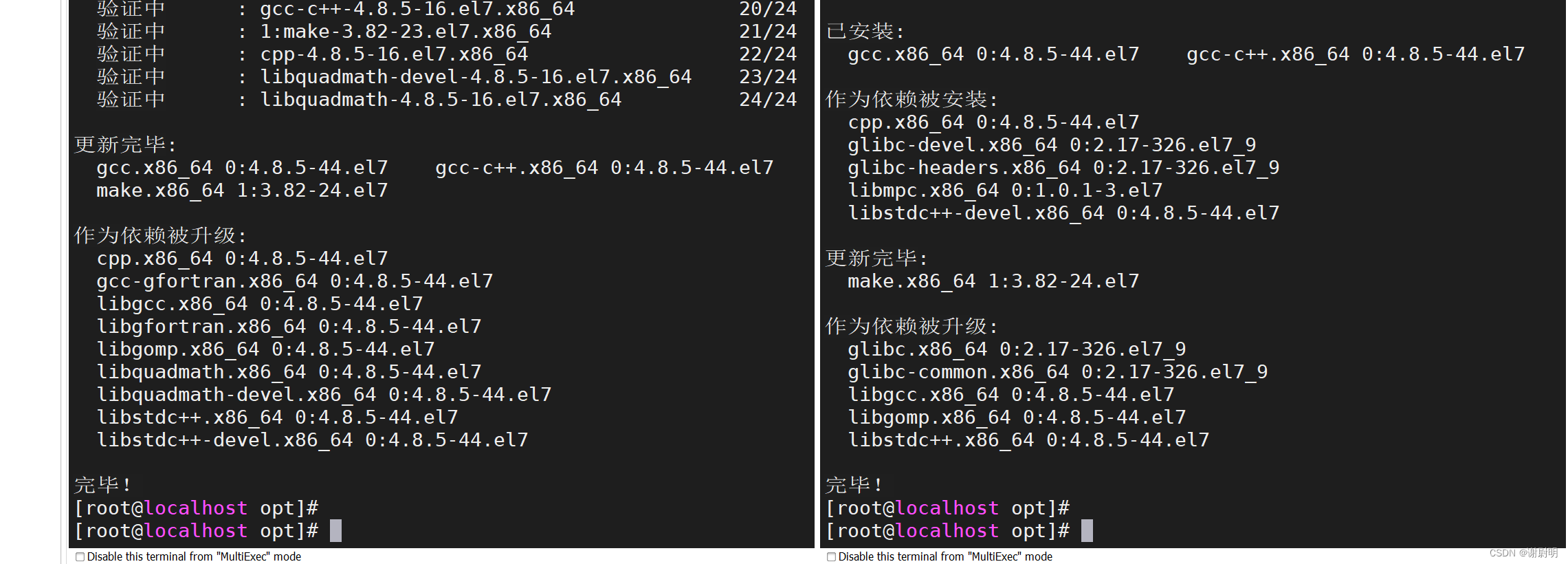

安装编译依赖环境

yum -y install gcc gcc-c++ make

- 1

cd node-v8.17.0/

./configure

make -4j && make install

- 1

- 2

- 3

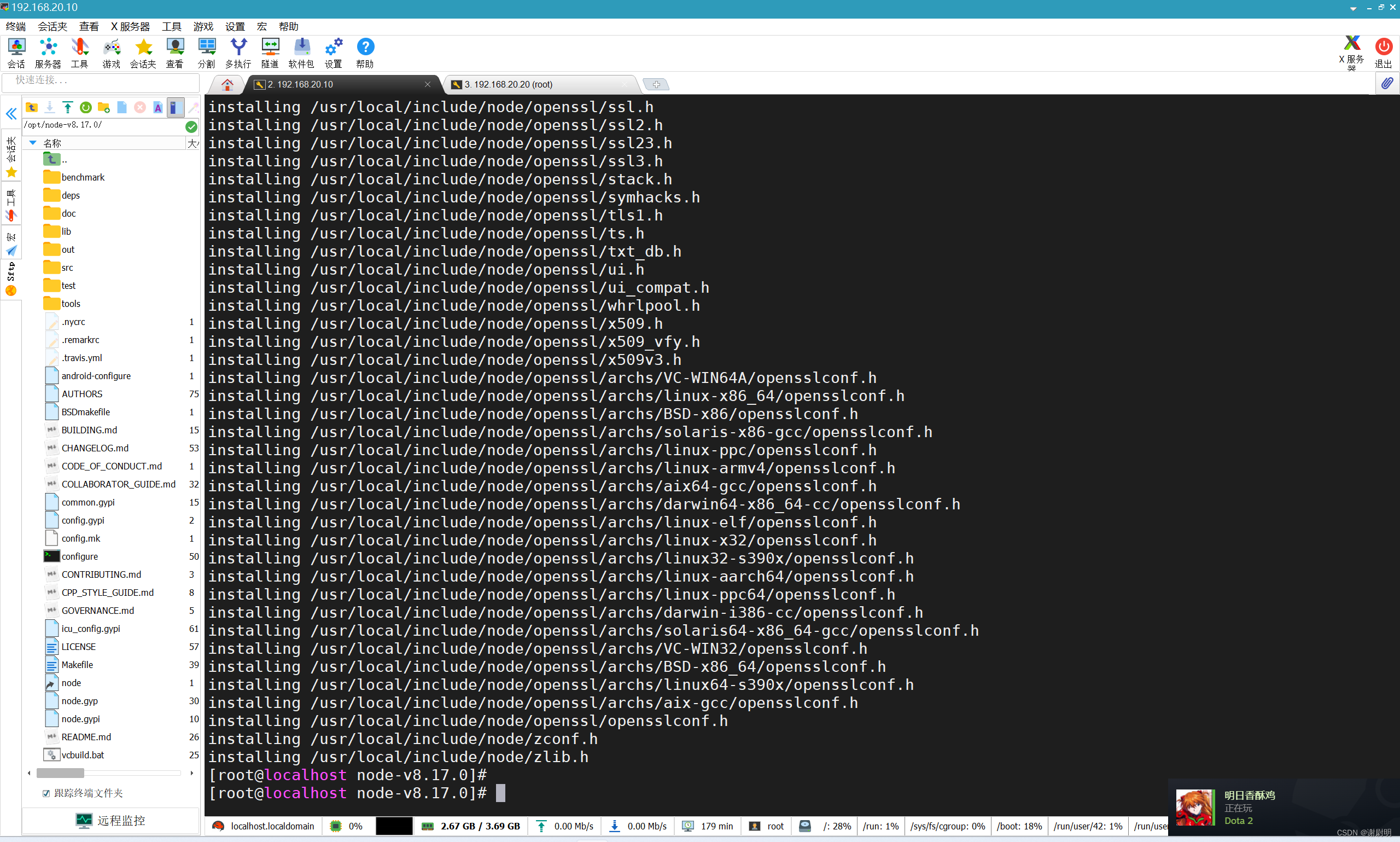

node编译安装完成

安装phantomjs

可以在官网下载

下载二进制文件包解压后可以直接使用

tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/local/src/

cd /usr/local/src/phantomjs-2.1.1-linux-x86_64/bin

cp phantomjs /usr/local/bin

- 1

- 2

- 3

安装 Elasticsearch-head 数据可视化工具

安装 Elasticsearch-head 数据可视化工具

#上传软件包 elasticsearch-head.tar.gz 到/opt

cd /opt

tar xfv elasticsearch-head.tar.gz

cd /opt/elasticsearch-head-5.0.0

npm install

- 1

- 2

- 3

- 4

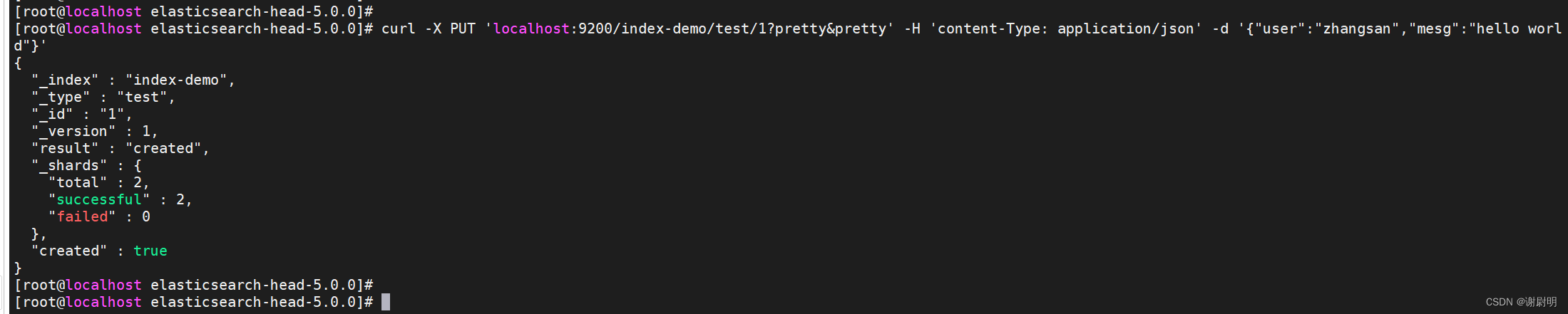

插入索引

通过命令插入一个测试索引,索引为 index-demo,类型为 test。

curl -X PUT ‘localhost:9200/index-demo/test/1?pretty&pretty’ -H ‘content-Type: application/json’ -d ‘{“user”:“zhangsan”,“mesg”:“hello world”}’

//输出结果如下:

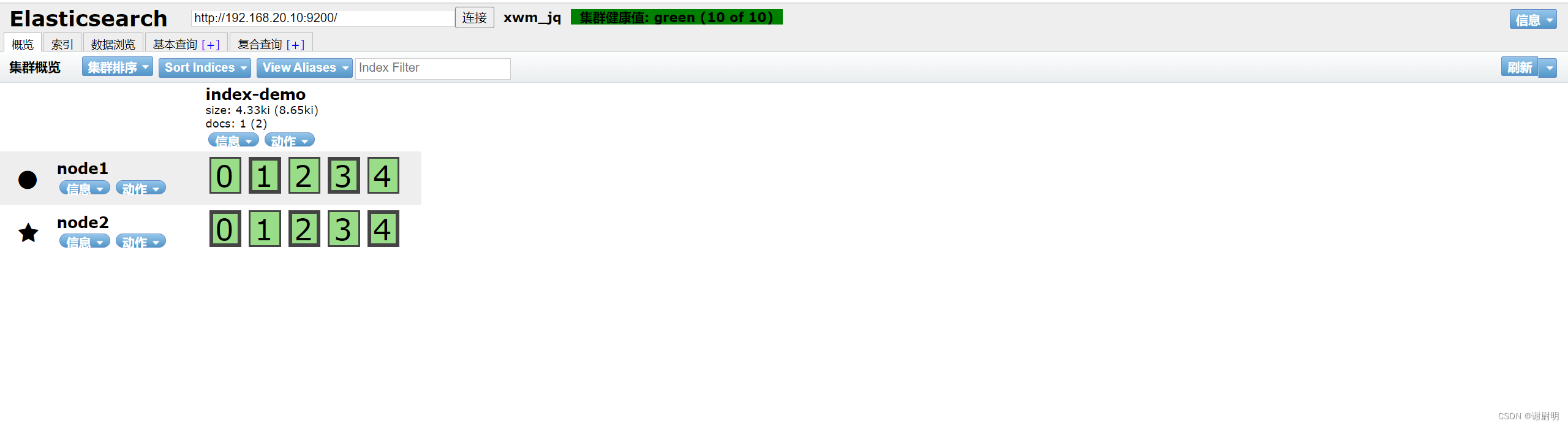

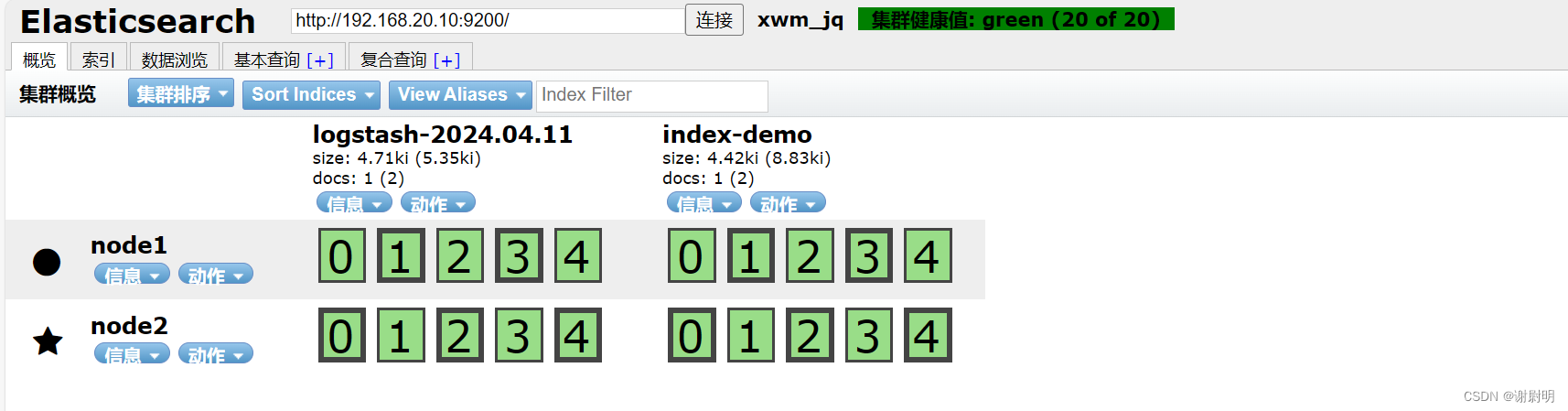

访问192.168.20.10:9100

可以看到它拥有一条索引

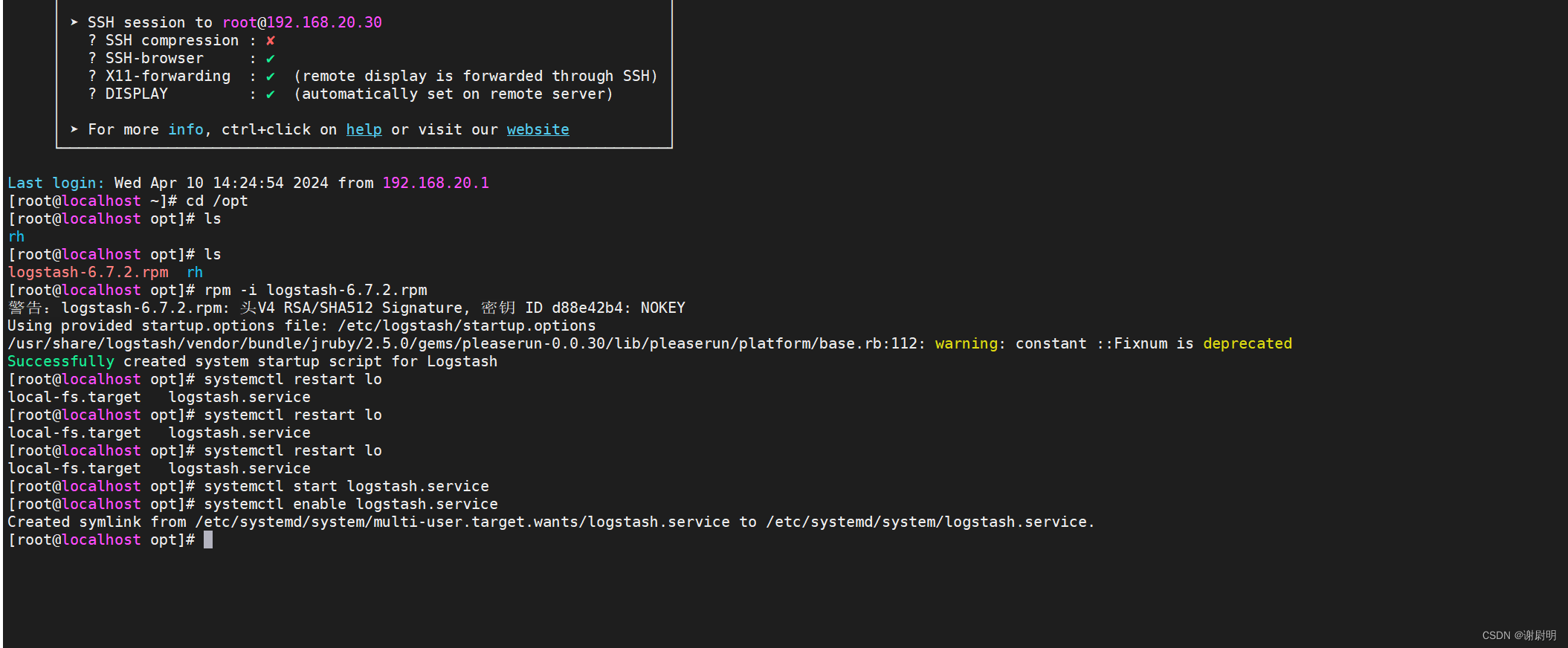

Logstash部署

在192.168.20.30机器上上传软件包 logstash-6.7.2.rpm 到/opt目录下

rpm -ivh logstash-6.7.2.rpm

systemctl start logstash.service

systemctl enable logstash.service

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

- 1

- 2

- 3

- 4

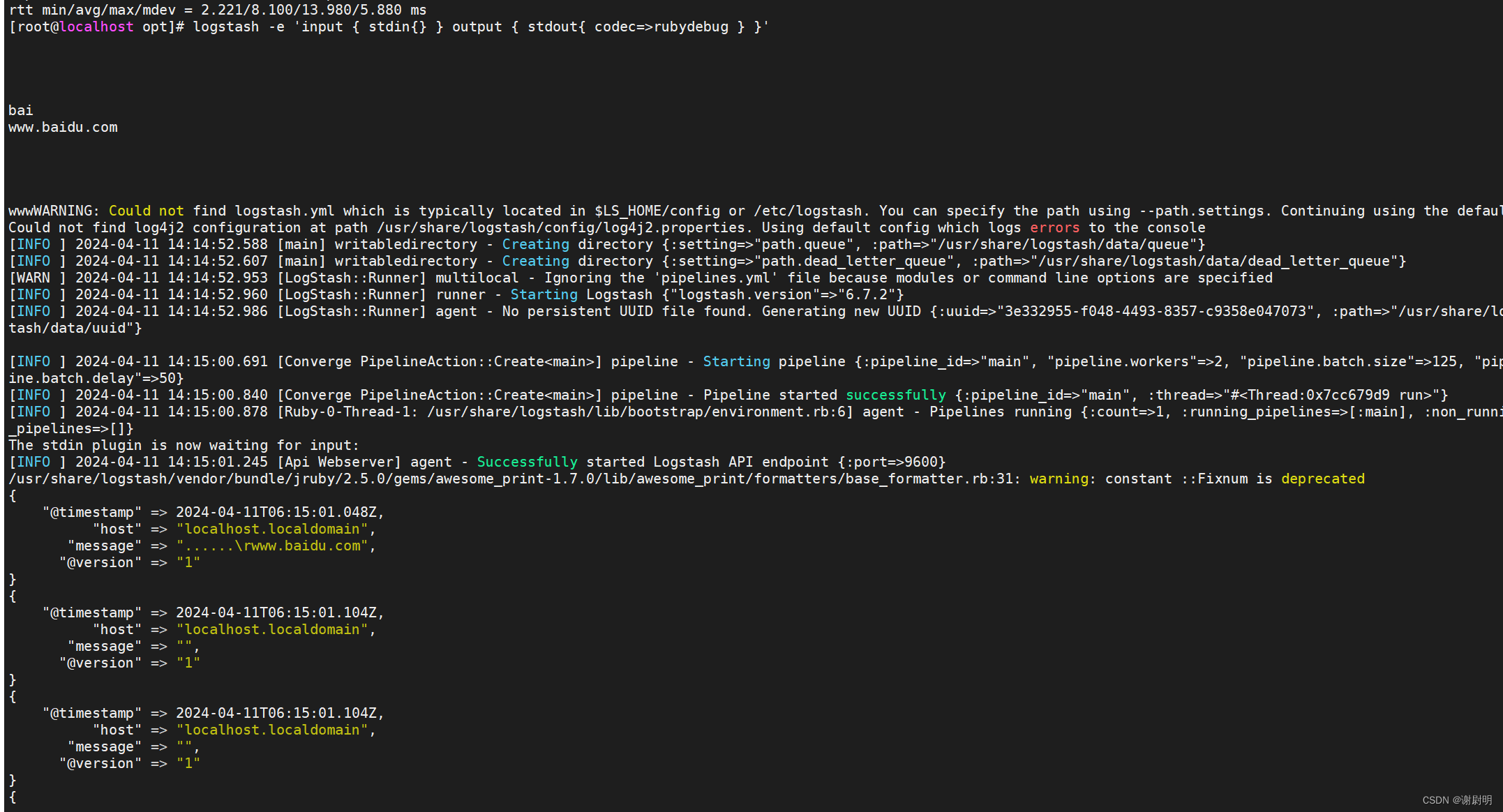

测试 Logstash

使用 rubydebug 输出详细格式显示,codec 为一种编解码器

logstash -e ‘input { stdin{} } output { stdout{ codec=>rubydebug } }’

使用 Logstash 将信息写入 Elasticsearch 中

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.20.10:9200"] } }'

输入 输出 对接

www.baidu.com

- 1

- 2

- 3

生成了新的日志 logstash发送到ES的日志

可以通过修改配置文件 让收集系统日志/var/log/message,并将其输出到elasticsearch服务器上

首先让logstersh有读取日志的权限

chmod +r /var/log/messages

- 1

在/etc/logstash/conf.d添加Logstash配置文件

vim /etc/logstash/conf.d/messages.conf

- 1

input { file { path =>"/var/log/messages" type =>"messages" start_position =>"beginning" sincedb_path => "/etc/logstash/sincedb_path/log_progress" add_field => {"log_hostname"=>"${HOSTNAME}"} } } output { elasticsearch { hosts => ["192.168.20.10:9200", "192.168.20.20:9200"] index =>"messages-%{+YYYY.MM.DD}" } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

mkdir /etc/logstash/sincedb_path/

touch /etc/logstash/sincedb_path/log_progress

chown logstash:logstash /etc/logstash/sincedb_path/log_progress

logstash -f messages.conf

- 1

- 2

- 3

- 4

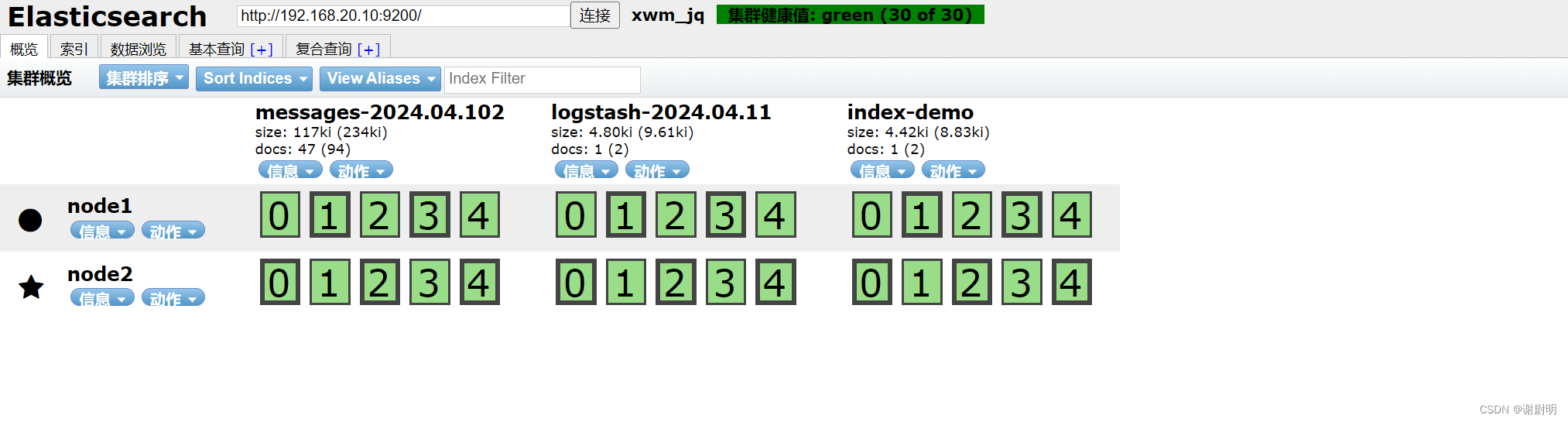

可以看见多出了一个messages索引,说明配置文件完成

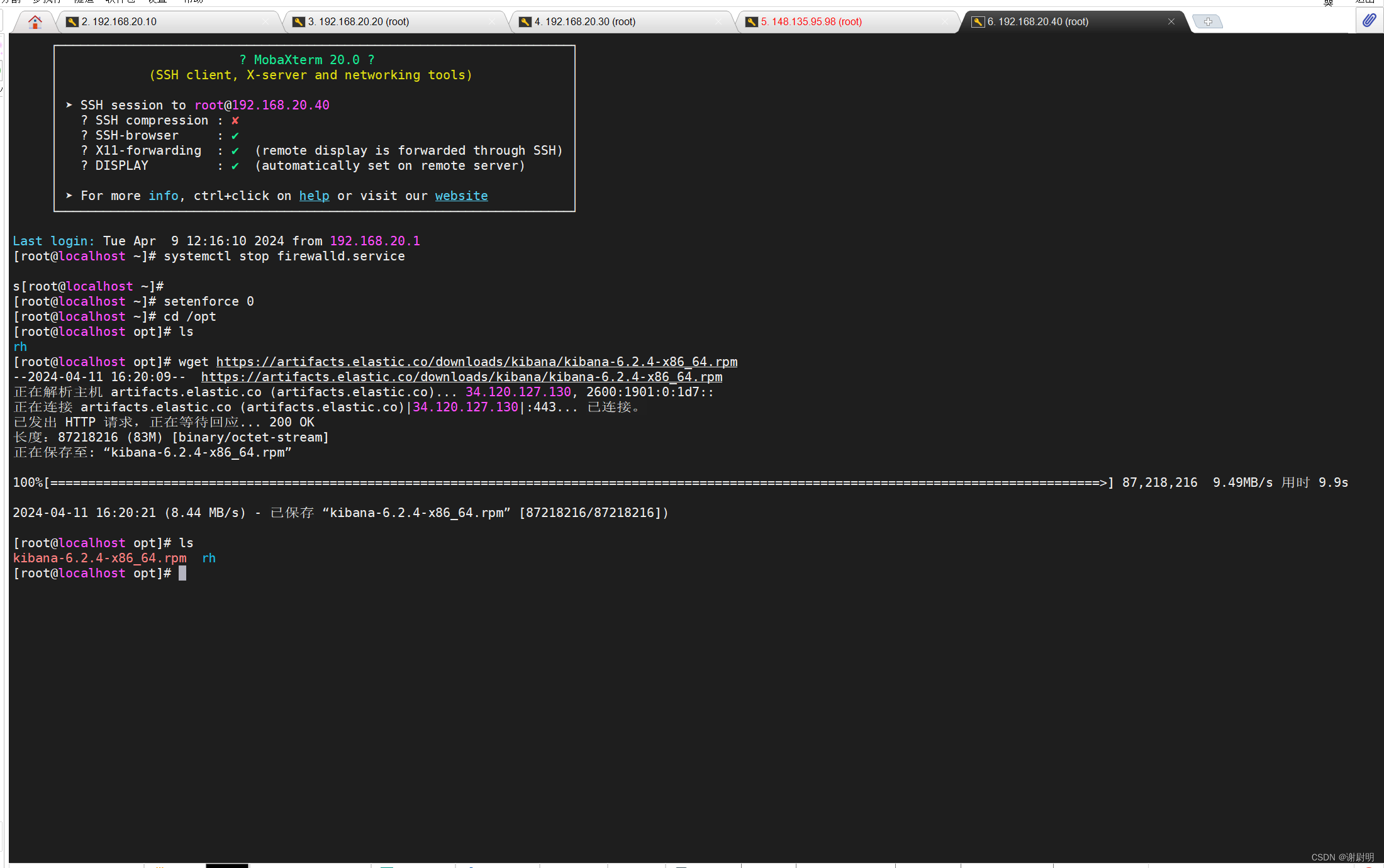

安装 Kiabana

在192.168.20.40安装

cd /opt

wget https://artifacts.elastic.co/downloads/kibana/kibana-5.0.2-i686.rpm

- 1

- 2

使用 rpm命令安装Kibana

rpm -i kibana-5.0.2-i686.rpm

- 1

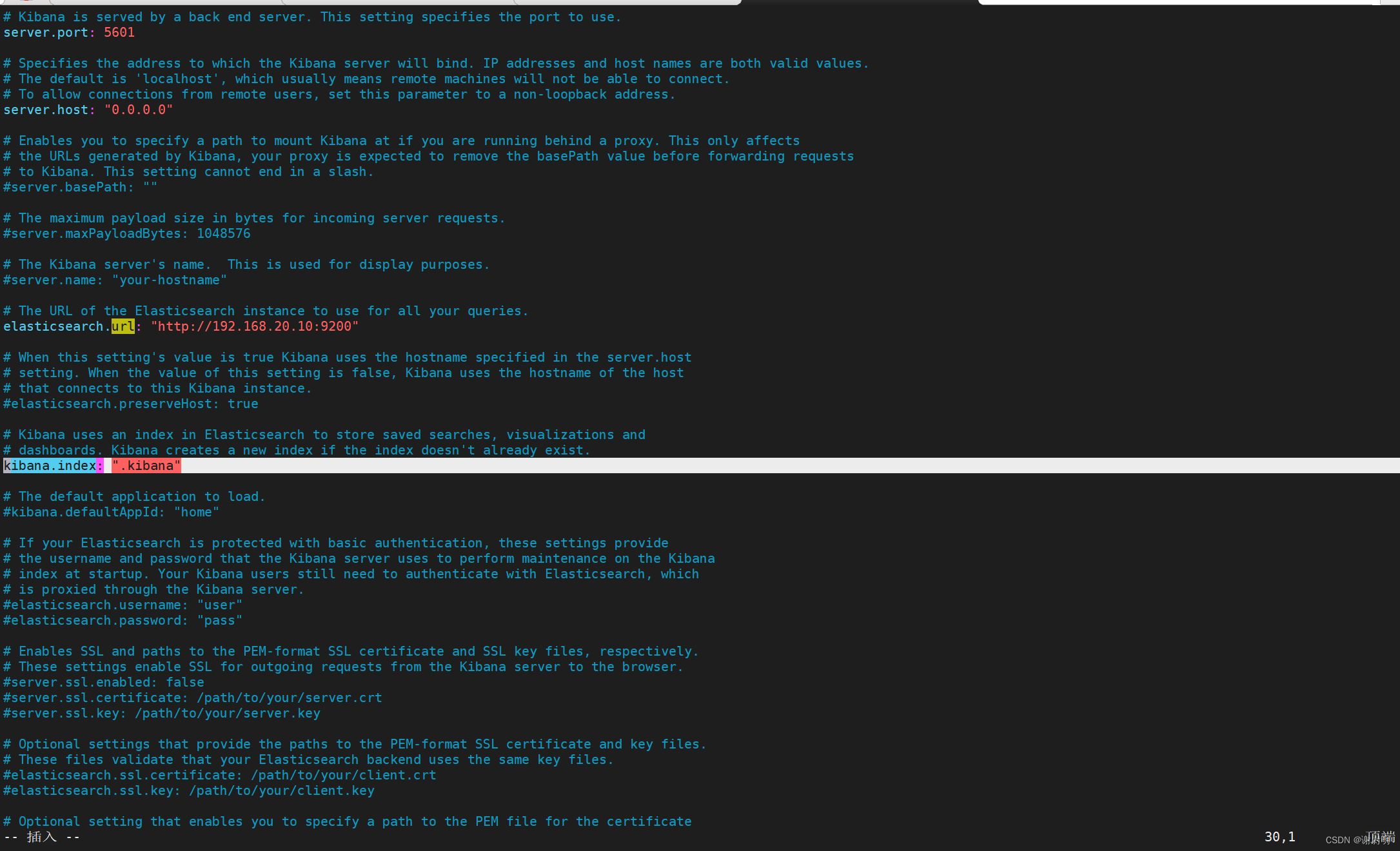

修改Kibana的配置文件

vim /etc/kibana/kabana.yul

- 1

#第二行取消注释

server.port: 5601

#第七行取消注释设置kabana需要监听的地址

server.host: "0.0.0.0"

#设置第二十八行置和 Elasticsearch 建立连接的地址和端口

elasticsearch.url: "http://192.168.20.10:9200"

#第三十行取消注释

kibana.index: ".kibana"

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

启动 Kibana 服务

systemctl start kibana.service

systemctl enable kibana.service

netstat -natp | grep 5601

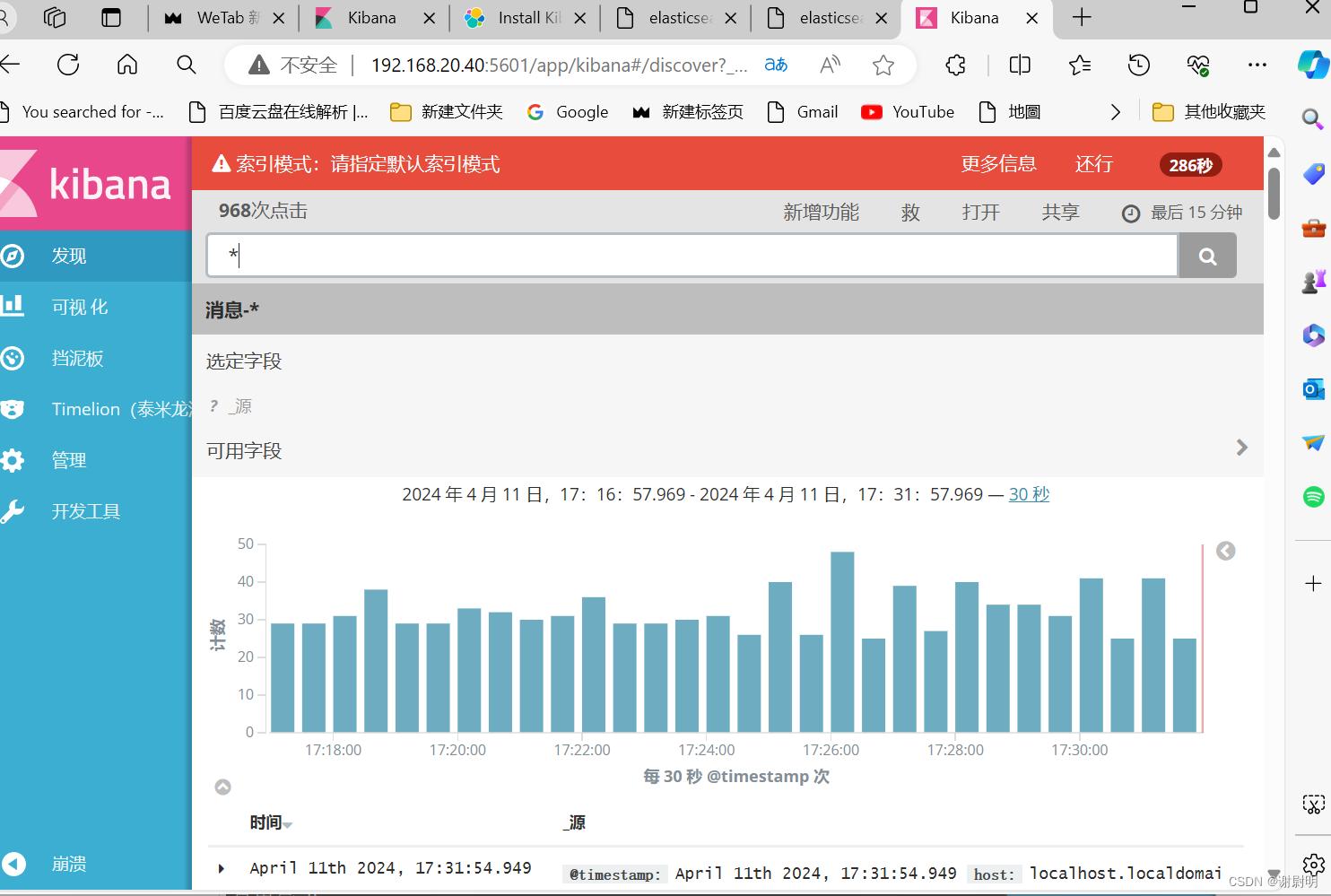

验证 Kibana

浏览器访问 http://192.168.10.13:5601

第一次登录需要添加一个 Elasticsearch 索引:

Index name or pattern

elk配置完成