- 1cmd输入python但是打开microsoft store问题_cmd输入python就打开microstore

- 2Spring+neo4j_spring+ne4oj

- 3实时数据处理的流式计算框架:Apache Spark Streaming 与 Apache Flink 的实践

- 4数据库常见面试题--MySQL

- 5【实战教程】Spring Boot项目集成华为openGauss数据库的关键步骤与注意事项_springboot集成opengauss

- 6Python 异常处理:Python 中的断言_python断言

- 709 Confluent_Kafka权威指南 第九章:管理kafka集群_confluent.kafka producerconfig

- 8ffmpeg源码编译_centos手动编译github中的ffmpeg源码

- 9如何使用MongoDB+Springboot实现分布式ID?_spring +mongodb id设计策略

- 10一文看懂自然语言处理-NLP(4个典型应用+5个难点+6个实现步骤)_nlp自然语言处理

mamba_ssm和causal-conv1d安装教程_不同torch版本的mamba-ssm

赞

踩

一、前言

最近爆火的mamba模型,号称是可以取代transformer模型的存在,这个能不能取代,时间会告诉我们的。由于mamba模型比较新,所以在安装其环境的时候,还是有点麻烦的。mamba_ssm和causal-conv1d这两个包似乎不能在windows下安装,但是我没有尝试过(github也没有windows系统的离线包),看到其他博主这样说的,身边能有linux的还是在linux下安装吧!

由于在线安装,经常由于网络问题导致安装失败,因此本次教程使用离线安装(比较简单)。

二、开始安装

创建虚拟环境、激活虚拟环境等等此处不在赘述。

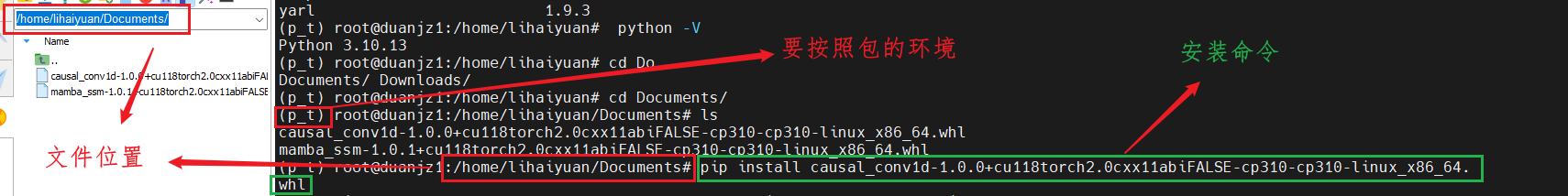

我的环境配置为:torch2.0+cu118+python3.10

因此我使用这两个安装包是

causal_conv1d-1.0.0+cu118torch2.0cxx11abiFALSE-cp310-cp310-linux_x86_64.whl

mamba_ssm-1.0.1+cu118torch2.0cxx11abiFALSE-cp310-cp310-linux_x86_64.whl

下面是这个两个安装包的github的网址,可以去下载对应版本的包

causal_conv1d:Release v1.0.0 · Dao-AILab/causal-conv1d · GitHub

下载之后,放到对应位置,且进入到要安装的环境。(先安装causal_conv1d)

安装命令:pip install 包名

eg:pip install causal_conv1d-1.0.0+cu118torch2.0cxx11abiFALSE-cp310-cp310-linux_x86_64.whl

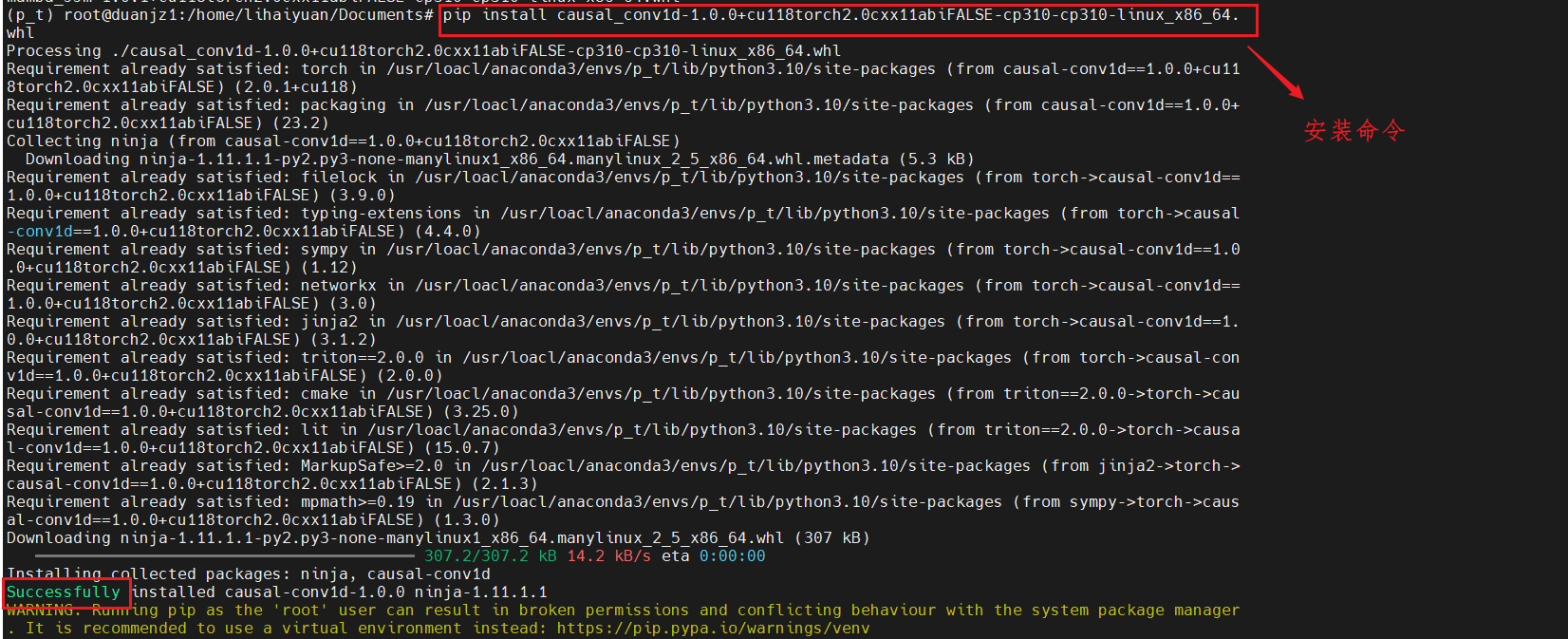

安装过程

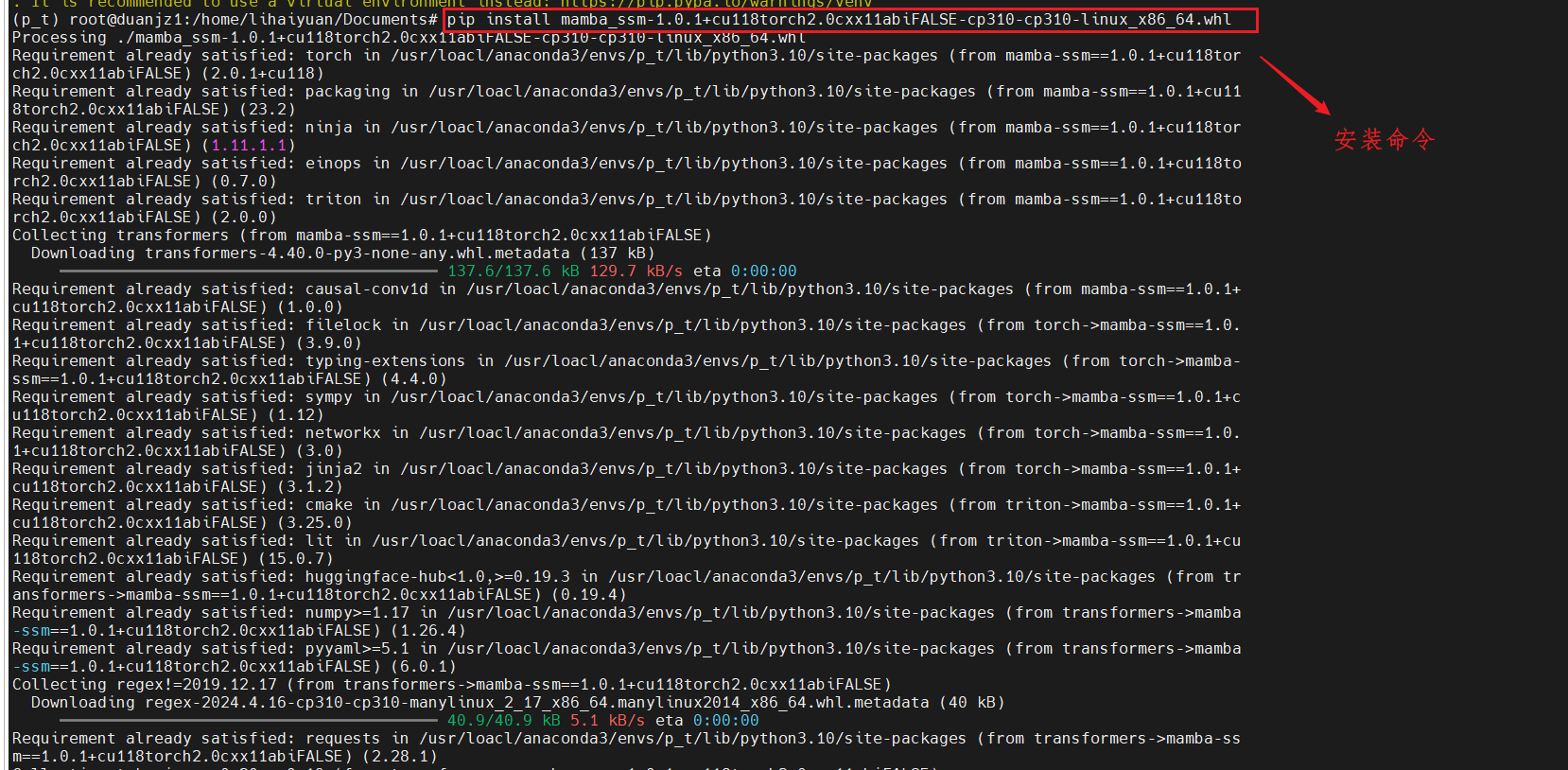

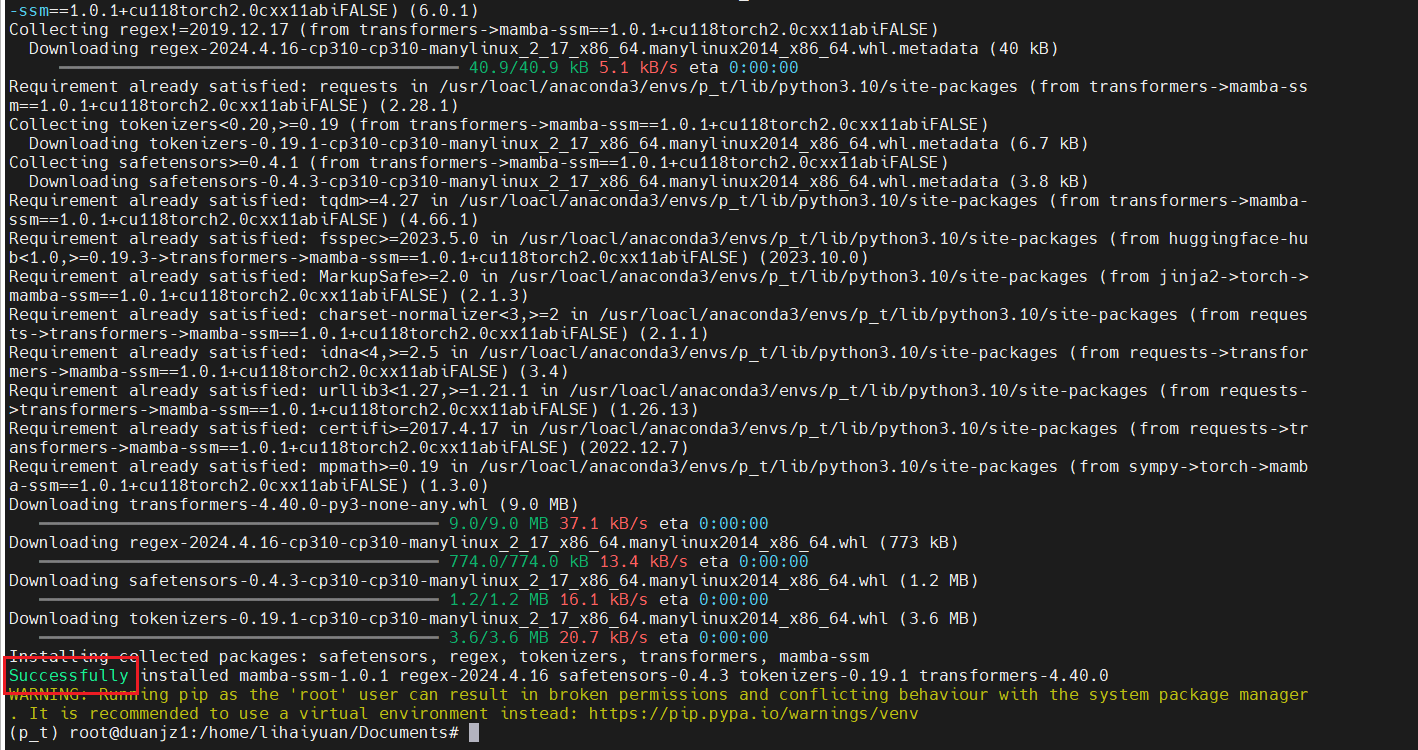

然后,使用相同的方法,安装mamba_ssm。

希望以上的内容,对各位朋友,有所帮助。

可能会遇到的问题

如果离线安装的时候遇到超时的情况,安装那个包超时的,再次执行安装命令即可。

如果某个包很大,一直卡在那个包超时,你直接使用临时源安装那个包,安装完,在执行安装Mamba包的命令。

例如:我在安装mamba这个包的过程中,一直卡在camke这个包,出现超时。

然后,我直接安装cmake这个包的对应版本

就很快的安装好,然后,我在去安装mamba这个包

就不会卡在cmake这个包一直出错了。

如果又卡在一个新的包出错了,继续使用上述做法。

下面给出我的安装文件

链接: https://pan.baidu.com/s/1UuY0QUqxeQgT3XGVet1mNQ?pwd=1234 提取码: 1234 复制这段内容后打开百度网盘手机App,操作更方便哦

--来自百度网盘超级会员v10的分享