- 1git配置修改.gitignore不上传node_modules文件目录到gitee码云_git不上传node modules

- 2艾默生Movicon Connext引擎:让数据采集、转发、管理更加高效、便捷、安全_micromine数据上传

- 3YOLOv10最详细全面讲解1- 目标检测-准备自己的数据集(YOLOv5,YOLOv8均适用)

- 4【yolov5】yolov5评估网络mAP时屏蔽指定的类_yolo不显示某一类别

- 5从零开始:构建、打包并上传个人前端组件库至私有npm仓库的完整指南_npm 上传组件到私有仓库

- 6RabbitMQ C++客户端SimpleAmqpClient编译总结(32以及64位)_simpleamqpclient 编译

- 7微信小程序添加用户隐私保护指引_微信小程序隐私保护指引弹框实现

- 8ModuleNotFoundError: No module named ‘import_export‘

- 9行为设计模式之策略模式

- 10基于springboot+opencv做人脸识别_org.openpnp.opencv

大模型微调 踩坑个人记录:_微调loss为0

赞

踩

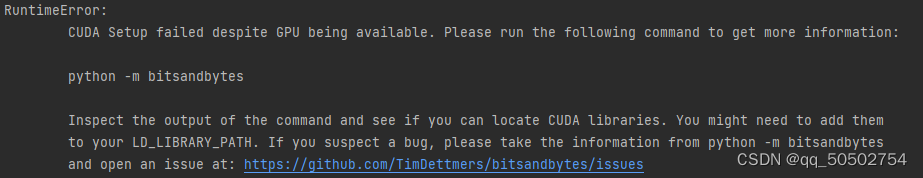

一、报错信息 python -m bitsandbytes

问题1:bitsandbytes 只支持linux,windows下版本过低不支持。

解决方法:改到linux服务器下运行。

问题2:gcc动态库版本过低:OSError: /lib64/libstdc++.so.6: version `GLIBCXX_3.4.21' not found

解决办法:曙光服务器加载module来使用新版gcc动态库:

module load /public/software/modules/compiler/gcc/10.3.0

问题3:cuda版本与bitsandbytes版本不匹配

解决方法1:降低bitsandbytes版本

pip uninstall bitsandbytes

pip install bitsandbytes-cuda117

报错:AttributeError: module 'bitsandbytes.nn' has no attribute 'Linear8bitLt'。需要更高版本的bitsandbytes。

解决方法2:覆盖cuda版本,兼容高版本bitsandbytes。

export BNB_CUDA_VERSION=117

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-11.7

二、chatglm2/3,lora微调时loss为0。

peft版本改为0.6.0后问题解决。

三、chatglm3,lora微调后推理报各种错。

transformer版本更新为4.37.2。

peft版本改为0.7.1后解决。