热门标签

热门文章

- 1springboot项目快速引入knife4j_spring boot2.6 引入 knife4j

- 2详解GROUPING函数

- 3车道线检测相关算法介绍_车道线检测算法

- 4Reading report: V-Net: Fully Convolutional Neural Networks for Volumetric Medical Image Segmentation_convunext: an efficient convolution neural network

- 5全面超越 GPT4,Cluade3深夜震撼发布!带你了解模型的特点,相比 GPT4 的优势,以及附上使用教程_gluade3

- 6python文字转语音的五种方式win32com,pyttsx3,百度api,可使用自己的声音_pyttsx3修改成自己下载的声音

- 7Transformer 解读之:用一个小故事轻松掌握 Decoder 端的 Masked Attention,为什么要使用 Mask,Transformer如何解码,何时停止解码过程。__prepare_decoder_attention_mask

- 8DAY15|| 102. 层序遍历 226. 翻转二叉树 101. 对称二叉树_inverttree(struct treenode* root)

- 9python bp神经网络进行预测_python实现BP神经网络回归预测模型

- 102021年数学建模国赛C题问题一详细思路和代码

当前位置: article > 正文

Positional Embedding与Positional Encoding的区别?

作者:weixin_40725706 | 2024-04-04 00:14:54

赞

踩

positional embedding

一、Positional Embedding

通常,embedding是指学习出来的encoding,是将位置信息“嵌入”到某个空间的意思。例如,bert的位置编码是学出来的,所以称为position embedding

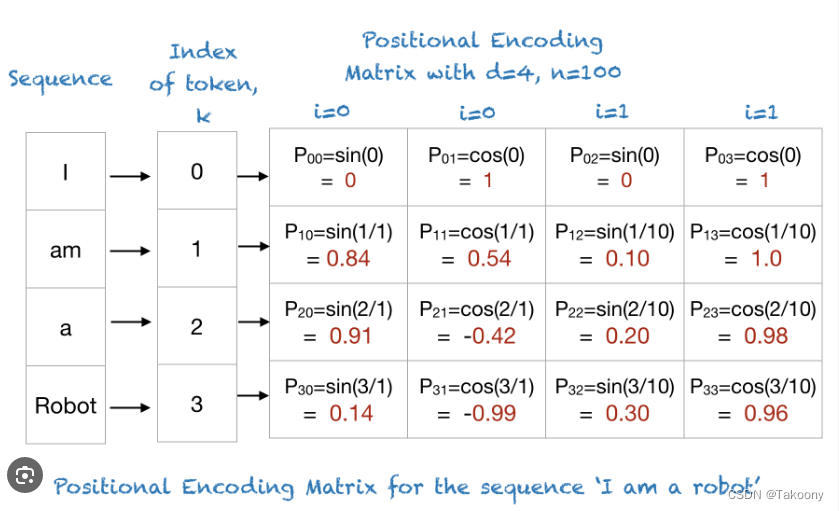

二、Positional Encoding

而transformer的位置编码是用三角函数直接算出来的(当然,论文中说也可以学出来,效果差不多,所以最后还是采用了直接编码),不涉及嵌入的思想,所以叫position encoding

三、应用:

embedding的方式存在序列长度的限制,position可以理解通过lookup的方式得到,超过了训练时最大长度,就无法识别了;这种方式也被验证相对于位置编码效果更好,因此BERT和GPT都采用了这种方式。

encoding的方式就不受最大序列长度的约束

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】

推荐阅读

相关标签