- 1用git bash调用md5sum进行批量MD5计算_bash md5

- 2远程抄表-LoRa水电气无线抄表解决方案_lora采集电表

- 3WPF中Binding的原理和应用

- 4git提交本地代码到github仓库

- 5C语言基础:MBD与C语言_mbd language subset

- 6想体验MacOS?快来下载虚拟机MacOS系统分享包,体验MacOS好选择!_虚拟机mac安装包

- 7深度学习之目标检测(十一)--DETR详解,大厂程序员35岁后的职业出路在哪

- 8【IDEA Git系列(共x篇)】第2篇:提交代码时提示冲突如何处理_apply changes and mark res

- 9利用牛顿迭代法求解非线性方程组_用newton迭代法求解非线性方程组

- 10python cms建站教程:Wagtail建站(一、安装与基本使用)

机器学习实验复习题_1、 似然函数l(θ∣x)中是已知量的是? a、 x b、 θ 2、 极大似然估计中,为了简化

赞

踩

线性回归

下面属于多元线性回归的是?

B、建立股票价格与成交量、换手率等因素之间的线性关系。

C、建立西瓜价格与西瓜大小、西瓜产地、甜度等因素之间的线性关系。

若线性回归方程得到多个解,下面哪些方法能够解决此问题?

A、获取更多的训练样本

B、选取样本有效的特征,使样本数量大于特征数

C、加入正则化项

下列关于线性回归分析中的残差(预测值减去真实值)说法正确的是?

A、残差均值总是为零

模型评估、选择与验证

下面正确的是?

D、将所有数据先随机打乱顺序,百分之80用来训练模型,剩下的百分之20作为测试集,预测结果正确率最高的模型就是我们所要选的模型。

训练集与测试集的划分对最终模型的确定有无影响?

A、有

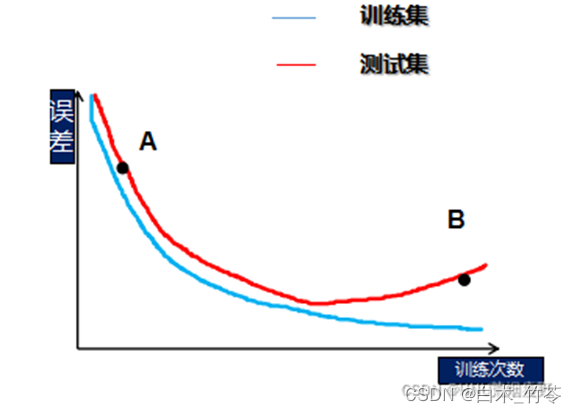

请问,图中A与B分别处于什么状态?

B、欠拟合,过拟合

如果一个模型在训练集上正确率为99%,测试集上正确率为60%。我们应该怎么做?

A、加入正则化项

B、增加训练样本数量

D、减少模型复杂度

如果一个模型,它在训练集上正确率为85%,测试集上正确率为80%,则模型是过拟合还是欠拟合?其中,来自于偏差的误差为?来自方差的误差为?

B、欠拟合,15%,5%

假设,我们现在利用5折交叉验证的方法来确定模型的超参数,一共有4组超参数,我们可以知道,5折交叉验证,每一组超参数将会得到5个子模型的性能评分,假设评分如下,我们应该选择哪组超参数?

D、子模型1:0.8 子模型2:0.8 子模型3:0.8 子模型4:0.8 子模型5:0.6

下列说法正确的是?

B、自助法对集成学习方法有很大的好处

C、使用交叉验证能够增加模型泛化能力

D、在数据难以划分训练集测试集时,可以使用自助法

下列说法正确的是?

A、相比MSE指标,MAE对噪声数据不敏感

B、RMSE指标值越小越好

支持向量回归(SVR)

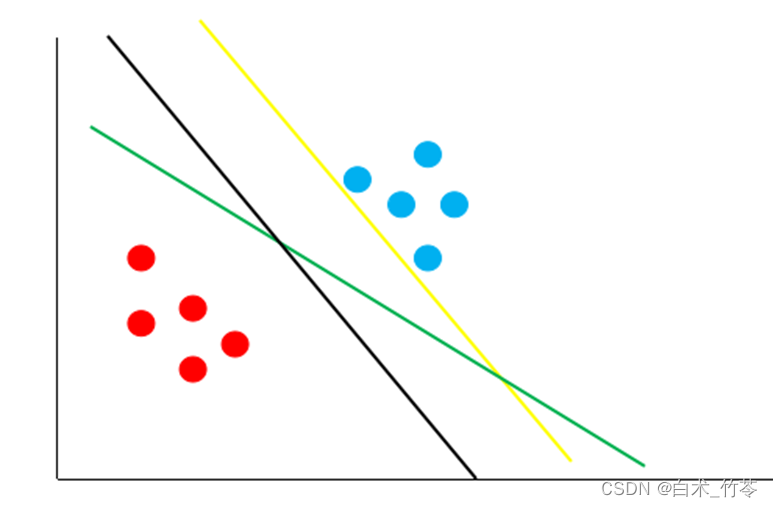

按照支持向量机的思想,下图哪条决策边界的泛化性最好?

B、黑线

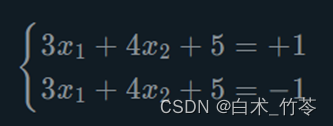

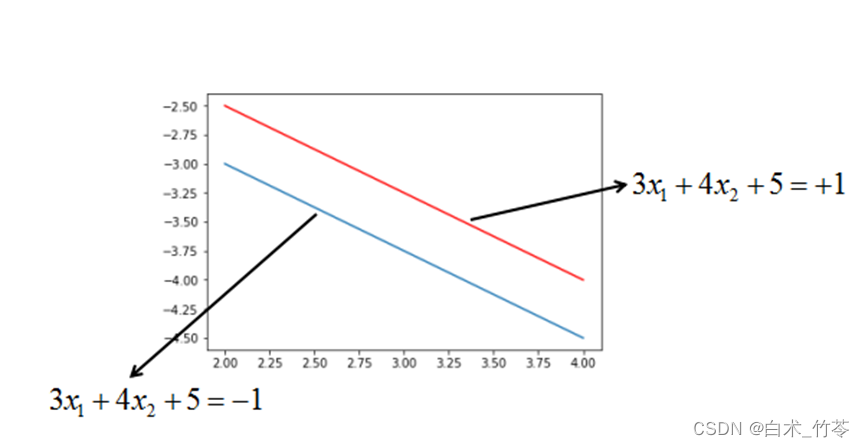

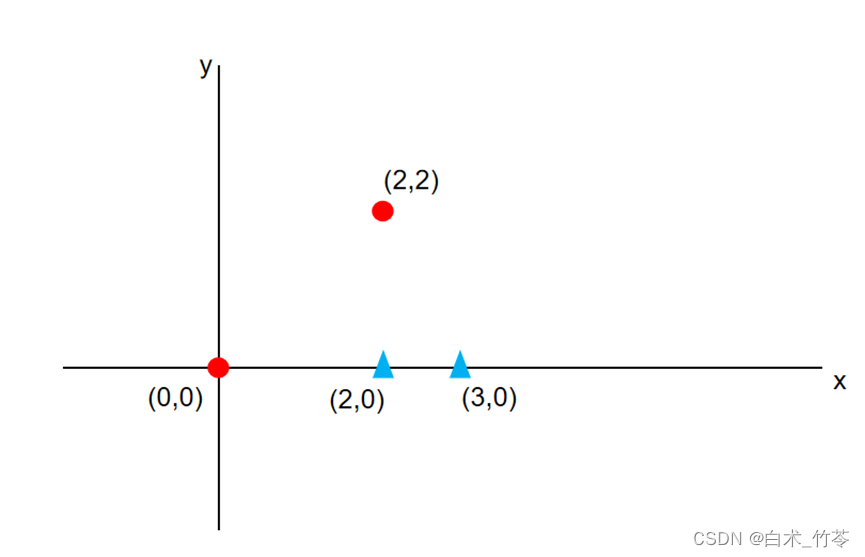

假设支持向量分别为

如下图:

则最大间隔r的值为?

B、0.4

假设有两个样本点:(V,+1),(-V,-1)。其中,V=(3,2),则使得间隔最大的决策边界为:(ps:x为横坐标轴,y为纵坐标轴)

C、3x+2y=0

有三个样本点:(x,+1),(y,+1),(z,-1),超平面为:a+b=1。其中,x=(3,0),y=(0,4),z=(0,0),则以下说法错误的为:

B、样本y到超平面的距离为3

图中,最大间隔决策边界为:

D、-x+y+1=0

下面说法正确的是?

A、支持向量机的最终模型仅仅与支持向量有关。

C、支持向量机的最终模型由离决策边界最近的几个点决定。

DBSCAN

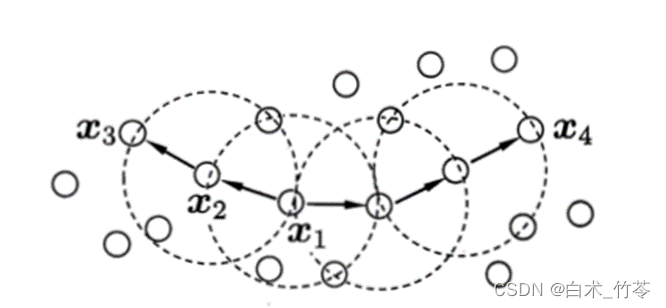

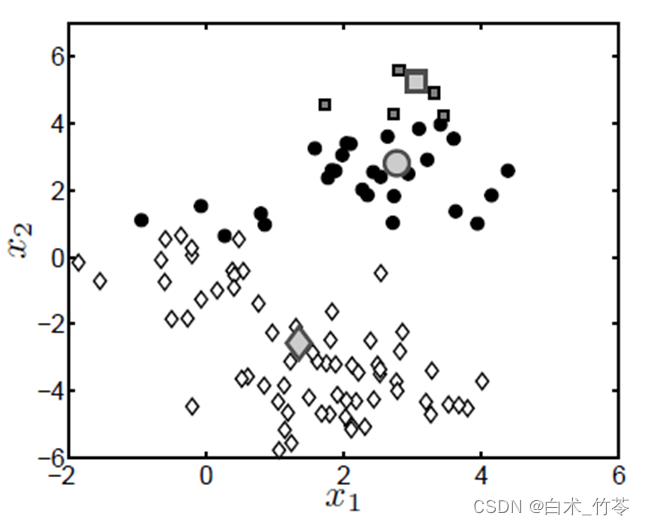

如图,假设Minpts=3,则x 2与x1 关系,x 3与x 1 关系,x 3与x 4关系分别为?

D、直接密度可达,密度可达,密度相连

任务描述

本关任务:使用Python实现DBSCAN算法,并对信用卡用户进行聚类,这里你不仅需要找出异常用户,还要将行为相似的用户划分为一组。

1. # encoding=utf8

2. import numpy as np

3. import random

4. from copy import copy

5. from collections import deque

6.

7.

8. # 寻找eps邻域内的点

9. def findNeighbor(j, X, eps):

10. return {p for p in range(X.shape[0]) if np.linalg.norm(X[j] - X[p]) <= eps}

11.

12.

13. # dbscan算法

14. def dbscan(X, eps, min_Pts):

15. """

16. input:X(ndarray):样本数据

17. eps(float):eps邻域半径

18. min_Pts(int):eps邻域内最少点个数

19. output:cluster(list):聚类结果

20. """

21. # ********* Begin *********#

22.

23. # 初始化核心对象集合

24. core_objects = {i for i in range(len(X)) if len(findNeighbor(i, X, eps)) >= min_Pts}

25.

26. # 初始化聚类簇数

27. k = 0

28.

29. # 初始化未访问的样本集合

30. not_visited = set(range(len(X)))

31.

32. # 初始化聚类结果

33. cluster = np.zeros(len(X))

34.

35. while len(core_objects) != 0:

36. old_not_visited = copy(not_visited)

37. # 初始化聚类簇队列

38. o = random.choice(list(core_objects))

39. queue = deque()

40. queue.append(o)

41. not_visited.remove(o)

42.

43. while len(queue) != 0:

44. q = queue.popleft()

45. neighbor_list = findNeighbor(q, X, eps)

46. if len(neighbor_list) >= min_Pts:

47. # 寻找在邻域中并没被访问过的点

48. delta = neighbor_list & not_visited

49. for element in delta:

50. queue.append(element)

51. not_visited.remove(element)

52.

53. k += 1

54. this_class = old_not_visited - not_visited

55. cluster[list(this_class)] = k

56. core_objects = core_objects - this_class

57.

58. # ********* End *********#

59. return cluster

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

任务描述

本关任务:你需要调用 sklearn 中的 DBSCAN 模型,对非球状数据进行聚类。

1. # encoding=utf8

2. from sklearn.cluster import DBSCAN

3.

4.

5. def data_cluster(data):

6. """

7. input: data(ndarray) :数据

8. output: result(ndarray):聚类结果

9. """

10. # ********* Begin *********#

11. dbscan = DBSCAN(eps=0.5, min_samples=10)

12. result = dbscan.fit_predict(data)

13. return result

14. # ********* End *********#

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

EM算法

似然函数L(θ∣x)中是已知量的是?

A、x

极大似然估计中,为了简化求导的过程,采用了什么方法?

B、取对数

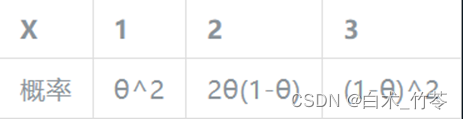

假设有一实验的概率分布为:

其中θ为未知参数,并现已经取得3个样本,分别为X1=1,x2=2,x3=1。请计算θ的极大似然估计。

D、5/6

本关任务:用 python 实现 EM 算法的单次迭代过程。请不要修改 Begin-End 段之外的代码。

1. import numpy as np

2. from scipy import stats

3.

4. def em_single(init_values, observations):

5. """

6. 模拟抛掷硬币实验并估计在一次迭代中,硬币A与硬币B正面朝上的概率

7. :param init_values:硬币A与硬币B正面朝上的概率的初始值,类型为list,如[0.2, 0.7]代表硬币A正面朝上的概率为0.2,硬币B正面朝上的概率为0.7。

8. :param observations:抛掷硬币的实验结果记录,类型为list。

9. :return:将估计出来的硬币A和硬币B正面朝上的概率组成list返回。如[0.4, 0.6]表示你认为硬币A正面朝上的概率为0.4,硬币B正面朝上的概率为0.6。

10. """

11. #********* Begin *********#

12. observations = np.array(observations)

13. counts = {'A': {'H': 0, 'T': 0}, 'B': {'H': 0, 'T': 0}}

14. theta_A = init_values[0]

15. theta_B = init_values[1]

16. # E step

17. for observation in observations:

18. len_observation = len(observation)

19. num_heads = observation.sum()

20. num_tails = len_observation - num_heads

21. # 两个二项分布

22. contribution_A = stats.binom.pmf(num_heads, len_observation, theta_A)

23. contribution_B = stats.binom.pmf(num_heads, len_observation, theta_B)

24. weight_A = contribution_A / (contribution_A + contribution_B)

25. weight_B = contribution_B / (contribution_A + contribution_B)

26. # 更新在当前参数下A、B硬币产生的正反面次数

27. counts['A']['H'] += weight_A * num_heads

28. counts['A']['T'] += weight_A * num_tails

29. counts['B']['H'] += weight_B * num_heads

30. counts['B']['T'] += weight_B * num_tails

31. # M step

32. new_theta_A = counts['A']['H'] / (counts['A']['H'] + counts['A']['T'])

33. new_theta_B = counts['B']['H'] / (counts['B']['H'] + counts['B']['T'])

34. return [new_theta_A, new_theta_B]

35.

36. #********* End *********#

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

本关任务:用 python 实现 EM 算法的迭代过程。请不要修改 Begin-End 段之外的代码。

1. import numpy as np

2. from scipy import stats

3.

4.

5. def em_single(init_values, observations):

6. """

7. 模拟抛掷硬币实验并估计在一次迭代中,硬币A与硬币B正面朝上的概率。请不要修改!!

8. :param init_values:硬币A与硬币B正面朝上的概率的初始值,类型为list,如[0.2, 0.7]代表硬币A正面朝上的概率为0.2,硬币B正面朝上的概率为0.7。

9. :param observations:抛掷硬币的实验结果记录,类型为list。

10. :return:将估计出来的硬币A和硬币B正面朝上的概率组成list返回。如[0.4, 0.6]表示你认为硬币A正面朝上的概率为0.4,硬币B正面朝上的概率为0.6。

11. """

12. observations = np.array(observations)

13. counts = {'A': {'H': 0, 'T': 0}, 'B': {'H': 0, 'T': 0}}

14. theta_A = init_values[0]

15. theta_B = init_values[1]

16. # E step

17. for observation in observations:

18. len_observation = len(observation)

19. num_heads = observation.sum()

20. num_tails = len_observation - num_heads

21. # 两个二项分布

22. contribution_A = stats.binom.pmf(num_heads, len_observation, theta_A)

23. contribution_B = stats.binom.pmf(num_heads, len_observation, theta_B)

24. weight_A = contribution_A / (contribution_A + contribution_B)

25. weight_B = contribution_B / (contribution_A + contribution_B)

26. # 更新在当前参数下A、B硬币产生的正反面次数

27. counts['A']['H'] += weight_A * num_heads

28. counts['A']['T'] += weight_A * num_tails

29. counts['B']['H'] += weight_B * num_heads

30. counts['B']['T'] += weight_B * num_tails

31. # M step

32. new_theta_A = counts['A']['H'] / (counts['A']['H'] + counts['A']['T'])

33. new_theta_B = counts['B']['H'] / (counts['B']['H'] + counts['B']['T'])

34. return [new_theta_A, new_theta_B]

35.

36. def em(observations, thetas, tol=1e-4, iterations=100):

37. """

38. 模拟抛掷硬币实验并使用EM算法估计硬币A与硬币B正面朝上的概率。

39. :param observations: 抛掷硬币的实验结果记录,类型为list。

40. :param thetas: 硬币A与硬币B正面朝上的概率的初始值,类型为list,如[0.2, 0.7]代表硬币A正面朝上的概率为0.2,硬币B正面朝上的概率为0.7。

41. :param tol: 差异容忍度,即当EM算法估计出来的参数theta不怎么变化时,可以提前挑出循环。例如容忍度为1e-4,则表示若这次迭代的估计结果与上一次迭代的估计结果之间的L1距离小于1e-4则跳出循环。为了正确的评测,请不要修改该值。

42. :param iterations: EM算法的最大迭代次数。为了正确的评测,请不要修改该值。

43. :return: 将估计出来的硬币A和硬币B正面朝上的概率组成list或者ndarray返回。如[0.4, 0.6]表示你认为硬币A正面朝上的概率为0.4,硬币B正面朝上的概率为0.6。

44. """

45. #********* Begin *********#

46. theta = np.array(thetas)#初始值

47. # 循环iterations次

48. for i in range(iterations):

49. new_theta = np.array(em_single(theta, observations))

50. # 当差异小于iterations跳出循环

51. if np.sum(np.abs(new_theta-theta))<tol:

52. break;

53. theta = new_theta

54. return theta

55. #********* End *********#

56.

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

慕课学习与练习

表1是一个由15个样本组成的贷款申请训练数据,这些数据包括贷款申请人的年龄、是否有工作、是否有房子以及信贷情况信息,表的最后一列表示是否同意该客户贷款。利用这些样本训练一棵决策树,再利用得到的决策树决定对于一个新的客户,是否同意其贷款。该问题属于( )。

A、监督学习

C、二分类问题

对于表1所给的训练数据集D,根据信息增益准则选择最优特征。分别以A_1,A_2,A_3,A_4表示年龄、有工作、有自己的房子和信贷情况4个特征。现已经计算出经验熵H(D)=0.971,不同特征划分下D的经验条件熵也已经通过计算得到:H(D|A_1 )=0.888,H(D|A_2 )=0.647,H(D|A_3 )=0.551,H(D|A_4 )=0.608。则应选取特征( )作为最优特征。

C、有自己的房子

在构建决策树的过程中,下列情况中不会导致出现叶子结点的是( )。

D、当前数据集已经经过“年龄”、“有工作”两个特征的划分,现以“信贷情况”为标准进行划分,信贷情况为“一般”的集合包含一个正例和两个反例

以下关于k近邻算法的说法中,错误的是( )

A、k近邻法中,当训练集、距离度量、分类决策规则确定后,其结果唯一确定

B、k取值过小会导致过拟合,因此k值应尽可能大

数据点(1,3)和(5,6)之间的欧氏距离和曼哈顿距离分别是( )。

B、5,7

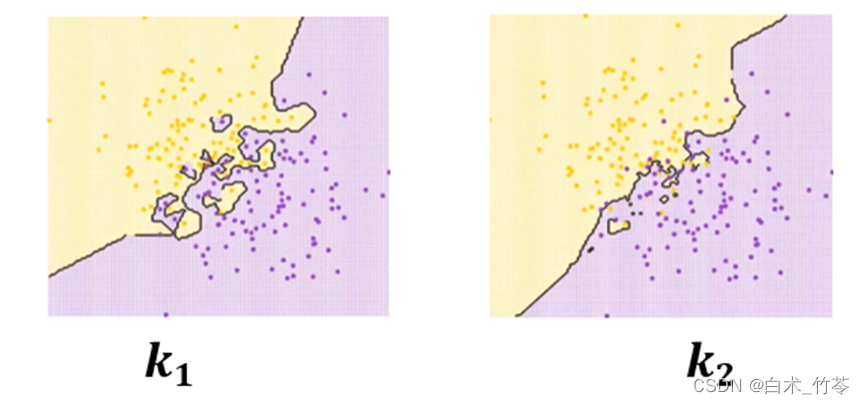

以下两个图中,训练集、距离度量、分类决策规则都相同的情况下,k值的大小关系为()。

C、k1<k2

以下关于K-means算法的说法中,正确的是( )。

D、K-means算法容易陷入局部最优

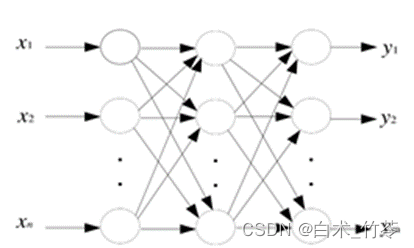

以下哪个网络属于多层前馈神经网络( )

以下关于神经元和感知机的说法中,错误的是( )。

D、感知机由两层或两层以上神经元组成,可以解决复杂的问题

以下关于误差逆传播算法的说法中,错误的是( )

B、学习率η过大会导致震荡,因此越小越好

PCA

下列说法正确的是

B、降维能够缓解维数灾难的负面影响

C、使用原始数据训练出的回归器已经过拟合,可试试降维来提升性能

下列说法错误的是

C、维数灾难不会引起过拟合

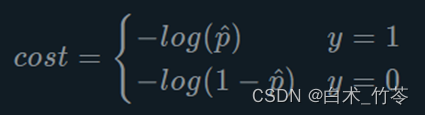

逻辑回归

逻辑回归的损失函数可以写成如下形式

A、对

下列说法正确的是

A、损失值能够衡量模型在训练数据集上的拟合程度

C、sigmoid函数的输入越大,输出就越大

D、训练的过程,就是寻找合适的参数使得损失函数值最小的过程

sigmoid函数(对数几率函数)相对于单位阶跃函数有哪些好处?

A、sigmoid函数可微分

B、sigmoid函数处处连续

逻辑回归的优点有哪些?

D、可以用现有的数值优化算法求解

绪论

下面哪种方法属于机器学习?

B、将大量名画的真品与赝品输入计算机,让计算机自己从数据中学习出一个模型用来判断是真品还是赝品。

C、让计算机通过对以往的房价数据进行分析,预测未来房价走势。

以下是我们的一份数据集,则x 32表示的是?

B、硬挺

我们现在手头上有大量的猫与狗的图片,我现在想训练出一个模型,能够区别出这张图片是猫还是狗,这是一个什么问题?

B、分类

我们现在手头上有大量的动物的图片,为了方便处理,我们想让同一种动物的图片放到同一个文件夹,这是一个什么问题?

A、聚类

D、无监督学习

在无人驾驶时,希望程序能够根据路况决策汽车的方向盘的旋转角度,那么该任务是?

B、回归

机器学习的主要任务

朴素贝叶斯算法属于有/无监督学习的回归/分类算法?

A、监督学习;分类

机器学习之神经网络概述

神经网络中最基本的单元是( )

A、神经元

下列关于神经网络说法正确的有( )

A、在 M-P 神经网络模型中,神经元收到n个其他神经元传递过来的输入信号,这些信号通过带权重的连接传递给细胞体,这些权重又称为连接权。

B、感知机只有输出层神经元进行激活函数处理,即只拥有一层功能神经元。

C、神经网络是由具有适应性的简单单元组成的广泛并行互连的网络,它的组织能够模拟生物神经系统对真实世界物体所作出的交互反应。

D、感知机油两层神经元组成,输入层接收外界信号后传给输出层。

要解决非线性可分问题,要使用多层功能得神经元。( )

A、对

机器学习简述

以下关于机器学习的基本含义,说法正确的一项是()

D、以上都对

关于机器学习的应用场景,包括以下哪一项()

D、以上都对

以下哪一项应用属于模式识别()

D、以上都是

以下不属于机器学习具体应用的一项是()

A、数字货币

机器学习涉及到的学科,包括以下哪一项()

D、以上都是

以下不属于模拟人脑的机器学习的是()

B、聚类算法

以下不属于统计机器学习三要素的一项是()

C、经验

以下不属于基于学习方式的分类的一项是()

D、归纳学习

以下属于学习目标的一项是()

D、以上都是

以下关于机器学习的基本类型,说法不正确的一项是()

C、典型参数学习主要有神经网络学习

以下不属于需求分析的一项是()

D、数据清洗

以下属于数据清洗方法的一项是()

A、对原始数据中出现的噪声进行修复、平滑或者剔除

以下关于特征工程,说法不正确的一项是()

D、增加变量之间的相关性,用少数新的变量来尽可能反映样本的信息

以下属于常见分类模型评估方法的一项是()

D、以上都是

以下不属于算法建模过程中涉及到的一项是()

C、特征选择

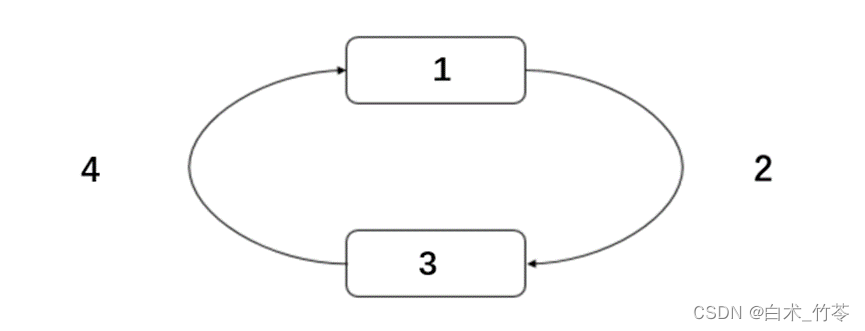

初识强化学习

强化学习是智能体(Agent)以()的方式进行学习

C、试错

强化学习四要素包括以下哪些?(多选)

A、状态

B、动作

C、策略

D、奖励

RL最重要的3个特性在于?(多选)

A、通常是一种闭环的形式

B、不会直接指示选择哪种行动(actions)

C、一系列的 actions 和奖励信号(reward signals)都会影响之后较长的时间

请将A:Agent B:State,RewardC:ActionD:Environment填入对应的序号当中

D、ACDB

机器学习可以分为以下哪三类?

A、supervised learning

B、unsupervised learning

D、reinforcement learning

强化学习是否实现了真正的工业级应用 ?

B、否

____年,阿尔法围棋与围棋世界冠军、职业九段棋手李世石进行围棋人机大战并获胜。

C、2016

强化学习核心的_____为机器人复杂的工程设计提供了可能,

B、 MDP 序列决策特性

强化学习在城市交通领域的应用中,______充当了MDP过程中的智能体

A、辅助/自助驾驶控制系统

强化学习作为一种有效的基于用户与系统交互过程建模和最大化累积收益的学习方法, 在下列哪些场景中有所应用?(多选)

A、信息检索

B、商品推荐

C、广告推送

为了进一步向通用人工智能的目标迈进, 强化学习研究与应用可以从以下哪几个方向进行努力?

A、借助监督学习手段, 提高强化学习鲁棒性.

B、构建更智能的强化学习表示与问题表述方式.

C、开发针对实体输入的强化学习算法, 应对实际

工业生产应用.

D、添加记忆模块, 利用上下文信息增强强化学习

的自主学习能力.

____是强化学习系统中的决策者和学习者,可以做出决策和接受奖励信号。

C、智能体

____是强化系统中除智能体以外的所有事物,是智能体交互的对象。

D、环境

强化学习的基本过程是一个_____过程。

B、马尔科夫决策

马尔科夫决策过程可以用 构成的四元组{s, a, p, r}表示

A、状态 (State)

B、 行动 (Action)

D、 状态转移概率 (Possibility)

E、状态转移奖励或回报 (Reward)

行动与环境发生交互, 环境以奖励的形式对智能体的行动给出相应的反馈;那么,该行动能否改变智能体的状态呢?

B、能

强化模型分类中,___是去学习和理解环境,学会用一个模型来模拟环境,通过模拟的环境来得到反馈。

B、基于模式(Model Based)

Model-free 的方法有很多, 以下哪些方法属于Model-free 的方法?(多选)

B、 Q learning

C、Sarsa

D、Policy Gradients

Value-Based的方法输出的是____?

A、动作的价值

Actor-Critic方法属于以下那种类别?

C、Policy-Based与Value-Based二者的结合

以下那个答案符合本句的描述:_____的方法是指整个学习过程全部结束后再进行更新,____的方法是指学习过程中的每一步都在更新。

A、回合更新,单步更新

下列那个选项符合本句:_指的是学习的过程agent必须参与其中,典型的算法为。_____指的是既可以自己参与其中,也可以根据他人学习过程进行学习。

D、在线学习(on-policy),Sarsa,离线学习(off-policy)

机器学习中的数学

以下模型中我们选择哪个模型效果最好?

A、方差小,偏差小

衡量预测值之间的关系我们可以使用____.

B、方差

常用的估计方法有哪些?

A、最大似然估计

B、最大后验估计

C、贝叶斯估计

当模型的偏差较高的时候我们可以怎么做?

A、增加特征

B、获得更多的特征

C、增加多项式特征

D、减少正则化程度

模型的方差较高时,我们如何解决呢?

A、减少特征数量

B、增加正则化程度

C、增加训练数据

对求极大似然估计值的一般步骤进行排序:1. 求导 2. 对似然函数求对数,并简化整理 3. 解似然方程 4. 写出似然函数

B、4213

最大似然估计的英文缩写为:

B、MLE

假如在100次从装有黑白球的罐中每次取一个球后放回,有30次是白球,请问罐中白球所占的比例最有可能是多少?

B、30%

在前面的100次重复记录中,有30次是白球,罐中白球的比例是p,黑球的比例是1-p,其似然函数是?

B、p30(1-p)70

当我们求出似然函数之后要对其进行:

B、取对数

P(A|B)是已知___发生后的___条件概率。

C、B,A

P(A)是A的____,P(B|A)是已知___发生后___的条件概率.

A、先验概率,A,B

下面的公式为____.

D、全概率公式

贝叶斯估计的求解步骤排序为: 1.确定参数的先验分布 2.根据贝叶斯公式求解参数的后验分布 3.求联合分布 4.求后验密度

B、1342

如果后验分布的范围较窄,则估计值的准确度相对较高,反之,如果后验分布的范围较广,则估计值的准确度就较低。请问这种说法正确吗?

A、正确

概率论之条件概率

P(AB)表示的是事件A与事件B同时发生的概率,P(A|B)表示的是事件B已经发生的条件下,事件A发生的概率。

A、对

从1,2,…,15中小明和小红两人各任取一个数字,现已知小明取到的数字是5的倍数,请问小明取到的数大于小红取到的数的概率是多少?

C、9/14

集成学习简述

对于一个二分类问题,假如现在训练了500个子模型,每个模型权重大小一样。若每个子模型正确率为51%,则整体正确率为多少?若把每个子模型正确率提升到60%,则整体正确率为多少?

C、65.7%,99.99%

决策树简述

下列说法正确的是?

A、训练决策树的过程就是构建决策树的过程

B、ID3算法是根据信息增益来构建决策树

下列说法错误的是?

B、决策树只能是一棵二叉树

KNN算法简述

下列说法正确的是?

A、kNN算法的预测效率与训练集的数量有关

D、kNN算法属于监督学习

下列说法错误的是

A、kNN算法的训练阶段需要构建模型

机器学习概述

在____学习中,每个实例都是由一个输入对象(通常为矢量)和一个期望的输出值(也称为监督信号)组成。

A、监督

有监督算法常见的有哪些?

A、KNN

B、线性回归算法

C、决策树

聚类是监督学习的代表,这样的表述正确吗?

B、不正确

无监督学习的方法分为以下哪些类?

A、基于概率密度函数估计的直接方法

B、基于样本间相似性度量的简洁聚类方法

监督学习和无监督学习有以下哪些区别?

A、训练样本不同

B、核心

C、可解释性不同

D、规律性不通

通过作业可以知道不同学生学习情况、进步的速度快慢这一过程属于以下哪种?

B、验证

常用的评估方法有哪些?

A、k折交叉验证

B、自助法

C、留出法

____在数据集较小难以有效划分训练集和测试集时很有用。

B、自助法

评价指标有以下哪几种?

A、召回率(Recall)

B、准确率(Accuracy)

C、F1_score

D、精确率(Precision)

学习器在训练集上的误差称为____,在新样本上的误差称为____.

B、“训练误差”(training error),“泛化误差”(generalizationerror)

k折交叉验证是留一法的特例,这种表达正确吗?

B、不正确

机器学习基本含义

机器学习数据集可划分为训练集和测试集

A、对

下列属于监督学习的有

A、分类

B、回归

机器学习致力于研究如何通过计算的手段,利用经验来改善系统自身的性能。

A、对

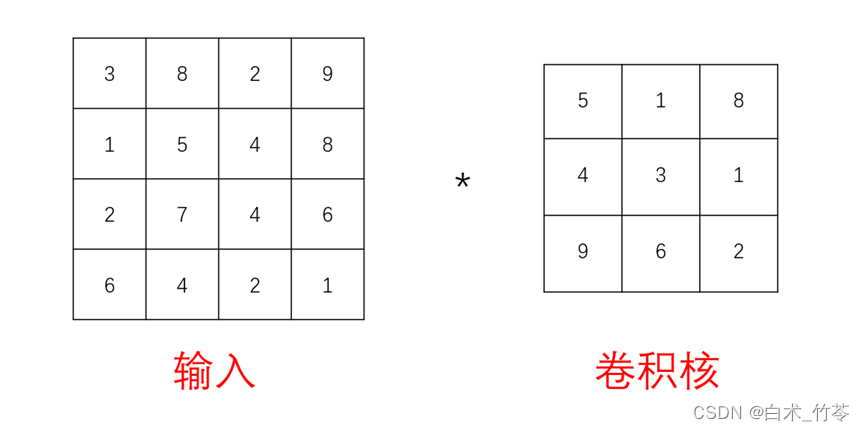

神经网络学习之卷积神经网络

已知输入和卷积核,求下列图片中卷积运算的输出结果:

C、[ [ 130 , 253 ] ,

[ 157 , 189 ] ]

已知输入是10∗10的矩阵,卷积核高宽都为5,请问,结果的高和宽分别为多少?

B、高为6,宽为6。

已知输入形状为:10∗10,卷积核的形状为5∗5,求当需要输出形状为10∗10时,需要填充的大小为:

B、2

已知输入形状为:10∗10,卷积核的形状为5∗5,是Valid卷积,则需要填充的大小为:

A、0

已知输入形状为:10∗10,卷积核的形状为5∗5,填充大小为1,求当需要输出形状为8∗8时,需要的步幅大小为:

A、1

已知输入的形状为n∗n,卷积核形状为3∗3,填充大小为2,步幅为1,输出大小为15∗15,请问,输入的形状为:

B、13*13

已知输入的形状为3∗24∗24,想要输出的形状为16∗24∗24,请问卷积核的形状应为:

C、3163*3,填充为1,步幅为1

已知池化层的输入为3∗224∗224,池化层形状为2∗2,步幅为2,求输出结果的形状为:

D、3∗112∗112

kNN算法原理

下列说法正确的是?

A、kNN算法的预测效率与训练集的数量有关

D、kNN算法属于监督学习

下列说法错误的是

A、kNN算法的训练阶段需要构建模型

数据科学导论——数据科学认知

假设有两碗曲奇饼,碗A包含30个香草曲奇饼和10个巧克力曲奇饼,碗B这两种曲奇饼各20个。 现在假设你在不看的情况下随机地挑一个碗拿一块饼,得到了一块香草曲奇饼。从碗A渠道香草曲奇饼的概率是多少?

A、0.6

假设一个学校里有60%男生和40%女生。女生穿裤子的人数和穿裙子的人数相等,所有男生穿裤子。一个人在远处随机看到了一个穿裤子的学生。那么这个学生是女生的概率是多少?

B、0.25

以下哪种方法为无监督类型机器学习方法?

C、聚类

以下哪些为连续型变量?

A、温度

B、身高

C、房价

以下哪些模型适用于回归的任务?

A、简单回归模型

B、多项式回归模型

C、多元线性回归模型

以下哪个统计指标能反映机器学习结果的自身不稳定性?

B、方差

在多项式回归中,随着多项式的最大指数p增加,训练得到的回归模型表现会是下面怎样的情形?

B、在训练集合上偏差小

C、在测试集合上方差大

以下哪种回归模型可以有效利用特征之间的交互?

C、神经网络回归模型

聚类属于有监督学习。

B、错误

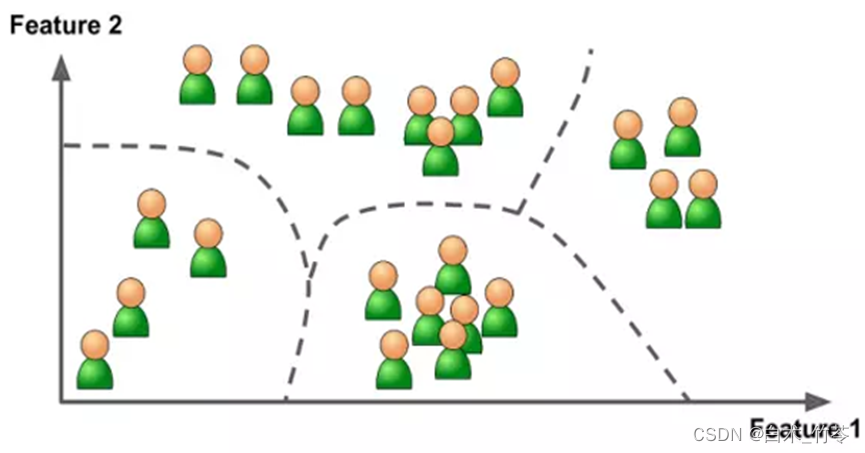

这两幅图主要体现了聚类思想。

A、正确

以下哪些名言体现了聚类思想?

A、“物以类聚,人以群分”

B、“不是一家人,不进一家门”

以下哪一些属于聚类方法的典型应用?

A、用户商品推荐

B、基因功能预测

C、对web上的文档进行归类

k均值方法属于下列哪一类聚类方法?

A、基于划分的聚类

均值移动属于下列哪种聚类方法?

B、基于密度的聚类

以下属于聚类方法的有?

A、谱聚类

B、DBSCAN

支持向量机简介

训练SVM的最小时间复杂度为O(n2),那么一下哪种数据集不适合用SVM?

A、大数据集

支持向量是那些最接近决策平面的数据点。

A、对

SVM在下列那种情况下表现糟糕:

C、含噪声数据与重叠数据点

如果我使用数据集的全部特征并且能够达到100%的准确率,但在测试集上仅能达到70%左右,这说明:

C、过拟合

如果使用较小的C(C趋于0),则:

A、误分类

使用条件概率来分类

下列关于贝叶斯分类方法优点的说法,错误的是?

D、无论是类别类输入还是数值型输入(默认符合正态分布)目前还没有相应模型可以运用。

条件概率

对以往数据分析结果表明,当机器调整得良好时,产品的合格率为98 ,而当机器发生某种故障时,其合格率为55%。每天早上机器开动时,机器调整良好的概率为95%。试求已知某日早上第一件产品是合格品时,机器调整良好的概率是多少?

D、0.97

数据科学导论——分类的概念

分类问题属于下列哪一类?

A、有监督学习

下列哪些不属于分类问题的典型应用?

B、智能音箱控制家电

D、购物网站为顾客推荐“猜你喜欢”

分类问题需要预测的变量为离散整数值或者连续实数均可。

B、错误

根据输出结果形式,分类器可分为概率和非概率分类器。

A、正确

下列哪些属于非概率分类器?

C、k近邻

D、支持向量机

手写数字识别应该采用何种方法?

B、非概率分类器

强化学习与机器学习

“强化学习(Reinforcement Learning)是机器学习的一个分支,它的原理是:在交互环境中,智能体利用自身的经验和反馈,通过试验和错误经验来进行学习。”这句话是否正确?

A、正确

下列关于强化学习的描述正确的是?

A、强化学习学习得非常快,因为每一个新的反馈(例如执行一个行动并获得奖励)都被立即发送到影响随后的决定。

B、强化学习中的环境指的是,智能体所处的物理世界。

C、为了得到最优的方案,智能体既需要探索新的状态,又要同时尽量取得最多的奖励。

D、马尔可夫决策过程(MDP)是所有强化学习环境的数学框架,几乎所有强化学习问题都可以使用MDP来搭建模型。

下列关于确定基本的强化学习问题的描述正确的是?

A、描述强化学习问题的关键元素是:环境,状态,奖励,方案,价值。

B、强化学习问题的关键元素状态是指:智能体目前的状态。

C、强化学习问题的关键元素奖励是指:从环境中得到的反馈。

关于强化学习和机器学习的概述说法正确的是?

A、强化学习(Reinforcement Learning)是机器学习的一个分支。

B、无监督学习的目标仅仅是找到数据之间的相似和不同,而强化学习的目标却是找到一个能最大化智能体总累计奖励的模型。

C、有监督学习和强化学习都会明确指出输入和输出之间的映射关系。

强化学习基本含义

下列关于强化学习原理的描述正确的是?

A、强化学习(Reinforcement Learning, RL),又称再励学习、评价学习或增强学习,是机器学习的范式和方法论之一。

B、强化学习的常见模型是标准的马尔可夫决策过程(Markov Decision Process, MDP)。

C、强化学习不同于监督学习和非监督学习,强化学习不要求预先给定任何数据,而是通过接收环境对动作的奖励(反馈)获得学习信息并更新模型参数 。

D、深度学习模型可以在强化学习中得到使用,形成深度强化学习

下列关于强化学习的基本模型和原理的描述错误的是?

D、强化学习系统学习的目标是静态地调整参数。

下列关于强化学习的描述正确的是?

A、强化学习与监督式学习, 非监督式学习是有区别的。

B、强化学习和监督式学习的区别在于强化学习面对的输入总是在变化,每当算法做出一个行为,它影响下一次决策的输入,而监督学习的输入是独立同分布的。

C、非监督式不是学习输入到输出的映射,而是模式。而强化学习将通过向用户先推荐少量的新闻,并不断获得来自用户的反馈。

“强化学习是智能体(Agent)以“试错”的方式进行学习,通过与环境进行交互获得的奖赏指导行为,目标是使智能体获得最大的奖赏。”这句话是否正确?

A、正确

深度学习应用场景

“深度学习在搜索技术,数据挖掘,机器学习,机器翻译,自然语言处理,多媒体学习,语音,推荐和个性化技术,以及其他相关领域都取得了很多成果。深度学习使机器模仿视听和思考等人类的活动,解决了很多复杂的模式识别难题,使得人工智能相关技术取得了很大进步。”这句话对深度学习的描述是否正确?

B、正确

下列对深度学习在物体检测的应用场景说法正确的是?

A、物体识别属于深度学习在机器视觉领域的应用

B、物体检测是从图像中确定物体的位置,并进行分类的问题。

C、物体检测比物体识别(以整个图像为对象进行识别)更难,因为物体检测需要对图像中的每种类别进行识别并判断其位置。

D、我们还可以使用多个基于CNN的方法,其中一个较为有名的方法是R-CNN,来实现物体检测。

下列关于深度学习应用场景的描述正确的是?

A、深度学习已经在图像、语音、自然语言处理等各个不同的领域展现出了优异的性能。

B、图像分割是深度学习的应用场景之一,图像分割是指在像素水平上对图像进行分类。

C、自动驾驶是深度学习的应用场景之一,自动驾驶技术中,正确识别周围环境的技术尤为重要。

强化学习

智能体(Agent)外部的所有事物,并受智能体动作的影响而改变其状态,并反馈给智能体相应的奖励的是?

C、环境

强化学习的目标是?

A、学习到一个策略来最大化期望。

马尔可夫决策过程中计算状态值函数的目的是?

A、为了构建学习算法从数据中得到最优策略。

蒙特卡罗与时序差分方法(Temporal Difference)的区别是?

C、蒙特卡罗需要获得完整轨迹,才能进行策略评估并更新,时序差分法利用一步预测方法来计算当前状态值函数。

在Q-learning方法中采用递进的方式更新原有Q值的好处是?

D、能够减少估计误差造成的影响,类似随机梯度下降,最终收敛到最优Q值。

深度强化学习的核心问题是?

A、使用深度神经网络做值函数近似。

与Q-Learning相比,DQN主要改进为?

A、DQN利用深度卷积网络(Convolutional Neural Networks,CNN)来逼近值函数

B、DQN利用经验回放训练强化学习的学习过程

C、DQN独立设置了目标网络来单独处理时序差分中的偏差

Q-Leaning 方法所遇到的两个问题是?

B、交互得到的序列存在一定的相关性。

C、交互数据的使用效率。

Replay Buffer包含哪两个过程?

B、收集样本

C、采样样本

深度强化学习通过什么算法来更新参数?

B、梯度下降算法

支持向量机算法

什么是支持向量机?

A、支持向量机是一种用于分类和回归的监督学习算法,目的是在特征空间中找到间隔最大的超平面。

B、支持向量机是一种快速可靠的机器学习线性分类器,能在有限的数据量下达到很好的性能。

C、SVM算法的原理就是找到一个分割超平面,它能把数据正确的分类,并且间距最大。

支持向量机包含哪几种模型?

A、硬间隔支持向量机

B、软间隔支持向量机

C、非线性支持向量机

SVM是否只能处理二分类任务?

B、否

为什么引入核函数?

A、SVM核函数的引用主要将非线性分类问题转换为线性分类问题

SVM有哪些核函数?

A、线性核函数

B、多项式核函数

C、高斯核函数

线性回归算法

线性回归又被称为什么?

A、最小二乘法

线性回归的原理:

D、找到数据集中y的预测值和其真实值的平方差最小的时候,所对应的w值和b值

最小二乘法的误差在什么情况下符合极大似然估计的思想?

B、正态分布

线性回归方程公式:

C、y=w*x+b

线性回归简述

下面属于多元线性回归的是?

B、建立股票价格与成交量、换手率等因素之间的线性关系。

C、建立西瓜价格与西瓜大小、西瓜产地、甜度等因素之间的线性关系。

若线性回归方程得到多个解,下面哪些方法能够解决此问题?

A、获取更多的训练样本

B、选取样本有效的特征,使样本数量大于特征数

C、加入正则化项

下列关于线性回归分析中的残差(预测值减去真实值)说法正确的是?

A、残差均值总是为零

机器学习概述

在____学习中,每个实例都是由一个输入对象(通常为矢量)和一个期望的输出值(也称为监督信号)组成。

A、监督

有监督算法常见的有哪些?

A、KNN

B、线性回归算法

C、决策树

聚类是监督学习的代表,这样的表述正确吗?

B、不正确

无监督学习的方法分为以下哪些类?

A、基于概率密度函数估计的直接方法

B、基于样本间相似性度量的简洁聚类方法

监督学习和无监督学习有以下哪些区别?

A、训练样本不同

B、核心

C、可解释性不同

D、规律性不通

通过作业可以知道不同学生学习情况、进步的速度快慢这一过程属于以下哪种?

B、验证

常用的评估方法有哪些?

A、k折交叉验证

B、自助法

C、留出法

____在数据集较小难以有效划分训练集和测试集时很有用。

B、自助法

评价指标有以下哪几种?

A、召回率(Recall)

B、准确率(Accuracy)

C、F1_score

D、精确率(Precision)

学习器在训练集上的误差称为____,在新样本上的误差称为____.

B、“训练误差”(training error),“泛化误差”(generalizationerror)

k折交叉验证是留一法的特例,这种表达正确吗?

B、不正确

下面哪种方法属于机器学习?

B、将大量名画的真品与赝品输入计算机,让计算机自己从数据中学习出一个模型用来判断是真品还是赝品。

C、让计算机通过对以往的房价数据进行分析,预测未来房价走势。

以下是我们的一份数据集,则x 32表示的是?

B、硬挺

我们现在手头上有大量的猫与狗的图片,我现在想训练出一个模型,能够区别出这张图片是猫还是狗,这是一个什么问题?

B、分类

我们现在手头上有大量的动物的图片,为了方便处理,我们想让同一种动物的图片放到同一个文件夹,这是一个什么问题?

A、聚类

D、无监督学习

在无人驾驶时,希望程序能够根据路况决策汽车的方向盘的旋转角度,那么该任务是?

B、回归

人工智能概述

达特茅斯会议是谁发起的?

B、麦卡锡

“人工智能”这个词最早是由麦卡锡提出来的

B、错

下列哪些属于人工智能?

A、计算机下五子棋

B、无人驾驶

C、验证码识别

D、聊天机器人

智能推荐不需要大量的历史数据

B、错

人工智能不仅仅只能用于智能推荐、能源控制、自动驾驶和智能助理

A、对