- 1【python 13】计算机视觉:基本的图像处理_python 图像处理

- 2如何用docker架设chatgpt-on-wechat实现微信问答机器人_chatgpt-on-wechat docker 部署

- 3转行零基础学习Python编程,从入门到放弃,方法你确定用对了吗?_我在学python编程

- 4 前端开发周报: CSS 布局方式与JavaScript数据结构和算法

- 5打工人好用的大模型问答,还需要一款可靠的文档解析工具

- 6js代码中“use strict” 是什么意思? 使用它的区别是什么?_.javascript 代码中的”use strict”;是什么意思 ? 使用它区别是什么?

- 7ubuntu 配置用户登录失败尝试次数限制_ubuntu对账户远程登录失败做安全限制,比如远程登录失败三次锁定60秒

- 8VALSE 2024 Workshop报告分享┆ 大规模自动驾驶仿真系统研究

- 9testbench仿真赋值时,为符合真实情况,时序逻辑应延迟一拍

- 10利用yolov5输出提示框,segment-anything生成掩膜实现图像的自动标注_yolov5 segment

TENT: FULLY TEST-TIME ADAPTATION BY ENTROPY MINIMIZATION--论文笔记

赞

踩

论文笔记

资料

1.代码地址

https://github.com/DequanWang/tent

2.论文地址

https://arxiv.org/abs/2006.10726

1论文摘要的翻译

在这种完全测试时适应的情况下,模型只有测试数据和自身参数。我们建议通过测试熵最小化(tent)进行适应:我们通过预测熵来优化模型的置信度。我们的方法会估算归一化统计量,并优化通道仿射变换,以便在每个批次上进行在线更新。Tent 降低了损坏的 ImageNet 和 CIFAR-10/100 图像分类的泛化误差,并达到了最先进的误差。在从 SVHN 到 MNIST/MNIST-M/USPS 的数字识别、从 GTA 到 Cityscapes 的语义分割以及 VisDA-C 基准上,Tent 处理了无源域适应。这些结果是在不改变训练的情况下,通过一次测试时间优化取得的。

2论文的创新点

2.1

强调了只有目标数据而没有源数据的完全测试时适应的设置。为了强调推理过程中的实际适应性,我们对离线和在线更新进行基准测试

2.2

我们将熵作为自适应目标,并提出了一种测试时间熵最小化方案(Tent),通过降低测试数据上模型预测的熵来减少泛化误差

2.3

对于对的鲁棒性,tent在ImageNet-C上达到44.0%的错误率,优于鲁棒训练(50.2%)和测试时间标准化的强基线(49.9%)

2.4

对于领域自适应,tent能够在线和无源地适应数字分类和语义分割,甚至可以与使用源数据并进行更多优化的方法相媲美

3 论文方法的概述

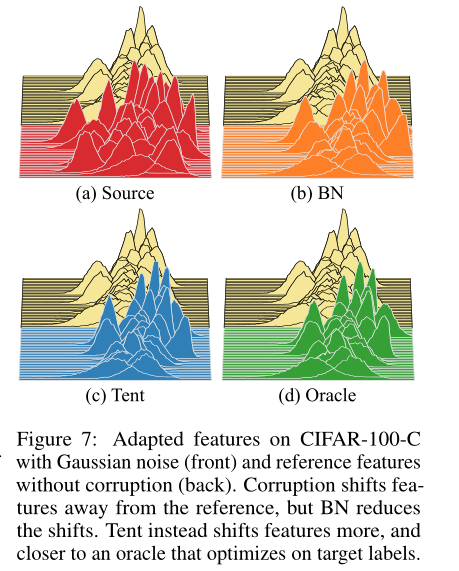

熵与误差有关,置信度更高的预测总体上更正确,下图为在熵低的数据集上预测具有更低的误差。所以确定性可以作为测试过程中的监督。

这里发现熵与corruption造成的偏移有关,因为corruption越多,熵就越大,随着corruption程度的增加,熵 与 图像分类的loss有很强的相关性。

为了最小化熵,tent通过估计统计量和逐批优化仿射参数对目标数据的推理进行归一化和转换。这种选择的低维、通道特征调制在测试期间是有效的,即使是在线更新。tent不限制或改变模型训练:它独立于给定模型参数的源数据。如果模型可以运行,就可以进行调整。最重要的是,tent不仅有效地减少了熵,还减少了误差。

本文的研究结果评估了图像分类中对corruption的泛化,对数字识别的域移位,以及对语义分割的模拟到真实移位。对于具有更多数据和优化的上下文,我们评估了给定标记源数据的鲁棒训练、领域适应和自监督学习方法。在给定目标数据的情况下,Tent可以实现更小的错误,并且在ImageNet-C基准测试的基础上进行了改进。分析实验支持我们的熵目标,检查对数据量的敏感性和适应参数的选择,并支持跨架构的普遍性

Adaptation处理从源到目标的泛化的任务。在源数据和标签

x

s

x^s

xs,

y

s

y^s

ys上训练参数为θ的模型

f

θ

(

x

)

f_θ(x)

fθ(x)在移位的目标数据

x

t

x^t

xt上测试时可能无法泛化。

我们的tent只需要模型

f

θ

f_θ

fθ和未标记的目标数据

x

t

x^t

xt在推理过程中进行自适应。

下图是总结的 适应设置、所需数据和损失类型。

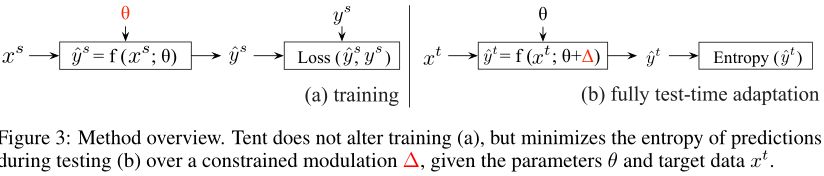

我们在测试期间优化模型,通过调节其特征来最小化其预测的熵。我们把我们的方法tent称为测试熵。下图概述了tent的方法过程。

3.1 ENTROPY OBJECTIVE

我们的TTA的目标 L ( x t ) L(x^t) L(xt)是最小化模型预测的熵 H ( y ) H(y) H(y)。

3.2 MODULATION PARAMETERS

模型参数

θ

θ

θ是测试时间优化的自然选择,这些是对train-time entropy最小化的先验工作的选择然而,

θ

θ

θ是我们设置中训练/源数据的唯一表示,改变

θ

θ

θ可能会导致模型偏离其训练。此外,

f

f

f可能是非线性的,

θ

θ

θ可能是高维的,这使得优化对test-time的使用过于敏感和低效。

为了稳定性和效率,我们只更新线性(尺度和移位)和低维(通道方向)的feature modulations。上图显示了显示了modulations的两个步骤

- 通过统计数据进行规范化和通过参数进行转换。归一化将输入 x x x集中并标准化为 ¯ x = ( x − µ ) / σ ¯x = (x−µ)/σ ¯x=(x−µ)/σ,通过其平均值µ和标准差σ。

- 变换通过尺度 γ γ γ和位移 β β β的仿射参数将 ¯ x ¯x ¯x转换为输出 x 0 = γ ¯ x + β x0 = γ¯x + β x0=γ¯x+β。注意,统计量 µ µ µ, σ σ σ是从数据中估计的,而参数 γ γ γ, β β β是通过损失优化的。

为了实现,我们只需重新利用源模型的规范化层。我们在测试过程中更新了所有层和通道的归一化统计量和仿射参数。

3.3 ALGORITHM

- Initialization

优化器收集源模型中每个归一化层 l l l和通道 k k k的仿射变换参数 γ l , k , β l , k {γl,k, βl,k} γl,k,βl,k。其余参数 θ θ θ\ γ l , k , β l , k {γl,k, βl,k} γl,k,βl,k是固定的。源数据的归一化统计 µ l , k , σ l , k {µl,k, σl,k} µl,k,σl,k将被丢弃。 - Iteration

每一步更新一批数据的规范化统计信息和转换参数。在向前传递期间,依次估计每层的归一化统计量。在反向传递过程中,通过预测熵 ∇ H ( y ) ∇H(y) ∇H(y)的梯度来更新变换参数 γ 、 β γ、β γ、β。注意,转换更新遵循当前批处理的预测,因此它只影响下一个批处理(除非重复forward操作)。每个额外的计算点只需要一个梯度,所以我们默认使用这个方案来提高效率。 - Termination

对于在线适配,不需要终止,只要有测试数据,迭代就会继续。对于离线自适应,首先更新模型,然后重复推理

当然,适应可以通过多个时代的更新来继续。

4 论文实验

我们评估了tent在CIFAR-10/CIFAR-100和ImageNet上的corruption鲁棒性,以及SVHN对MNIST/MNIST- m /USPS的数字自适应的领域适应性。

数据集

CIFAR-10、CIFAR-100、ImageNet上的损坏鲁棒性,

MNIST、MNIST- m 、USPS

基础模型

对于corruption,我们使用残差网络, CIFAR10/100上有26层(R-26), ImageNet上有50层(R-50)。

对于domain adaption,我们使用R-26架构。为了公平比较,每个实验条件下的所有方法都使用相同的架构。

训练超参数

我们根据源模型的训练超参数对调制参数 γ , β γ, β γ,β进行了优化,并且变化很小。在ImageNet上,我们使用SGD进行动量优化;在其他数据集上,我们由Adam优化(Kingma & Ba, 2015)。我们降低批大小(BatchSize, BS)以减少用于推理的内存使用,然后通过相同的因素降低学习率(LearningRate, LR)以进行补偿(Goyal等人,2017)。在ImageNet上,我们设置BS = 64, LR = 0.00025,在其他数据集上,我们设置BS = 128, LR = 0.001。我们通过随机打乱和跨方法共享顺序来控制排序。

基线任务

- Source将训练好的分类器应用于测试数据而不进行自适应;

- 对抗性域自适应(RG)反转域分类器在源和目标上的梯度,以优化域不变表示

- 自监督域自适应(UDA-SS)在源和目标上联合训练自监督旋转和定位任务,以优化共享表示

- 测试时训练(TTT)在源上对监督任务和自监督任务进行联合训练,然后在测试过程中对目标上的自监督任务进行持续训练

- 测试时间归一化(test-time normalization, BN)在测试过程中更新目标数据上的批归一化统计

- 伪标记(PL)调整置信度阈值,将超过阈值的预测分配为标签,然后在测试之前针对这些伪标签优化模型

4.1 稳健性 TO CORRUPTIONS

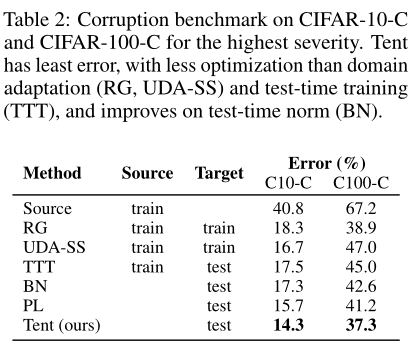

Tent用更少的数据和计算提高了性能。下表报告了在最严重的corruptions程度下不同腐败类型的平均错误。在CIFAR-10/100-C上,比较了所有方法,包括那些需要跨域或损失联合训练的方法,同时考虑到这些数据集的方便大小。这里的适应是离线的,以便与离线基线进行公平比较。Tent改进了全测试时间自适应基线(BN, PL),也改进了域自适应(RG, UDA-SS)和测试时间训练(TTT)方法,这些方法需要在源和目标上进行多次优化。

下图绘制了在ImageNet-C上每种损坏类型在损坏级别上的平均误差。

4.2 SOURCE-FREE DOMAIN ADAPTATION

Tent适应无源目标。表3报告了域适应和完测试时间适应方法的目标误差。测试时间归一化(Test-time normalization, BN)的性能略有提高,而对抗性领域自适应(arial domain adaptation, RG)和自监督领域自适应(self-supervised domain adaptive, UDA-SS)在源和目标联合训练下的性能有较大提高。Tent总是比源模型和BN具有更低的误差,并且在2/3的情况下达到最低的误差,即使只有一个历元并且不使用源数据。

4.3 分析

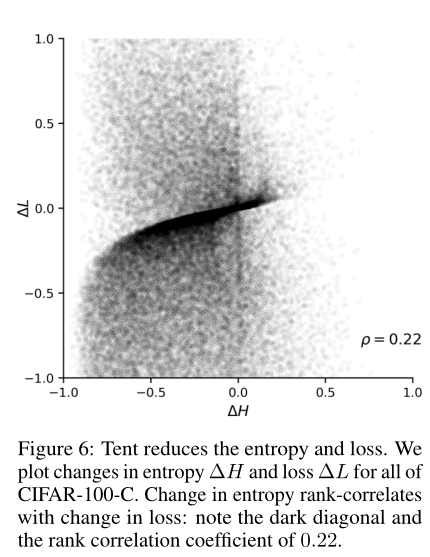

==Tent减少了熵和误差。==下图验证了tent确实减少了熵和任务损失(softmax cross-entropy)。我们绘制了CIFAR-100-C上所有75种损坏类型/级别组合的熵和损失的变化。两个轴都通过预测的最大熵(log 100)进行归一化,并裁剪为±1。大多数点经过自适应后熵值和误差都较低。

帐篷适应不同的架构。原则上帐篷是建筑不可知论者。为了衡量其在实践中的通用性,我们评估了基于自关注(SAN)和平衡求解(MDEQ) 的新架构在CIFAR-100-C上的损坏鲁棒性。下表显示,在与卷积残差网络相同的设置下,tent减少了误差。

5总结

Tent通过最小化测试时间熵来减少移位数据的泛化误差。在最小化熵的过程中,模型根据自己预测的反馈进行自我调整。这才是真正的自我监督的自我提升。这种类型的自我监督完全由被监督任务定义,不像代理任务旨在从数据中提取更多的监督,但它仍然显著地减少了错误。然而,由于corruption 和其他变化造成的错误仍然存在,因此需要更多的适应。接下来的步骤应该追求测试时间适应更多和更困难类型的转移,在更一般的参数,并通过更有效和高效的损失。

Shifts

Tent减少了各种转换的错误,包括图像损坏,数字外观的简单变化以及模拟到真实的差异。

Parameters

Tent通过规范化和转换来调整模型,但模型的大部分保持固定。test-time adaption可以更新更多的模型,但问题是要确定既具有表现力又可靠的参数,这可能与损失的选择相互作用。

Losses

Tent使熵最小化。对于更强的adaption,对于一般的但偶然的测试时间优化是否有有效的损失?熵在任务中是通用的,但在范围上是有限的。它需要批量优化,并且不能一次在一个点上偶然更新。