热门标签

热门文章

- 1Cesium.js基础使用(vue)

- 2网络工程实训_5交换机配置

- 3nginx快速入门,使用多种方式部署nginx(mac/windows/docker/docker-compose)_mac nginx

- 4总结:大模型技术栈---算法与原理

- 5python怎么做gui界面,python gui界面设计_gui练习-制作两个界面

- 6django + mssql + sqlserver2008_django+serversql源码

- 7git 本地改动了,不保留,直接拉取线上最新代码_git强制拉取最新代码覆盖原有代码的命令

- 8性能监控与报告:实时了解ReactFlow应用的性能指标

- 9【蓝桥杯】-刷题技巧-总结_蓝桥杯会员到期可以刷题吗

- 10python获取剪切板内容

当前位置: article > 正文

RKNN 模型转化的BUG_rknn 推理慢

作者:weixin_40725706 | 2024-07-20 01:33:46

赞

踩

rknn 推理慢

yolov5s pytorch模型转onnx模型再转rknn模型

这里用的是rk3588

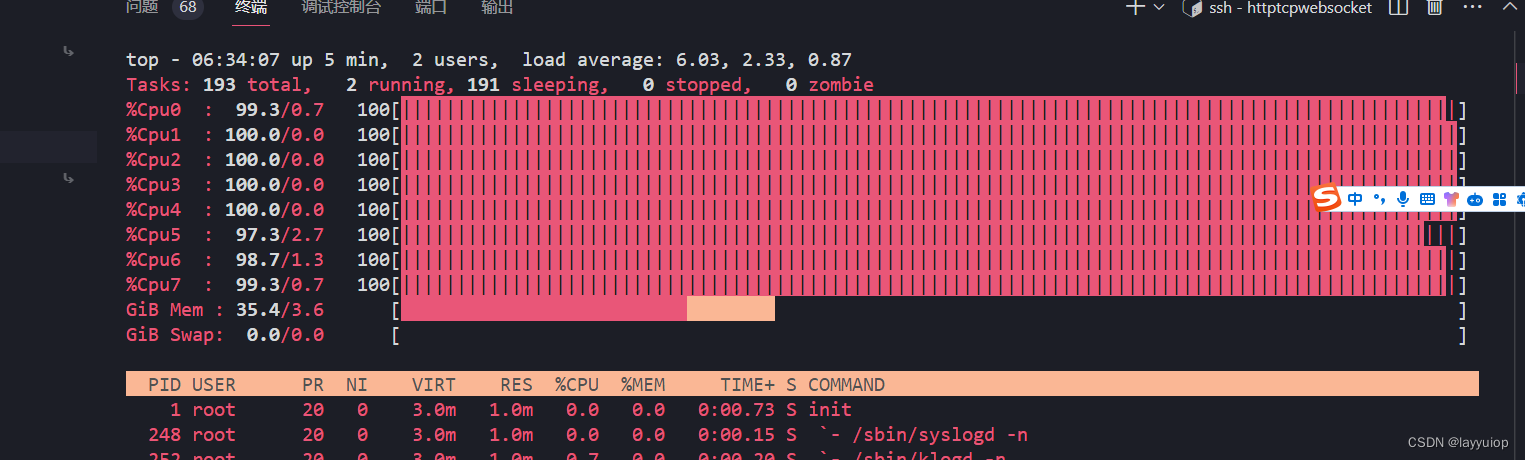

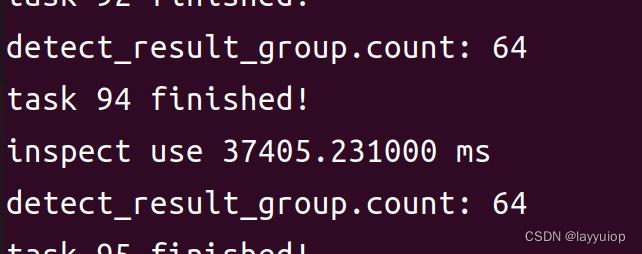

完成之后上板子跑,cpu全部干满,推理时间300ms+(正常只要10ms)

排查发现,从onnx就不一样了,如果用官方的推理代码,上板的模型一定不能加permute层。

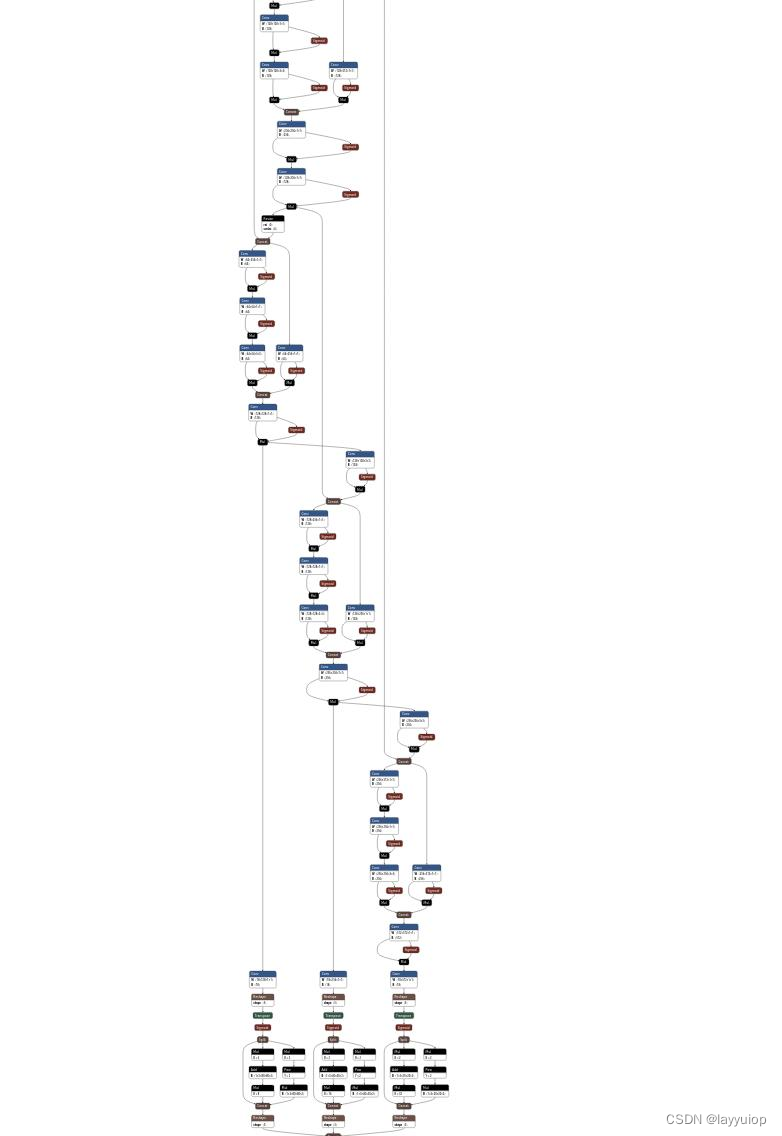

先贴一个正常的:

这个是具慢的:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/854479

推荐阅读

相关标签