热门标签

热门文章

- 1洛谷P1000 超级玛丽游戏_超级玛丽 题目描述 超级玛丽是一个非常经典的游戏。请你用字符画的形式输出超级玛

- 2探秘未来对话:GPT4Free TypeScript 版本,免费的 OpenAI GPT-4 API!

- 3蓝队应急响应-docker搭建ELK日志分析系统_蓝队kibana

- 4GCN实战_gcn代码实战

- 5设计模式笔记-概述

- 6Runway Gen-3 实测,这就是 AI 视频生成的 No.1!视频高清化EvTexture 安装配置使用!_runway gen3使用介绍

- 7风控小白必看!主流风控模型解析_风控利率敏感模型

- 8记录一次WireGuard组网中断的问题_csdn zhangzhibo921

- 9知乎好物推荐新号选品思路

- 10因为文件共享不安全,所以你不能连接到文件共享。此共享需要过时的SMB1协议,而此协议是不安全的 解决方法_因为文件共享不安全,所以你不能连接到文件共享

当前位置: article > 正文

单个消费级GPU笔记本win电脑测试LLaMA模型_llama 模型7b 13b测试

作者:一键难忘520 | 2024-07-17 02:25:48

赞

踩

llama 模型7b 13b测试

1、LLaMa模型代码:

GitHub - facebookresearch/llama: Inference code for LLaMA models

不同模型对参数规模要求不同,有7B、13B、30B(33B)和65B四个数据规模。

| Model | MP |

|---|---|

| 7B | 1 |

| 13B | 2 |

| 30B(33B) | 4 |

| 65B | 8 |

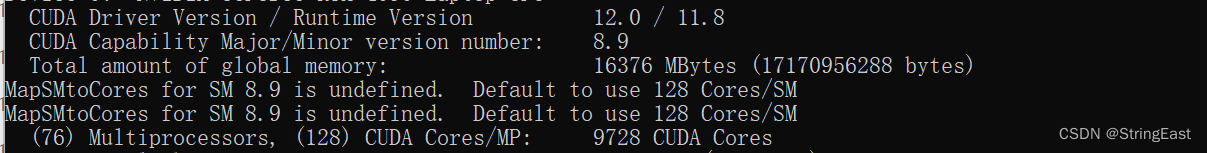

2、环境检查

(1)、检查CUDA环境是否已安装(没有的话先安装CUDA):

(2)、检查是否已安装Pytorch(没有的话先安装Pytorch):

3、LLaMa模型下载:

(1)、7B模型:

nyanko7/LLaMA-7B at main (huggingface.co)

(2)、13B模型:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/一键难忘520/article/detail/837467

推荐阅读

相关标签