热门标签

热门文章

- 1Recovery刷机图文教程_lm手机怎么开机?

- 2NGINX实现内网访问服务器中的文件_nginx 访问文件

- 3安恒网安面试题来啦!兄弟们冲起来~(下)_上海安恒网安初级面试题

- 4激光雷达健身记_激光雷达 人体姿态

- 5uniapp通过websocket实现手机APP通知栏消息显示功能(前端部分)

- 6vue+java基于Spring Boot的四川火锅餐饮地方美食文化点评网站

- 7HarmonyOS开发:封装一个便捷的Log工具类_鸿蒙开发封装工具类

- 8[OpenHarmony RK3568] (一)环境搭建_rk3568移植鸿蒙操作系统

- 9ubuntu下gcc切换版本_ubuntu 切换gcc版本

- 10卡巴斯基 2050.earth 源码分享——第一部分_7nkstv.top

当前位置: article > 正文

python写的爬虫,抓取百度的搜索结果,被屏蔽了怎么办?_python 百度数据抓取不了

作者:不正经 | 2024-03-12 23:47:33

赞

踩

python 百度数据抓取不了

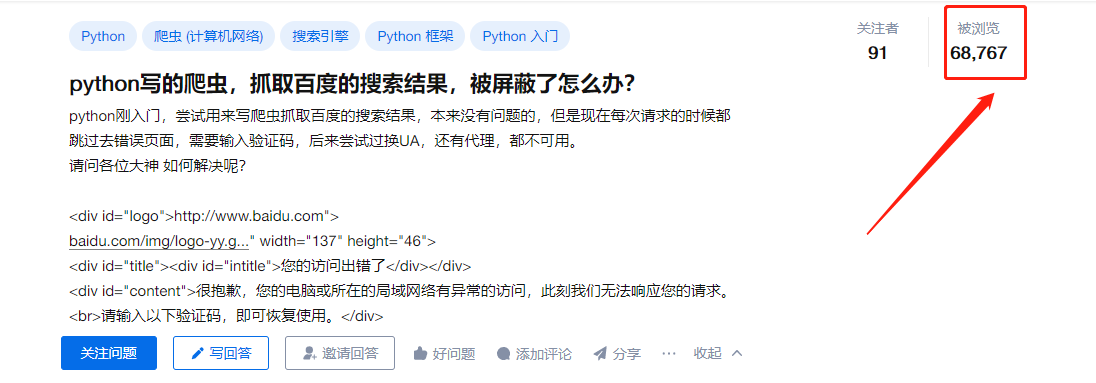

某乎上有个热门话题,引起了很大的讨论。

这个问题通常是由于频繁的请求导致百度的反爬虫机制触发了验证码的保护机制。

解决办法无非是那几套流程走一遍。

1.增加请求的时间间隔

通过在每个请求之间增加一些时间间隔,可以降低请求频率,从而避免被反爬虫机制检测到。例如,可以使用time模块中的sleep函数在每个请求之间添加一定的延迟。

2.修改请求头信息

百度反爬虫机制通常会检测请求头信息,您可以尝试修改请求头信息中的User-Agent、Referer等参数来模拟真实的浏览器行为,减少被检测到的概率。例如,可以使用fake_useragent库来生成随机的User-Agent。

3.使用Selenium等工具

Selenium是一款自动化测试工具,可以模拟真实的浏览器行为来进行爬取。通过使用Selenium可以避免被反爬虫机制检测到,但是相对来说速度较慢。

4.使用优质的HTTP代理

虽然这位同学说已经更换过HTTP代理了,但实际上这个HTTP代理是否优质,是否高匿名,是否节点够广,这些都不知道。也许你这家的质量不是很好呢,毕竟HTTP大厂如某麻都很多人骂,青果、快代理这种后起之秀反而成为越来越多人的选择。

建议购买这些HTTP代理之前,先入手测试一下,我看基本上很多厂商都有提供测试服务。不说别的,看我测试青果网络的,视频放不上来,放个截图凑合看:

总的来说还行,因为我们项目要的量比较大,年底又跑去泉州他们公司考察了一波。他们还给我们定制了方案,基本上成本这一块是控下来了,不过这家价格总体而言本身就是偏低,好在质量OK,算的上挖到宝了?

当然也可以去看看市面上的另外那些家啦,总的来说量小靠测试,量大,那就测试+考察吧。多测试几家,好有个对比。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/不正经/article/detail/226552

推荐阅读

相关标签