热门标签

热门文章

- 1使用 Vue.js 和 Python 构建 DevOps 应用程序

- 2Docker安全最佳实践_docker安全端口配置

- 3数据库系统(二)数据库关系代数 | 选择 投影 笛卡尔积 自然连接 外连接等_投影选择笛卡尔积自然连接

- 4西蒙斯告诉你何为传奇人生 James Simons_吉姆 西蒙斯

- 5CSDN 博客等级获取及介绍_csdn等级升级

- 6csdn专用必杀技----谷歌浏览器插件_csdn谷歌插件

- 7导致Oracle裁员的原因有哪些?

- 8Java智能语音电销机器人 可私有化部署 自带小程序系统_java开发智能外呼机器人系统

- 9Hadoop 3.0磁盘均衡器(diskbalancer)新功能及使用介绍

- 10Mac电脑M1芯片Python环境搭建_mac m1 python 安装 依赖

当前位置: article > 正文

Ubuntu 环境安装和使用Ollama_3ubuntu ollama phi

作者:不正经 | 2024-05-28 00:38:03

赞

踩

3ubuntu ollama phi

参考官方git安装即可 ollama/docs/linux.md at main · ollama/ollama · GitHub

如果打不开,我这里大概列出来。

命令如下:

curl -fsSL https://ollama.com/install.sh | sh

执行下载到指定目录:

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama

命令解释:`-o` 是 `curl` 命令中的一个选项,它用于指定下载后的文件的保存位置和文件名。在你提供的命令中,`-o` 后面跟着 `/usr/bin/ollama`,这意味着下载的文件将被保存在 `/usr/bin` 目录下,并以名为 "ollama" 的文件名保存。

sudo chmod +x /usr/bin/ollama

命令解释:赋予ollama可执行的权限

![]()

下载完成后,可以看到大小大约为 292m

设置环境变量,修改模型保存的位置

默认模型保存位置如下:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

但是我的系统盘空间不够,想使用挂载的磁盘,就需要更改位置。按照官网的提示。就可以修改环境变量OLLAMA_MODELS

但是我尝试了一下,没有成功的。而且发现启动的时候,发现目录不是 usr/share/ollama/.ollama

而是在当前用户目录~的.ollama下或许时候因为我使用ubuntu的原因?因此我使用了软连接来解决这个问题。

ln -s /disk2t/mjy/ollama/.ollama /home/ryq/.ollama

表示 /home/ryq/.ollama 的实际地址为 /disk2t/mjy/ollama/.ollama

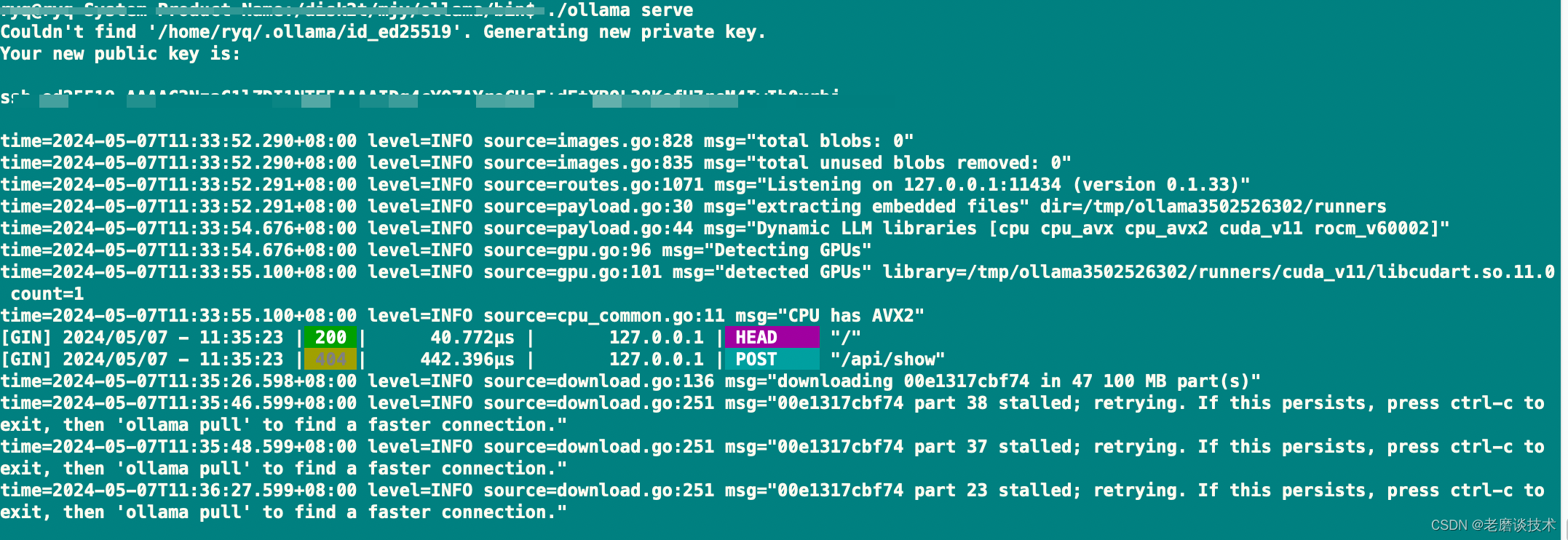

./ollama serve 启动 ollama app。

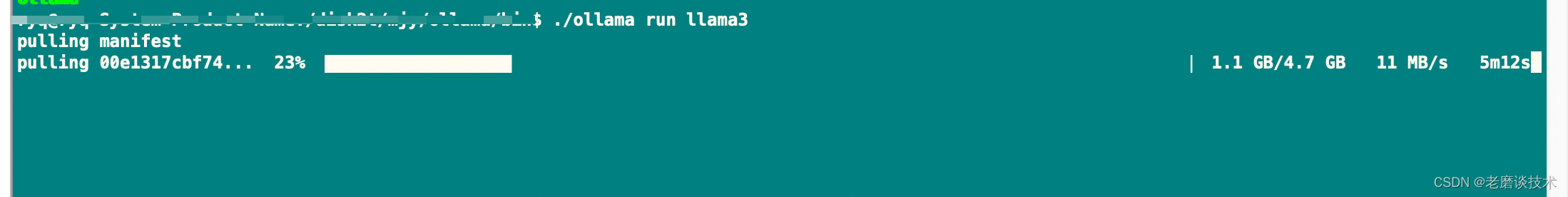

./ollama run llama3 下载模型并启动模型

如果希望开机启动,需要参考官网配置 并使用systemctl启动:

ollama/docs/linux.md at main · ollama/ollama · GitHub

下载成功后,就可以测试了 对于简单的问题,回答得还是比较快的,但是还是一不小心就使用英文回答。

对于简单的问题,回答得还是比较快的,但是还是一不小心就使用英文回答。

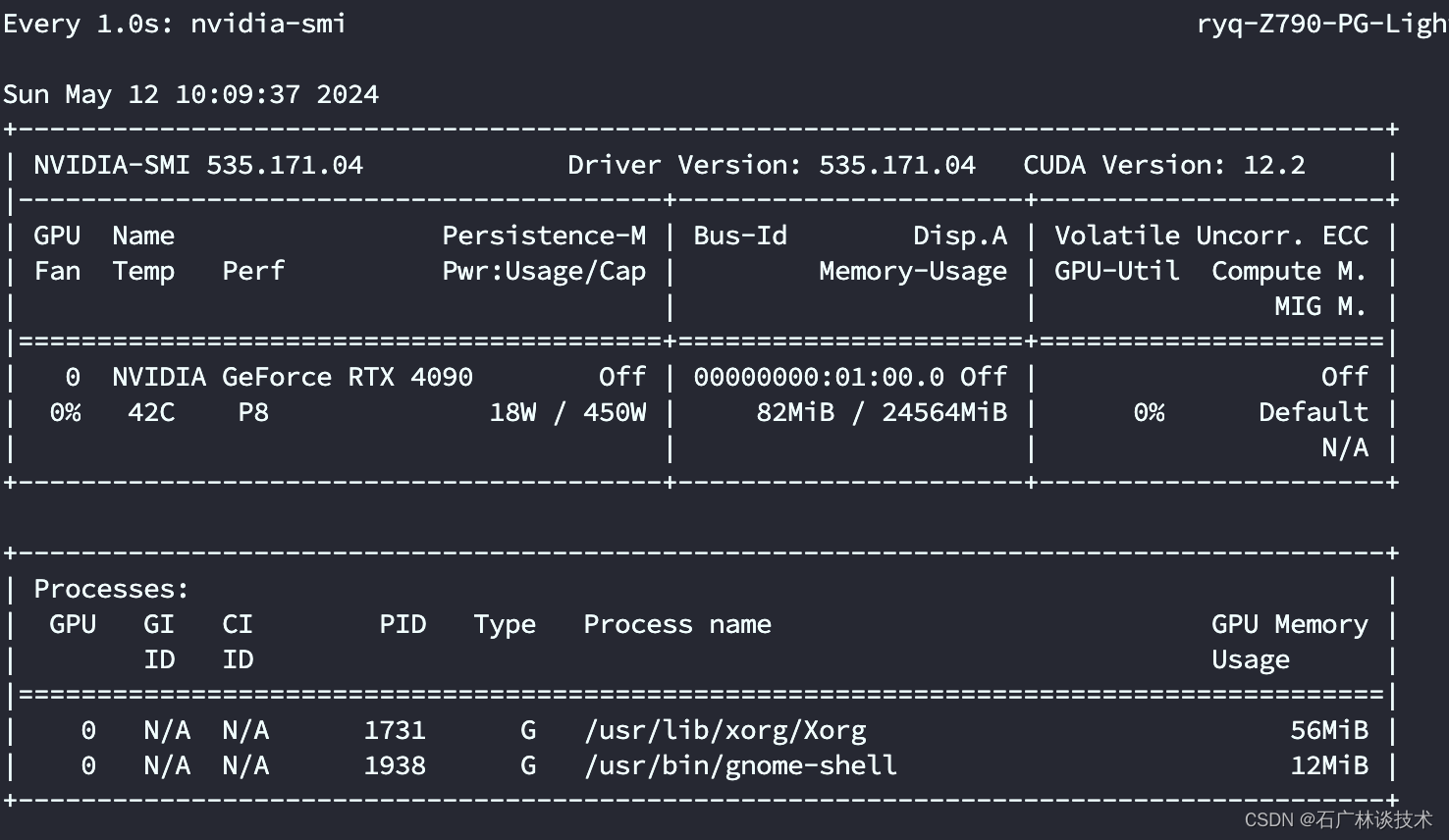

有时候我们需要看一看本地GPU的使用情况,nvidia的可以使用

watch -n 1 nvidia-smi

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/不正经/article/detail/634851

推荐阅读

相关标签