热门标签

热门文章

- 1Git 解决 Permission denied, please try again 问题_git permission denied, please try again.

- 2前端开发者必备:Nginx入门实战宝典,从部署到优化一网打尽

- 3HTML+CSS+JavaScript实现的动态爱心,超简单直接用!_html代码草莓熊

- 4霍兰德职业兴趣测试全解析,助你找到理想工作!_职业性向测试

- 5详解数据中台的底层架构逻辑

- 6Let’s Move Sui , 一起来学习吧

- 7路由器就能赚钱? 揭秘京东云无线宝背后的黑科技

- 8YoloV8改进策略:RefConv打造轻量化YoloV8利器_yolov8引入refconv

- 9Redis分布式集群--Redis的优势_集群中的redis数据库的作用

- 10数据结构之排序_堆排序和顺序表

当前位置: article > 正文

服务器部署开源大模型完整教程 Ollama+Llama3+open-webui_服务器部署开源大模型完整教程 ollama+gemma+open-webui

作者:你好赵伟 | 2024-05-24 05:16:44

赞

踩

服务器部署开源大模型完整教程 ollama+gemma+open-webui

前言

最近大语言模型大火,正好最近打比赛可能会用得上LLMs,今天就在学校的服务器上面进行一次部署。这样之后就可以直接在内网里面使用学校的LLMs了。

介绍

Ollama:一款可以让你在本地快速搭建大模型的工具

官网:https://ollama.com/

github:https://github.com/ollama/ollama

Llama3:谷歌开源的大模型

open-webui:非常不错的大模型webui,也就是界面展示

github:https://github.com/open-webui/open-webui

详细部署

部署Ollama

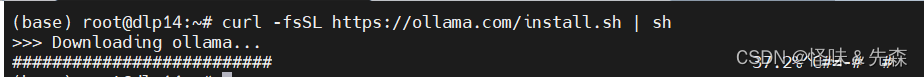

部署ollama非常简单直接输入:

curl -fsSL https://ollama.com/install.sh | sh

- 1

安装成功后使用下述命令查看版本信息,如果可以显示则代表已经安装好:

ollama -v

- 1

部署Llama3

官网地址:library (ollama.com)

我们可以通过官网查看适合自己服务器GPU大小的模型,点击想要下载的模型之后右侧会有对应的代码,直接在服务器上面下载模型即可,模型的默认安装位置为 ”/usr/share/ollama/.ollama/models“。

部署open-webui

Open WebUI基于docker部署,docker的安装方法可以参考这篇知乎文章。

执行以下docker命令来拉取并运行open-webui:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

- 1

如果发现为开启的话,我们使用docker命令运行image即可:

docker run -d ghcr.nju.edu.cn/open-webui/open-webui

- 1

之后访问服务器的3000端口,就可以访问到我们的UI界面了。这样我们就部署好了大语言模型以及UI界面。

结语

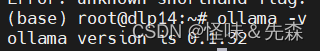

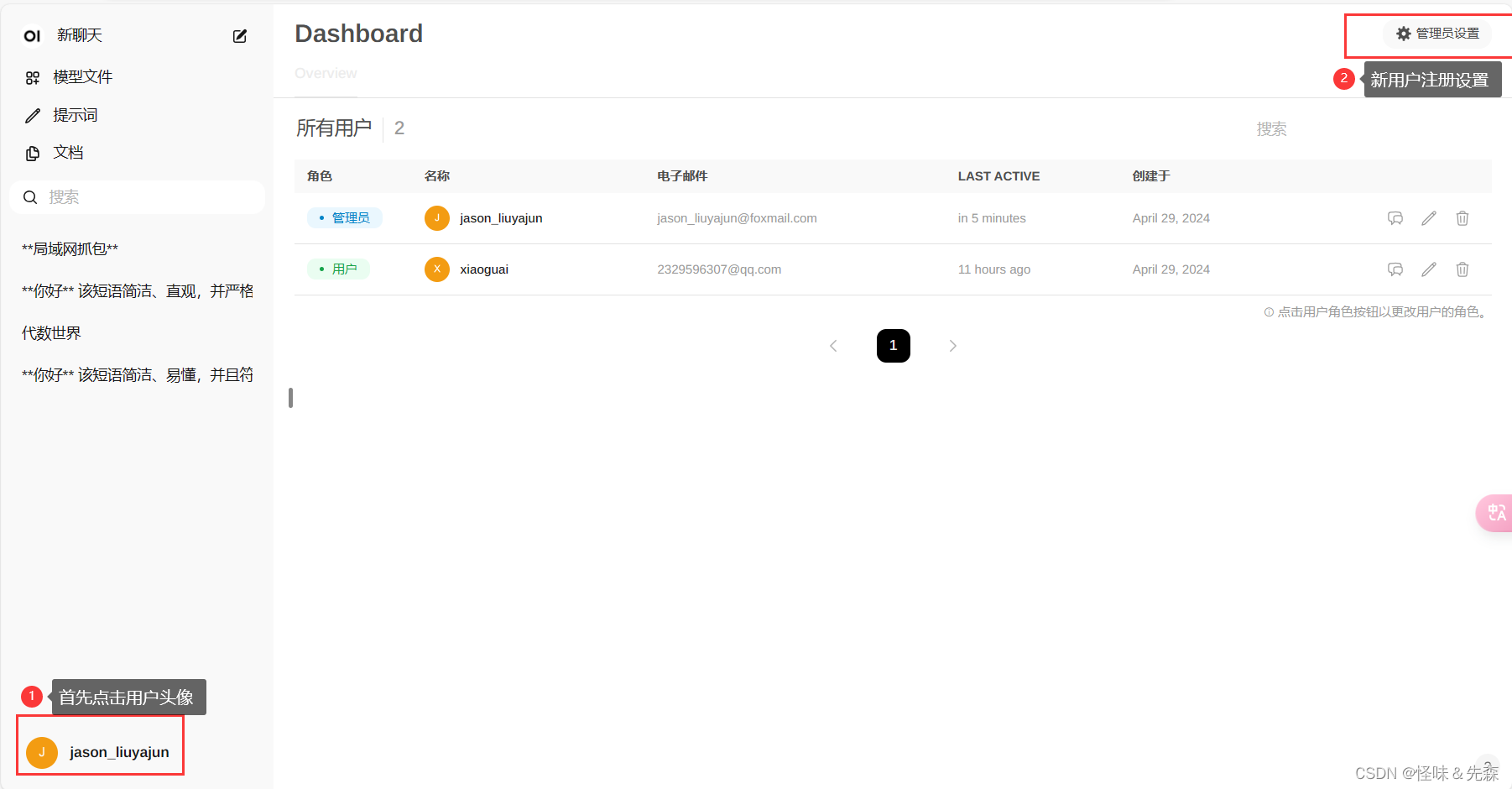

- 我们注册的第一个用户默认是管理员,其他用户进行注册的时候需要经过管理员的同意,如果不想这么麻烦的话可以在UI界面设置—”默认用户角色“,设置为用户即可。

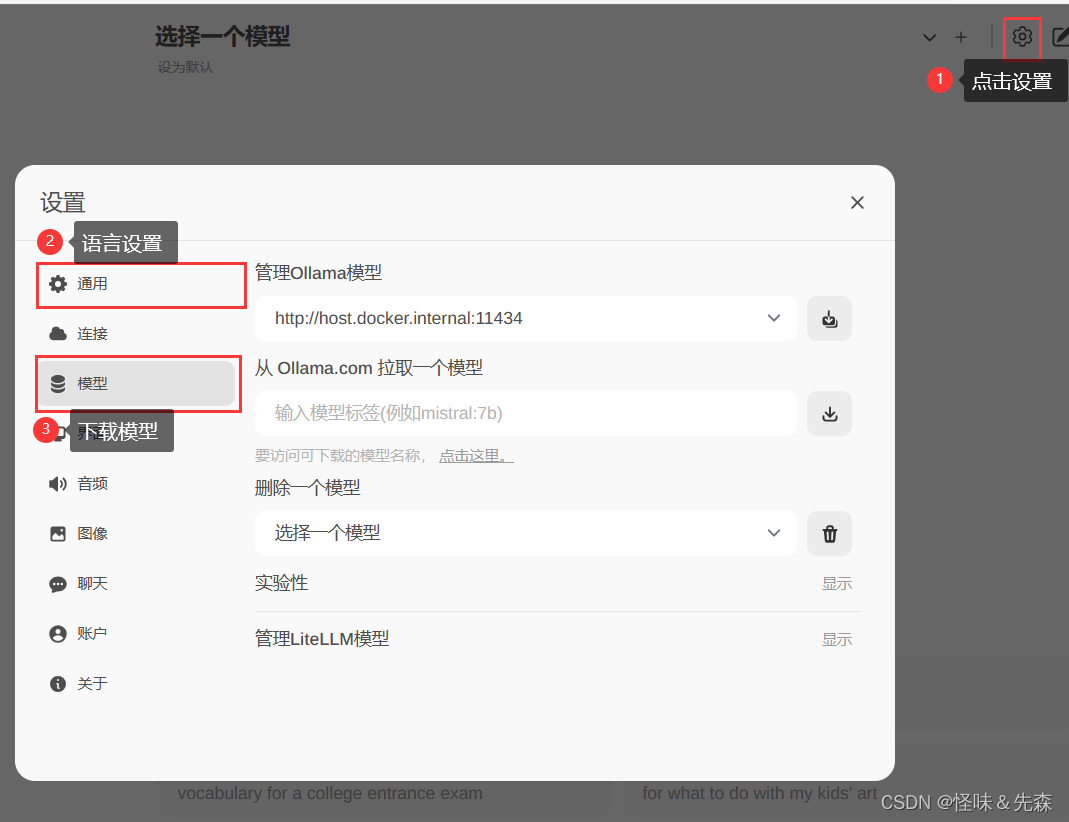

- 下载模型时可以直接在UI界面下载模型,这样节省时间(管理员);同时还可以设置UI界面的使用语言:

参考:

Linux快速部署大语言模型LLaMa3,Web可视化j交互(Ollama+Open Web UI)_ollama3 下载-CSDN博客

服务器部署开源大模型完整教程 Ollama+Gemma+open-webui - 哔哩哔哩 (bilibili.com)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/615989

推荐阅读

相关标签