热门标签

热门文章

- 12024年新算法-冠豪猪优化算法(CPO)-公式原理详解与性能测评 附赠Matlab代码

- 2安全更进一步 | 有孚网络获得国内首张 ISO 22301:2019带CNAS标证书_iso22301带cnas标志

- 3街区最短路径问题

- 4【IoT】Arduino 实现 ESP32 BLE 与 Android 手机的数据交互_arduino发送数据到手机app蓝牙代码

- 5python互联网程序设计GUI程序设计和网络程序设计(人机互动聊天软件)_python使用 tcp 协议实现人机聊天,程序具有服务端和客户端。具体要求: (1) 必备功

- 6智能网联汽车云控系统第1部分:系统组成及基础平台架构_智能网联云控基础平台建设方案

- 7构建新一代的K8s原生Java微服务+Quarkus实战_k8s 微服务架构 书

- 8ChaosBlade故障注入工具--cpu,内存,磁盘占用\IO,网络注入等

- 9VMware中Linux网络配置_无线局域网适配器 本地连接*1

- 10完美解决cuda安装 could not find compatible graphics hardware问题_could not find cuda drivers on your machine, gpu w

当前位置: article > 正文

全网最全windows11 量化部署Llama2踩坑集合_w64devkit编译 llama.cpp时ld报错

作者:从前慢现在也慢 | 2024-03-22 13:14:52

赞

踩

w64devkit编译 llama.cpp时ld报错

自从Llama2宣布可商用后,相信很多小伙伴都想一睹真容,奈何大模型对算力等各方面的要求就高,个人电脑只能望而却步,好在有llama.ccp的量化技术,使得个人windows电脑可以部署Llama2。在部署的过程中也是问题频出,下面就将踩过的坑分享给大家:

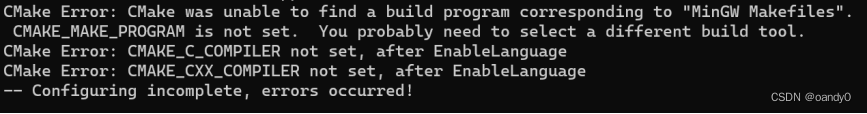

1.llama.cpp编译不过,各种奇怪问题。

按照网上各种教程,采用cmake进行编译,包括下载MinGW,一路踩坑过去依旧编译不过。

CMake Error:CMAKE_C_COMPILER not set ,after Enablelanguage

报错1

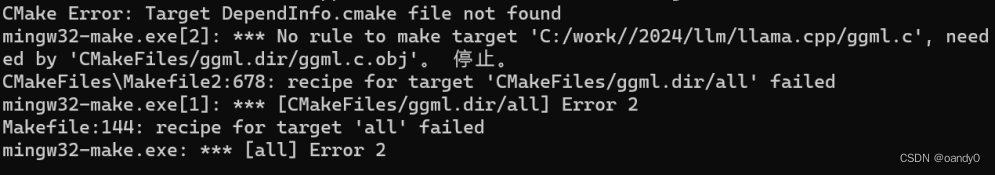

recipe for target 'CMakeFiles/ggml.dir/all' failed

报错2

到这里相信很多小伙伴选择放弃了,网上已经很难找到解决问题的办法。经过小编的不懈努力,正解来了:

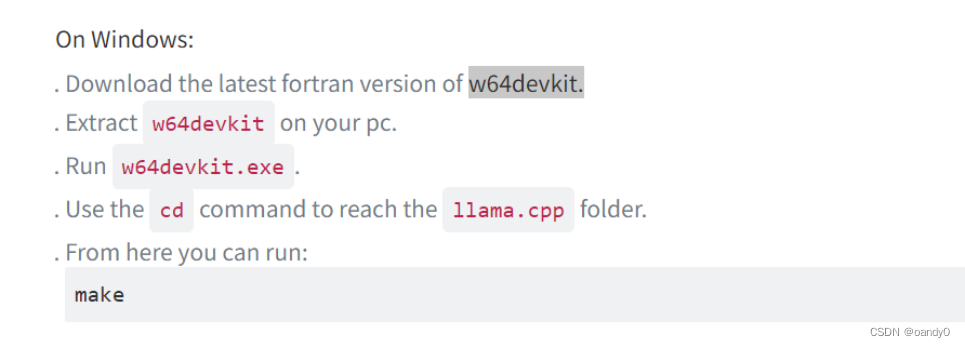

按照llama.cpp官网说明,windows可以采用w64devkit进行编译,下载安装后,编译成功,离llama2又近了一步。

llama.cpp官网截图

2.模型量化,报找不到config.json文件的错误

这个问题解决起来难度比较大,官方下载的模型文件夹中确实没有包含config.json文件,一度怀疑文件下载不全。经过苦苦寻找,终于找到了解决方案,需要先对模型进行转换,具体如下:

使用安装的transformers模块,对模型进行转换,转换为hungingface可以识别的文件。转换成功后,再次执行量化步骤,完美通关!

python D:\Anaconda3\envs\llm\Lib\site-packages\transformers\models\llama\convert_llama_weights_to_hf.py --input_dir C:\work\llm\Llama-2-7b --model_size 7B --output_dir C:\work\llm\7b-4bit3.执行命令中各种文件找不到

采用最粗暴最原始的方式,全部用绝对路径,同时所有的文件路径中不要出现中文。

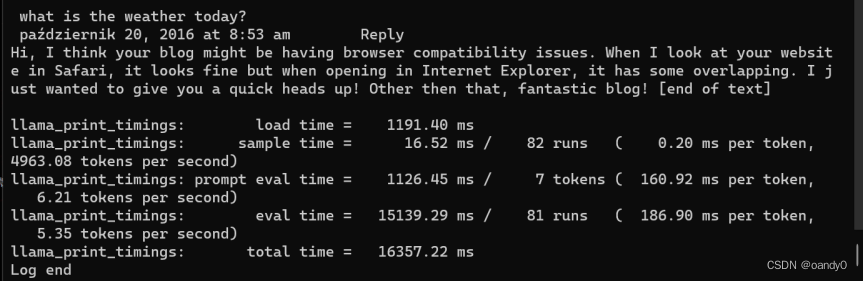

以上3大坑都踩过了,打算体验llama2的小伙伴,可以试试,相信很快就可以看到llama2真容了!

llama2对话效果

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/288431

推荐阅读

相关标签