热门标签

热门文章

- 1SSH 命令行参数详解【英】

- 2SAP 批量bom展开的需求_sap批量导多个物料bom

- 3AI接入微信公众号方法总结_微信公众号 集成ai

- 4【Uni-App】运行微信小程序时报错routeDone with a webviewId 2 that is not the current page_uniapp微信小程序that is not the current page

- 5【uniapp】scroll-view 实现自动滚动到最底部_scrollview自动滚动到底部

- 6AI大模型引领未来智慧科研暨ChatGPT在地学、GIS、气象、农业、生态、环境等领域中的应用

- 7uniapp 创建 钉钉小程序 (拒绝使用Hbuilder创建)_uni-dingtalk

- 8HarmonyOS部署服务器,HarmonyOS环境搭建遇到的坑,分享给大家

- 9模型训练出现NAN_nn.cov2d后输出nan

- 10数据库 并发更新之乐观锁和悲观锁_数据库并发更新一条数据乐观锁可以锁住吗

当前位置: article > 正文

【大模型】LLM显存占用对比:Qwen-7B-Chat,Qwen-14B-Chat-Int8,chatglm3-6b_chatglm3-6b qwen-14b对比

作者:从前慢现在也慢 | 2024-04-03 21:05:03

赞

踩

chatglm3-6b qwen-14b对比

显存占用对比:

显卡:NVIDIA GeForce RTX 4090

系统环境:ubuntu 22.04LTS

-

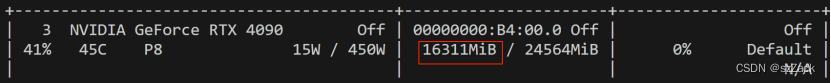

Qwen-14B-Chat-Int8

模型:qwen/Qwen-14B-Chat-Int8

GPU占用:

-

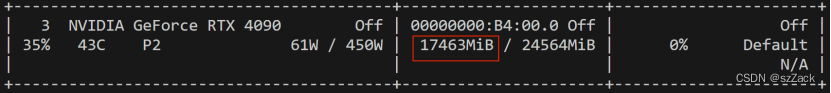

Qwen-7B-Chat

模型:qwen/Qwen-7B-Chat(bf16, fp16)

GPU占用:

-

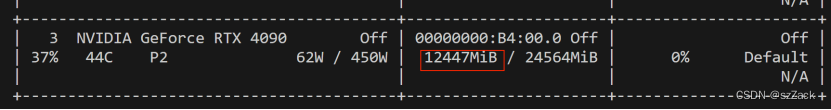

chatglm3-6b

模型:ZhipuAI/chatglm3-6b(bf16, fp16)

GPU占用:

总结

总结下来就是能用fp16就用fp16,能用Int8就用Int8,能用int4就用int4。

量化对降低显存占用还是非常不错。

参考

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/356617

推荐阅读

相关标签