热门标签

热门文章

- 1分库分表之后,自增主键如何处理?_分库分表主键自增

- 2RHCSA

- 3逻辑电路,组合逻辑电路、时序逻辑电路、同步时序电路、异步时序电路_同步时序逻辑电路的 方程比较简单,异步时序逻辑电路的 方程比较简单。

- 4后台撸完,撸JS,something funny

- 5Flutter Widget:State 状态管理

- 6【讲解下NLP学习路线的总结】

- 7Python之对数组元素做批量操作_python nparray元素批量操作并更新

- 8SyntaxError: Unexpected number in JSON at position 7 at JSON.parse (<anonymous>)前端接收到数据,无法进入success

- 9adb命令 :查看当前已打开的应用程序_adb查看当前运行的程序

- 10java多人聊天室实现(可群聊私聊/添加好友/发送文件)_java利用多线程和socket制作gui界面的在线聊天室文件传输、私聊、群聊等

当前位置: article > 正文

【网络优化】超轻量级网络SqueezeNet算法详解_卷积通道数先提升再减少

作者:从前慢现在也慢 | 2024-04-06 19:32:59

赞

踩

卷积通道数先提升再减少

Iandola, Forrest N., et al. “SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and< 1MB model size.” arXiv preprint arXiv:1602.07360 (2016).

本文考察了深度学习中除了精度之外的另一个重要因素:模型大小。有两处值得学习的亮点:

- 给出了一个分类精度接近AlexNet1的网络,模型缩小510倍

- 归纳了缩小模型尺寸时的设计思路

复习:卷积层的参数个数。

输入通道 c i c_i ci,核尺寸 k k k,输出通道 c o c_o co,参数个数为: c i × k 2 × c o c_i \times k^2 \times c_o ci×k2×co。

以AlexNet第一个卷积层为例,参数量达到:31111*96 = 34848。

作者提供的源码请戳这里,各个主流框架均有实现。

基础模块

在当下许多深度学习的文章中都使用了模块化的设计思想,远者有AlexNet中反复出现的conv+relu+pool模式;近者有用于人体姿态分析的Stacked Hourglass算法(参看这篇博客)

本文使用的基础模块称为fire:

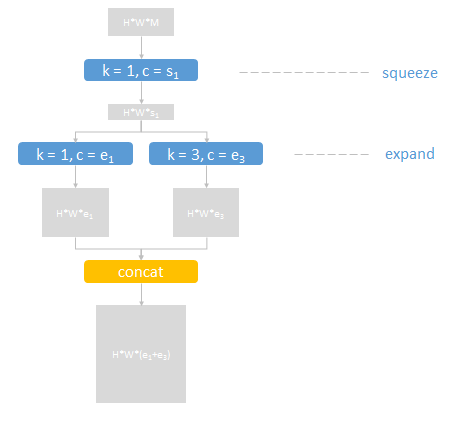

包含三个卷积层(蓝色),步长均为1。分为squeeze和expand两部分,分别压缩和扩展数据(灰色矩形)的通道数。

expand部分中,两个不同核尺寸的结果通过串接层(黄色)合并输出。

fire模块有三个可调参数:

- s 1 s_1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/373895

推荐阅读

相关标签