- 1GPT系列初探_gpt 自回归

- 2CleanMyMac X 4.15.1 for Mac 最新中文破解版 系统优化垃圾清理工具

- 3OpenCV联通组件扫描

- 4一夜之间,3.0万 Star,全部清零。。

- 5使用link rel="shortcut icon"为网页标题加图标_6Android系统默认Home应用程序(Launcher)的启动过程源代码分析_android9 默认launcher home

- 701背包问题,多重背包问题-分组背包问题-完全背包问题-总结-内含4种经典背包问题_01背包例题

- 8E/RecyclerView: No layout manager attached; skipping layout问题解决

- 9arrayList和vector的区别

- 10Python爬虫-某跨境电商(AM)搜索热词_跨境电商相关python 项目

聚合方法、模型验证、节点选择_区块链 联邦学习 节点选择

赞

踩

*论文题目:When Federated Learning Meets Blockchain: A New Distributed Learning Paradigm

期刊:IEEE Computational Intelligence Magazine

作者:Chuan Ma;Jun Li;Ming Ding;Long Shi;Taotao Wang;Zhu Han;H. Vincent Poor

时间:August 2022

关键词:聚合方法、节点选择

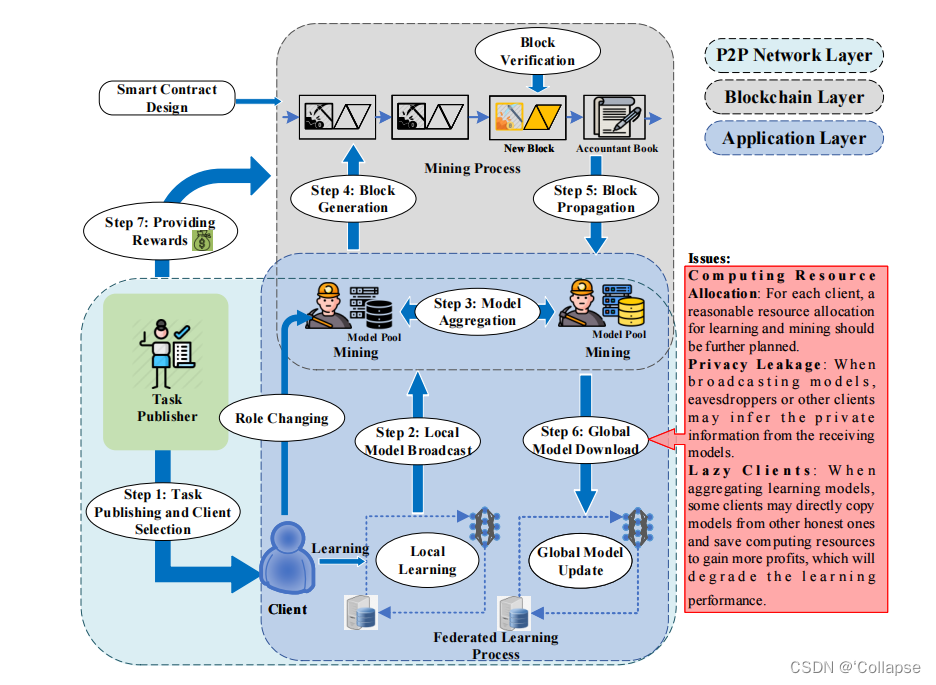

一、提出了BLADE-FL框架。工作流如下:

1.任务发布和节点选择:任务发布者通过智能合约来广播一个FL任务,同时智能合约选择可用的训练节点参与这个学习任务

2.本地模型广播:客户端使用本地数据训练模型

3.模型聚合:客户端根据SC中定义的聚合规则更新全局模型

4.块生成:训练客户端切换为miner开始挖掘。生成块后,其他客户端验证该块的内容

5.块传播:如果一个块被大多数客户端验证,这个块将被添加到区块链上。lazy client问题发生在这个步骤

6.全局模型的下载和更新:每个被选中的客户端从块中下载聚合的模型,并在下一轮学习之前执行更新

7.奖励分配:根据智能合约,依据在学习任务中的贡献奖励客户端

二、关键设计

1.智能合约设计

三个主要功能

(1)学习任务发布:任务发布者通过智能合约向所有用户广播一个FL任务。智能合约包含任务需求(数据大小、训练精准度、延迟)、聚合规则和奖励

(2)Dynamic bidding for request(动态招标):分布式训练节点通过他们的成本和能力申请加入任务。在申请任务时每个训练节点都需要向智能合约缴纳一笔保证金,智能合约选择最有价值的节点加入到任务中,未被选中的节点,如果训练结果被证实可信,保证金将被自动返还

(3)学习结果聚合和奖励反馈:在生成一个新的块之前,每个客户端将根据智能合约的聚合规则对上传的模型进行聚合,其中每个模型的贡献也被记录在新生成的块中。然后自动触发奖励机制。

2.安全问题

每个客户端在进行训练时自己设置一个隐私级别,同时为了实现局部差异隐私(LDP),每个客户端都添加一个随机噪声,该噪声遵循一定分布

3.lazy client

lazy client可能不想训练,直接复制其他客户端上传的参数

为了解决lazy client问题,在广播本地更新时,每个客户端将生成一个长度为L的PN序列,将其添加到更新中。该PN序列具有较高的自相关性,很难被其他客户端检测或重新生成。在接收到来自其他客户端的本地更新后,每个客户端将使用自己的PN序列来检查两者的相关系数,如果系数较大则认为它为lazy client

论文题目:Latency Analysis of Consortium Blockchained Federated Learning

作者:Pengcheng Ren and Tongjiang Yan

时间:10 May 2021

1、关键词:模型验证

*论文题目:A Comprehensive Survey of Incentive Mechanism for Federated Learning

*论文题目:Blockchain-based Secure Client Selection in Federated Learning

期刊: 2022 IEEE International Conference on Blockchain and Cryptocurrency(ICBC)

作者:Truc Nguyen;Phuc Thai;Tre'R. Jeter;Thang N. Dinh;My T. Thai

时间:02-05 May 2022

关键词:节点选择

本文提出了两种不同的策略进行有偏的选择攻击,说明了通过操纵客户端选择,服务器可以绕过安全聚合来学习受害者客户端的本地模型。这表明仅凭安全聚合不足以进行隐私保护。为了应对这种攻击,本文提出严格执行服务器上的随机客户端选择方案。

为了说明安全客户端选择的必要性,本文描述了一个有偏选择攻击模型。该模型遵循FL的训练方案,攻击体现在试图操控选择过程。该攻击过程有两种不同的方式。

服务器与一些客户端勾结形成的colluding attack:服务器选择受害客户端v和勾结客户端u。所选的客户端正常计算本地模型更新。勾结客户端u秘密的共享他们训练出来的模型。在得到聚合模型后除去u的模型即为受害客户端模型。

Non-colluding attack:该攻击至少需要两轮训练。在第一轮训练后得到全局聚合模型。第二轮中服务器选择u客户端,使用第一轮的全局模型减去第二轮的u客户端模型,得到受害客户端模型。

(未完待续)

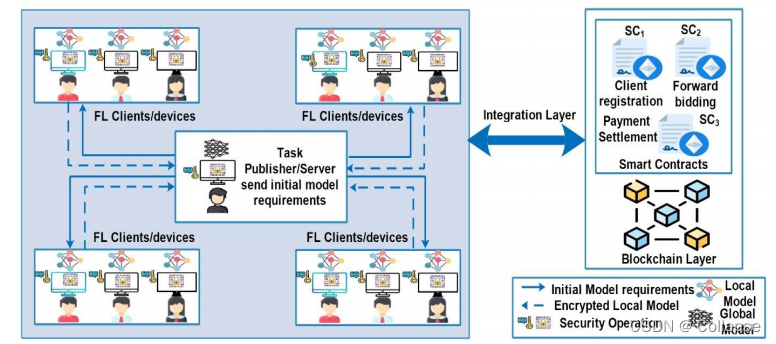

*论文题目:Blockchain-based Optimized Client Selection and Privacy Preserved Framework for Federated Learning

作者:Attia Qammar, Abdenacer Naouri, Jianguo Ding, Huansheng Ning

关键词:节点选择

提出了基于区块链的优化客户端选择方案和隐私保护框架。该系统由服务器、客户端、集成层和区块链层组成

提出了正向招标智能合约用以选择topk模型优化联合学习

服务器通过区块链网络对对任务进行拍卖,客户端向智能合约发送投标。在该过程中客户端需要缴纳保证金,这使得客户端不能离开或退出训练过程,否则他们会失去保证金。在模型训练完成后,服务器将金额返回给客户端。

在客户端投标之前,需要在以太坊上注册一个唯一地址。只有注册的客户端可以进行投标。

在选择了topx个客户端并完成训练后,使用CKKS完全动态加密方案进行模型传输

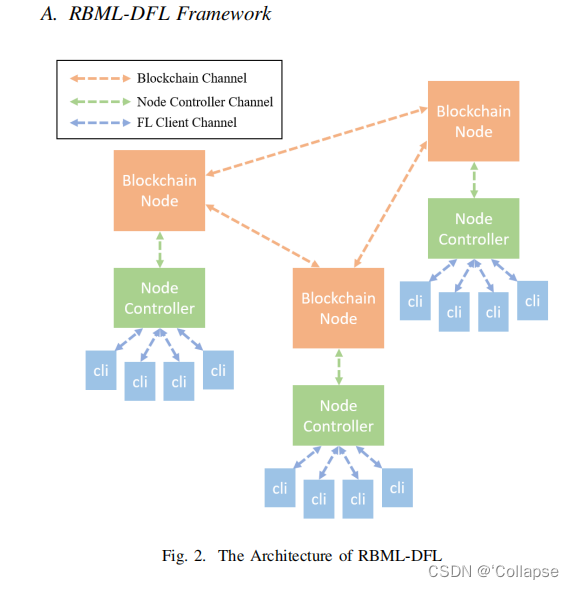

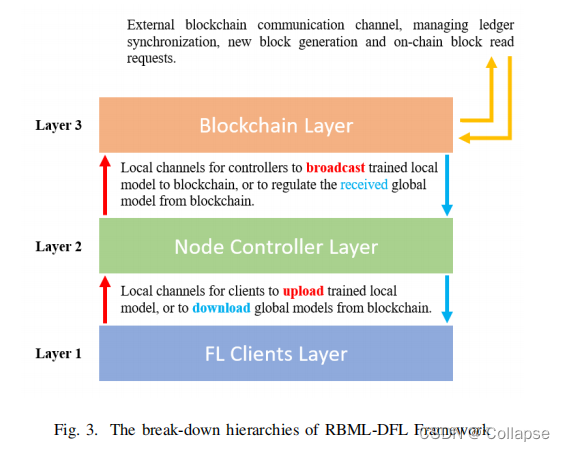

*论文题目:A Blockchain-based Multi-layer Decentralized Framework for Robust Federated Learning

期刊:2022 International Joint Conference on Neural Networks(IJCNN)

作者:Di Wu;Nai Wang;Jiale Zhang;Yong Xiang;Longxiang Gao

时间:18-23 July 2022

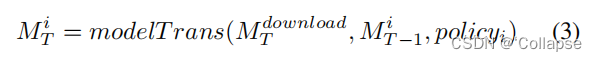

(2)Node Controller(NC)Layer:该层主要有两个任务:1.平局来自FLC层的模型;2.接收来自BC层的模型。NC使用评估集比较来自FLC层与BC层的模型,并将性能更高的模型分配给客户端。对于恶意用户,NC层始终发送一个健康模型。同时,NC只将性能较高的模型上传到BC层,以避免模型污染。

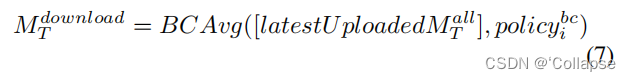

第T轮迭代上传到BC层的模型

第T轮NC层的最新模型

(3)Blockchain(BC)Layer:该层负责提供节点间通信,实现区块链的功能

在RBML-DFL框架中的联邦学习

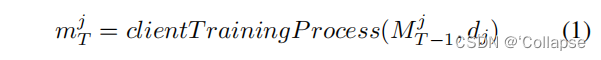

(1)客户端模型重置:i节点下的j客户端模型

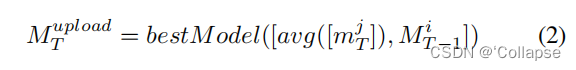

(2)NC层模型平均:对于节点i

(3)NC层模型测试和上传:对于节点i,使用模型选择器和已定义的选择策略来测试和选择要上传的最佳模型

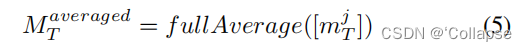

(4)区块链同步:对于节点i,BC层测试并在链上发布一个新的数据块。当新的块上链后,BC层计算出平均模型

(5)模型下载和测试:NC层请求最新的平均BC模型

(6)BC层模型分布:NC层将结果较好的模型分配到FLC层中的客户端

可以在BC层上应用不同的策略,以降低中毒攻击的危害。通过随机改变每个训练任务的加密方法,恶意攻击者很难获取正确的加密方法,从而对加密消息进行解密。

总结:与经典的FL框架相比,NC层等价于中间层的作用,因此,NC层中的平均模型也会受到恶意攻击者的中毒攻击。NC层采用模型选择机制应对该威胁。在将平均局部模型上传到区块链时,NC需要评估当前的平均局部模型与全局模型,以决定是否将其局部平均模型上传到区块链。一旦全局模型优于本地模型,NC停止将其本地模型上传到区块链网络。否则,本地模型将被嵌入区块链中。

*论文题目: A Blockchain-based Federated Learning Scheme for Data Sharing in Industrial Internet of Things

期刊:IEEE Internet of Things Journal

作者:Guangxia Xu;Zhaojian Zhou;Jingnan Dong;Lejun Zhang;Xiaoling Song

时间:24 July 2023

关键词:模型验证

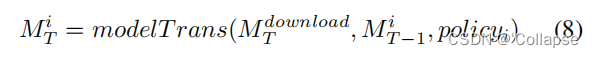

系统框架

系统主要由任务发布者、参与者、共识委员会和区块链四个部分组成

为了降低推理攻击导致的数据泄露风险,在模型聚合过程中加入基于拉普拉斯机制的差异隐私保护

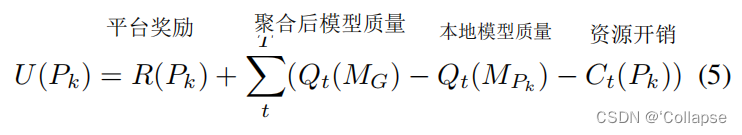

激励机制的效用函数

PoC共识机制:验证每个参与节点的局部模型的质量,作为是否参与聚合的依据

声誉评价:

*论文题目:A Novel Blockchain-Assisted Aggregation Scheme for Federated Learning in IoT Networks

期刊:IEEE Internet of Things Journal

作者:Zhiming Liu; Kan Zheng; Lu Hou; Haojun Yang; Kan Yang

时间:18 May 2023

1、关键词:聚合方法、节点选择

2、背景:

在将Fl应用于物联网网络时,由于物联网端设备的数量众多且具有脆弱性,如何保持高效率和可靠性是一个挑战

3、如何解决:

提出了一种区块链辅助的物联网网络中的FL聚合方法,其中聚合节点的选择用于提高效率,区块链用于性能检验。在模型聚合过程中,采用DDPG算法获得一种选择策略,以便基于多个指标选择物联网终端设备的最优子集。采用基于区块链的新性能检验。

为了提高聚合效率,使用分层聚合。模型聚合分为三部分,即集群聚合、边缘聚合和全局聚合,分别由健壮的边缘设备、基站和服务器执行。

使用DDPG算法选择聚合节点。在聚合选择过程中,基站确定参与模型聚合的节点数。在聚合选择开始时,根据模型精度对上一轮FL训练中参与模型聚合的节点进行排序。排名前50%的节点继续参与模型聚合,并加入聚合节点的子集。前一轮FL训练中参与模型聚合的其他聚合节点作为本轮训练中的验证节点。

4、创新点:

(1)提出了一种分层聚合框架,通过在物联网网络中构建端设备集群来分散聚合任务

(2)提出了一种包含聚合节点选择和区块链辅助验证的新聚合方案。在聚合节点选择中,DDPG算法根据节点资源和模型性能选择终端设备。同时,在区块链的辅助下实现了可追溯的互相验证,保证了可靠性,并结合最有停止理论提高效率。

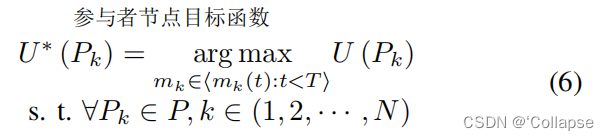

*论文题目:An Efficient Blockchain assisted Reputation aware Decentralized Federated Learning Framework

期刊:IEEE Transactions on Network and Service Management

作者:Harsh Kasyap;Arpan Manna;Somanath Tripathy

时间:22 December 2022

关键词:模型验证、节点选择

框架整体由九个步骤组成。

在边缘设备上训练:边缘设备使用本地数据进行训练。其中资源有限的设备不能直接参与,他们与fog device关联,并发送本地模型更新

发布本地更新:fog device和边缘设备将本地更新发送给Transaction Topics。由broker管理这些主题。每个模型被分到一个主题,该主题由每个消费者订阅。(kafka)

启动事务处理:fog device和边缘设备启动挖掘任务

更新消费消息:挖掘节点对Transaction Topics中已启动的事务进行更新

合约执行和共识:挖掘节点执行智能合约,根据数据质量、数量和过去的声誉评估客户

发布挖掘块:挖掘者在区块链主题中发布这些块

消费和聚合:使用挖掘出来的块,根据声誉选择客户端。此外,还在Transaction Topics中聚合他们感兴趣的模型

算法2计算标签识别,算法3使用2得到的标签识别恶意模型。使用算法4从诚实模型中的每个类标签中计算出贡献,并选出topk个作为聚合节点

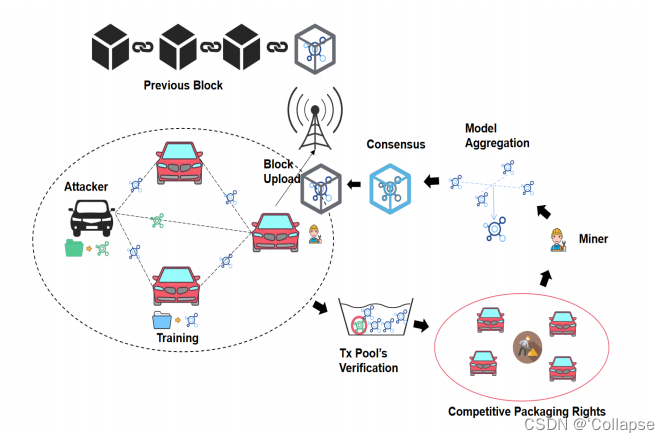

**论文题目:A Data Sharing Scheme based on Federated Learning in IoV

期刊:IEEE Transactions on Vehicular Technology

作者:Xiaoya Hu;Ruiqin Li; Yuqiao Ning; Kaoru Ota; Licheng Wang

时间:11 April 2023

1、关键词:节点选择

2、背景:

由于数据共享而导致的用户私人信息的泄露,可能会损害车辆用户的利益,甚至危及生命。同时,由于车辆收集的数据质量各不相同,高质量的数据共享意味着用户可以获得更可靠的服务,而低质量的数据则会降低服务的可靠性、驾驶体验或造成交通事故。因此需要开发一个高度可靠的共享书隐私保护方案

3、如何解决:

使用基于top-k的节点选择方案。原理如下:经过第t轮局部训练后,车辆计算数据质量指数DQI并更新区块链上的DQI。对DQI进行排序,选择精确率最高的前k辆汽车参与模型训练。

4、创新点:

(1)提出了一种基于秘密共享的分散式联邦学习方案

(2)为了进一步保护数据隐私,在学习阶段引入同态加密和对称加密

(3)提出了一种基于top-k的节点选择方案,以选择k辆局部模型精度最高的车辆,提高全局精度

(4)为了减少引入联邦学习造成的延迟,将数据请求过程于数据共享过程解耦,大大减少了应用联邦学习所造成的时间消耗

##论文题目:Blockchain-based Trustworthy Federated Learning Architecture

作者:Sin Kit Lo; Yue Liu;Qinghua Lu;Chen Wang; Xiwei Xu;Hye-Young Paik;Liming Zhu

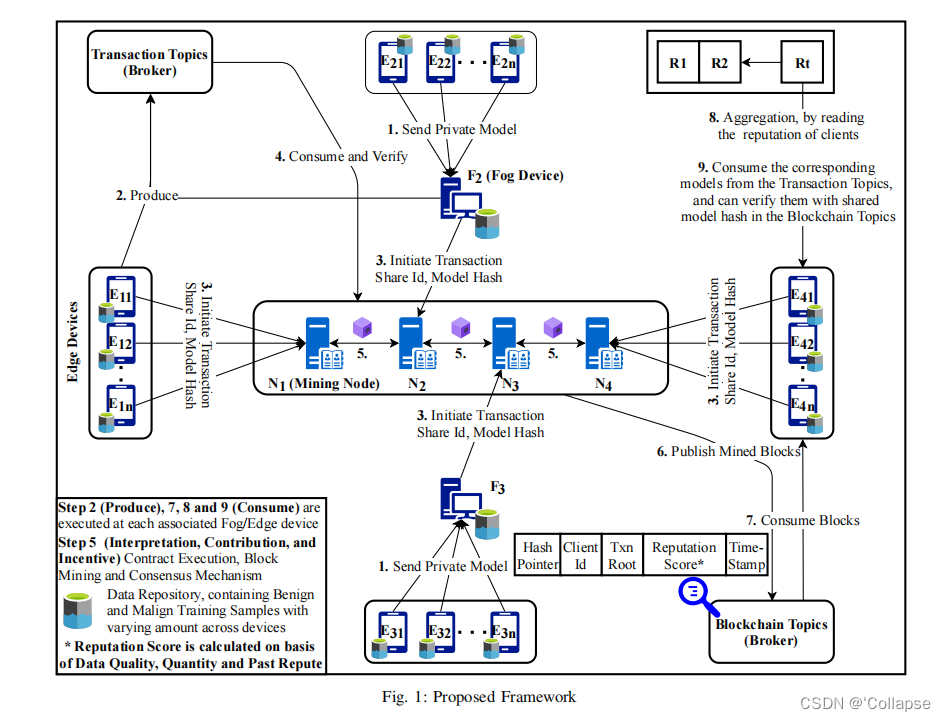

*论文题目:VTFL: A Blockchain Based Vehicular Trustworthy Federated Learning Framework

期刊: 2023 IEEE 6th Information Technology,Networking,Electronic and Automation Control Conference(ITNEC)

作者:Aojie Li;Xing Chang;Jingxiao Ma;Shousheng Sun;Yantao Yu;

时间:24-26 February 2023

关键词:模型验证、聚合方法

一、VTFL系统框架主要包括局部训练、事务验证、挖掘、模型聚合、块上传五个步骤

(1)局部训练:参与训练的车辆使用梯度下降的方法更新全局模型参数

(2)事务验证:交易池用于收集附近的训练模型,使用基于梯度差的局部模型验证方法验证正确性,从而消除恶意模型对全局模型的影响。此外,模型包含了车辆的私钥,这可以帮护追踪恶意模型。

(3)挖掘:使用优化的PoW选择矿工

(4)模型聚合:矿工将本地验证的可信模型进行聚合

(5)块上传

二、PoMSFL共识机制

PoMSFL负责局部模型验证和全局模型聚合

(1)局部模型验证:使用局部模型梯度wi和最后一轮的全局模型梯度之间的差值的归一化值作为模型的评价因子

恶意节点使用污染数据的局部模型的部分梯度与全局梯度之间差距很大,为了消除中毒攻击的影响,将该因子作为模型安全性验证的基础。根据交易信息的数据签名,跟踪上传恶意模型的车辆并拒绝其参加后续的训练,防止恶意车辆多次攻击。

(2)矿工选举和添加区块:考虑到车辆的计算能力有限,以及移动性的交互时间较短,如果哈希问题的难度设置的过高,会导致较长的块生成时间和计算功耗。为了提高车辆训练效率,期望车辆在训练工程中花费更多的计算能力,从而使PoMSFL中减少一定的散列计算能力,同时确保块效率。

(3)最长链原理:在生成链时可能会产生分岔,选择最长的链作为主链,其余的短分支被丢弃。文章认为当恶意矿工的时间小于51%时,该原理可以保证链上数据的可靠性和真实性。

**论文题目:TORR: A Lightweight Blockchain for Decentralized Federated Learning

期刊:IEEE Internet of Things Journal

作者:Xuyang Ma;Du Xu

时间:21 June 2023

1、关键词:节点选择、聚合方法

2、背景:

所有的本地模型都应该在聚合之前收集,所以联邦学习的延迟由最慢的设备决定。区块链所需的共识过程将进一步增加延迟,特别是当需要一个很大的包含模型的块时。不断增长的区块链和模型将占用大量的存储空间,这使得它无法在轻量级设备上部署。

3、如何解决:

提出了一个用于联邦学习的轻量化区块链TORR。设计了一种新的共识协议的可靠性证明,以实现快速的共识,同时减轻掉队者的影响。基于擦除编码和定期存储刷新策略,设计了一种存储协议。通过擦除编码,我们充分利用了设备有限的存储空间。

4、创新点:

(1)提出了一个用于去中心化联邦学习的轻量级区块链TORR

(2)提出了一种新的一致性协议来过滤不可靠的设备,从而降低系统延迟。提出了一种快速聚合算法来实现快速、正确的聚合,进一步降低了系统的延迟。

(3)采用擦除编码来有效、可靠地存储模型,而仅采用小区块链分类帐记录模型的散列值。提出了一种定期的存储刷新策略,以进一步降低存储开销

##论文题目:Straggler Mitigation and Latency Optimization in Blockchain-based Hierarchical Federated Learning

作者:Zhilin Wang;Qin Hu; Minghui Xu; Zehui Xiong

1、关键词:聚合方法

2、背景:

云边缘设备分层联合学习(HFL)最近被提出,以实现通信效率和保护隐私的分布式学习。然而,存在几个关键的挑战,如单点故障和边缘服务器和本地设备的潜在偏离者

3、如何解决:

为了减轻掉队者对学习的影响,提出了一种新的聚合方法HieAvg,利用掉队者的历史权重来估计缺失的提交内容。通过联合考虑全局模型收敛和区块链共识延迟的约束,优化BHFL的总体延迟

4、创新点:

(1)提出了一个分散的可收敛的BHFL框架

(2)设计了一种新的BHFL模型聚合方法HieAvg,利用偏离者的历史权值来减轻BHFL的负面影响,并从理论上证明了其收敛性。

(3)在区块链共识时间消耗和全局模型收敛的约束下,通过推导出边缘服务器上的最优聚合轮数来优化BHFL的总延迟。

*论文题目:Node Selection Strategy Design Based on Reputation Mechanism for Hierarchical Federated Learning

期刊:2022 18th International Conference on Mobility, Sensing and Networking(MSN)

作者:Shen XIn;Li Zhuo;Chen Xin

时间:14-16 December 2022

关键词:节点选择

针对分层联邦学习的节点选择问题,提出了基于声誉的节点选择算法

一、声誉机制

节点k的总声誉值由局部训练模型的测试精度和邻居节点对节点k的声誉值组成

k邻居节点v的声誉值

二、一种基于声誉价值预测的节点选择算法

分层联合学习,基于时间序列,需要根据节点的历史声誉价值观测下一个时间段的总声誉价值,然后选择高声誉价值的节点参与模型训练。

从第p轮到第t轮的累计声誉值

基于自回归时间序列模型,可以预测下一个时间段t中节点的声誉值。每个边缘服务器m根据声誉预测值选择声誉较高的节点,形成一个节点集Km

**论文题目:Lightweight Privacy and Security Computing for Blockchained Federated Learning in IoT

期刊:IEEE Internet of Things Journal

作者:Mochan Fan;Kailai Ji; Zhaofeng Zhang; Hongfang Yu;Gang Sun

时间:14 April 2023

关键词:节点选择

*论文题目:Lightweight Blockchain-empowered Secure and Efficient Federated Edge Learning

期刊:IEEE Transactions on Computers

作者:Rui Jin;Jia Hu; Geyong Min; Jed Mills

时间:10 July 2023

关键词:节点选择

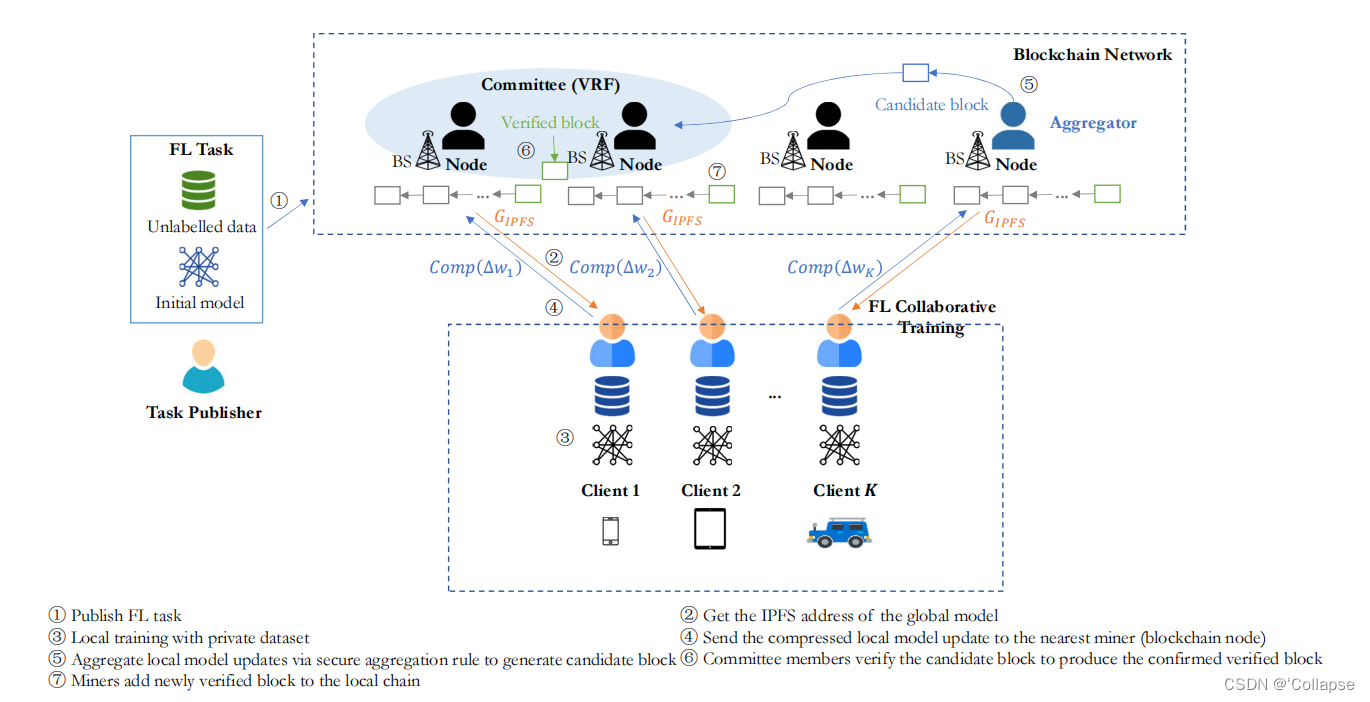

Blockchain、IPFS、VRF

可验证的随机函数VRF提供了一种非交互式的方式来独立地确定节点是否被选为委员会成员

步骤1:任务发布者将数据、存储在IPFS中的初始全局模型和FL任务发布在区块链网络

步骤2:区块链节点从网络中检索任务信息,并保留一个数据副本。然后,客户端可以通过查询最近的活跃节点来获得全局模型的IPFS地址

步骤3、4:利用IPFS下载全局模型。使用全局模型和本地数据进行训练。训练完成后,客户端压缩模型更新,将压缩的梯度Comp(∆w)连同他们的签名作为事务发送到最近的活跃节点

步骤5:区块链节点接收来自客户端的模型更新,通过检查签名和恢复压缩的更新来验证客户端是否被发布,查看与全局模型的相似程度。如果满足这两个要求,节点将此事务传播到网络。当接收到足够多的本地模型更新后,节点根据安全聚合协议计算下一轮的全局模型,生成候选块,并将其发送给VRF委员会。

步骤6:委员会表明“是”或“否”投票来验证全局模型是否正确聚合。如果超过2/3的委员会通过,则将它视为一个经过验证的块并将其传播到网络。

Stake-based Committee Constitution

在VRF的基础上,提出了一种新的随机节点子集的算法。每个节点以一个公共种子(区块链的最新块)作为其输入,独立地运行该算法,看看它自己是否被选为候选委员会成员。节点拥有的股份越多,他被选为委员会的可能性就越高。委员会的规模达到设定值后,第一个委员会成员作leader。任何节点都可以在网络中获取委员会信息,使用他们的VRF公钥和他们的股份来验证委员会成员的身份

Communication-efficient Distributed Training

不是从服务器获得全局模型,而是通过发送客户端请求,在最近活跃的区块链节点中获得最新的全局模型。然后,节点返回最新全局模型的IPFS地址集训练轮次,以便客户端检查模型是否是新更新的模型。为了节省上传模型和进行全聚合的通信成本,使用梯度压缩机制PowerSGD来压缩传输的更新

Secure Aggregation Protocol

使用MI衡量两个随机变量之间的依赖程度,MI可以捕捉变量之间的共享信息量。 由于SGD的随机性,将客户端的局部模型的输出作为一个随机向量。MI分数过低的模型更新由于差异较大被怀疑是恶意的;分数很高的模型更新往往增加模型聚合的冗余,可能会降低收敛速度。为了过滤掉潜在的恶意模型以及贡献较小的模型更新,选择MI分数在95%置信水平内的模型更新进行聚合。聚合后,更新的全局模型M和动量系数m将由聚合器上传到IPFS。然后聚合器生成包含IPFS地址的待处理的候选块,并将其送给委员会进行验证。

Consensus Achievement

**论文题目:ESB-FL: Efficient and Secure Blockchain-Based Federated Learning with Fair Payment

期刊:IEEE Transactions on Big Data

作者:Biwen Chen;Honghong Zeng;Tao Xiang;Shangwei Guo; Tianwei Zhang;Yang Liu

时间:23 May 2022

1、关键词:聚合方法

*论文题目:BlockDFL: A Blockchain-based Fully Decentralized Federated Learning Framework

作者:Zhen Qin;Xueqiang Yan;Mengchu Zhou;Peng Zhao;Shuiguang Deng

关键词:聚合方法

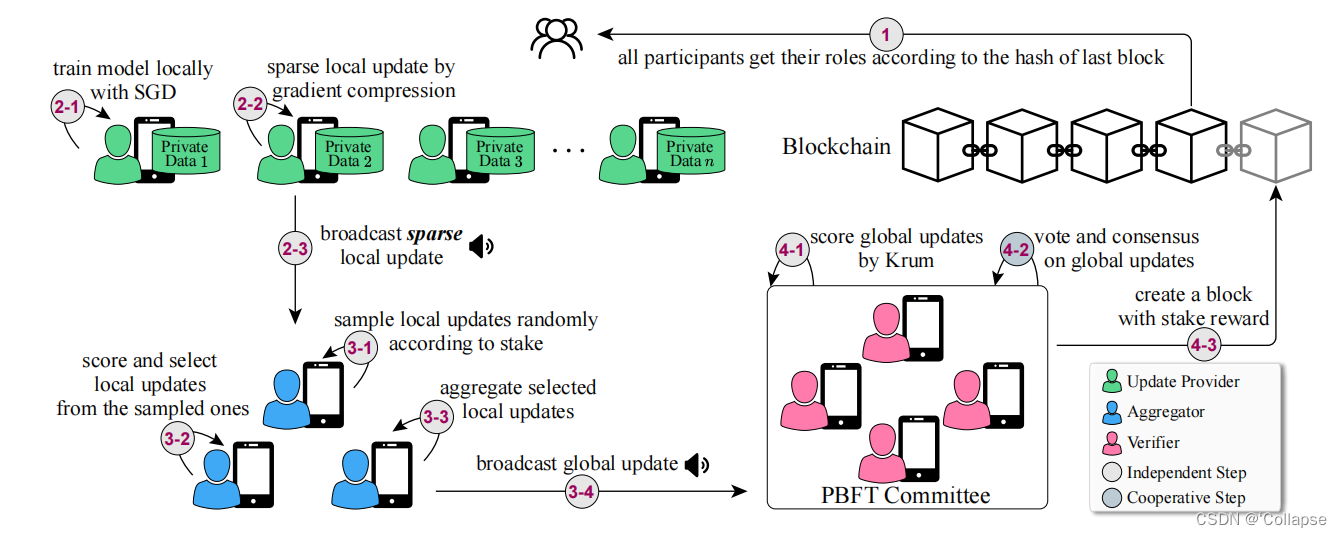

BlockDFL有四个过程:角色选择、本地训练、聚合、验证和共识

由于区块链上记录的stake(股份)可以与金钱奖励挂钩,因此持有大量股份的参与者倾向于诚实的履行义务,因为他们可以在金钱奖励中收益更多。

1.在每一轮通信中,每个节点被随机分配一个角色

2.更新提供者在自己的训练集上使用随机梯度下降算法训练局部模型,并通过梯度压缩对局部更新进行稀疏化,然后将其广播给聚合器

3.每个聚合器接收本地更新,直到获得一定数量的本地更新,然后启动聚合

4.聚合器首先根据提供者的股份从接收到的本地更新中获取一定数量的本地更新。然后,对采样的本地更新进行评分,选择其中一部分进行更新。在获得全局更新后,开始验证阶段

Role Selection

每个参与者根据他们的股份分到一个比例空间。依次选择聚合节点、验证节点、更新节点。(当选择了所有的聚合节点和验证节点后,其余的参与者为更新节点,这确保了具有更多股份的节点更有可能被选为重要角色)。在BlockDFL中,每一轮重新分配一次角色,这可以让每个参与者都有机会向FL系统提供本地更新,同时防御贿赂攻击。

Local Training

为了降低通信成本,将模型进行稀疏化,传输部分更新。为了避免精准性的损失,其余的元素被保留在本地,并积累到该参与者的下一次本地训练中。

Aggregation

聚合中有两个采样过程。第一步使用过滤器,丢弃大部分的模型更新,减轻以后测试的计算成本。第二步是基于中位数的测试,以筛选出高质量、非中毒的本地更新以进行聚合。

Verification and Consensus

Gi是第一个被选中的要验证全局更新。在Gi的验证过程中,leader首先向其他验证者发送一条带有Gi数字签名的信息。当验证其接收到超过2/3条信息后,开始提交阶段。在提交过程中,验证者通过Krum对每个Gi进行评分,分数越低表示质量越高。

*论文题目:Blockchain-enabled Edge Computing Framework for Hierarchic Cluster-based Federated Learning

期刊:2022 14th Internaional Conference on Wrieless Communications and Signal Processing(WCSP)

作者:Xiaoge Huang;Yuhang Wu;Zhi Chen;Qianbin Chen;Jie Zhang

时间:01-03 November 2022

关键词:聚合方法、模型验证

一、解决数据是非独立同分布(Non-IID)情况下的问题。

二、边缘计算网络由中心云层、共识层、边缘层和客户端层组成

中心云层:包含一个中心云,协调FL任务交付、生成智能合约、成果验证

共识层:包含主链层和子链层。主链层用于发布FL任务。子链层由多个独立完成FL任务的部分组成。每个部分包括leader节点和验证节点。采用PBFT共识,更新局部模型梯度信息。

leader节点从客户端的局部模型梯度中聚合全局模型。验证节点负责验证局部模型梯度,并将可信的模型梯度存储到区块链中。全局聚合后,验证节点将奖励分配给提供可信模型梯度的可信id。

边缘层:用于聚类

三、基于层次化集群的联合学习算法

客户端上传局部模型梯度

同时该梯度代表数据的分布。

使用余弦相似度计算梯度之间的相似度,从而得到分布相似的节点,形成cluster。为了减少计算量,只将Non-IID数据进行聚类。如果cluster中数据分布不一致,则节点i的收敛解与cluster的收敛解不同。通过以上方法可以将cluster进行拆分。

*论文题目:Blockchain-based Personalized Federated Learning for Internet of Medical Things

期刊:IEEE Transactions on Sustainable Computing

作者:Zhuotao Lian;Weizheng Wang; Zhaoyang Han; Chunhua Su

时间:23 May 2023

关键词:聚合方法

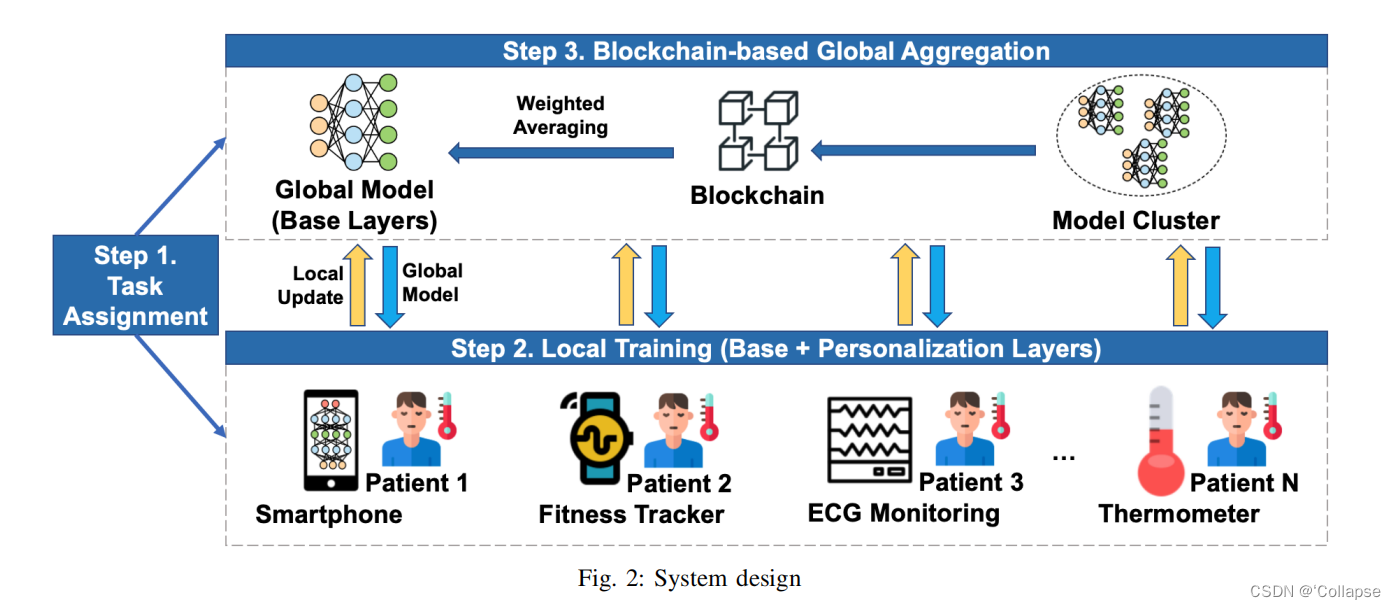

系统工作流程分三步:任务分配、局部训练(基本层+个性化层)、全局聚合

在训练时需要指定模型的划分方法,明确基本层和个性化层。客户端只将模型的基本层上传到区块链进行聚合,个性化则在本地进行维护

*论文题目:Blockchain-based Federated Learning with Secure Aggregation in Trusted Execution Environment for Internet-of-Things

期刊:IEEE Transactions on Industrial Informatics

作者:Aditya Pribadi Kalapaaking;Ibrahim Khalil;Mohammad Saidur Rahman;Mohammed Atiquzzaman,;Xun Yi;Mahathir Almashor

时间:26 April 2022

关键词:聚合方法

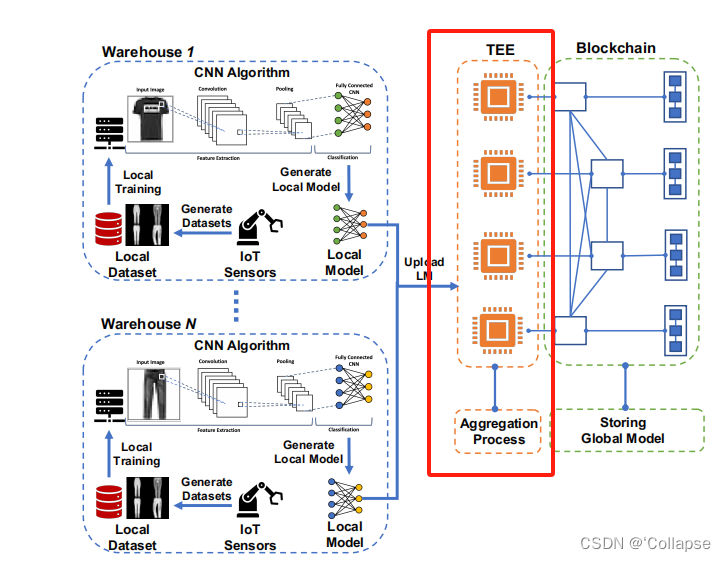

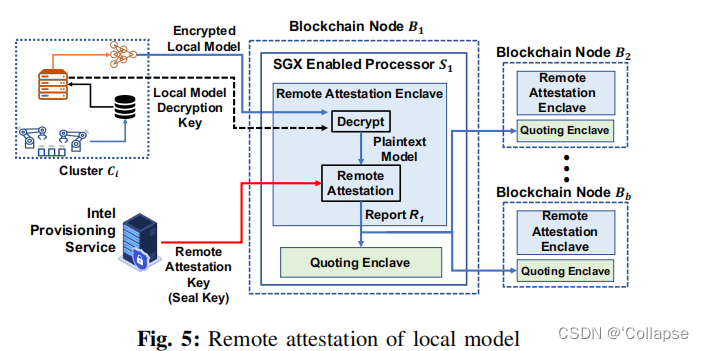

启用TEE的安全聚合模型

区块链节点接收到不同的本地模型后,TEE就可以进行安全聚合。

对于TEE,在这个框架中使用Intel Software Guard Extension (SGX)。SGX是一组CPU扩展,它可以提供独立的执行环境enclaves(一个安全的环境)。区块链节点无法访问启动SGX的CPU Si中的代码和数据。

区块链向Si提供加密的本地训练模型,加密方法使用对称加密。在Si中使用FedAVG算法进行聚合。聚合完成后Si生成一个远程认证Ri,生成的Ri可以用于验证聚合得到的模型