热门标签

热门文章

- 1双积分型ADC工作原理_双积分ad转换器工作原理简述

- 2SpringBoot远程过程调用RPC(WebClient、HTTP Interface客户端)_spring boot 访问外部接口 webclient

- 3百度艾尼(ERNIE)常见问题汇总及解答_ernie ner

- 4每天一个设计模式之过滤器模式(Filter/Criteria Pattern)_c# 过滤器模式 设计模式

- 5【双曲几何学 02】什么是极点和极线?_极点极线

- 6浪潮服务器远程安装Ubuntu系统_浪潮服务器kvm装系统教程

- 72024年泰迪杯数据挖掘B题详细思路代码文章教程_泰迪杯2024数据

- 8【2024-03-24】小红书春招笔试三道编程题解

- 9基于AD9833的信号发生器_ad9833引脚图

- 10BetaFlight飞控启动&运行过程简介_betaflight spi

当前位置: article > 正文

大语言模型如何工作?

作者:从前慢现在也慢 | 2024-04-11 11:10:16

赞

踩

大语言模型如何工作?

此为观看视频How Large Language Model works的笔记。

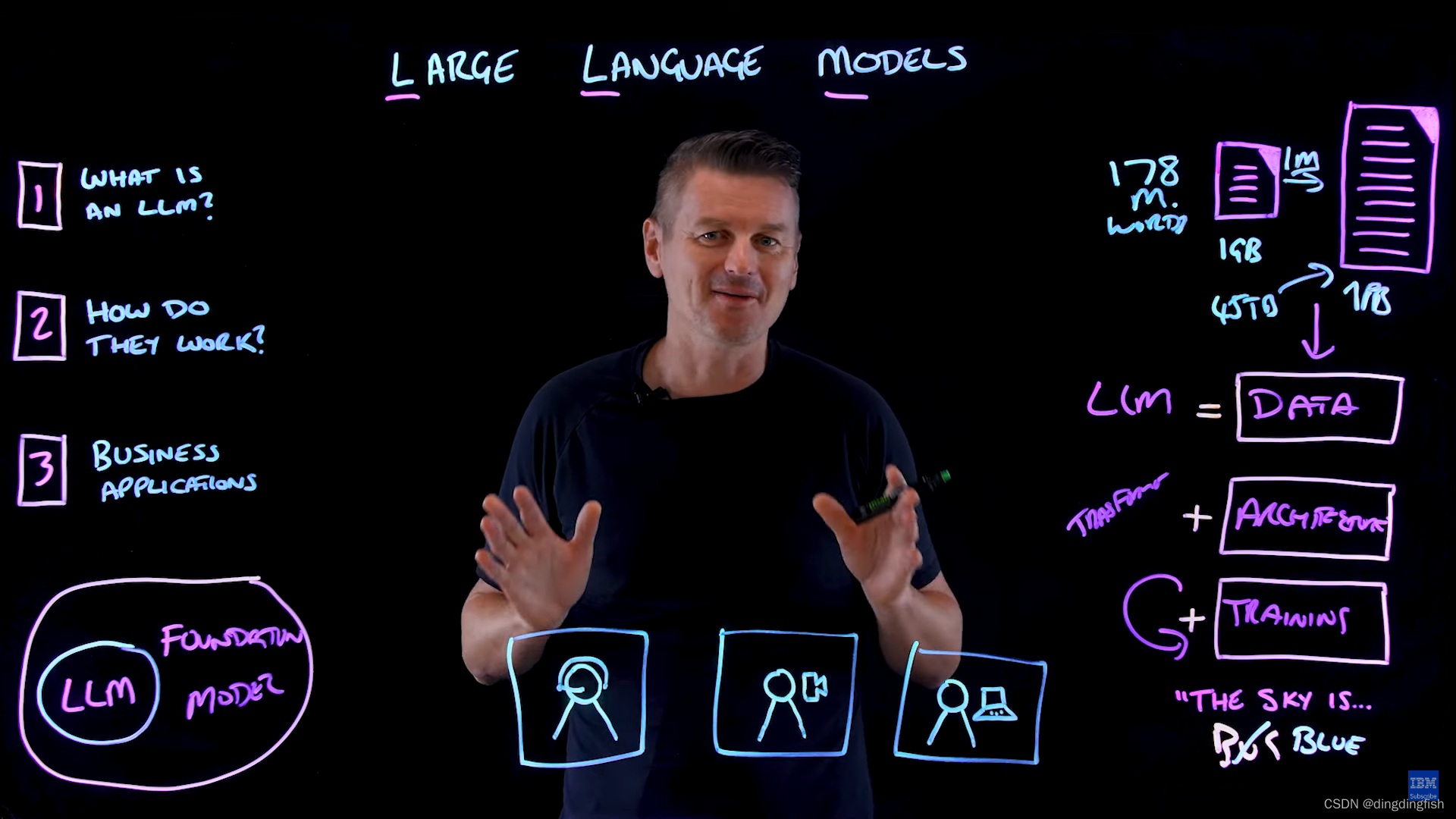

GPT(Generative Pre-trained Transformer)是一个大语言模型(LLM),可以生成类似人类的文本。本文阐述:

- 什么是LLM

- LLM如何工作

- LLM的应用场景

什么是LLM

LLM是基础模型,基于大量未标记和自监督文本数据进行预训练。模型从数据中的模式中学习,产生可推广和自适应的输出。生成的模型可能为几十GB。

大语言模型的“大”体现在2个方面:

- 训练的数据大,为TB或PB级(1GB可以存储1.78亿个单词)

- 参数非常大。参数是模型在学习过程中可以独立改变的值,参数越多,模型越复杂。例如,GPT-3是在45TB数据的语料库上预训练的,使用了1750亿个参数。

LLM如何工作

LLM包括3部分:数据,架构和训练。

架构指的是神经网络,就GPT而言,就是transformer。

transformer架构使模型可以处理序列数据,如句子和代码。transformer通过考虑与每个其他单词的关系来理解句子中每个单词的上下文。这允许该模型建立对句子结构和其中单词含义的全面理解。然后在此架构上对所有这些大量数据进行训练。在训练期间,模型学会预测句子中的下一个单词。它从随机猜测下一个单词开始,然后在每次迭代时,模型都会调整其内部参数,以减少其预测和实际结果之间的差异。该模型不断重复疵过程,逐渐改进其单词预测,直到它能够可靠地生成连贯的句子。现在,模型可以在更小、更具体的数据集上进行微调。模型逐步完善了其理解,以便能够更准确地执行这项特定任务。微调允许通用语言模型成为特定任务的专家。

LLM的应用场景

对于客户服务,企业可以使用LLM创建智能聊天机器人,可以处理各种客户查询,而人可以处理更复杂。

第二个适合场景是内容创建。LLM可以帮助生成文章、电子邮件、社交媒体帖子,甚至YouTube视频脚本。

对于软件开发,LLM还可以生成和审查代码。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/404672

推荐阅读

相关标签