- 1WebApi返回类型设置为json的三种方法

- 2李宏毅机器学习--self-supervised:BERT、GPT、Auto-encoder_autoregressive模型 和 self-supervised

- 335款优秀的 SpringBoot/SpringCloud 开源项目,开发脚手架,总有一款适合你!

- 4Flutter入门-Flutter配置_flutter支持的最低安卓版本

- 5推荐一本Vue开发的书籍_vue书籍

- 6【网络奇遇记】计算机网络三大交换方式:电路交换、分组交换和报文交换_电路交换网络和分组交换网络

- 7大数据 - Spark系列《二》- 关于Spark在Idea中的一些常用配置_idea sprk

- 8hive 列转行—collect_set()/collect_list()/concat_ws()函数的使用场景_collect set函数用法

- 9GitHub 各种开源项目_github项目推荐

- 10java 8 的流库api 使用详解_streamsupport.stream(graphquery.vertexids().splite

将 Llama2 中文模型接入 FastGPT,再将 FastGPT 接入任意 GPT 套壳应用,真刺激!_text-generation-webui

赞

踩

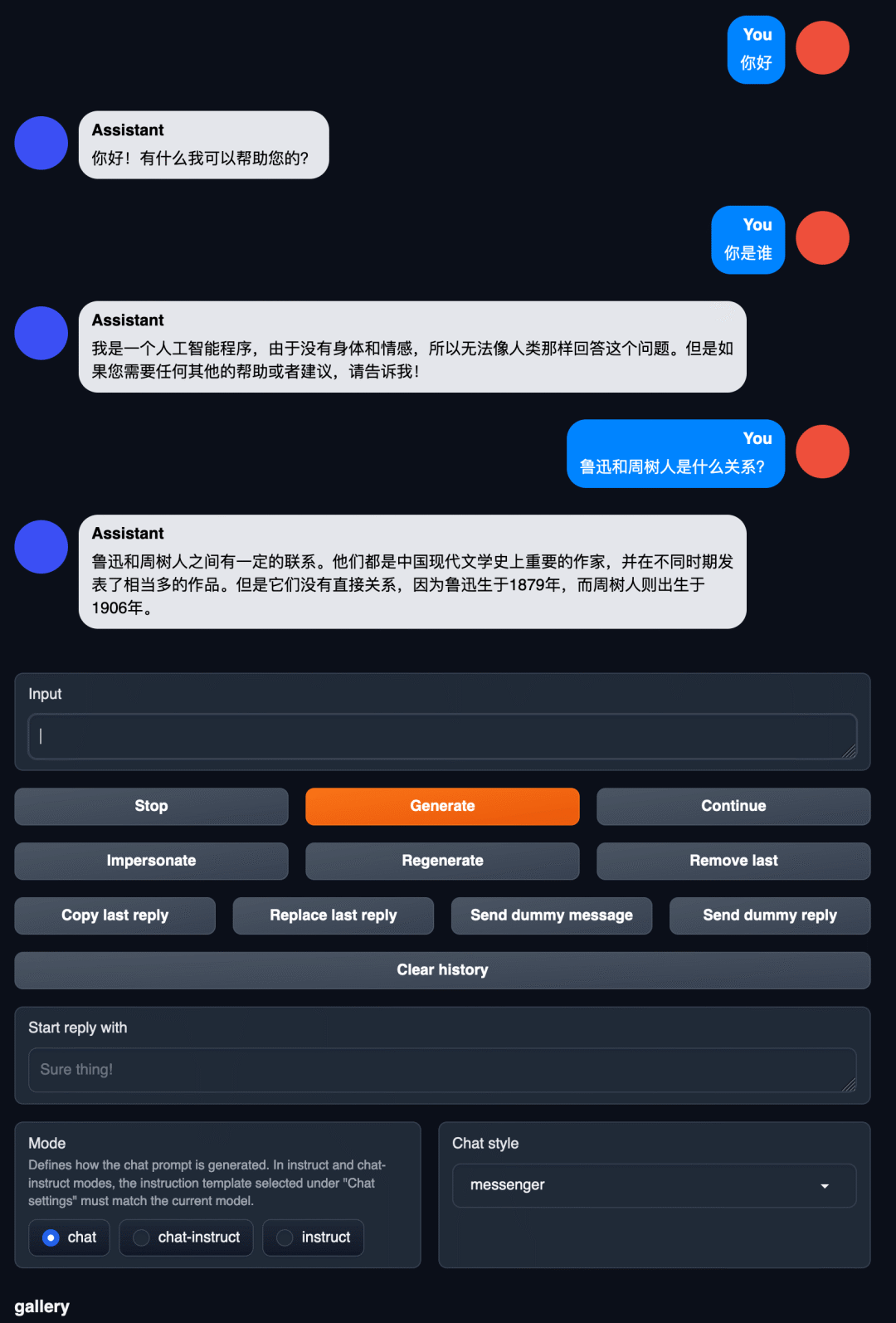

FastGPT(https://fastgpt.run) 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。同时可以通过 Flow 可视化进行工作流编排,从而实现复杂的问答场景!

Llama2 是Facebook 母公司 Meta 发布的开源可商用大模型,国内的开源社区以及个人和机构也纷纷着手基于 Llama2 构建了中文版,并且还利用 GGML 机器学习张量库构建了可以在 CPU 上运行的 Llama2 中文版模型。

今天我们来玩点刺激的! 首先在 CPU 上运行一个开源的 Llama2 中文版模型,然后将这个模型接入到 FastGPT 的知识库中,最后再将 FastGPT 接入第三方任意 GPT 套壳应用。

一键运行 LLama2 中文版

运行模型有很多种方法,但是为了能和各种 GPT 应用兼容,最好能够提供一个对外的 API,并且这个 API 还得对齐 OpenAI 的 API。这就需要用到一个叫做 Text generation web UI 的项目。

Text generation web UI

Text generation web UI 是一个大语言模型启动器,它的终极目标是在 AI 对话领域对标 Stable Diffusion WebUI。引用 GitHub 原文:

❝ A gradio web UI for running Large Language Models like LLaMA, llama.cpp, GPT-J, OPT, and GALACTICA.

Its goal is to become the AUTOMATIC1111/stable-diffusion-webuiof text generation.

它可以加载几乎所有的主流模型(支持 llama.cpp 模型),并且在本地运行他们。语言模型能做什么,你就能体验到什么,可以当成离线版 ChatGPT 来使用。再加上 ChatGPT 在国内的审查问题,以及信息泄露风险,客制化的本地模型几乎提供了无限可能。

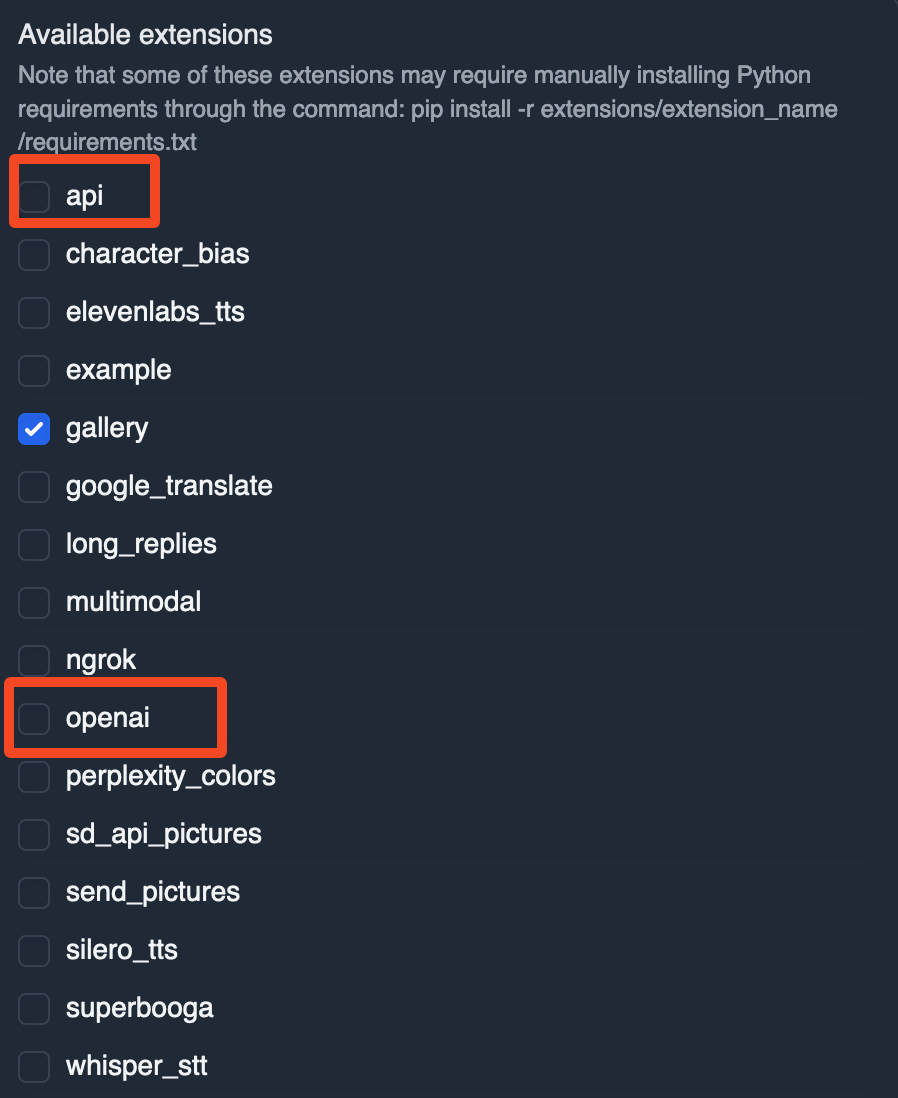

值得一提的是,它还支持通过 API 来进行调用,同时还提供插件对齐 OpenAI 的 API,你可以将其接入任意套壳 GPT 应用中。

接下来我们就需要用到这个 openai 插件!

Sealos 国内集群

今年 6 月份,Sealos 正式上线了海外集群(