热门标签

热门文章

- 1Ubuntu22.04 roshumble 跑 mid360 SDK

- 2浙大版python程序设计编程练习题解_浙大python习题答案

- 3一文搞懂Secure Boot (安全启动)

- 4xctf web之 command_execution

- 5高效实用|ChatGPT指令/提示词/prompt/AI指令大全,基础版_prompt指令大全

- 6python实例入门学习_python编写数位和倍数

- 7软件缺陷报告模板(微信缺陷报告案例)_qq和微信报告缺陷exce

- 8回表查询 覆盖索引 索引下推

- 9FPGA纯verilog代码实现8位精简指令集CPU,一学期的微机原理不如看懂这套代码,提供工程源码和技术支持_微机verilog一学期不如一节课csdn

- 10Cause: java.sql.SQLSyntaxErrorException: Unknown column_nested exception is java.sql.sqlsyntaxerrorexcepti

当前位置: article > 正文

NLP-D31-《动手学pytorch》完结&BERT&Layer_norm_bertlayernorm

作者:从前慢现在也慢 | 2024-05-27 09:23:41

赞

踩

bertlayernorm

---------0439我感觉今天终于可以阶段性地看完沐沐的课了!!!狂喜!马上终于可以看看宝可梦了嘿嘿嘿!

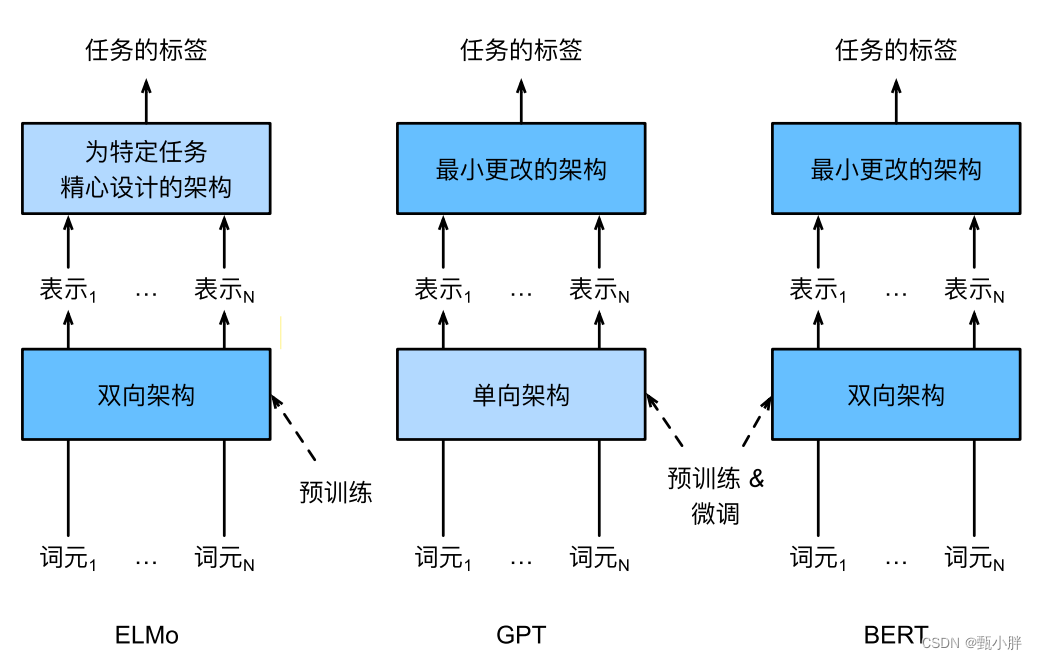

1、ELMo&GPT&BERT对比

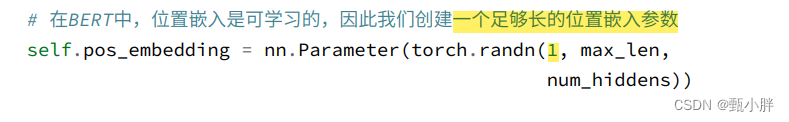

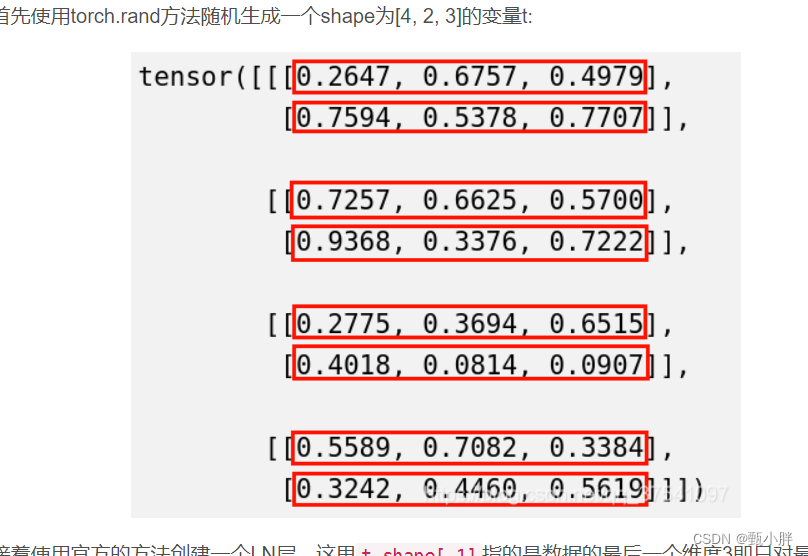

2\位置嵌入参数

全局来看,应该也就只有一个位置嵌入参数

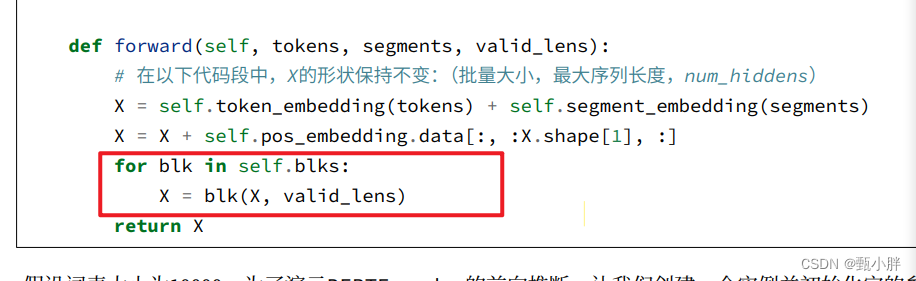

3\BERT的valid_len第一层觉得有意义,后面感觉就很生硬了

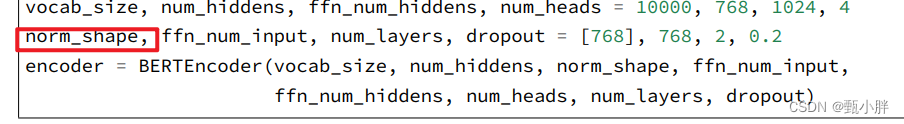

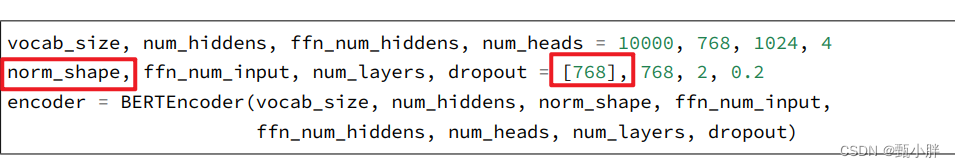

4\为啥norm_shape一会一维一会二维呢???

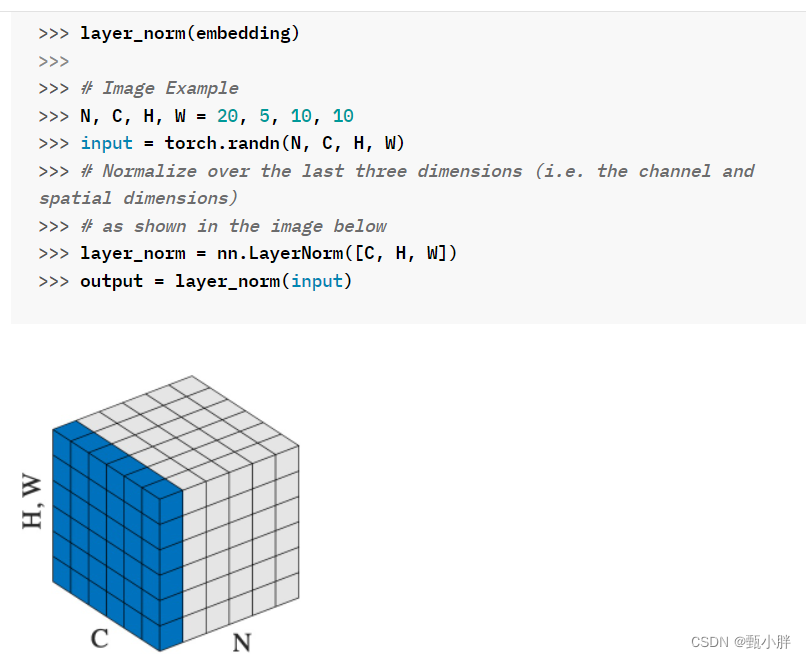

5\Layer_norm的使用方法

参数传几维,就对几维座layer_norm,不过传的时候shape要匹配。

传最后一维

参考:https://blog.csdn.net/qq_37541097/article/details/117653177

这里面应该是把【768这维给norm了】。这个细节之后再研究吧。

传3维,官方文档也很给力

参考:

-------0522先干个饭

6、Momentum用来做梯度平滑;Adam做梯度平滑+并且调整各个维度的值,避免因为值大小不同,lr不好取。

看到最后一节啦!!!!沐沐大大棒棒!!!

----06020看完啦!!!又被种草了《实用机器学习》,不过有一说一,本来就是想看的hhhhhhhh

现在来把BERT代码敲完hhh

—0638ee网络冲了一波浪,现在就学hhh

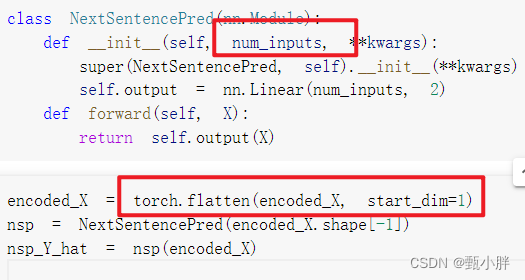

7\NSP任务

做nsp任务时,留下batch_size层,把接下来的维展开,用单层感知机进行预测。

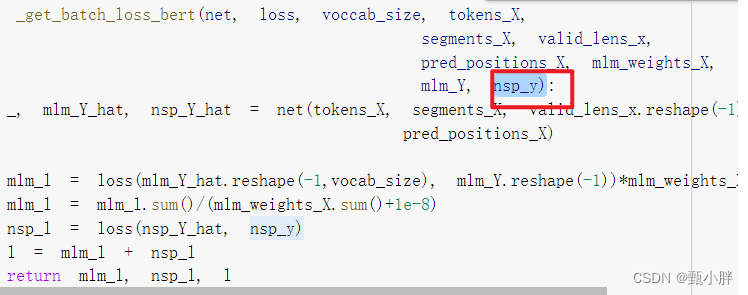

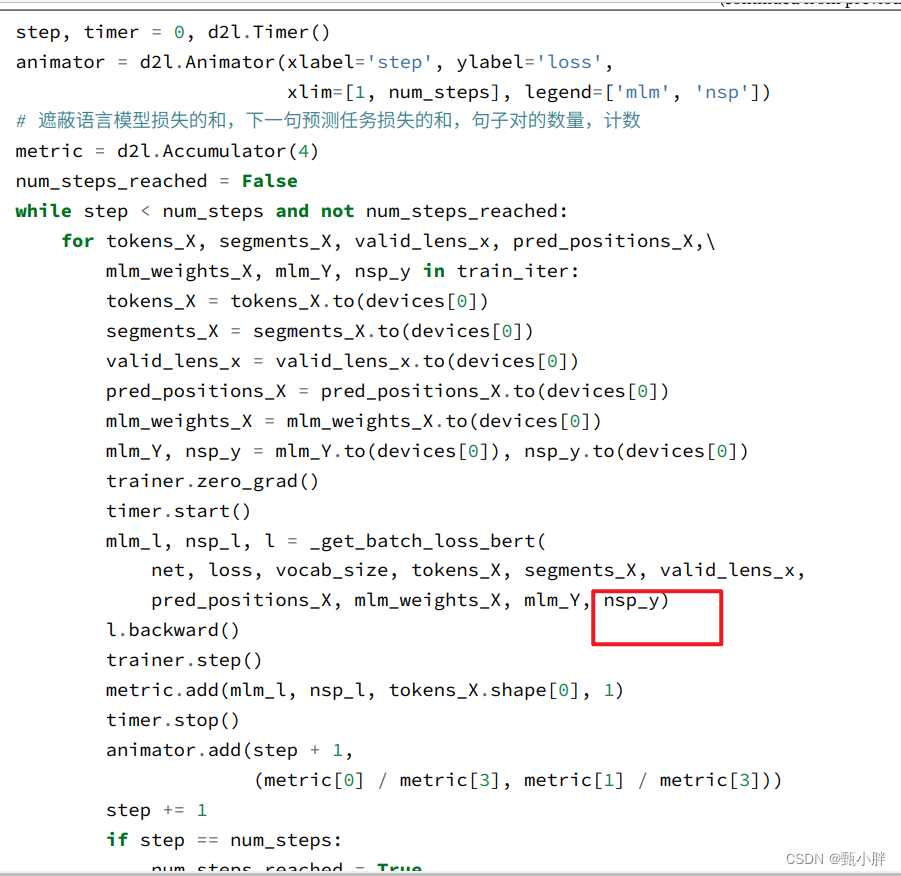

8在get_batch_loss中传入nsp_y即真实值

在get_batch_loss中会做前向传播,得到nsp_y_hat,因此,在最后的train中,也只需要传入真实的nsp_y供其计算损失即可。

—0837帮同学回答了一些毕设相关的问题,还是蛮开心的hhh,继续写bert啦

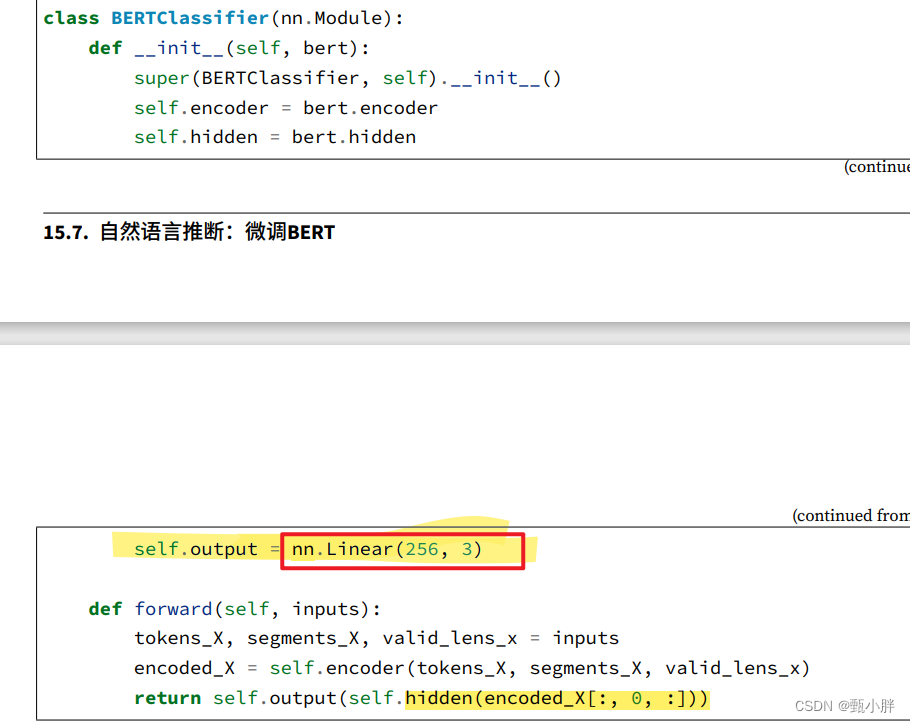

9Bert微调实例

得到cls的最终表示后,再放入一个hidden和一个linear层,得到最终正向推理结果。

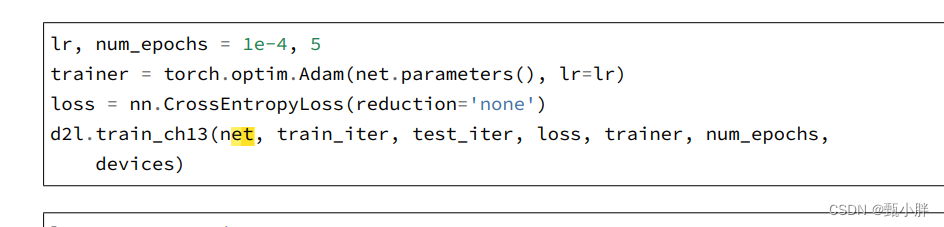

在定义了正向推理(net)过程后,便可以train了,也就是根据目标的y不断地优化模型参数。

!!!完结撒花!!!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/630944

推荐阅读

相关标签