- 1使用 ORPO 微调 Llama 3 更便宜、更快的统一微调技术(教程含源码)

- 2【技术科普】主流的深度学习模型有哪些?AI开发工程师必备!_常用深度学习模型

- 3保研边缘渣渣的保研心得......_大三保研党材料

- 4大数据-孩子学习成绩分析_学生成绩数据集

- 5怎么让员工服从管理_如何面对不服从管理的员工?巧用这5点管理“刺头”员工...

- 6安装企业版pycharm以及anaconda_pycharm企业版

- 7如何使用Python读写多个sheet文件_python sheets 选择读取多行sheet(1)_python读取多个sheet表

- 8STM32读写内部FLASH

- 9七周三次课(5月8日)_ens33里面有冒号是什么原因

- 10Git和Github_ic项目 github

手撸私有AI大模型——ollama本地部署私有大模型_ollamasetup.exe

赞

踩

作者:vscene 时间:2024年5月17日 版权声明:如需转载请注明出处

目录

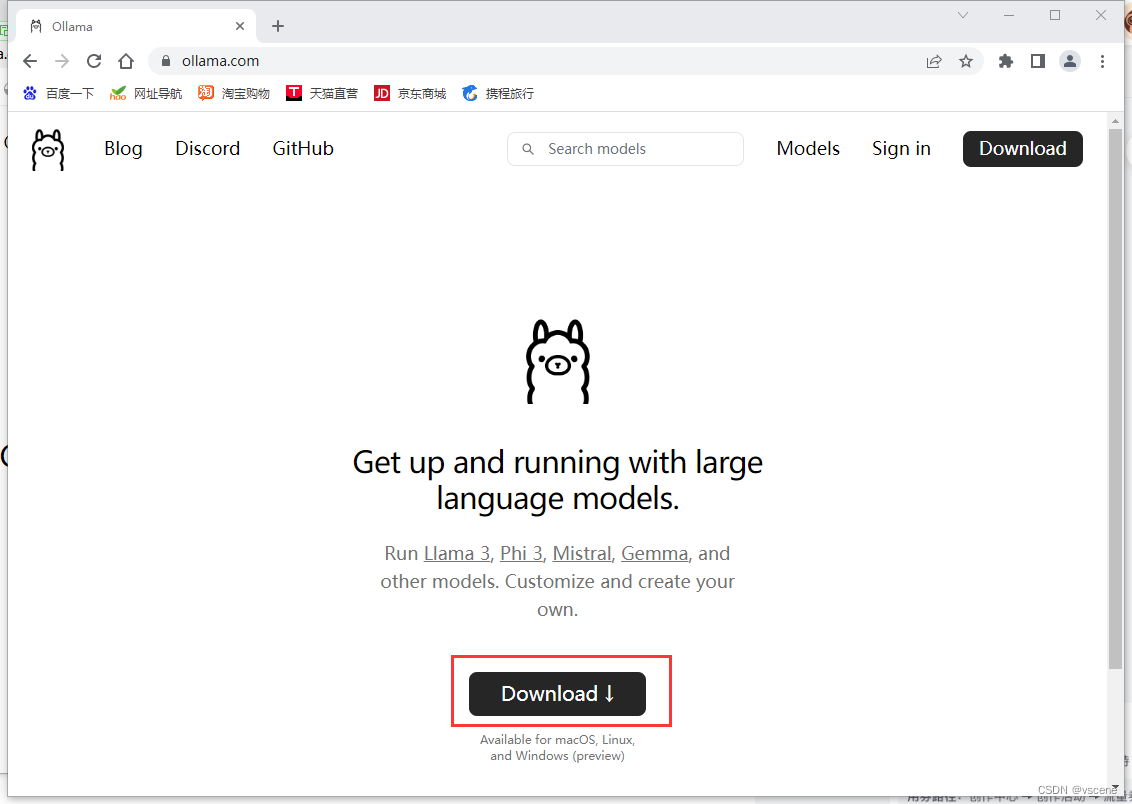

1.下载ollama

访问ollama的官网https://ollama.com/,点击【Download】

http://ollama.com/

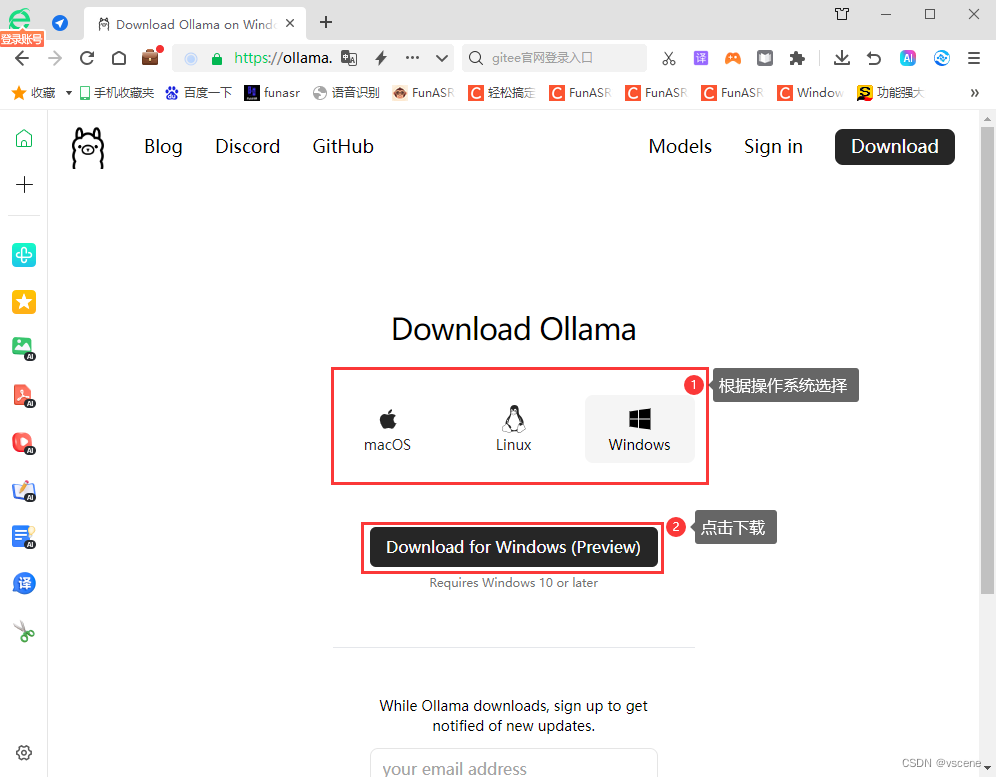

选择操作系统类别,这里我选择的是Windows,OllamaSetup.exe (198MB)

2. 安装OllamaSetup.exe

双击运行OllamaSetup.exe

默认安装路径为:

C:\Users\Administrator\AppData\Local\Programs\Ollama

Administrator 为当前windows 登录用户名

3. 下载大模型

复制模型名称,通过命令行下载,命令为ollama run [模型名称]

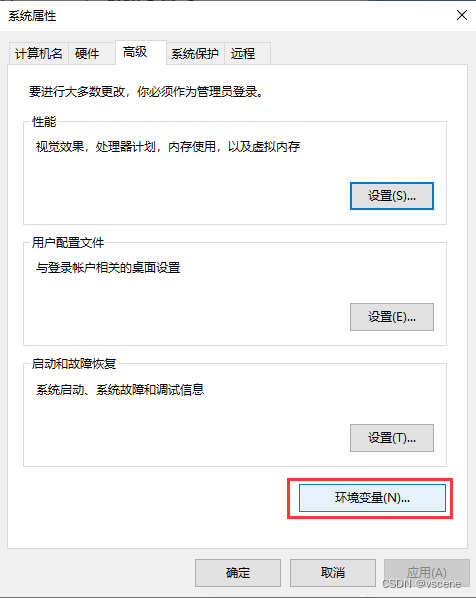

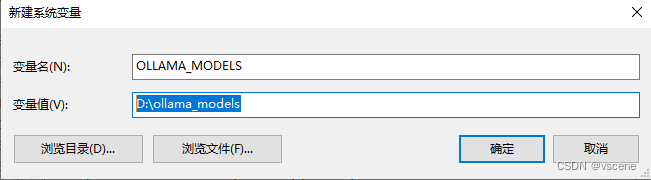

配置模型下载到本机的路径。如果c盘空间不足(模型至少占用4GB),可以下载到其他盘上,这里设置为下载到D盘。

默认下载路径:C:\Users\Administrator\.ollama\models,通过配置环境变量 OLLAMA_MODELS修改下载路径

注意:配置模型安装位置配置,可以在运行这个命令前在系统环境变量中配置【在运行中输入“sysdm.cpl”命令】,然后配置

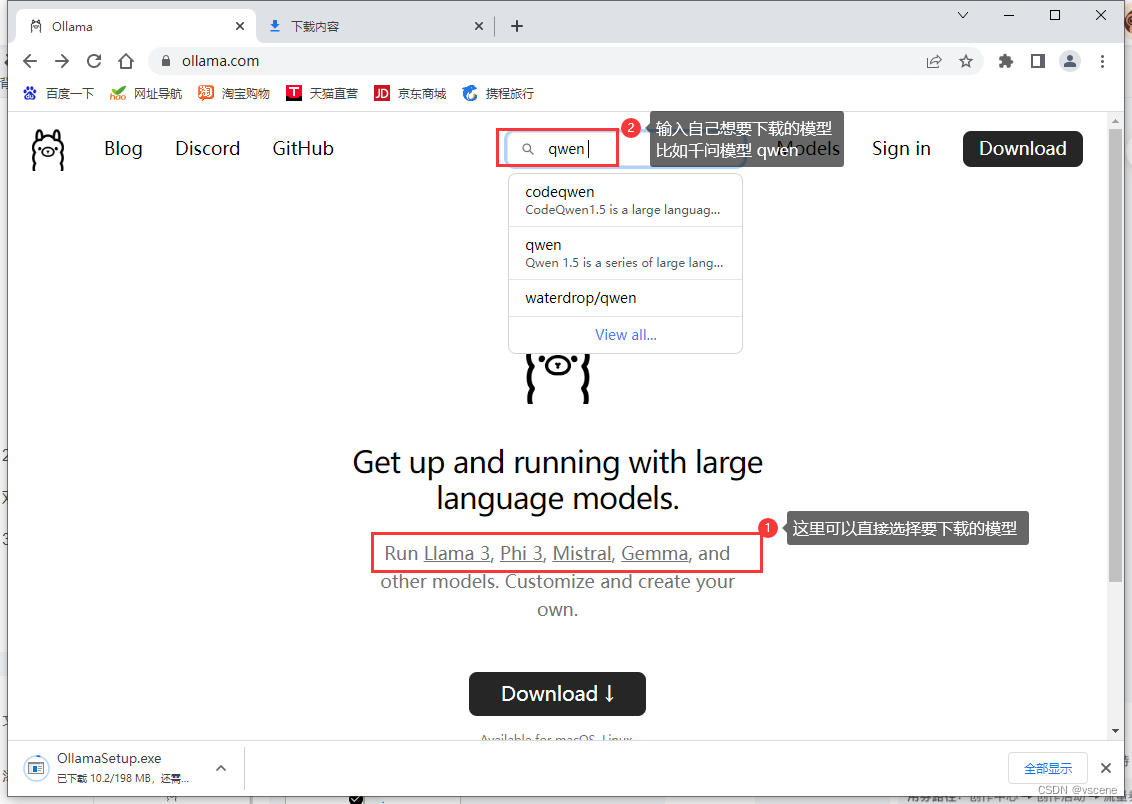

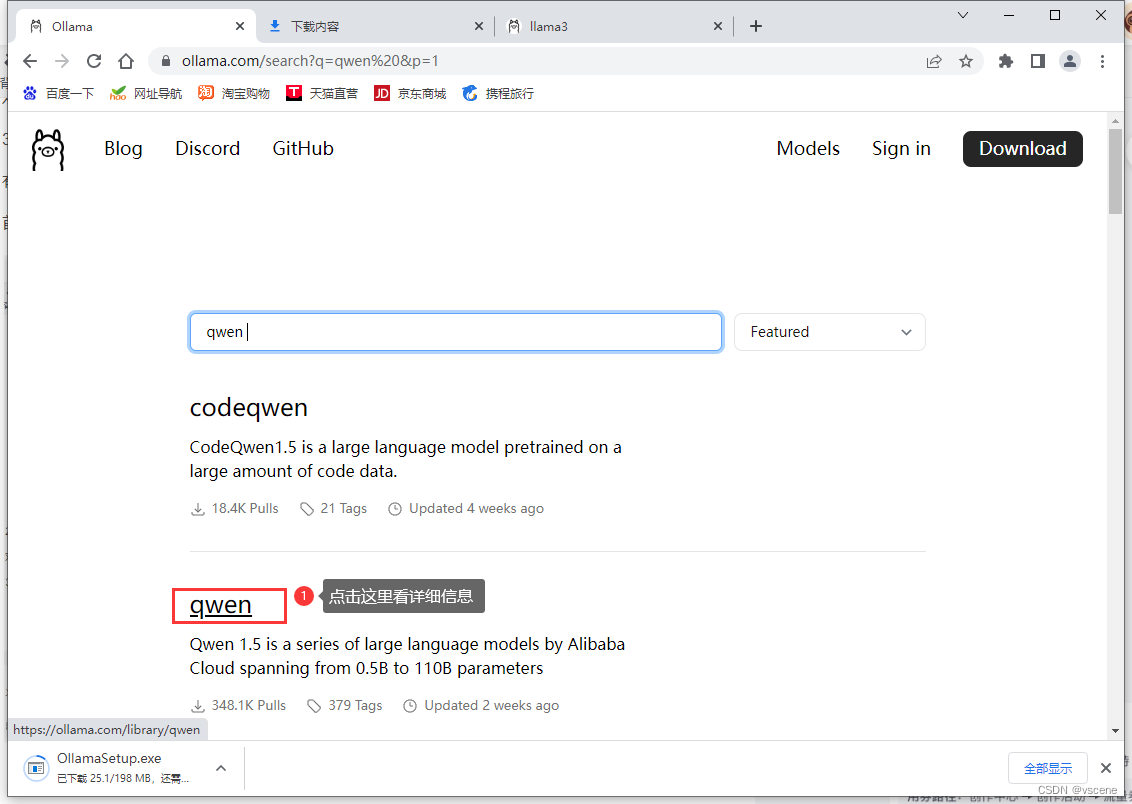

首先,查询到想要现在的模型名称及连接地址

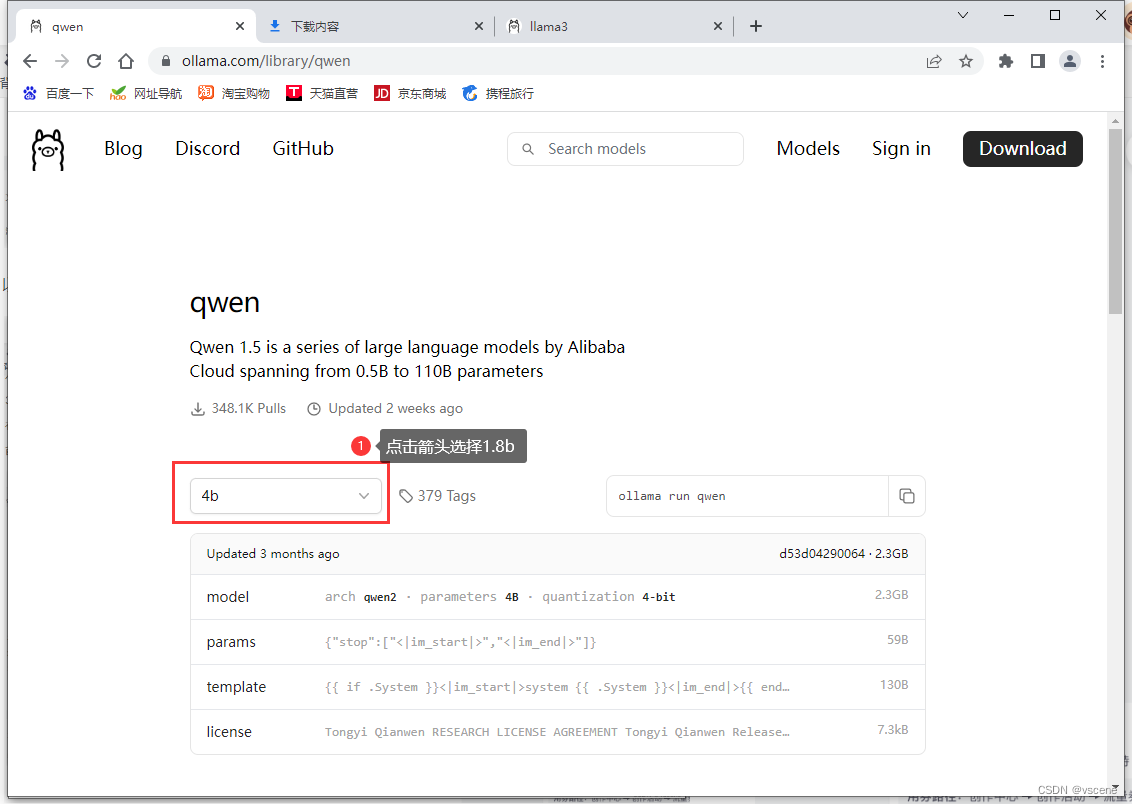

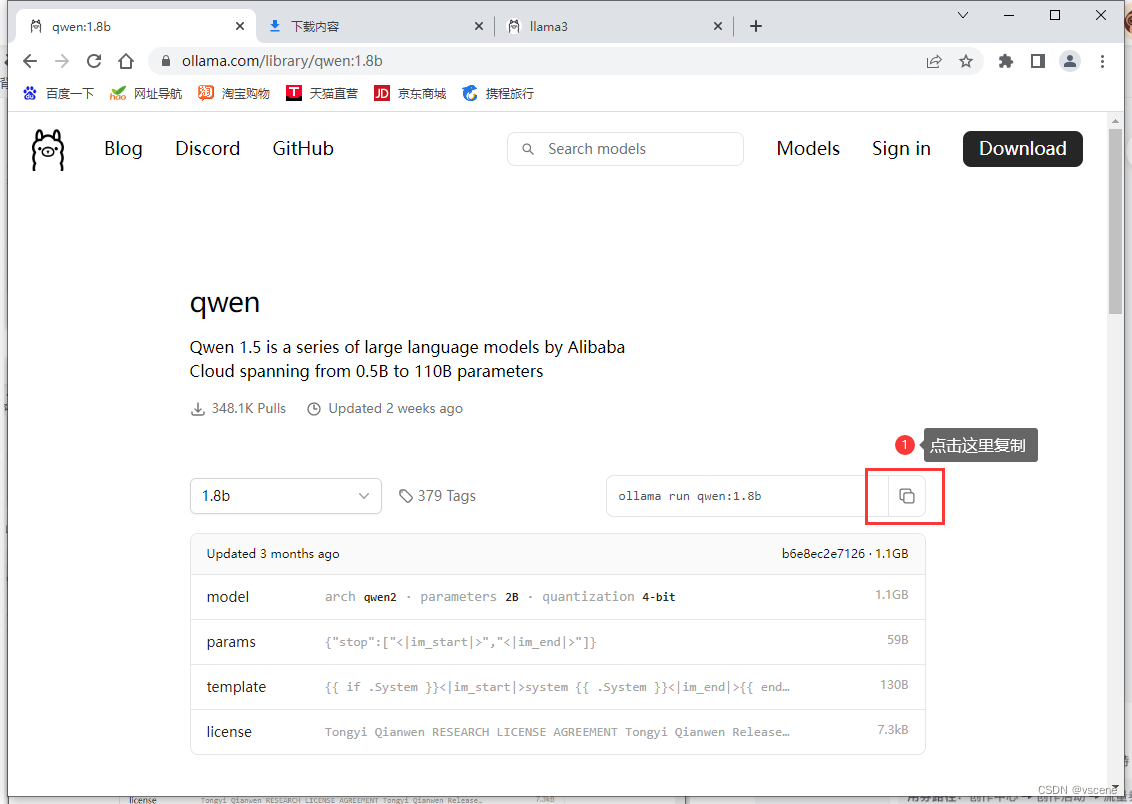

以下载 qwen1.8b为例

复制下载的连接地址:ollama run qwen:1.8b

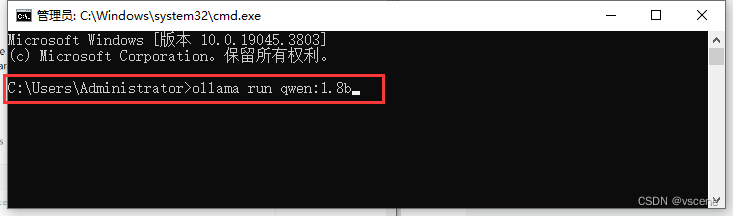

在命令行cmd 中,运行 ollama run qwen:1.8b,回车

ollama run qwen:1.8b

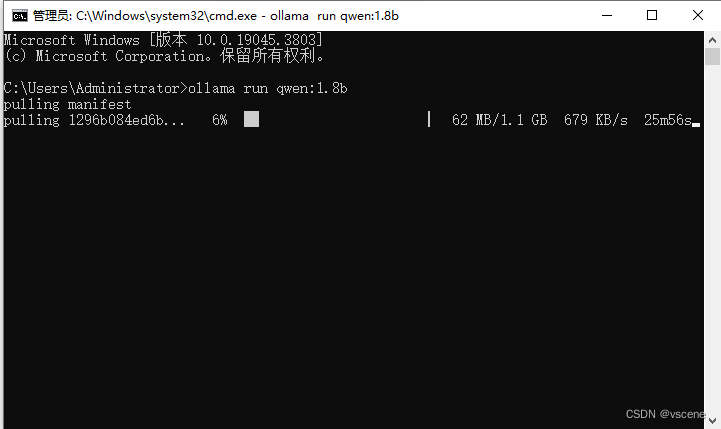

开始下载 qwen1.8b模型

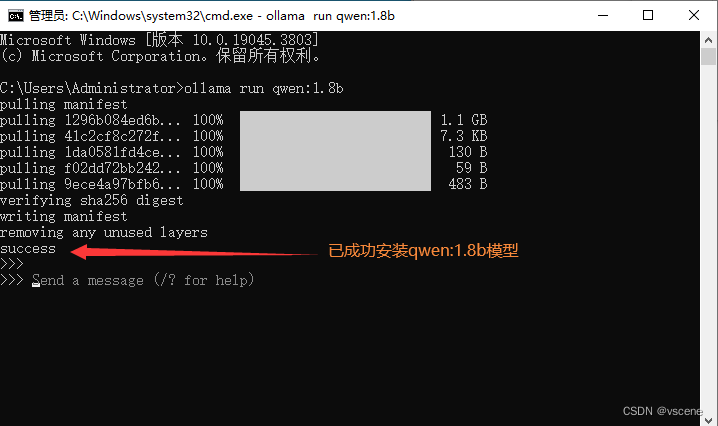

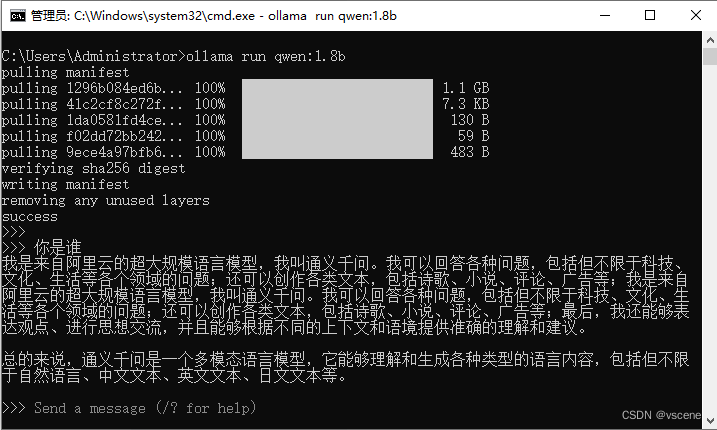

下载成功后就可以看到 success 提示。在>>>后面输入想要问的问题就可以和大模型对话了。

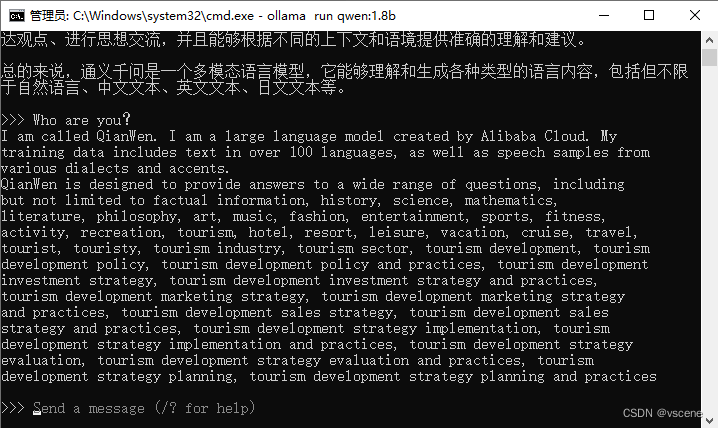

输入 你是谁,大模型就会给出回答。回答的相应速度和本机的硬件CPU和GPU有关,我这里只有CPU所以会慢点,不过可以在本地运行大模型还是很让人惊喜的。

4. 运行大模型

在命令行中再次运行ollama run qwen:1.8b(其实下载模型和运行模型都是同一个命令,本地没有这个模型就先下载,如果有这个模型就运行)

ollama run qwen:1.8b

通过英文问看看回答如何

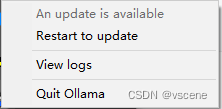

5. 重启并更新 ollama

在任务栏有 ollama 的图标,点击可以看到菜单

重启 restart to update

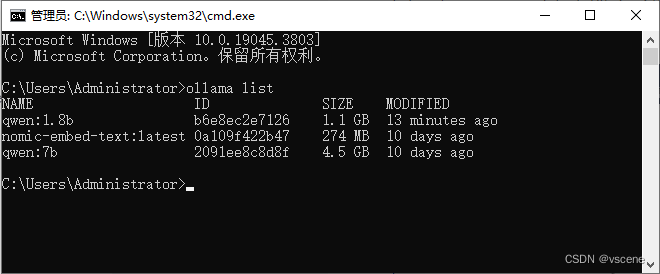

6. ollama 常用命令

ollama -v:显示版本

ollama list:显示模型列表

ollama show:显示模型的信息

ollama pull:拉取模型

ollama push:推送模型

ollama cp:拷贝一个模型

ollama rm:删除一个模型

ollama run:运行一个模型

ollama serve:启动ollama 服务,端口号11434

ollama create:从模型文件创建模型

ollama help:获取有关任何命令的帮助信息

显示本地有那些模型 ollama list

ollama list

如果想要有一个webui交互界面,我们可以通过编程的方式来实现,或者下载一个开源的webui

后续的分享会通过代码的方式搭建一个webui