热门标签

热门文章

- 1今年,中国AI大模型产业发展看这些_大模型数据

- 2Leetcode 73. 矩阵置零 C++_矩阵 所有值赋值为0 c++

- 3昇思MindSpore 25天学习打卡营|day1

- 4信号特征之希尔伯特变换(Python、C++、MATLAB实现)_python 希尔伯特变换

- 5idea用Git如何拉取、更新、上传提交项目(最新版idea2018.2.5版)超详细超简单版_idea git拖一个新增文件

- 6python查找图片_python 在屏幕中找 图片

- 7JAVAWEB项目页面设计之网上商城JSP页面设计一------JavaWeb_网站商城页面的web

- 8Oracle和My Sql返回结果集的存储过程

- 9超详细!一文搞定PID!嵌入式STM32-PID位置环和速度环_位置环pid分别代表什么

- 10【Android】如何使用ADB进行调试_adb调试

当前位置: article > 正文

anaconda安装spark_conda install pyspark

作者:从前慢现在也慢 | 2024-06-28 18:23:43

赞

踩

conda install pyspark

anaconda安装pyspark

进入Anaconda Prompt (Anaconda3),使用conda install pyspark或者 pip install pyspark

conda install pyspark

- 1

pip install pyspark

- 1

报错解决

- 报错:

Solving environment: failed with initial frozen solve. Retrying with flexible solve

- 1

- 解决办法

可先升级conda,在Anaconda Prompt执行conda update指令

conda update

- 1

然后会执行打了更新包,耐心等待

更新完成以后,再执行一遍conda update --all,然后再安装包就没有问题了

conda update --all

- 1

- 报错

Exception in thread “main" java.lang.UnsupportedClassVersionError Unsupported major.minor version 52.0

- 1

原因是jdk格式不对,52.0表示JDK格式需为1.8版本

- 解决办法

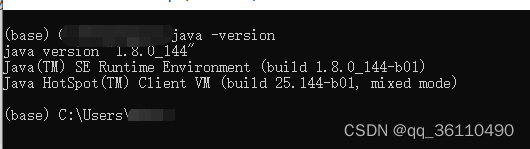

cmd查看本地JDK版本`

java -version

- 1

发现版本为1.7,需将版本升级到1.8版本,可下载1.8版本JDK,官网下载地址:https://www.oracle.com/java/technologies/downloads/archive/

安装新版JDK办法

①删除原有版本SDK文件,然后将新版本将其解压到原有的jdk文件夹下,然后修改系统变量

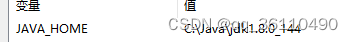

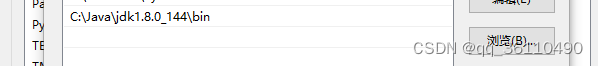

JAVA_HOME 为JDK的文件夹地址,path为jdk的bin文件夹地址,示例:jdk所在位置为:

C:\Java\jdk1.8.0_144

② ②修改注册表

② ②修改注册表

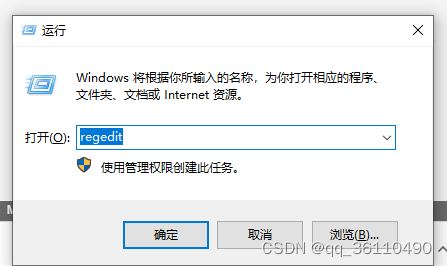

win+R 然后输入regedit

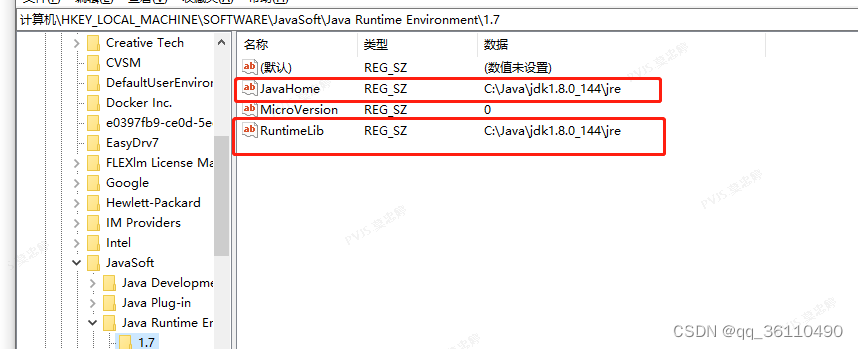

修改HKEY_LOCAL_MACHINE\SOFTWARE\JavaSoft\Java Runtime Environment的子项,将JavaHome及RuntimeLib值设置为JDK的jre文件夹位置

修改HKEY_LOCAL_MACHINE\SOFTWARE\JavaSoft\Java Runtime Environment的子项,将JavaHome及RuntimeLib值设置为JDK的jre文件夹位置

③查看java的位置,发现java.exe不仅在jdk文件夹中,还在System32里,需删除system32的java.exe ,javaws.exe,javaw.exe文件

where java

- 1

然后查看java版本,发现已更新至1.8版本

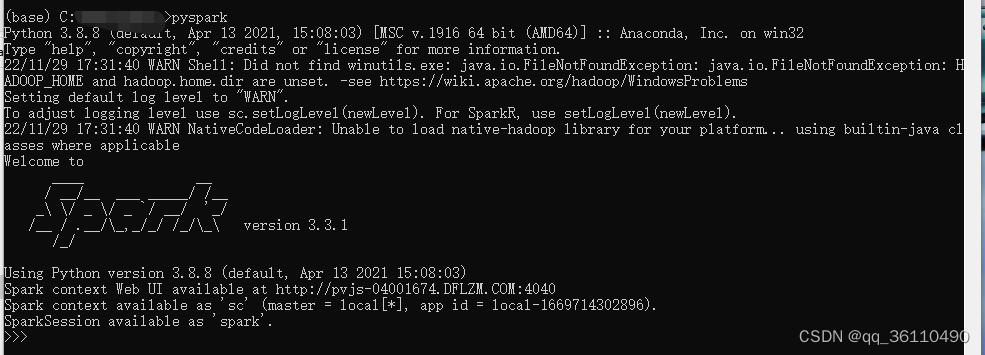

以上报错都处理后,可顺利安装pyspark,安装成功如下图:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/766902

推荐阅读

相关标签