热门标签

热门文章

- 1Set集合(Java) 及底层原理_set集合的底层原理

- 2CorelDRAW2024官方中文版重磅发布更新_coreldraw 2024启动界面

- 3Spring Boot_spring boot springtoolsuite4 vm option

- 4事实表和维度表是怎么造数据_数据仓库建模方法论

- 5【数据结构】带你深入栈和队列,轻松实现各种接口功能

- 6Linux下DISPLAY环境变量的作用_linux display的用法

- 7揭秘 .npmrc 文件:NPM 包管理器的秘密武器

- 8【面经笔记】哈希表_哈希表有14个桶新元素31的位置

- 9MySQL从入门到入魔,总结我的学习历程,给有需要的人看!

- 10Win2008(IIS+PHP7.2.33)无法显示详细错误(始终显示500错误)或提示The FastCGI process exited unexpectedly_php7.2 phpoffice错误500

当前位置: article > 正文

YOLOv5改进策略|YOLO模型优化|Slowfast 和 YOLOv5 检测器 自动驾驶、车辆识别、车牌识别、车道识别、行人识别_yolo 自动驾驶

作者:从前慢现在也慢 | 2024-08-15 19:46:39

赞

踩

yolo 自动驾驶

订阅专栏后私信(留下联系方式)获取完整源码+远程部署

目录

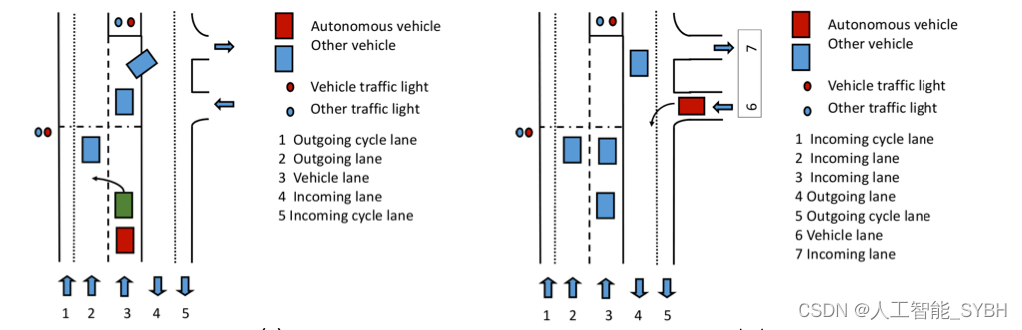

最近几年,自动驾驶(或者机器人辅助驾驶)已成为一个快 速发展的研究领域。全自动驾驶汽⻋的竞赛促使许多大公司, 如谷歌、丰田和福特,开发了自己的概念机器人汽⻋[1]、[2]、 [3]。尽管自动驾驶汽⻋被广泛认为是人工智能实际应用的主要 开发和测试场,但安全性、道德、成本和可靠性方面仍然存在令 人担忧的主要原因[4]。特别是从安全⻆度来看,智能汽⻋需要 强有力地解释与他们共享环境的人类(驾驶员、行人或骑自行⻋ 者)的行为,以便应对他们的决策。态势感知因此,了解其他道 路使用者行为的能力对于自动驾驶⻋辆(AV)的安全部署至关重 要。

最新一代的机器人汽⻋配备了一系列不同的传感器(即激光 测距仪、雷达、摄像头、GPS),以提供有关道路上发生的情况 的数据[5]。然后融合如此提取的信息以建议⻋辆应如何移动 [6]、[7]、[8]、[9]。然而,一些作者认为,视觉对于自动驾驶汽 ⻋来说是一种足够的感知能力,可以在其环境中导航,并得到人 类这样做的能力的支持。无需征召我们自己作为后一种观点的支持者,在本文中我们考虑了以下背景:基于 视觉的自动驾驶[10]来自安装在⻋辆上的摄像头以流媒体、在线 方式捕获的视频序列。

虽然检测器网络 [11] 通常经过训练以促进道路场景中的物体 和演员识别,但这只是让⻋辆“看到”周围的事物。这项工作的 理念是,强大的自动驾驶能力需要以语

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/984979

推荐阅读

相关标签