热门标签

热门文章

- 1vue2公众号跳转小程序 wx-open-launch-weapp 超完整流程

- 2Unity用ZXing插件生成二维码_zxing unity

- 3获取本机软件安装目录_获取软件安装目录

- 48- app如何修改包名_raname

- 5sqoop导入mysql到hbase报错 java.lang.NoSuchMethodError: org.apache.hadoop.hbase.client.HBaseAdmin.

- 6基于MATLAB的遗传算法优化卡车和两架无人机的配送路径规划_卡车无人机协同配送代码

- 7Spring Boot Actuator未授权访问远程代码执行_eureka_XStream反序列化_springeureka平台未授权访问

- 8zookeeper连接不上/Session 0x0 for server null, unexpected error, closing socket connection

- 9AI-如何有效测试机器学习模型_机器学习测试

- 10必须要掌握的【Hbase Shell】_create 'scores2',{name=>'course',versions=>3},{nam

当前位置: article > 正文

自主部署和运行大语言模型Llama3的5种方法_llama3 安装

作者:代码探险家 | 2024-06-29 09:52:21

赞

踩

llama3 安装

Meta 最近发布了Llama 3,这是其开源大型语言模型(LLM)的最新和最强大的版本。Llama3包括两个版本:Llama 3 8B(含80亿个参数)和 Llama 3 70B(含700亿个参数),这两个版本都有基础和指令调整变体。

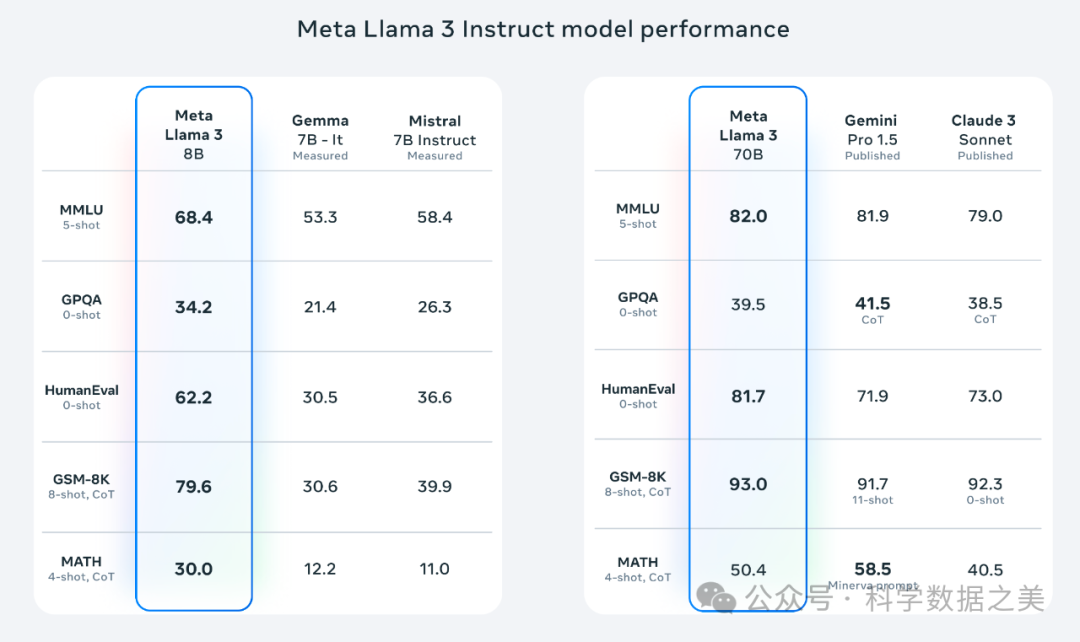

与Llama 2相比,Llama 3模型降低了错误拒绝率,提供了双倍的上下文长度,具有 8K 标记上下文窗口。Llama 3 模型的训练数据比 Llama 2 多出约 8 倍,在24000个GPU卡上,使用了超过 15 万亿个token的新的公开在线数据组合。HumanEval的大模型代码能力评测对比结果中,作为开源模型的Llama3得分为81.7分,高于闭源商业模型Gemini Pro 1.5(71.9分)和Claude 3 Sonnet(73分),低于Claude 3 Opus (84.9分) 和GPT4 Turbo (85.7分)。

本文介绍5种安装和运行Llama3的方法,供参考。

- 使用Web浏览器部署和运行模型

该方法使用WebGPU技术在Web浏览器运行模型,不需要网络和服务器端支持。

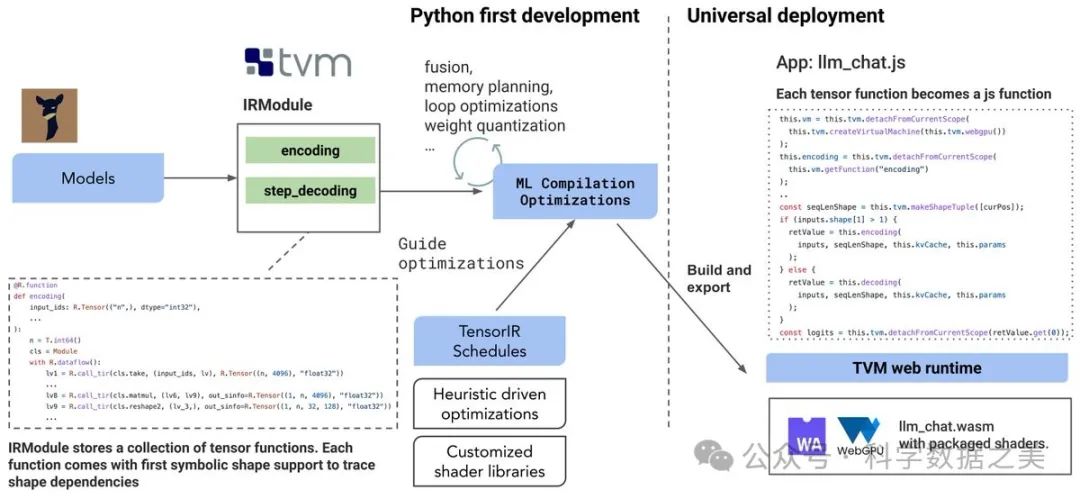

- WebLLM

这是一个使用WebGPU和WebAssembly等技术的项目,能够完全在浏览器中运行大语言模型和大语言模型应用程序。WebLLM 是一个模块化和可定制的 javascript 软件包,可直接将语言模型聊天直接带入Web浏览器,并进行硬件加速。一切都在浏览器内运行,无需服务器支持,并通过 WebGPU 加速。同时还支持在手机上运行模型。

Demo: https://mlc.ai/mlc-llm/

WebLLM技术架构

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/代码探险家/article/detail/768932

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。