- 1spring security token认证_SpringSecurity认证流程详解(附源码)

- 2推荐5款 深受欢迎 的AI开源项目_ai github 开源学习

- 3linux中ln -s 命令详解_linux ln -s

- 4红黑树的插入和遍历时间复杂度分析_红黑树遍历复杂度

- 5字节跳动三面拿offer:网络+IO+redis+JVM+GC+红黑树+数据结构

- 6Flutter从入门到实战(一)之环境搭建(Mac版)_flutter create project offline

- 7Floyd算法求最短路径_floyd最短路径算法

- 8Xcode14.3.1真机调试iOS17的方法_ios真机调试

- 9大数据--计算引擎分类_大数据计算引擎有哪些

- 10LangChain 30 ChatGPT LLM将字符串作为输入并返回字符串Chat Model将消息列表作为输入并返回消息_llm.invoke

ollama本地部署llama3(window系统)_ollama run llama3

赞

踩

首先介绍下ollama是什么?Ollama是一个开源的大型语言模型服务工具,旨在为用户提供本地化的运行环境,满足个性化的需求。具体来说,Ollama是一个功能强大的开源框架,可以简化在Docker容器中部署和管理大型语言模型(LLM)的过程,使得用户能够快速地在本地计算机上运行大型语言模型,如Llama 2等。此外,Ollama还提供了类似OpenAI的API接口和聊天界面,方便用户部署和使用。总的来说,Ollama可以帮助用户实现大型语言模型的本地化运行,从而满足用户对于语言处理任务的个性化需求。

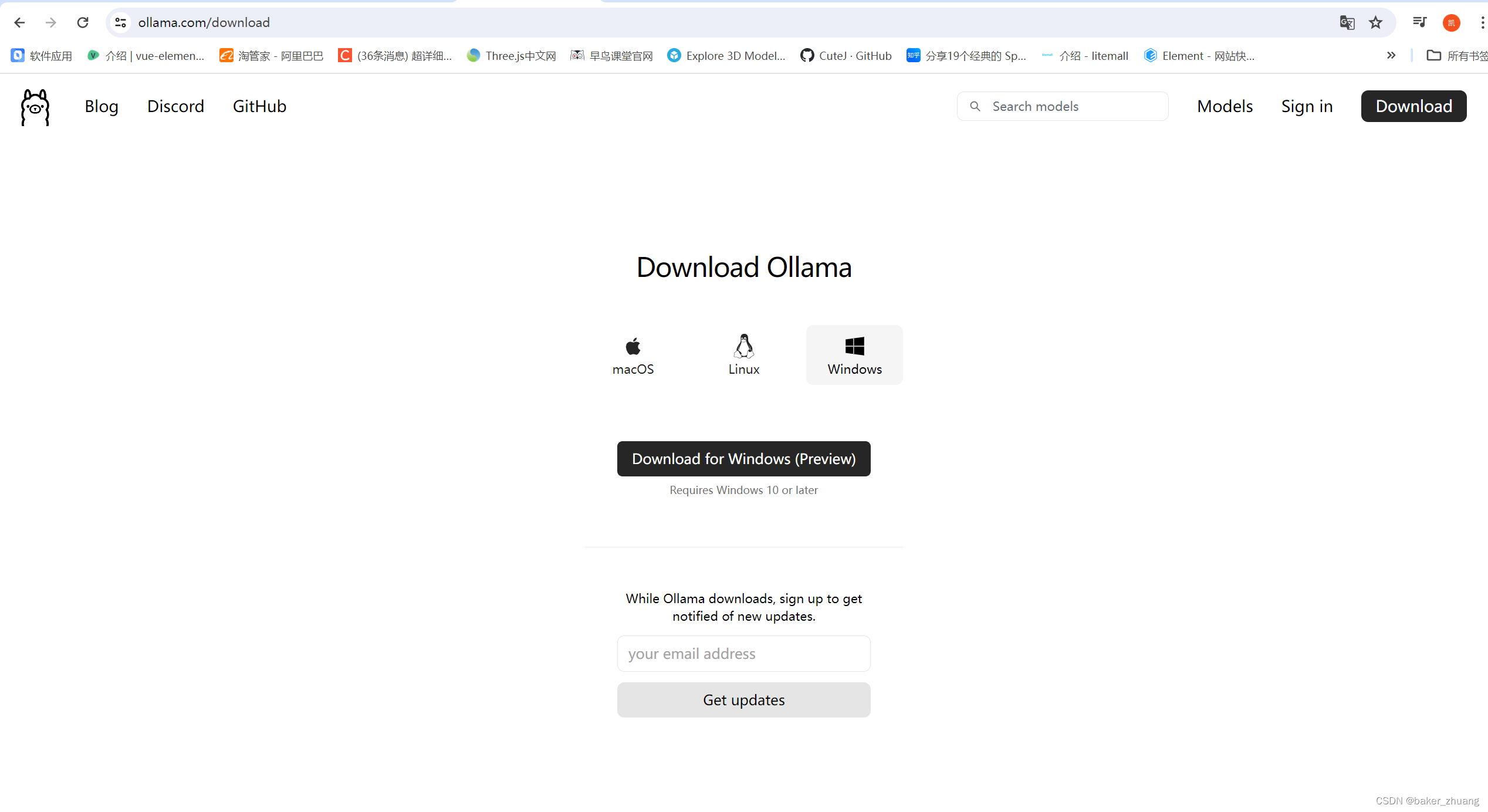

下面开始下载和安装,下载的话可以到ollama的官网去下载,有window,macOS,liunx三个版本,下载链接

点击下载后等待下载完成,然后会得到一个exe文件:

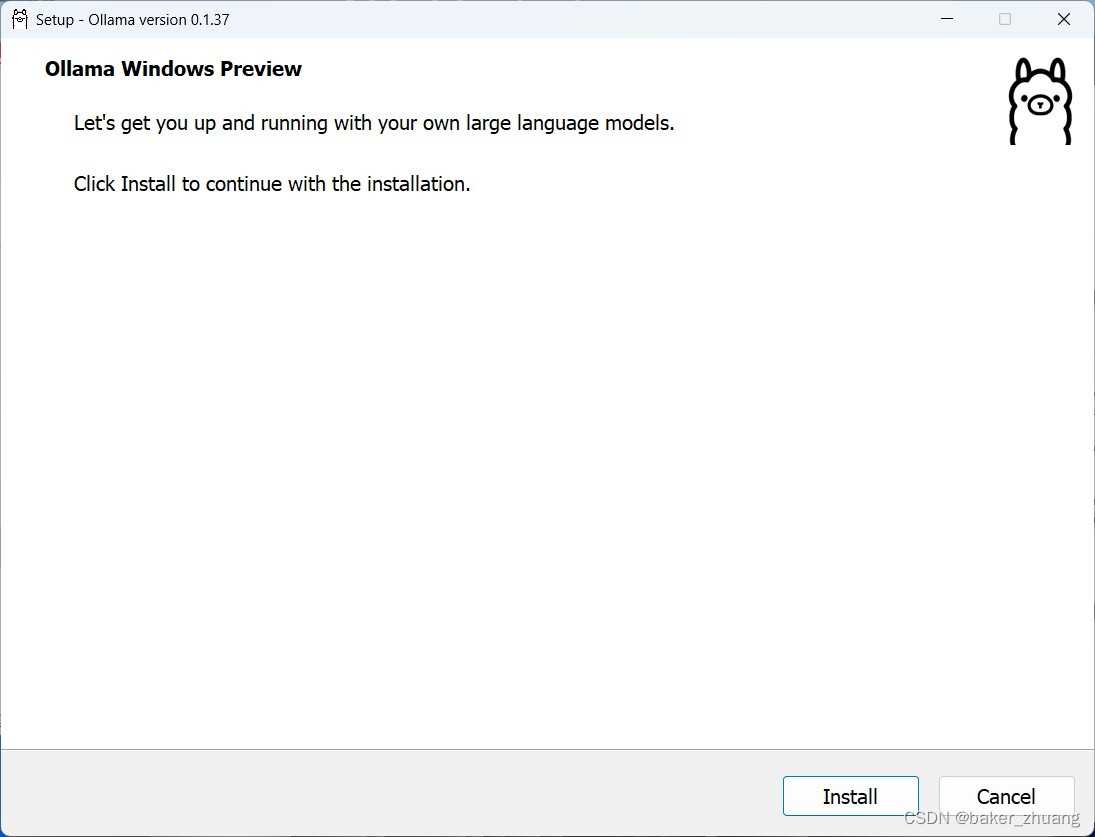

双击此exe,点击Install直接开始安装,

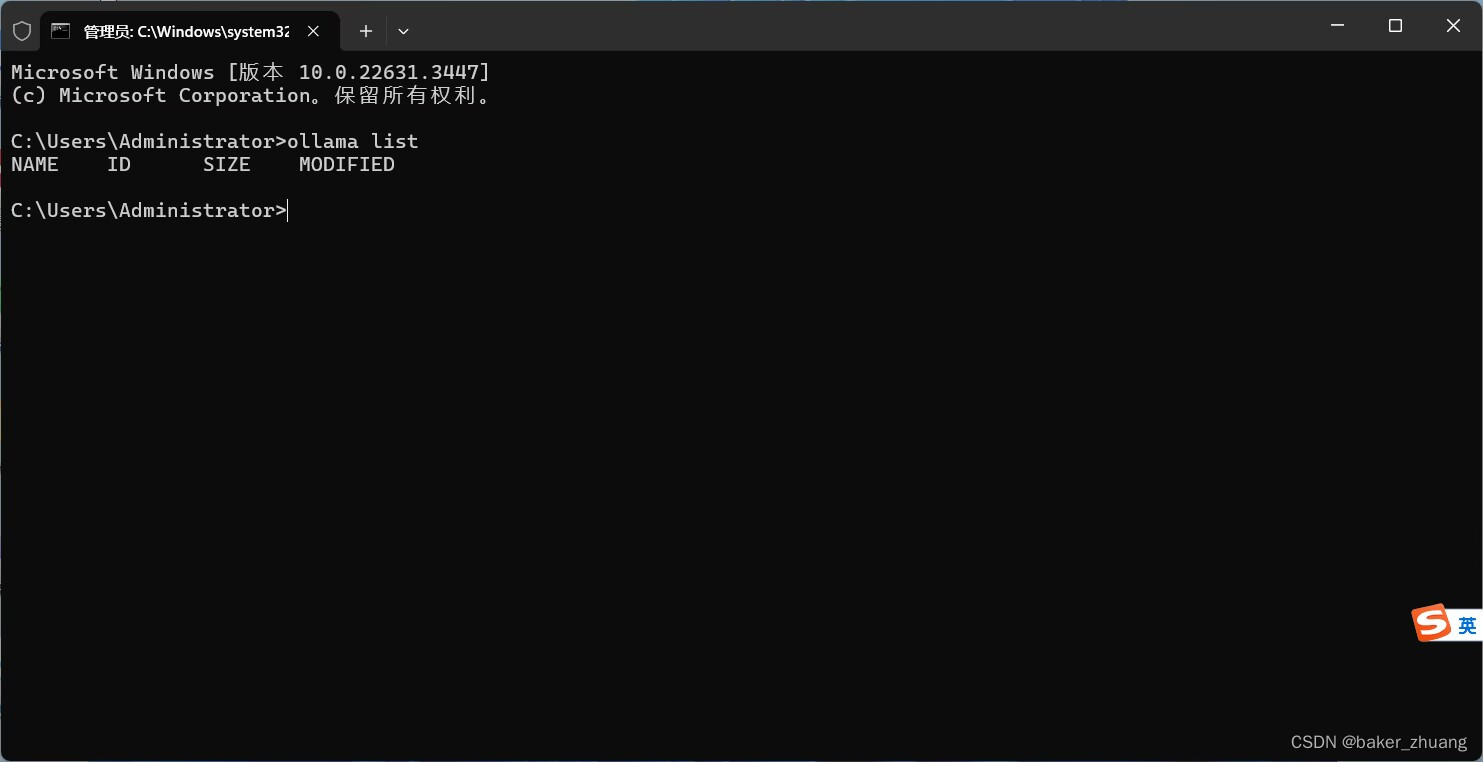

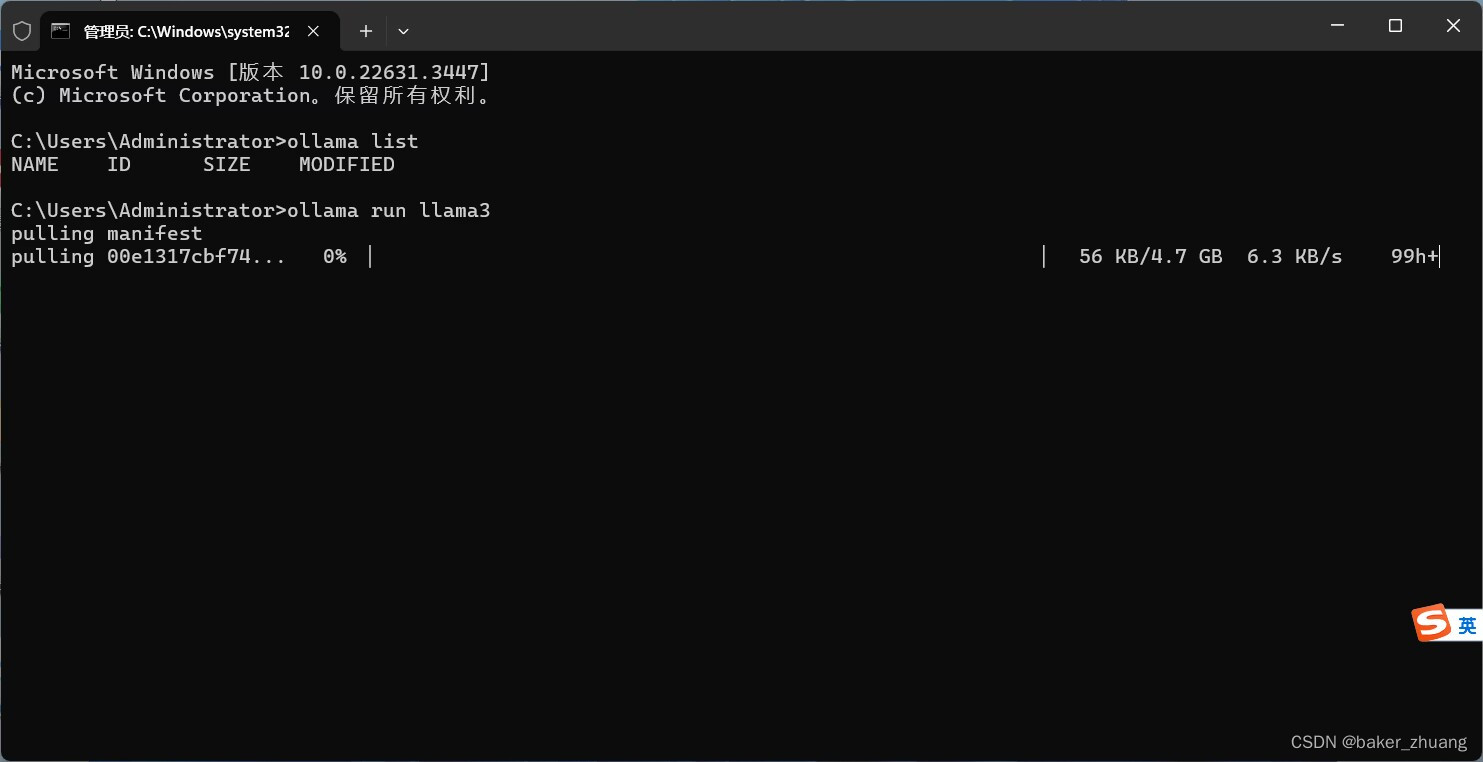

安装完毕后,点击window下面的状态栏会看到有ollama的标志,就是刚才exe一样的标识,此时ollama就在运行中了。也可以打开命令提示符窗口,输入ollama list,这个命令是查看已经下载的大模型,因为我这里是刚安装所以是空的:

ollama只是一个大模型的服务工具,并非大模型本体,所以只是安装ollama也并不能使用大模型,所以接下来要通过ollama下载大模型,需要注意的是,llama3分为多个版本,如果你的电脑性能一般还是安装llama3:8B的版本,除非是很好的电脑,内存64以上,GPU 3090的那种才考虑安装llama3:70B,下面是根据电脑配置推荐的安装版本

RAM:Llama 3 8B至少16GB,Llama 3 70B至少64GB或更多。

GPU:Llama 3 8B具有至少8GB VRAM的强大GPU,Llama 3 70B最好是支持CUDA的NVIDIA GPU。

磁盘空间:Llama 3 8B约为5GB,而Llama 3 70B超过20GB

这类以下载ollama3为例,在命令提示符窗口输入:

ollama run llama3

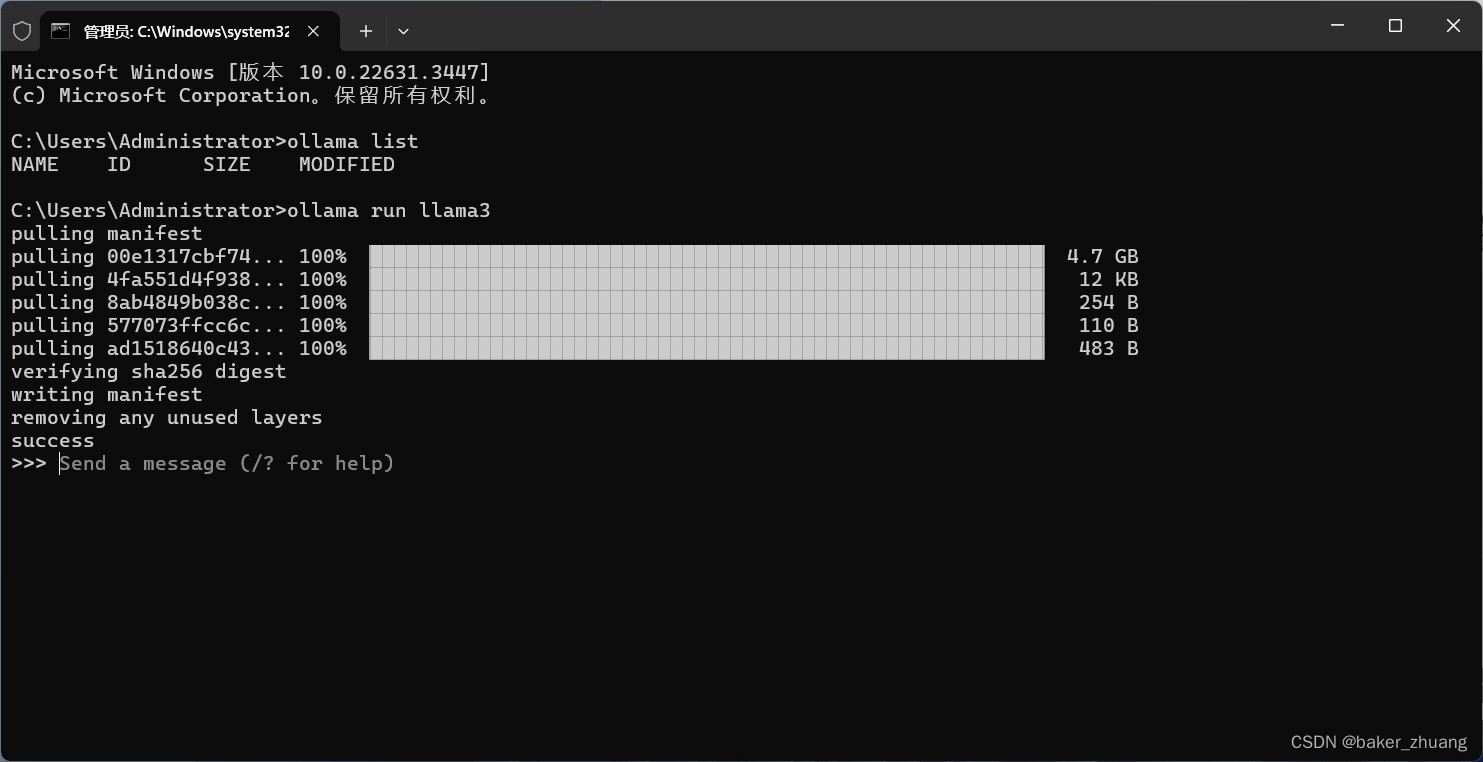

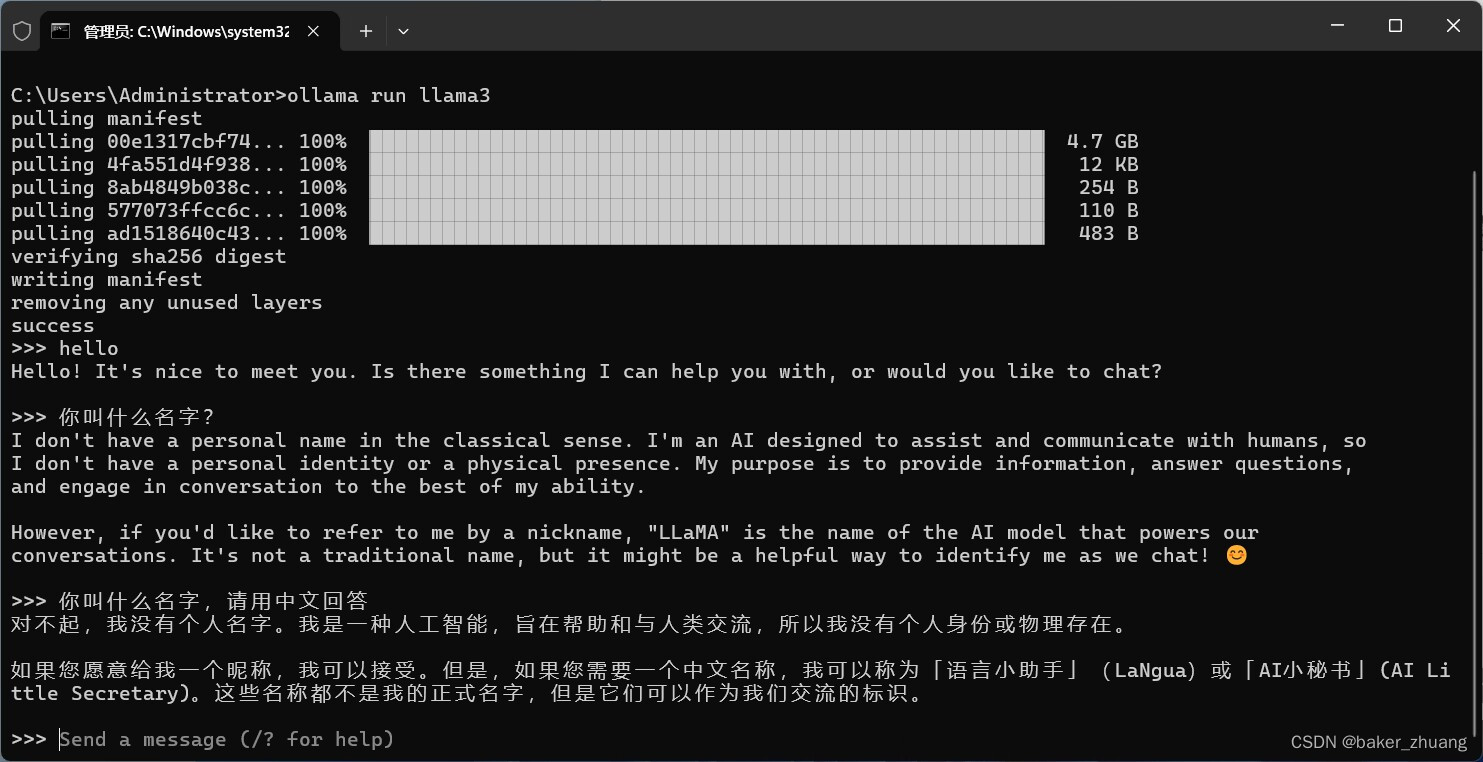

这里使用run命令就可以直接下载llama3了,然后等待下载完成。如下图就是下载完成,可以直接在这里提问了,

不过llama3对英文支持更好,可以用英文进行提问,英文不好的话也可以要求它用英文回答。

不过llama3对英文支持更好,可以用英文进行提问,英文不好的话也可以要求它用英文回答。

至此,用ollama部署一个可以离线使用的llama3大模型就好啦。