- 1Hadoop高可用集群出现两个standby,如何解决_启动hadoop出现两台备用

- 2【RabbitMQ】RabbitMQ 消息的堆积问题 —— 使用惰性队列解决消息的堆积问题_rabbitmq出现消息堆积_netcore6 怎么处理 rabbitmq消息堆积

- 3服务器GPU性能测试流程_gpu测试脚本

- 4Proteus8仿真:51单片机LCD1602显示_proteus8lcd1602

- 5大数据技术原理与应用笔记_大数据应用开发技术笔记

- 6别焦虑,这份初学者入门大语言模型(LLM)教程学习路线给你做好了_如何让大模型学会语法

- 7小白带你学习linux数据库—用户权限管理(二十九)_grant option权限

- 8Window10:不能建立到远程计算机的连接。你可能需要更改此连接的网络设置。_不能建立到远程计算机的连接你可能需要更改

- 9题解 | #24点运算#注意边界#题中规律&;数学规律两种解法_华创微系统面试

- 10python数据分析与可视化--体育收入排行榜

10分钟揭秘摘要抽取:探索信息提炼的奥秘_摘要提取算法

赞

踩

Introduction

本文分别介绍摘要数据集,摘要分类,摘要架构,相关baseline。并介绍若干篇EMNLP2023论文,介绍其最新工作。

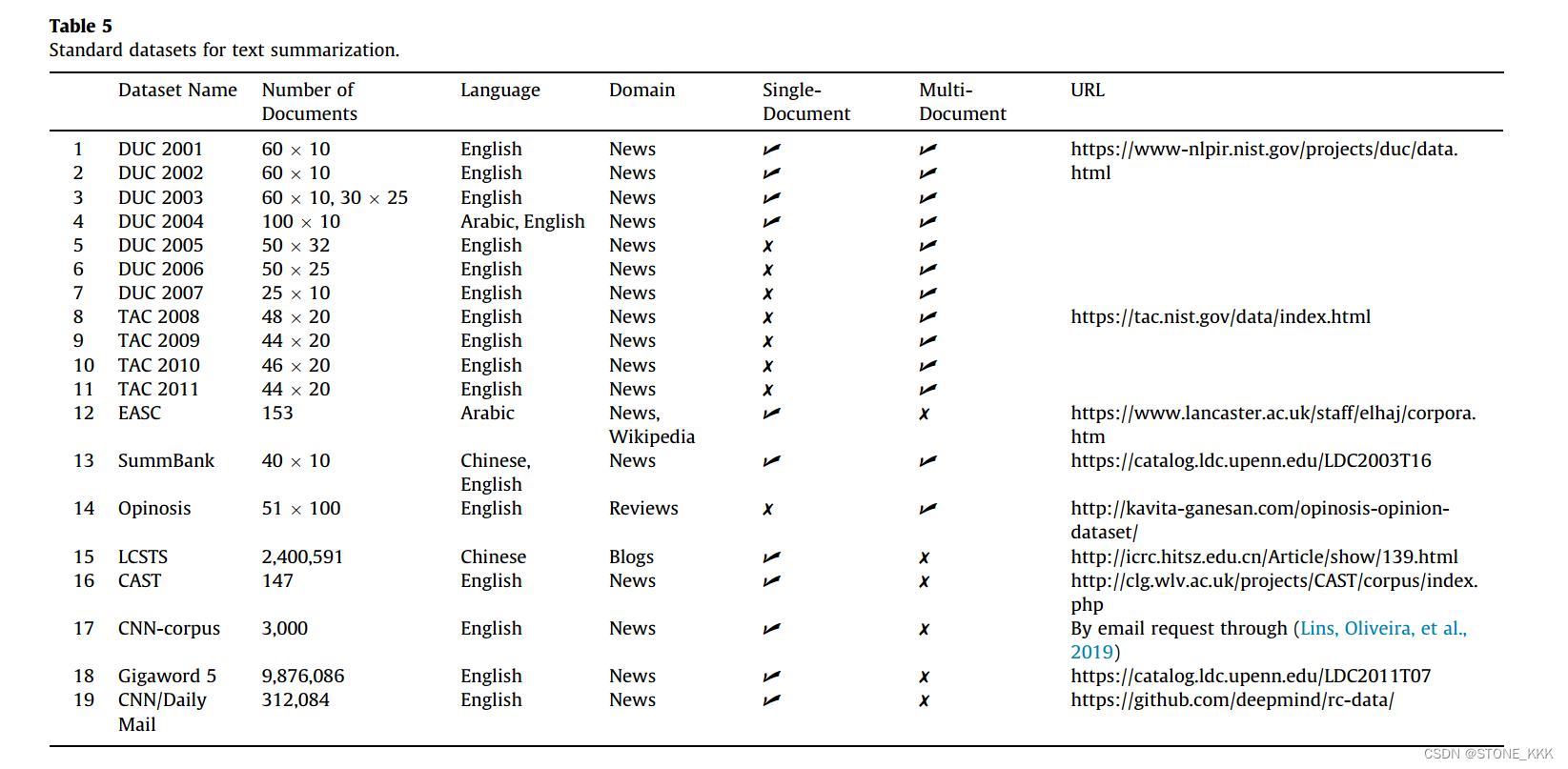

1.数据集

1.1 文本摘要

DUC/TAC 英文|数据集较小|适用于传统摘要方法的评估

Gigaword 英文|启发式规则构成|适用于深度神经网络方法

CNN/DailyMail 多句摘要数据|常用于生成式摘要方法

NYTAC 长度较短|可用于文本摘要、信息检索、信息抽取

ASNAPR 商品评论数据|可用于评论和情感的摘要

LCSTS 中文|新浪微博数据|短文本|深度网络摘要方法 --哈工大

NLPCC 中文,文本摘要、情感分类、自动问答等任务 --字节跳动

NLPCC分版本

2017,2020,2021

- 1

- 2

1.2 对话摘要

两个或两个以上的对话参与者

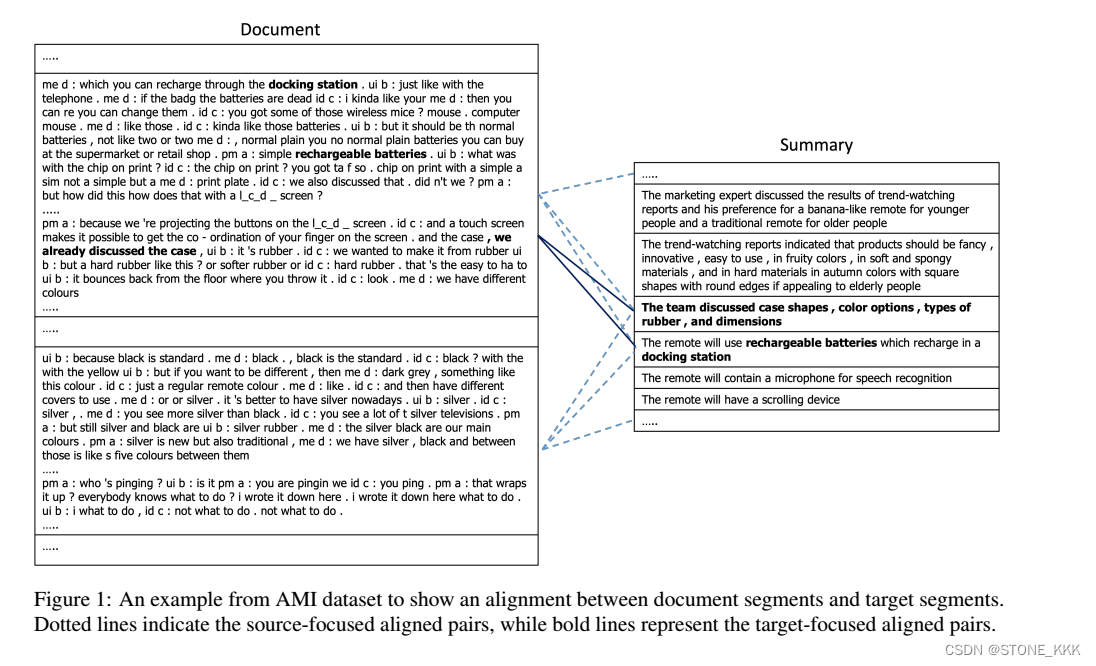

AMI 英|规模小|会议多模态数据|可用于抽取式与生成式摘要

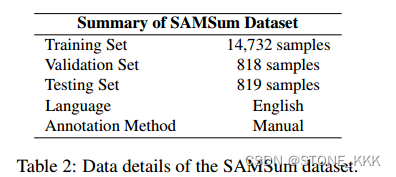

SAMSum英|规模大|闲聊数据|人工标注|适用于生成式摘要

ICSI 英|规模较小|会议语料库

1.3 From ATS Survey

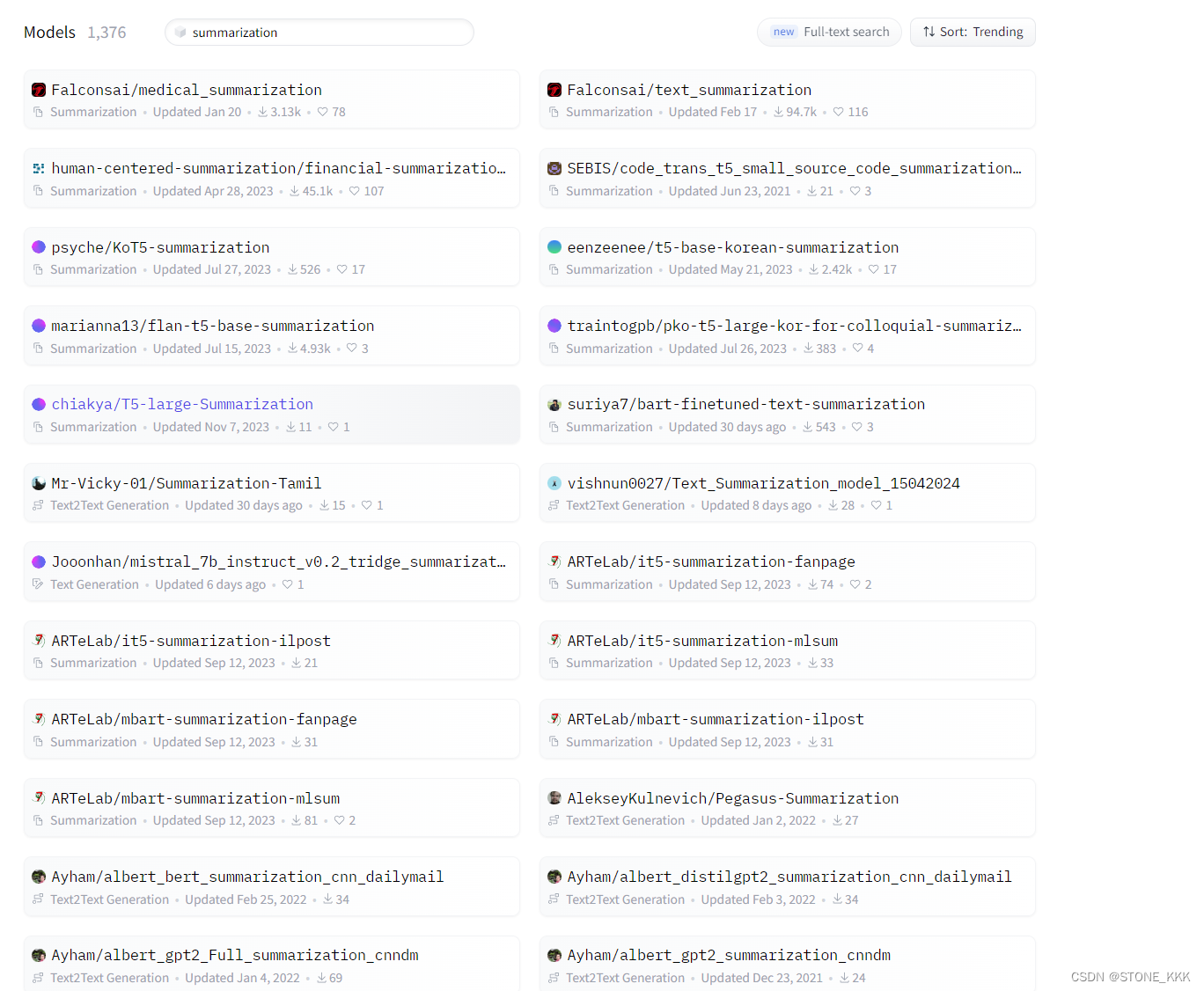

1.4 From Hugging Face

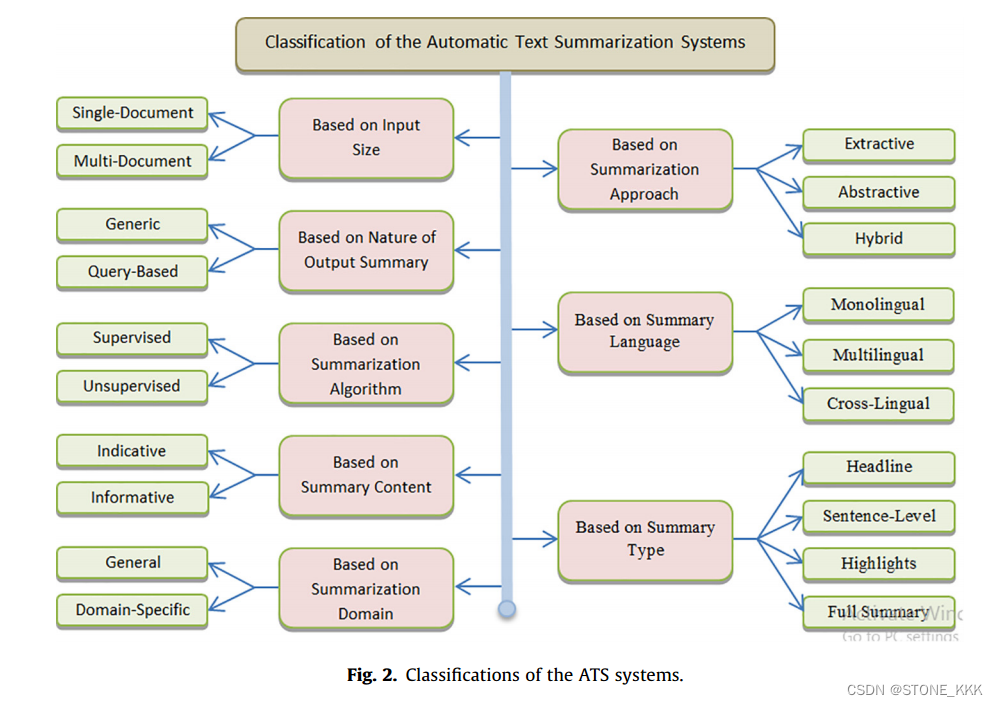

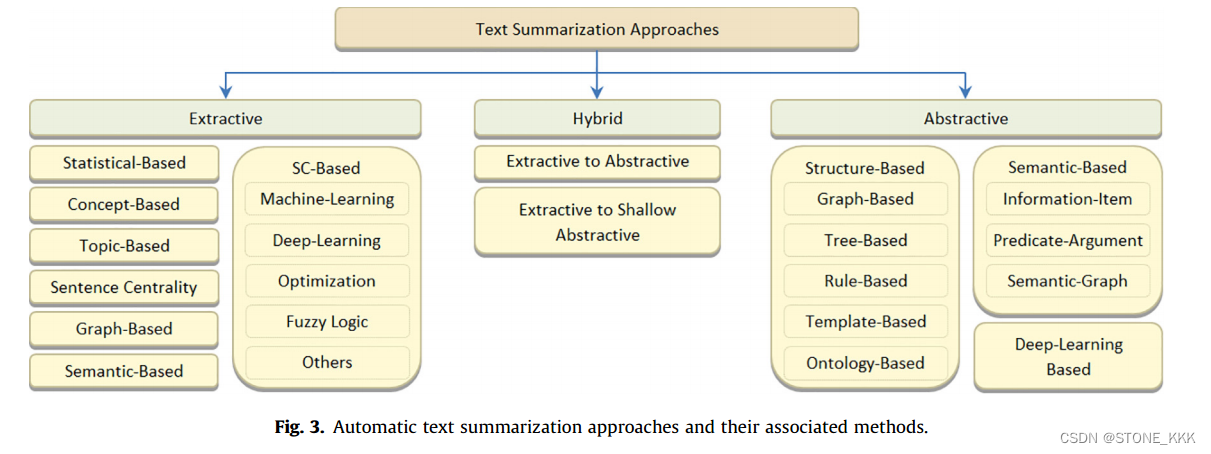

2.摘要分类

3.模型架构

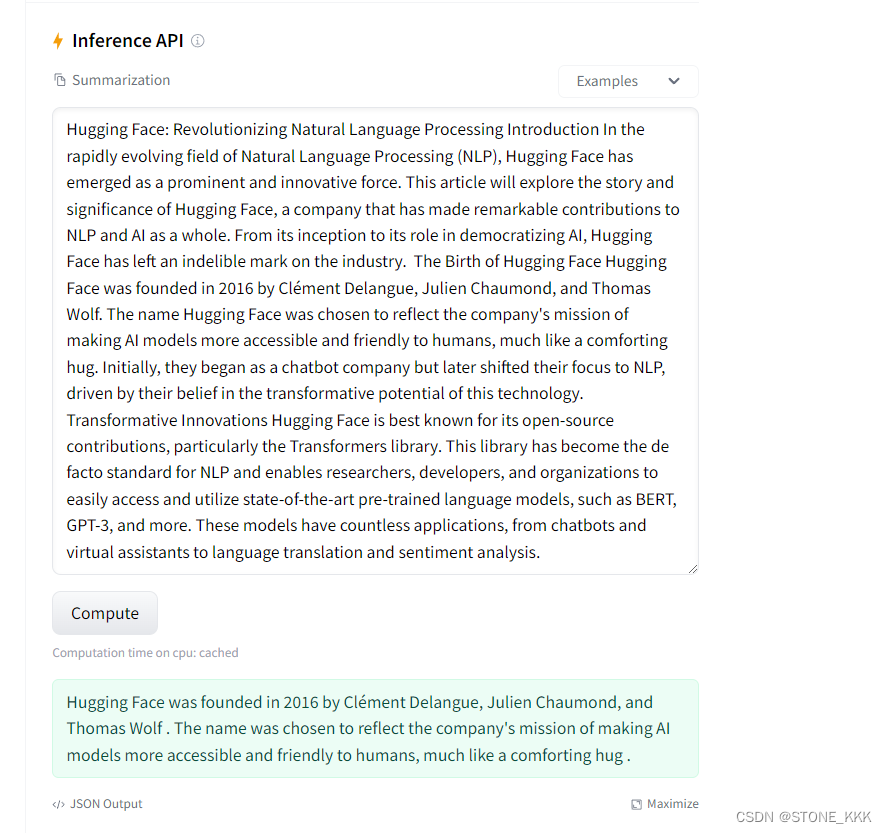

hugging face

微调T5 Small 做文本摘要

url:https://huggingface.co/Falconsai/text_summarization

4.baseline

评估指标 - Rouge

5.Recently Work From EMNLP

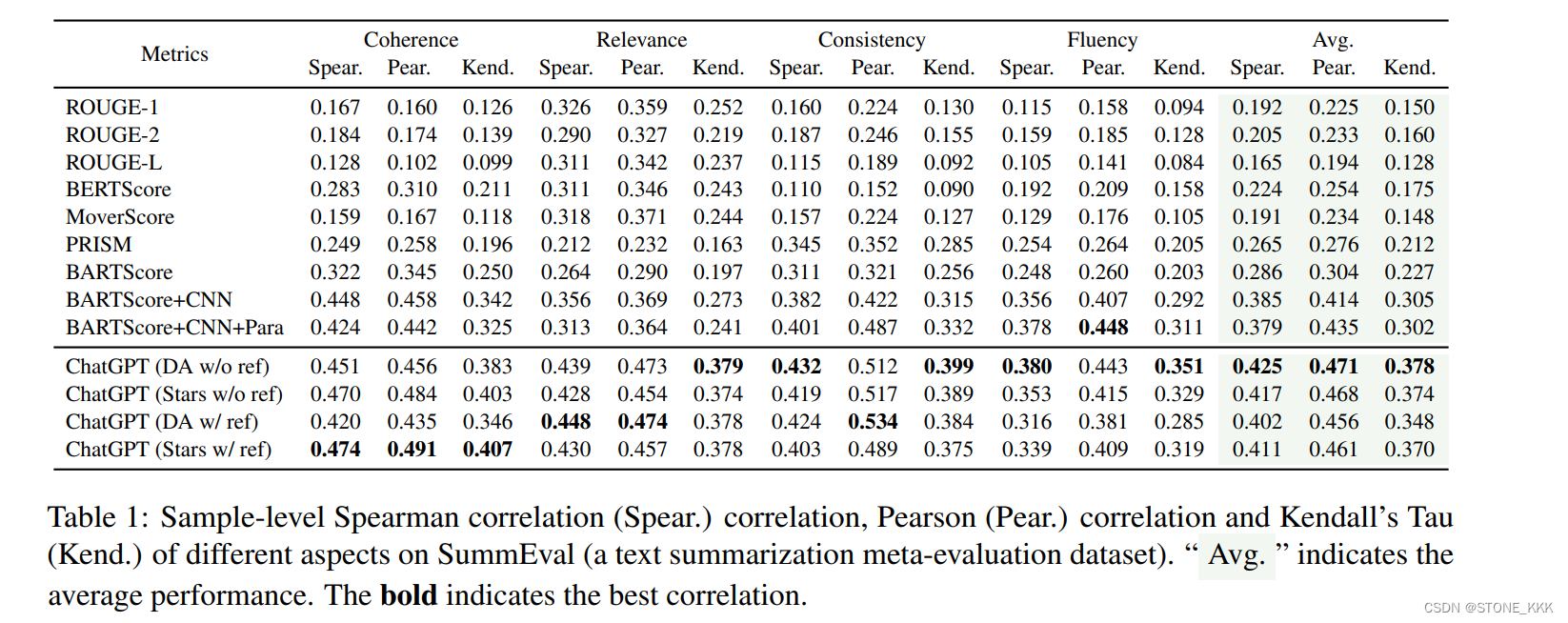

1.Is ChatGPT a Good NLG Evaluator? A Preliminary Study

自然语言生成(NLG)评估指标与人类判断的相关性很差,作者探索ChatGPT是否是一个很好的NLG评估指标。

结论:实验结果表明,与以前的自动度量相比,ChatGPT在大多数情况下与人类判断达到了最先进或竞争的相关性。此外,我们发现ChatGPT评估器的有效性可能会受到元评估数据集创建方法的影响。对于很大程度上依赖于参考而产生的元评估数据集,ChatGPT评估器可能会失去其有效性。

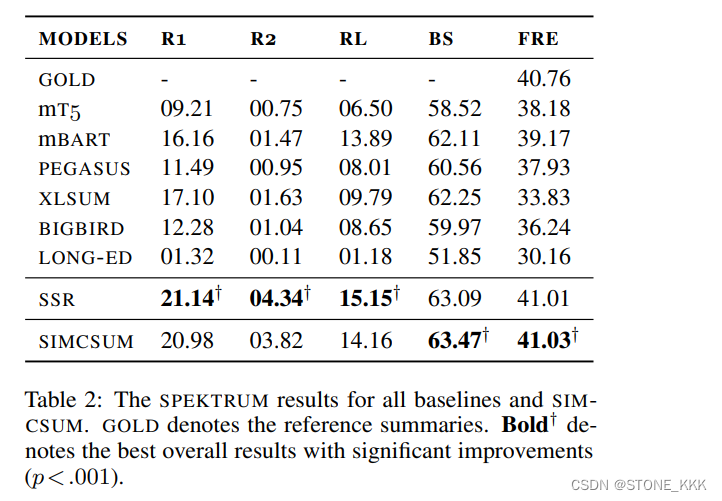

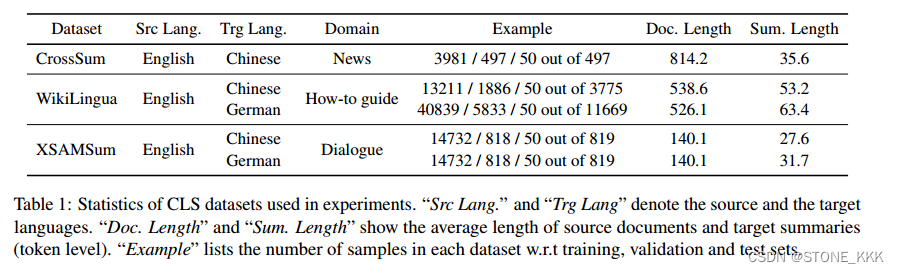

2. Zero-Shot Cross-Lingual Summarization via Large Language Models

评估大模型跨语言摘要(CLS)的 zero-shot 能力

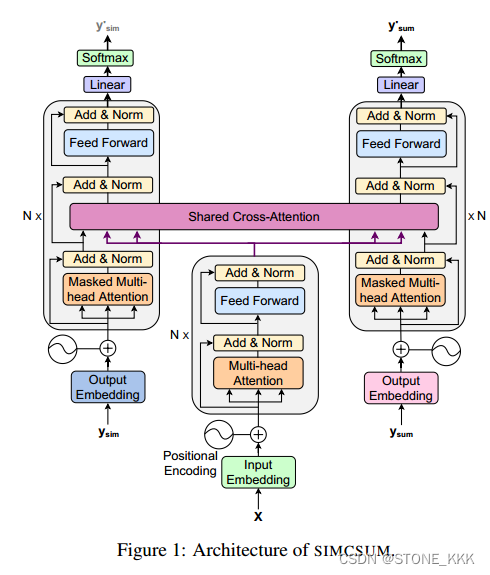

3.SimCSum: Joint Learning of Simplification and Cross-lingual Summarization for Cross-lingual Science Journalism

作者通过引入一种结合NLP任务的新颖的多任务学习架构,扩展了跨语言科学新闻的研究。作者的方法是联合训练SIMCSUM中的两个高级NLP任务来生成跨语言科普摘要。

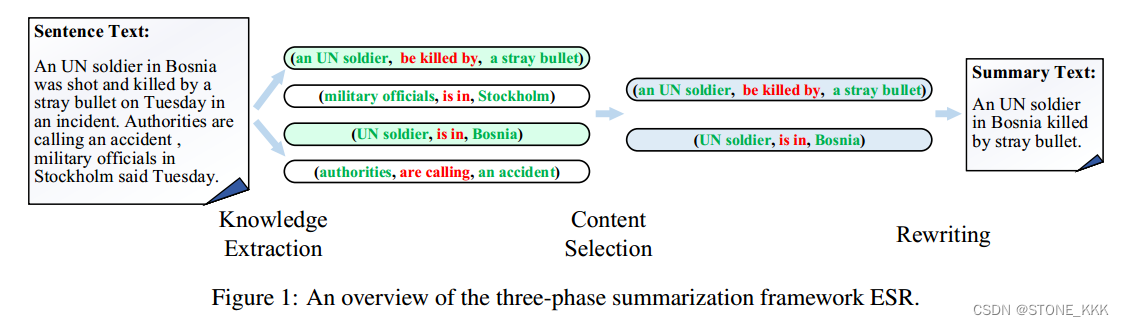

4. Extract, Select and Rewrite: A Modular Sentence Summarization Method

作者提出一种三阶段abstractive 句子方法 - Extract-Select-Rewrite (ESR),

作者将摘要分解为三个阶段:

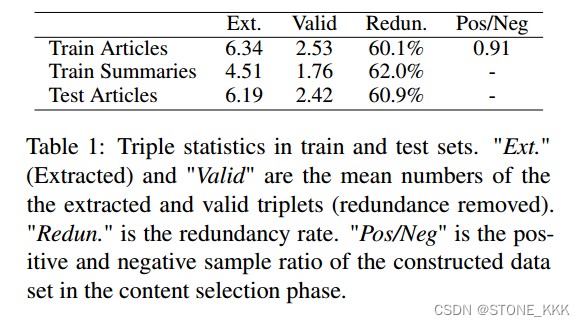

(i)知识提取,我们使用现成的工具从文本中提取关系三元组;

(ii)内容选择,其中选择三元组的子集;

(iii)重写

4.1ESR步骤

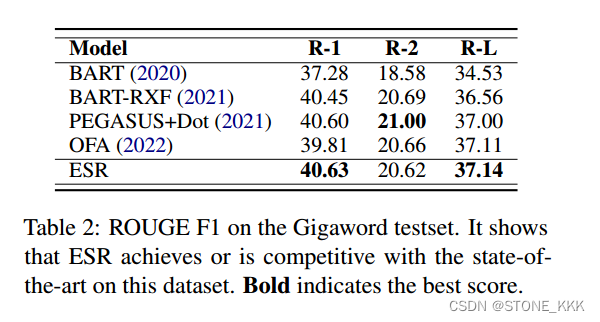

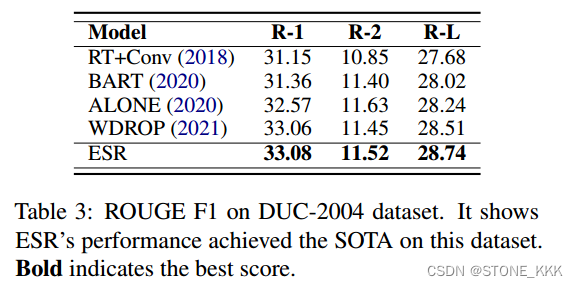

4.2 实验结果

4.3 1The codes are available on https://github.com/SeanG-325/ESR.

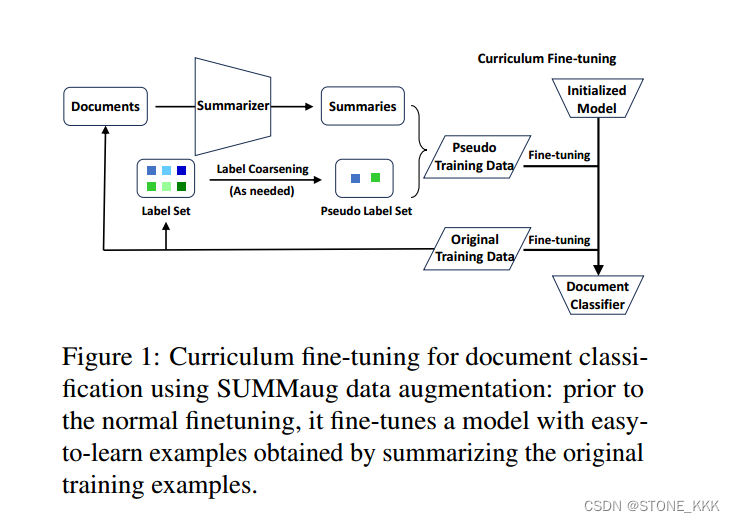

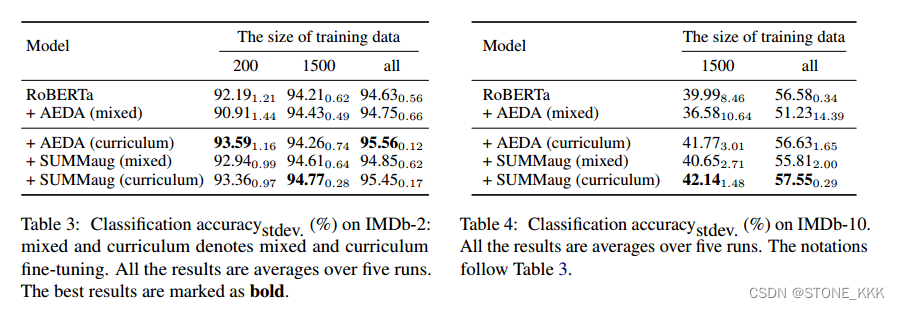

5. Summarization-based Data Augmentation for Document Classification

尽管预训练语言模型在自然语言理解任务中很流行,d但由于数据稀疏性问题,理解冗长的文本(如文档)仍然具有挑战性。

受人类通过阅读较短的文本来发展理解冗长文本的能力的启发,作者提出了一种简单而有效的基于摘要的数据增强方法summag,用于文档分类。

首先通过汇总原始训练样例的输入来获得目标文档分类任务的易于学习的样例,同时有选择地合并原始标签以符合汇总的输入。

然后,我们使用生成的伪示例来执行课程学习。

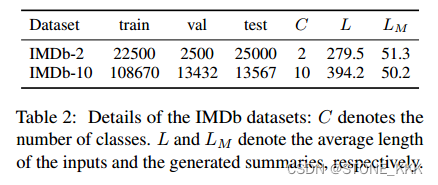

提供IMD数据集

5.1We release our code and data at https://github.com/etsurin/summaug

5.2 实验结果

作者针对

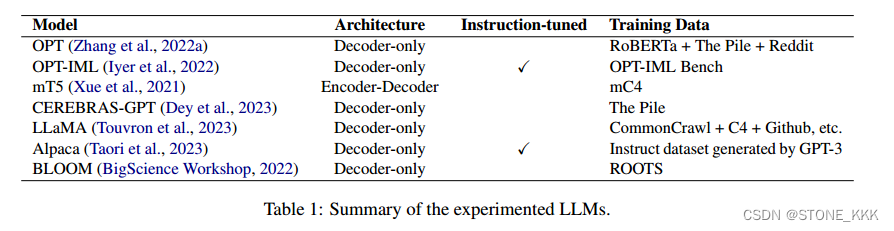

6.In-context Learning of Large Language Models for Controlled Dialogue Summarization: A Holistic Benchmark and Empirical Analysis

控制对话摘要大语言模型的语境学习:整体基准与实证分析

- 1

作者提出目前若干问题:

LLM在少数镜头Abstractive对话摘要背景下的表现仍未得到充分探索。本研究在几个镜头框架内评估了SAMSum数据集上的各种最先进的LLM。我们在受控环境(实体控制、长度控制和以人为中心的规划)和非受控环境中评估这些模型,并在少数镜头对话总结中建立一个全面的基准。我们的研究结果为对话摘要的质量和模型可控性提供了新的见解,为今后的对话摘要研究提供了重要的参考。

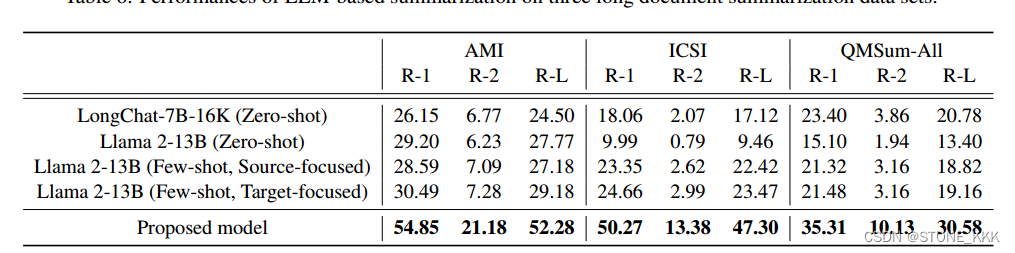

6.1 实验结果

表1 为实验模型

表2 为实验数据集

表4 - 7 表示不同对比实验

6.3 结论

本研究的一个局限性是,由于硬件的限制,只有小于10B个参数的llm被实验。针对这一问题,我们发布了评价代码,以便于后续的研究。

同时,本工作中的控制信号为oracle,这意味着我们假设用户提供了指示性关键字以包含在摘要中。

有从对话中提取关键字的自动方法(He et al, 2022),但这不是重点,因此不在本研究中讨论。

由于时间限制,我们采用GPT-3进行自动定性评价。虽然基于gpt的评估已被证明在某些评估任务中具有竞争力,但人工评估的必要性仍然存在。

7. From Sparse to Dense: GPT-4 Summarization with Chain of Density Prompting

对GPT-4摘要做出总结

8.Generating Extractive and Abstractive Summaries in Parallel from Scientific Articles Incorporating Citing Statements

作者开发了一个模型,利用源文献和引用文献中的信息来总结科学文献。

模型如下,未开源代码

9.Supervising the Centroid Baseline for Extractive Multi-Document Summarization

https://github.com/Priberam/cera-summ

作者通过在句子选择中添加一个束搜索过程和一个质心估计注意力模型来进一步改进它,提升性能。作者在几个多文档摘要数据集(包括多语言场景)进行验证。

实验结果如下

10. DebateKG – Automatic Policy Debate Case Creation with Semantic Knowledge Graphs

https://huggingface.co/spaces/Hellisotherpeople/DebateKG

自然语言处理系统在解决竞争性辩论中发现的问题方面具有适用性。在竞争性辩论中,最重要的任务之一是辩手创造高质量的辩论案例。

作者证明了有效的辩论案例可以在论证语义知识图上使用约束最短路径遍历来构建。我们在一种名为“政策辩论”的美国竞争性辩论的背景下研究这种潜力,这种辩论已经有了一个名为“DebateSum”的大规模数据集。

11.Improving Multi-Stage Long Document Summarization with Enhanced Coarse Summarizer

多阶段长文档摘要是一种从长文档中捕获重要信息的灵活方法,它将长文档分成多个部分,每个部分用于在多个阶段生成粗摘要,然后使用最后一个粗摘要生成最终摘要。然而,即使粗汇总影响最终汇总,现有多阶段汇总中的粗汇总器也是使用对生成最终汇总无用的数据段进行粗训练的。

本文提出了一种多阶段长文档摘要的新方法。该方法首先生成新的片段对,确保它们都与生成最终的摘要相关。然后,我们将对比学习结合到粗摘要器的训练中,它试图在训练过程中最大化源片段和目标摘要之间的相似性。通过在六个长文档摘要数据集上的大量实验,我们证明了我们提出的方法不仅增强了现有的多阶段长文档摘要方法,而且达到了与最先进的方法相当的性能,包括使用大型语言模型进行长文档摘要的方法。

The proposed method is publicly available at https://github.com/Jinhyeong-Lim/Summ-N-ECS