热门标签

热门文章

- 1测试开发 | 词嵌入(Word Embeddings):赋予语言以向量的魔力_词嵌入是将词汇表中的每个词映射到

- 2OpenMV:21控制多个舵机(需要模块PCA9685)_openmv控制双舵机

- 3AIGC内容分享(五十五):AIGC周刊

- 4在NVIDIA Orin中编译Apollo 9_apollo 9.0 orin

- 5大数据项目在线实习_数据测试员实习项目

- 6Elasticsearch 未授权访问_elasticsearch未授权访问

- 7【推荐系统】DeepFM模型分析

- 8跟着我,在PS里成功装上SD插件(终极教程!附基本操作步骤)_ps sd插件

- 9stm32+cubemx+淘晶驰串口屏+收发通信并应用_stm32驱动陶晶驰x系列串口屏

- 10原生php开发学生信息管理系统源码_php学生信息管理系统源代码

当前位置: article > 正文

K8S 集群节点缩容

作者:代码探险家 | 2024-07-09 17:06:45

赞

踩

K8S 集群节点缩容

环境说明:

| 主机名 | IP地址 | CPU/内存 | 角色 | K8S版本 | Docker版本 |

| k8s231 | 192.168.99.231 | 2C4G | master | 1.23.17 | 20.10.24 |

| k8s232 | 192.168.99.232 | 2C4G | woker | 1.23.17 | 20.10.24 |

| k8s233(需下线) | 192.168.99.233 | 2C4G | woker | 1.23.17 | 20.10.24 |

1. K8S 集群节点缩容

当集群中有闲置或者node因为硬件故障机其他原因需要下线时就需要对集群进行缩容

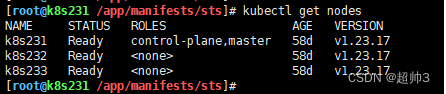

1.1 查看现有节点信息

kubectl get nodes

如图:

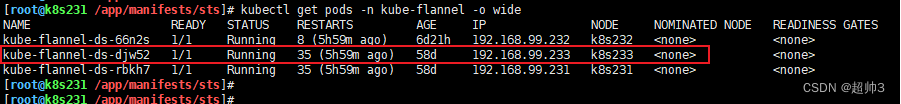

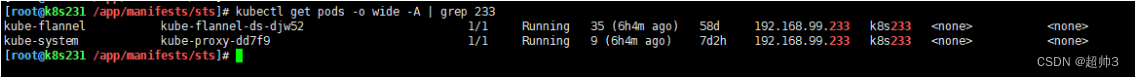

可以看到当前所有部署在k8s233节点上面的Pod

1.2 驱逐 Pod 并打 SchedulingDisable 标签,但 ds 资源创建的Pod不会驱逐

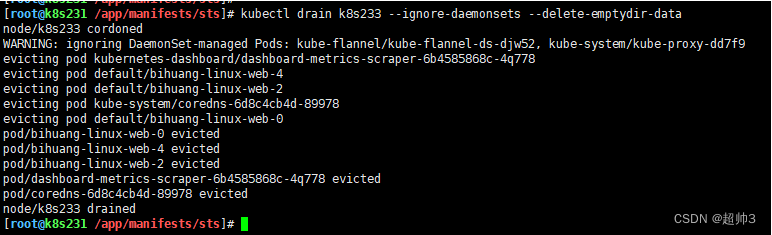

kubectl drain k8s233 --ignore-daemonsets --delete-emptydir-data

如图:

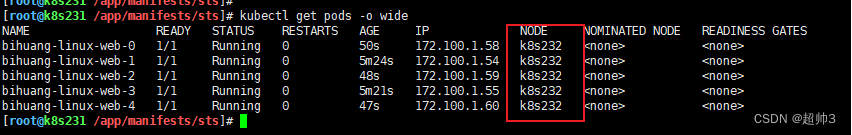

之前k8s233节点上的资源被驱逐到其他节点上了

如图:

ds资源并没有被驱逐

1.3 查看节点被标记为禁用调度状态

- #标记当前节点不可调度Pod,那么master组件的scheduler 就不会调度到Pod当前节点

- [root@k8s231 /app/manifests/sts]# kubectl get nodes

1.4给需要下线的节点打污点,驱逐已经调度到该节点的所有Pod

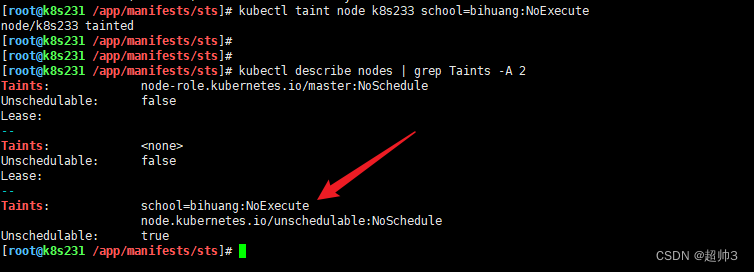

- 1.#打污点,不可调度且驱逐

- kubectl taint node k8s233 school=bihuang:NoExecute

-

-

- 2.#查看节点污点

- kubectl describe nodes | grep Taints -A 2

注意:

kube-proxy组件貌似无法被驱逐,因为配置无视污点的属性,所以打任何污点都无效!

1.5 下线节点重置

-

- [root@k8s233 ~]# kubeadm reset –f

-

- [root@k8s233 ~]# rm -rf /etc/cni/net.d && iptables -F && iptables-save

-

- [root@k8s233 ~]# systemctl disable --now kubelet

1.6 删除节点

[root@k8s231 /app/manifests/sts]# kubectl delete nodes k8s233

1.7 下线节点

节点关机

断电

修机器

随便操作即可

推荐阅读

相关标签