- 1Day04|逻辑运算符、位运算符及三元运算符_有一个假就都假

- 2python 决策树分类 泰坦尼克生存预测_泰坦尼克号生存预测python

- 3基于Python的天气数据可视化分析系统_气象数据可视化背景

- 4史上最全499道Java面试题:JVM+分布式+算法+锁+MQ+微服务+数据库_java分布式缓存面试题

- 5CentOS7 开放端口操作_centos7开放22端口指令

- 6【Web后端】输入localhost跳转IIS Windows Server的解决方法_使用nginx之后localhost仍然显示iis

- 7备忘:pyecharts 词云图网页出空图的解决办法_pyecharts词云图执行后空白

- 8ffmpeg实例,视频的翻转vflip、hflip,旋转rotate、转置transpose

- 9基于python+vue+elementUI+django平南盛世名城小区疫情防控系统(前后端分离)#毕业设计_基于python+vue+elementui+django疫情数据可视化分析系统(前后端分离)#毕业

- 10APT攻击原理和防范_防apt攻击工作原理

Python 并发简介(多线程、多进程)_python多线程并发

赞

踩

Python 并发简介

-

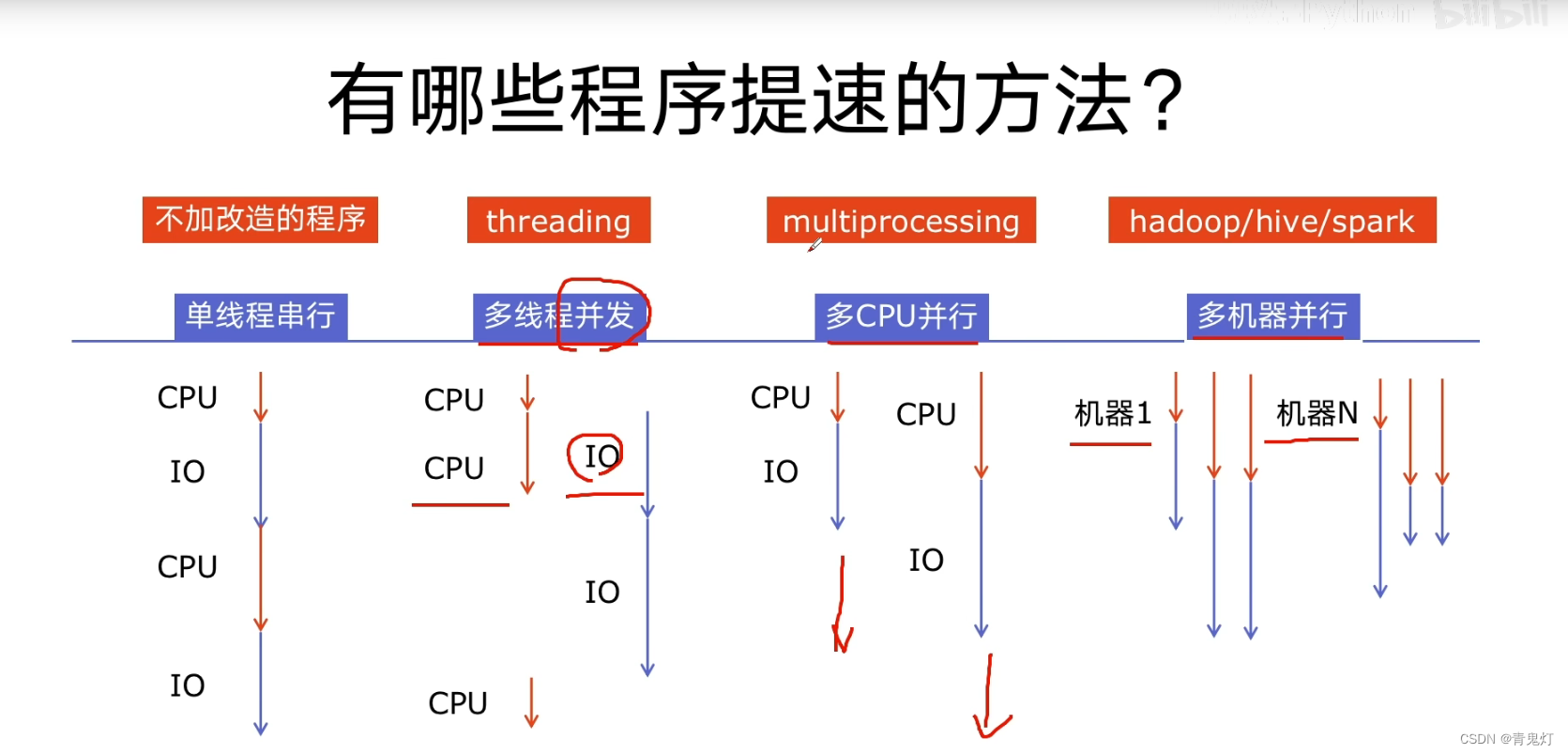

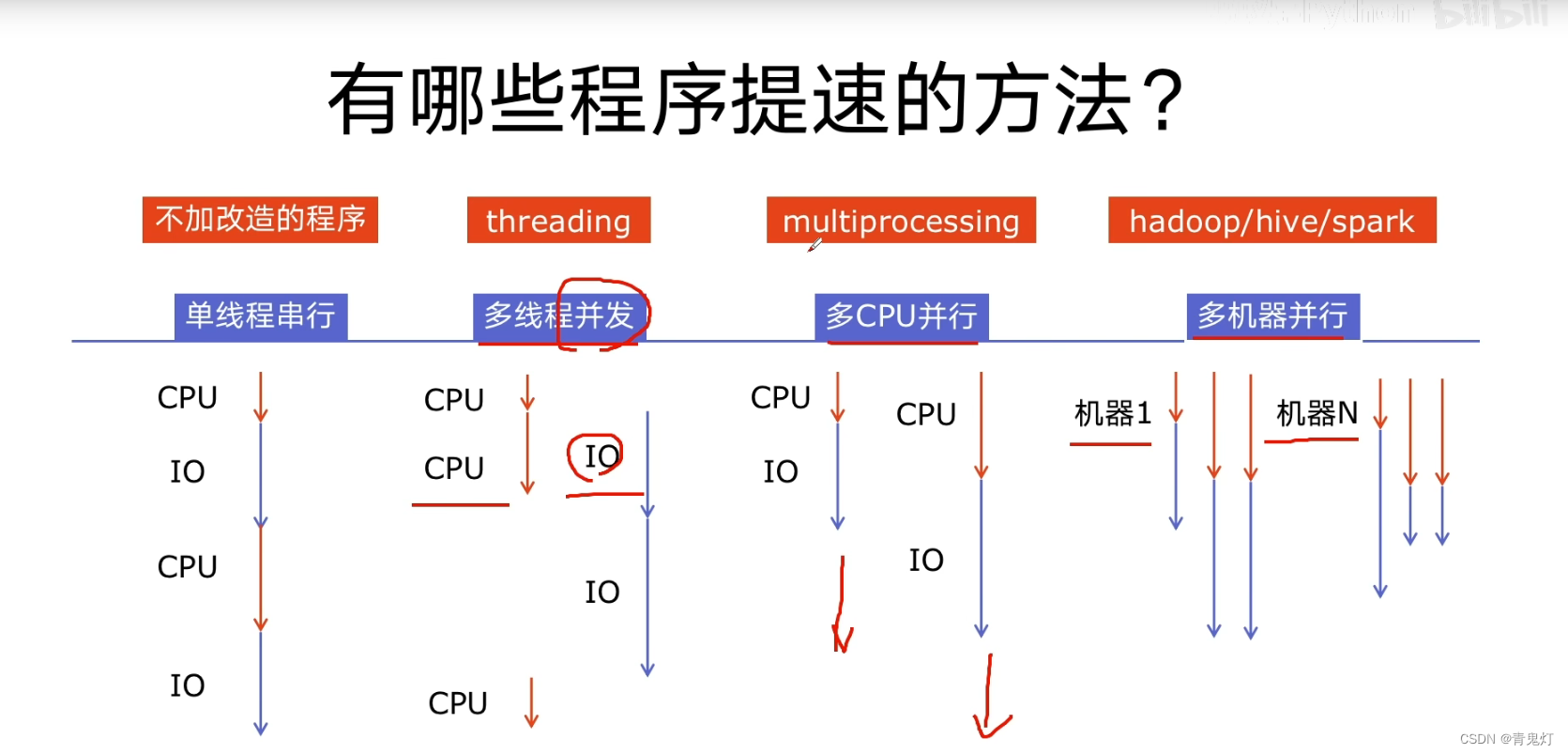

多线程:threading,利用CPU和IO可以同时执行的原理,让CPU不会干巴巴的等待IO完成。

-

多进程:multiprocessing,利用多核CPU的能力,真正并行执行任务。

-

异步IO:asyncio,在单线程利用CPU和IO同时执行的原理,实现函数异步执行。

-

使用 Lock对资源加锁,防止冲突访问

-

使用Queue实现不同线程、进程之间的数据通信,实现生产者-消费者模式

-

使用线程池Pool、进程池Pool,简化线程、进程的任务提交、等待结束、获取结果

多线程、多进程、多协程对比

-

多进程Process(multiprocessing):

优点:可以利用多核CPU并行计算

缺点:占用资源最多、可启动数目比线程少

适用于:CPU密集型计算

-

多线程Thread(threading):

优点:相比进程,更轻量级、占用资源少

缺点: 1. 相比进程:多线程只能并发执行,不能利用多CPU(GIL)(python多线程中只能使用单CPU)2. 相比协程:启动数目有限制,占用内存资源,有线程切换开销- 1

适用于:IO密集型计算、同时运行的任务数目要求不多

-

多协程Corotine(asyncio):

优点:内存开销最少、启动协程数量最多

缺点:支持的库有限制、代码实现复杂

适用于:IO密集型计算、需要超多任务运行、但有现成的库支持的场景

IO(读写内存、发送、网络等)

关系:进程 > 线程 > 协程,一个进程中可以启动多个线程,一个线程中可以启动多个协程。

GIL

python速度慢的原因

- 动态类型语言,边解释边执行

- GIL,无法利用多核CPU并发执行

GIL

同步线程的一种机制,使得任何时刻仅有一个线程在执行。在多核心处理器上,使用 GIL 的解释器也只允许同一时间执行一个线程

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jTXRZMgJ-1655734406988)(file:///D:\app\QQ\My_FILE\676221979\Image\Group2\N([J\N([JRTM]T]3G8P}_B5`S[18.png)]![img]

为什么有GIL这个东西?

简而言之:python设计初期,为了规避并发问题引入了GIL,现在想去除却去不掉

怎么规避GIL带来的限制?

-

多线程threading机制依然是有用的,用于IO密集型计算

因为在IO期间,线程会释放GIL,实现CPU和IO并行,因此多线程用于IO密集型计算依然可以大幅提升速度,

但是多线程用于CPU密集型计算时,只会更加拖慢速度。

-

使用multiprocessing的多进程机制实现并行计算、利用多核CPU优势

为了应对GIL的问题,python提供了multiprocessing

多线程编程

应用于IO密集型计算,比如几乎所有的网络后台服务、网络爬虫

引入模块

-

from threading import Thread- 1

新建、启动、等待结束

-

t=Thread(target=func, args=(100, )) t.start() t.join()- 1

- 2

- 3

数据通信

-

import queue q = queue.Queue() q.put(item) item = q.get()- 1

- 2

- 3

- 4

线程安全加锁

-

from threading import Lock lock = Lock() with lock:- 1

- 2

- 3

RLock和Lock的区别:

RLock支持嵌套锁,Lock只支持锁一次解一次,不支持嵌套锁。RLock又叫递归锁,Lock又叫互斥锁。如果Lock锁上没有解锁,再锁上一次,会造成死锁。死锁另外一种情况是由于竞争资源或由于彼此通信而造成阻塞的现象。

eg:两个线程函数func1和func2,分别被lock1和lock2锁上,在func1里(lock1未解锁)再用lock2上锁,在func2里在用lock1上锁.

信号量限制并发

-

from threading import Semaphore semaphre = Semaphore(10) with semaphre:- 1

- 2

- 3

线程池

-

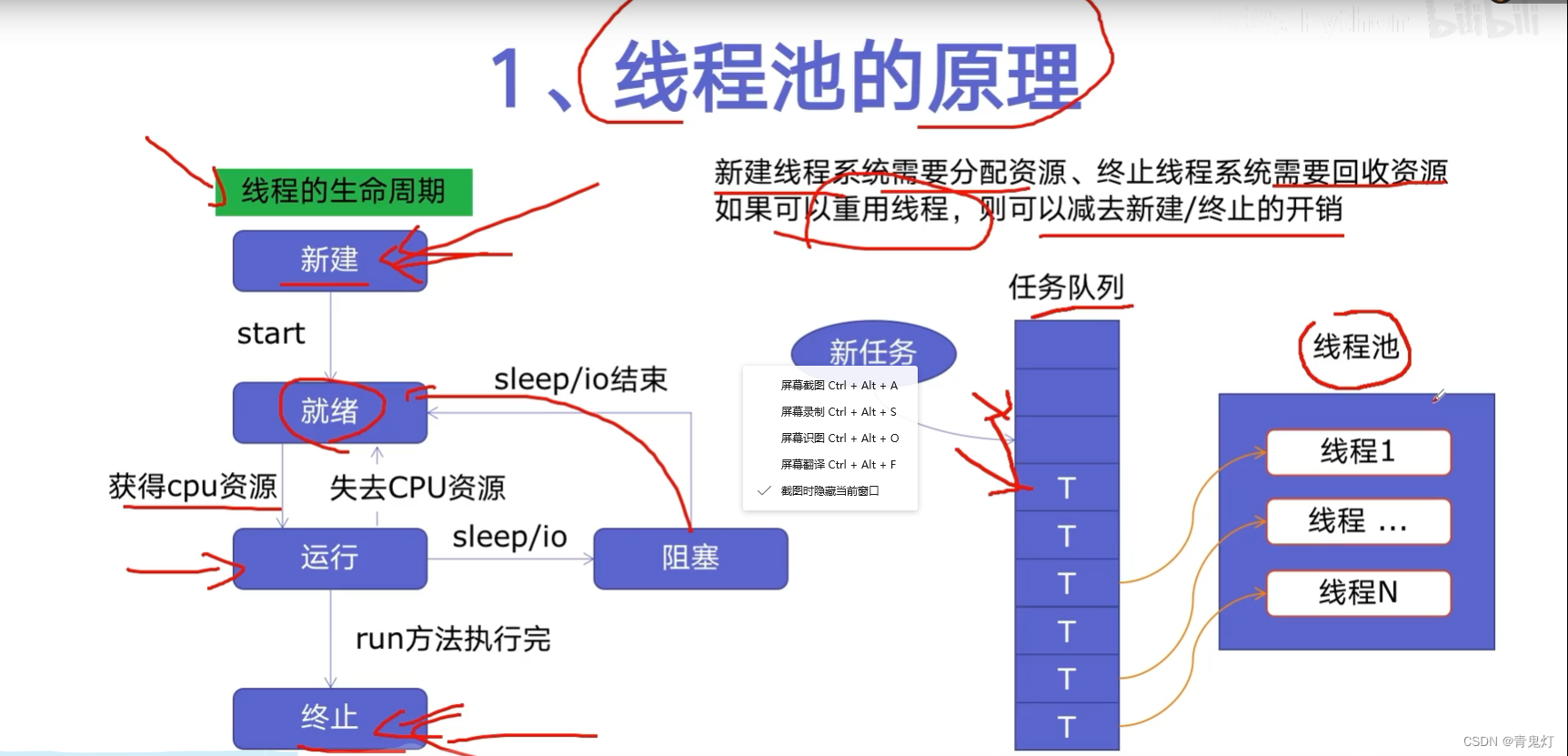

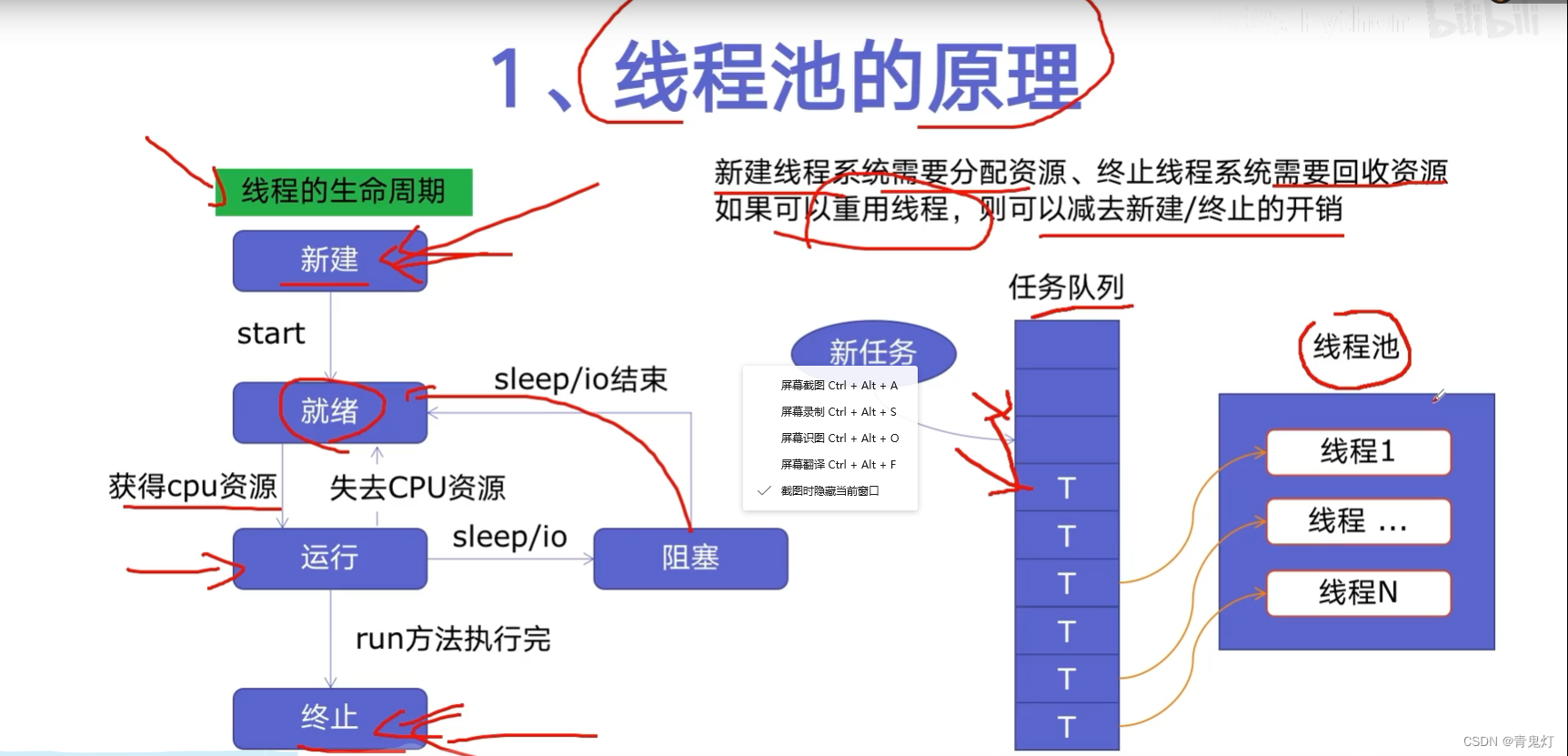

线程池的原理

-

使用线程池的好处

- 提升性能:因为减去了大量新建、终止线程的开销,重用了线程资源

- 适用场景:适合处理突发性大量请求或者需要大量线程完成任务、但实际任务处理时间短

- 防御功能:能有效避免系统因为创建线程过多,而导致系统符合过大相应变慢等问题

- 代码优势:使用线程池的语法比自己新建线程、执行线程更加简洁

-

ThreadPoolExecutor的使用语法

-

from concurrent.futures import ThreadPoolExecutor with ThreadPoolExecutor() as pool: results = pool.map(func, args) # args 对应着results- 1

- 2

- 3

- 4

-

future = pool.submit(func, 1) # 一个一个执行,一个arg对应一future futures = [pool.submit(func, arg) for arg in args] # 两种遍历方式 # 1 for future in futures: print(future.result()) # 2 for future in as_completed(futures): print(future.result())- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

-

-

使用线程池改造爬虫

使用线程池在Web服务中实现加速

多进程编程

如果遇到了 CPU密集型计算,线程自动切换反而变成了负担,多线程反而会降低执行速度,multiprocessing模块就是python为了解决GIL缺陷引入的模块,原理就是用多进程在多CPU上并发执行。

| 语法 | 多线程 | 多进程 |

|---|---|---|

| 引入模块 | from threading import Thread | from multiprcessing import Prcoess |

| 新建 启动 等待结束 | t = Thread(target=func, args=(100,))t.startt.join() | p = Process(target=func, args=('bob',))p.startp.join() |

| 数据通信 | import queueq = queue.Queue()q.put(item)item = q.get() | from multiprcessing import Queueq = Queue()q.put([42, None, 'hello']])item = q.get() |

| 安全加锁 | from threading import Locklock = Lock()with lock:pass | from multiprocessing import Locklock = Lock()with lock:pass |

| 池化技术 | from concurrent.futures import ThreadPoolExecutorwith ThreadPoolExecutor() as pool: # 方法1 results = pool.map(func, args)# args 对应着results# 方法2 future = pool.submit(func, 1)result = future.result() | from concurrent.futures import ProcessPoolExecutorwith ProcessPoolExecutor() as pool: # 方法1 results = pool.map(func, args)# args 对应着results# 方法2 future = pool.submit(func, 1)result = future.result() |

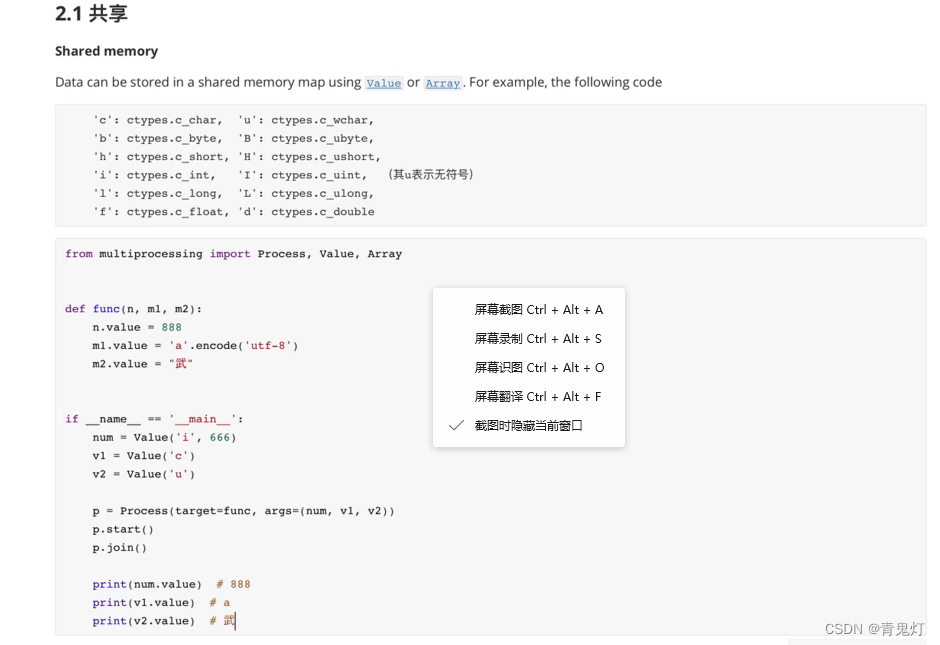

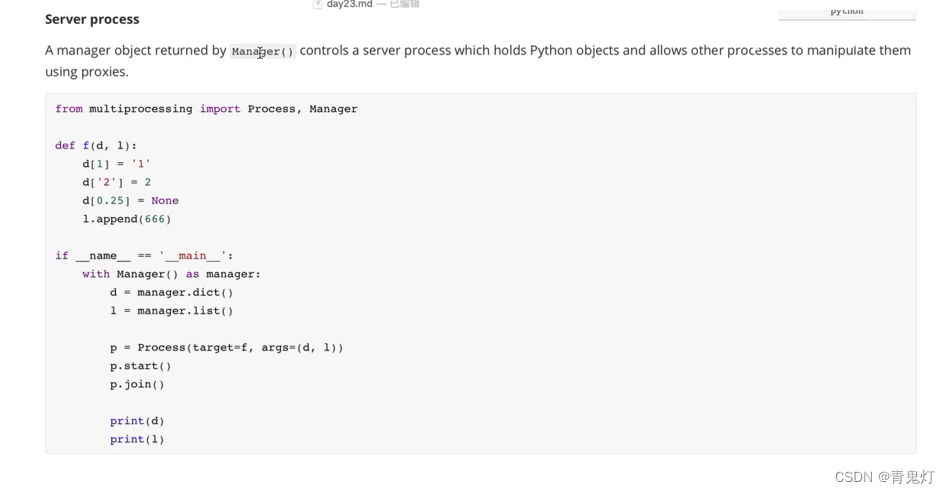

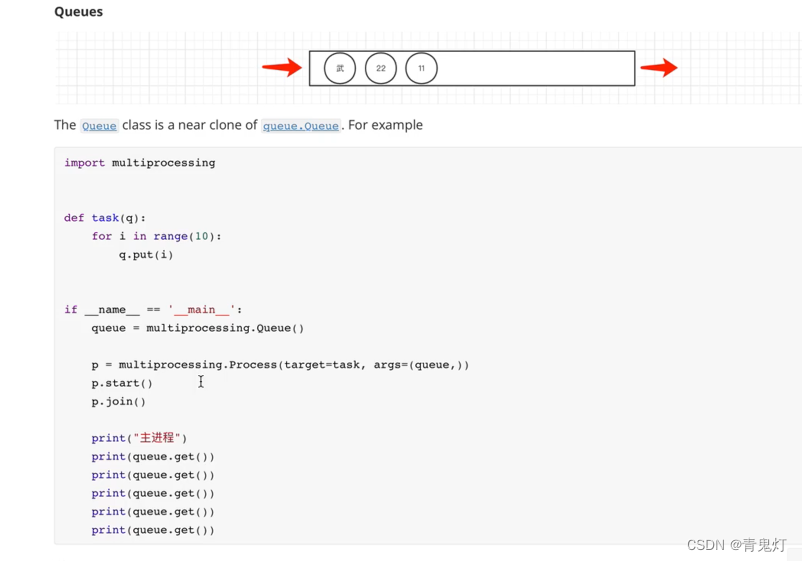

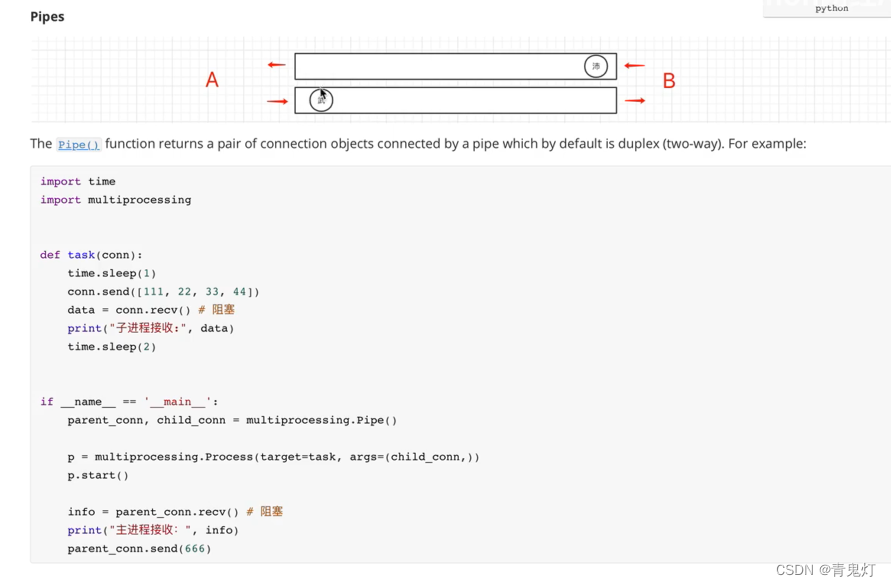

进程间通信

进程间相互独立

- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-RS9b1qGP-1655820951762)(C:\Users\han\Desktop$QFO8S6I}%)]65KLU}{H]$WY.jpg)

- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-CzofiY84-1655820951763)(C:\Users\han\Desktop\U_E)]14A88XMZ]C0}%Y_HL0P.jpg)

- [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dyujjB7J-1655820951763)(C:\Users\han\Desktop~NA

Python 并发简介

-

多线程:threading,利用CPU和IO可以同时执行的原理,让CPU不会干巴巴的等待IO完成。

-

多进程:multiprocessing,利用多核CPU的能力,真正并行执行任务。

-

异步IO:asyncio,在单线程利用CPU和IO同时执行的原理,实现函数异步执行。

-

使用 Lock对资源加锁,防止冲突访问

-

使用Queue实现不同线程、进程之间的数据通信,实现生产者-消费者模式

-

使用线程池Pool、进程池Pool,简化线程、进程的任务提交、等待结束、获取结果

多线程、多进程、多协程对比

-

多进程Process(multiprocessing):

优点:可以利用多核CPU并行计算

缺点:占用资源最多、可启动数目比线程少

适用于:CPU密集型计算

-

多线程Thread(threading):

优点:相比进程,更轻量级、占用资源少

缺点: 1. 相比进程:多线程只能并发执行,不能利用多CPU(GIL)(python多线程中只能使用单CPU)2. 相比协程:启动数目有限制,占用内存资源,有线程切换开销- 1

适用于:IO密集型计算、同时运行的任务数目要求不多

-

多协程Corotine(asyncio):

优点:内存开销最少、启动协程数量最多

缺点:支持的库有限制、代码实现复杂

适用于:IO密集型计算、需要超多任务运行、但有现成的库支持的场景

IO(读写内存、发送、网络等)

关系:进程 > 线程 > 协程,一个进程中可以启动多个线程,一个线程中可以启动多个协程。

GIL

python速度慢的原因

- 动态类型语言,边解释边执行

- GIL,无法利用多核CPU并发执行

GIL

同步线程的一种机制,使得任何时刻仅有一个线程在执行。在多核心处理器上,使用 GIL 的解释器也只允许同一时间执行一个线程

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jTXRZMgJ-1655734406988)(file:///D:\app\QQ\My_FILE\676221979\Image\Group2\N([J\N([JRTM]T]3G8P}_B5`S[18.png)]![img]

为什么有GIL这个东西?

简而言之:python设计初期,为了规避并发问题引入了GIL,现在想去除却去不掉

怎么规避GIL带来的限制?

-

多线程threading机制依然是有用的,用于IO密集型计算

因为在IO期间,线程会释放GIL,实现CPU和IO并行,因此多线程用于IO密集型计算依然可以大幅提升速度,

但是多线程用于CPU密集型计算时,只会更加拖慢速度。

-

使用multiprocessing的多进程机制实现并行计算、利用多核CPU优势

为了应对GIL的问题,python提供了multiprocessing

多线程编程

应用于IO密集型计算,比如几乎所有的网络后台服务、网络爬虫

引入模块

-

from threading import Thread- 1

新建、启动、等待结束

-

t=Thread(target=func, args=(100, )) t.start() t.join()- 1

- 2

- 3

数据通信

-

import queue q = queue.Queue() q.put(item) item = q.get()- 1

- 2

- 3

- 4

线程安全加锁

-

from threading import Lock lock = Lock() with lock:- 1

- 2

- 3

RLock和Lock的区别:

RLock支持嵌套锁,Lock只支持锁一次解一次,不支持嵌套锁。RLock又叫递归锁,Lock又叫互斥锁。如果Lock锁上没有解锁,再锁上一次,会造成死锁。死锁另外一种情况是由于竞争资源或由于彼此通信而造成阻塞的现象。

eg:两个线程函数func1和func2,分别被lock1和lock2锁上,在func1里(lock1未解锁)再用lock2上锁,在func2里在用lock1上锁.

信号量限制并发

-

from threading import Semaphore semaphre = Semaphore(10) with semaphre:- 1

- 2

- 3

线程池

-

线程池的原理

-

使用线程池的好处

- 提升性能:因为减去了大量新建、终止线程的开销,重用了线程资源

- 适用场景:适合处理突发性大量请求或者需要大量线程完成任务、但实际任务处理时间短

- 防御功能:能有效避免系统因为创建线程过多,而导致系统符合过大相应变慢等问题

- 代码优势:使用线程池的语法比自己新建线程、执行线程更加简洁

-

ThreadPoolExecutor的使用语法

-

from concurrent.futures import ThreadPoolExecutor with ThreadPoolExecutor() as pool: results = pool.map(func, args) # args 对应着results- 1

- 2

- 3

- 4

-

future = pool.submit(func, 1) # 一个一个执行,一个arg对应一future futures = [pool.submit(func, arg) for arg in args] # 两种遍历方式 # 1 for future in futures: print(future.result()) # 2 for future in as_completed(futures): print(future.result())- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

-

-

使用线程池改造爬虫

使用线程池在Web服务中实现加速

多进程编程

如果遇到了 CPU密集型计算,线程自动切换反而变成了负担,多线程反而会降低执行速度,multiprocessing模块就是python为了解决GIL缺陷引入的模块,原理就是用多进程在多CPU上并发执行。

| 语法 | 多线程 | 多进程 |

|---|---|---|

| 引入模块 | from threading import Thread | from multiprcessing import Prcoess |

| 新建 启动 等待结束 | t = Thread(target=func, args=(100,))t.startt.join() | p = Process(target=func, args=('bob',))p.startp.join() |

| 数据通信 | import queueq = queue.Queue()q.put(item)item = q.get() | from multiprcessing import Queueq = Queue()q.put([42, None, 'hello']])item = q.get() |

| 安全加锁 | from threading import Locklock = Lock()with lock:pass | from multiprocessing import Locklock = Lock()with lock:pass |

| 池化技术 | from concurrent.futures import ThreadPoolExecutorwith ThreadPoolExecutor() as pool: # 方法1 results = pool.map(func, args)# args 对应着results# 方法2 future = pool.submit(func, 1)result = future.result() | from concurrent.futures import ProcessPoolExecutorwith ProcessPoolExecutor() as pool: # 方法1 results = pool.map(func, args)# args 对应着results# 方法2 future = pool.submit(func, 1)result = future.result() |

进程间通信

进程间相互独立

-

-

-

-

线程池里,multiporcessing.RLock() 不可使用

使用: manager = multiprocessing.Manager()

lock = manager.RLock()

RLock 可以多次使用多次释放、递归锁

Lock