热门标签

热门文章

- 1python中文文本分析和提取_python str(使用python对txt文本进行分析和提取)

- 2定制elementPlus主题_element plus自定义主题

- 3在AntDesign的form表单中使用switch,初始化时赋值失败(编辑时数据不回显)_antdswitch怎么会显

- 4Python系列(9)—— 比较运算符

- 5图像边缘检测及提取方法总结(含Matlab代码)_边缘检测,区域提取高低通滤波,特征提取

- 605.结构体的练习

- 7android-安装应用直接“打开”,home键返回桌面再次点击应用图标,重新启动MAIN_action的Activity_android 二级activity打开后回到home

- 8sqli-labs-master靶场第二关详解_sqli第二关

- 9每日一题4.21_读入一些字符串,将其中的空格去掉。输入输入为多行,每行为一个字符串,字符串

- 10基于Javaweb实现的人脸识别考勤系统_人脸识别系统后台如何进入

当前位置: article > 正文

大模型实战营Day2 轻松玩转书生·浦语大模型趣味Demo

作者:你好赵伟 | 2024-03-02 12:59:35

赞

踩

大模型实战营Day2 轻松玩转书生·浦语大模型趣味Demo

大模型及 InternLM 模型介绍

- 什么是大模型?

- 定义:机器学习或人工智能领域中参数数量巨大、拥有庞大计算能力和参数规模的模型。

- 特点及应用

利用大量数据进行训练

拥有数十亿甚至数千亿个参数

在各种任务中展现出惊人的性能

- InternLM 模型全链条开源

InternLM 是一个开源的轻量级训练框架,旨在支持大模型训练而无需大量的依赖。基于 InternLM 训练框架,上海人工智能实验室已经发布了两个开源的预训练模型:InternLM-7B 和 InternLM-20B。

InternLM-Chat-7B智能对话Demo

- 模型介绍

通过单一的代码库,InternLM支持在拥有数千个 GPU 的大型集群上进行预训练,并在单个 GPU 上进行微调,同时实现了卓越的性能优化。在 1024 个 GPU 上训练时,InternLM 可以实现近 90% 的加速效率。

InternLM-7B包含了一个拥有70亿参数的基础模型和一个实际场景量身定制的对话模型。该模型具有以下特点:

利用数万亿的高质量token进行训练,建立了一个强大的知识库。

支持8k token的上下文窗口长度,使得输入序列更长并增强了推理能力。

Lagent智能体工具调用Demo

- 模型介绍

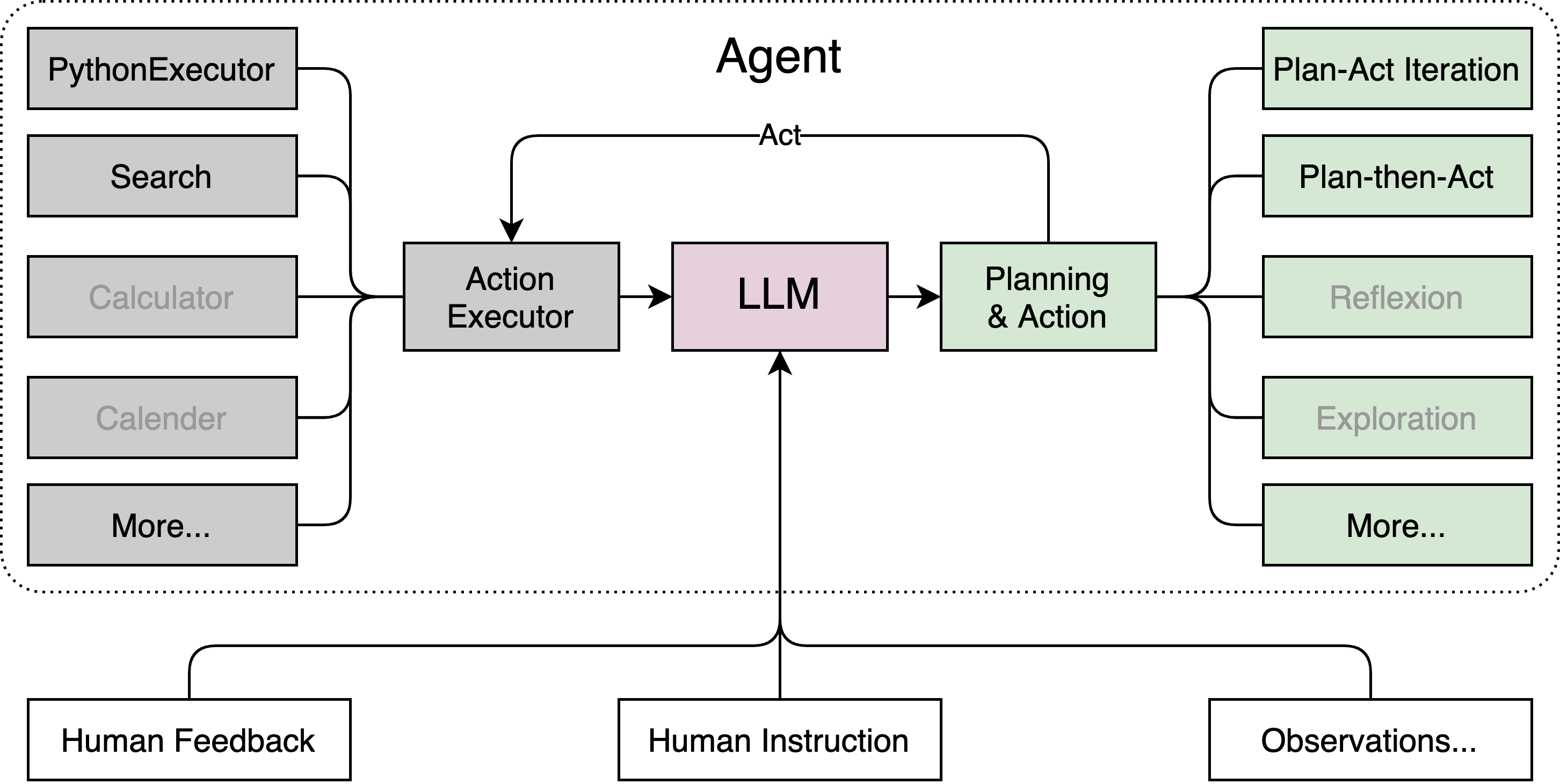

Lagent 是一个轻量级、开源的基于大语言模型的智能体(agent)框架,支持用户快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。通过 Lagent 框架可以更好的发挥 InternLM 的全部性能。

浦语·灵笔图文创作理解 Demo

- 模型介绍

浦语·灵笔是基于书生·浦语大语言模型研发的视觉-语言大模型,提供出色的图文理解和创作能力。

2.模型特点和优势:

- 为用户打造图文并茂的专属文章

- 设计了高效的训练策略,为模型注入海量的多模态概念和知识数据。

课后作业链接

Demo作业:声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/180579?site

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。